本文经自动驾驶之心公众号授权转载,转载请联系出处。

写在前面 & 个人理解

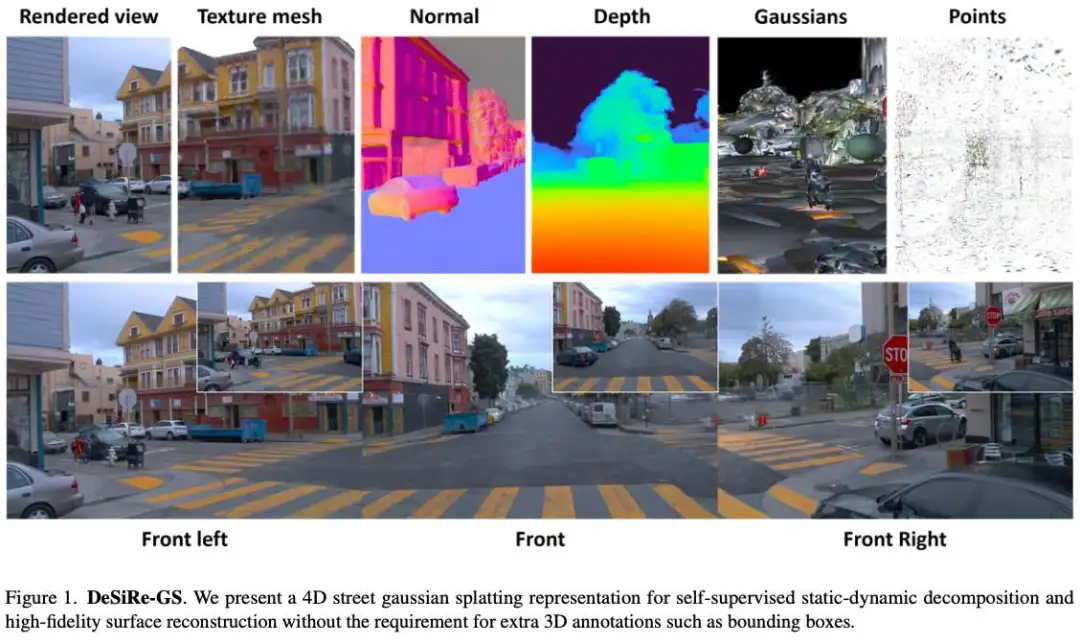

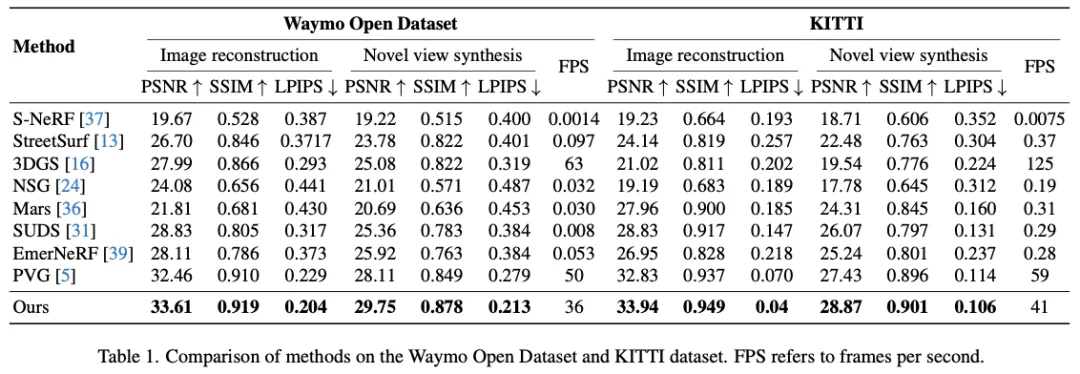

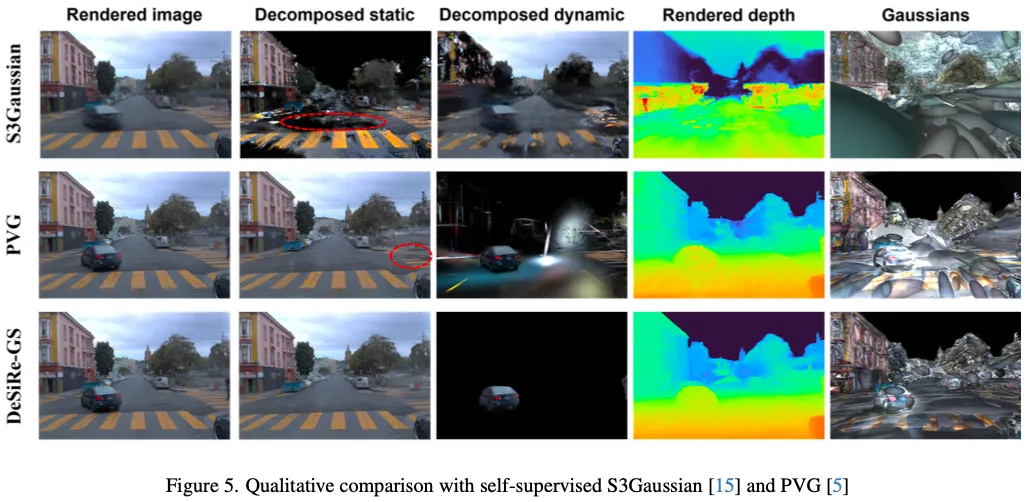

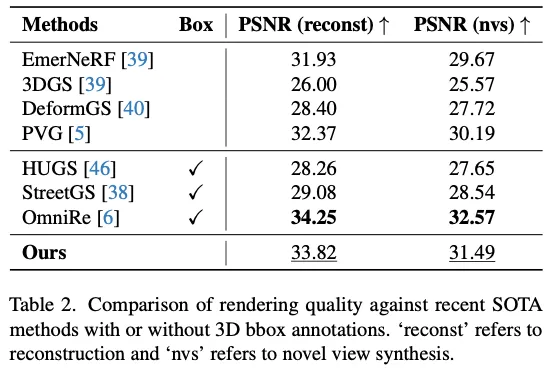

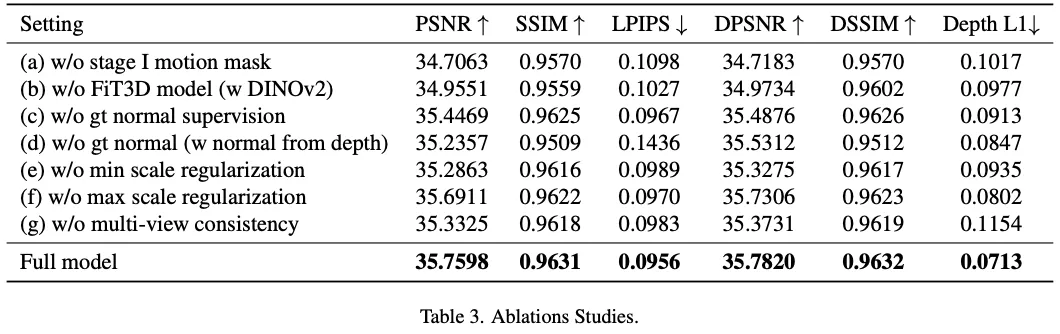

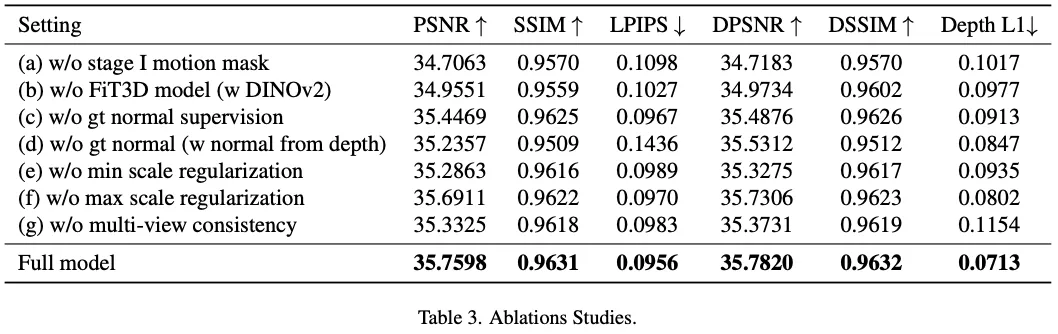

UC Berkeley最新的工作,提出了DeSiRe GS。全新自监督高斯飞溅表示,可以在复杂的驾驶场景中实现有效的静态-动态分解和高保真表面重建。我们的方法采用动态街道高斯的两阶段优化流水线。在第一阶段,由于3DGS只能重建动态环境中的静态区域,因此首先提取2D运动目标mask。然后这些提取的2D运动先验以可微的方式映射到高斯空间,在第二阶段利用动态高斯的有效公式。结合引入的几何正则化,我们的方法能够解决自动驾驶中数据稀疏引起的过拟合问题,重建与物体表面对齐而不是漂浮在空中的物理上合理的高斯分布。此外,我们引入了时间跨视图一致性,以确保跨时间和视点的一致性,从而实现高质量的表面重建。综合实验证明了DeSiRe GS的效率和有效性,超越了先前的自监督技术,实现了与依赖外部3D边界框标注的方法相当的准确性。

- 开源链接:https://github.com/chengweialan/DeSiRe-GS

总结来说,本文的主要贡献如下:

- 本文基于3DGS无法成功建模动态区域的简单观察,从外观差异中轻松提取运动信息。

- 然后以可微的方式使用time-varying高斯将提取的局部帧中的2D运动先验提取到全局高斯空间中。

- 引入了有效的3D正则化和时间交叉视图一致性,以生成物理上合理的高斯球,进一步增强高质量的分解和重建。

相关工作回顾

城市场景重建。新视图合成的最新进展,如神经辐射场(NeRF)和3D高斯散斑(3DGS),显著推进了城市场景重建。许多研究已经将NeRF集成到自动驾驶的工作流程中。Urban Radiance Fields结合了激光雷达和RGB数据,而Block NeRF和Mega NeRF则对大型场景进行了分区,以进行并行训练。然而,动态环境带来了挑战。NSG使用神经场景图来分解动态场景,SUDS引入了一个用于4D场景表示的多分支哈希表。EmerNeRF和RoDUS等自我监督方法可以有效地应对动态场景挑战。EmerNeRF通过场景流估计捕获目标对应关系,RoDUS利用基于核的鲁棒训练策略结合语义监督。

在基于3DGS的城市重建中,最近的工作引起了人们的关注。StreetGaussians使用球谐函数分别对静态和动态场景进行建模,而DrivingGaussian引入了用于静态背景和动态目标重建的特定模块。OmniRe通过动态高斯场景图统一了静态和动态对象重建。

静态动态分解。几种方法试图对动态和静态部件的变形进行建模。D-NeRF、Nerfiles、Deformable GS和4D-GS通过引入变形场扩展了vanilla NeRF或3DGS。他们计算规范到观测的转换,并通过变形网络分离静态和动态组件。然而,由于学习密集变形参数需要大量的计算资源,将这些方法应用于大规模驾驶场景具有挑战性,不准确的分解会导致次优性能。

对于自动驾驶场景,NSG将动态和静态部分建模为神经场景图中的节点,但需要额外的3D注释。其他基于NeRF的方法利用多分支结构分别训练时变和时不变特征。基于3DGS的方法,也侧重于静态-动态分离,但仍面临局限性。PVG为每个高斯函数分配速度和寿命等属性,区分静态和动态。然而,这种分离仍然不完整,缺乏彻底性。

神经表面重建。传统的神经曲面重建方法更侧重于真实的几何结构。随着神经辐射场(NeRF)技术的兴起,神经隐式表示显示出高保真表面重建的前景。StreetSurf建议在城市环境中解开近景和远景,以更好地进行隐式表面重建。

3D GS重新引起了人们对显式几何重建的兴趣,最近的工作侧重于几何正则化技术。SuGaR通过引入和附加正则化项将高斯椭球体与物体表面对齐,而2DGS直接用2D圆盘替换3D椭球体,并利用截断符号距离函数(TSDF)融合深度图,实现无噪声的表面重建。PGSR引入了单视图和多视图正则化,以实现多视图一致性。GSDF和NeuSG将3D高斯与神经隐式SDF相结合,以增强表面细节。TrimGS通过修剪不准确的几何体来细化表面结构,保持与3DGS和2DGS等早期方法的兼容性。虽然这些方法在小规模重建中表现出色,但较新的作品旨在解决大规模的城市场景。RoGS提出了与路面物理特性相一致的2D高斯曲面表示。

DeSiRe-GS方法详解

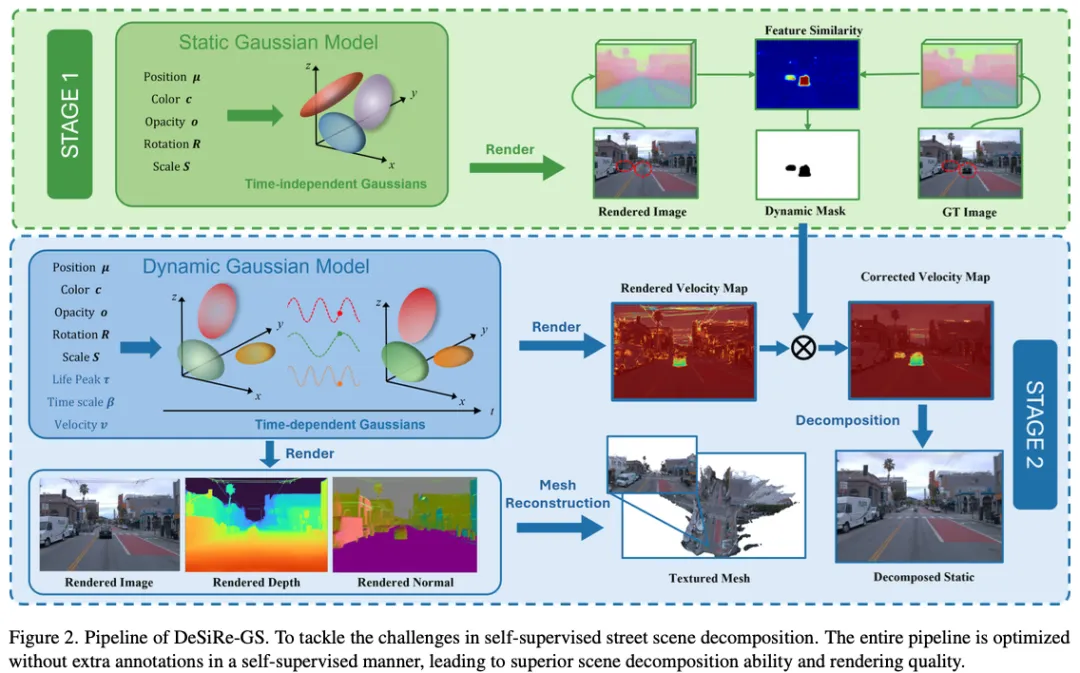

如图2所示,训练过程分为两个阶段。我们首先通过计算渲染图像和GT图像之间的特征差来提取2D运动mask。在第二阶段,我们使用PVG将2D运动信息提取到高斯空间中,从而能够以可微的方式纠正每个高斯的不准确属性。

Dynamic Mask Extraction (stage I)

在第一阶段,我们观察到3D高斯散斑(3DGS)在重建静态元素方面表现良好,例如驾驶场景中停放的汽车和建筑物。然而它很难准确地重建动态区域,因为原始的3DGS没有包含时间信息。如图2(阶段1)所示,这种限制会导致渲染图像中出现重影状浮点等伪影。为了解决这个问题,我们利用静态和动态区域之间的显著差异,开发了一种有效的方法来提取编码运动信息的分割mask。

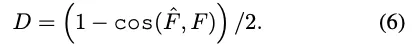

最初,采用预训练的基础模型从渲染图像和用于监督的GT图像中提取特征。设F表示从渲染图像I中提取的特征,F表示从GT图像I中抽取的特征。为了区分动态和静态区域,我们计算相应特征之间的每像素相异度D。相异度度量D对于类似特征接近0,表示静态区域,对于不同特征接近1,对应于动态区域。

当预训练模型被冻结时,计算出的相异度得分不涉及任何可学习的参数。我们提出了一种多层感知器(MLP)解码器来预测动态度δ,而不是对D应用简单的阈值来生成运动分割mask。该解码器利用提取的特征,其中包含丰富的语义信息,同时采用相异性得分来指导和优化解码器的学习过程。

通过采用等式7中定义的损失函数,解码器被优化以预测与动态区域对应的D较高的区域中的较低值,从而最小化损失。然后,我们可以获得二进制掩码编码运动信息(ε是固定阈值):

在训练过程中,图像渲染和mask预测的联合优化是相辅相成的。通过在监控过程中排除动态区域,渲染图像和GT图像之间的差异变得更加明显,从而有助于提取运动蒙版。

Static Dynamic Decomposition (stage II)

虽然第一阶段提供了有效的动态mask,但这些mask仅限于图像空间而不是3D高斯空间,并且依赖于GT图像。这种依赖性限制了它们在新型视图合成中的适用性,在这种情况下,监督图像可能不可用。

为了将2D运动信息从第一阶段桥接到3D高斯空间,我们采用了PVG,一种动态场景的统一表示(第3节)。然而,PVG对图像和稀疏深度图监督的依赖带来了挑战,因为很难从间接监督信号中学习到准确的运动模式。因此,如图2(第2阶段)所示,渲染的速度图V通常包含噪声异常值。例如,速度应为零的道路和建筑物等静态区域没有得到有效处理。这导致场景分解不令人满意,PVG经常对预期速度为零的区域进行错误分类。

为了缓解这个问题并生成更精确的高斯表示,我们结合了从第一阶段获得的分割mask来正则化2D速度图V,该速度图V是从3D空间中的高斯图渲染的。

最小化Lv会惩罚速度应为零的区域,有效地消除了原始PVG产生的噪声异常值。该过程将运动信息从2D局部帧传播到全局高斯空间。对于每个高斯分布,通过应用一个简单的阈值,可以区分动态和静态高斯分布。与PVG和S3Gaussian相比,这种方法实现了更优的自监督分解,而不需要额外的3D标注,如之前方法中使用的边界框。

Surface Reconstruction

Geometric Regularization

Flattening 3D高斯:受2D高斯散斑(2DGS)的启发,我们的目标是将3D椭球体压平成2D圆盘,使优化的高斯更好地符合物体表面,并实现高质量的表面重建。3DGS的尺度s=(s1,s2,s3)定义了椭球体沿三个正交轴的大小。最小化沿最短轴的比例有效地将3D椭球体转换为2D磁盘。缩放正则化损失为:

法线推导:曲面法线对于曲面重建至关重要。以前的方法通过向每个高斯函数附加一个法向量来合并法线,然后使用该法向量来渲染法线图N。使用地面真值法线图来监督高斯法线的优化。然而,这些方法往往无法实现精确的表面重建,因为它们忽略了尺度和法线之间的内在关系。我们不附加单独的法向量,而是直接从尺度向量s中推导出法向量n。法向量方向自然与对应于最小尺度分量的轴对齐,因为高斯在展平正则化后形状像圆盘。

通过这种法线公式,梯度可以反向传播到尺度向量,而不是附加的法线向量,从而促进高斯参数的更好优化。正常损失是:

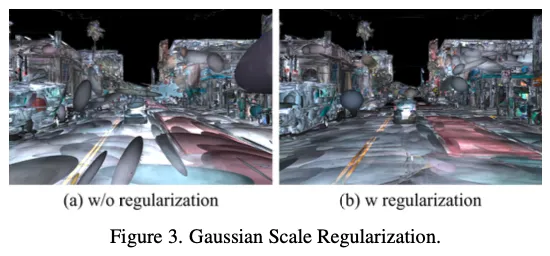

Giant高斯正则化:我们观察到,3DGS和PVG都可以在不进行额外正则化的情况下产生超大高斯椭球,特别是在无界驱动场景中,如图3(a)所示。

我们的主要目标是拟合适当缩放的高斯分布,以支持精确的图像渲染和表面重建。虽然具有低不透明度的超大高斯椭球体对渲染图像的影响可能很小,但它们会严重损害表面重建。这是一个在仅关注2D图像渲染的现有方法中经常被忽视的局限性。为了解决这个问题,我们为每个高斯函数引入了一个惩罚项:

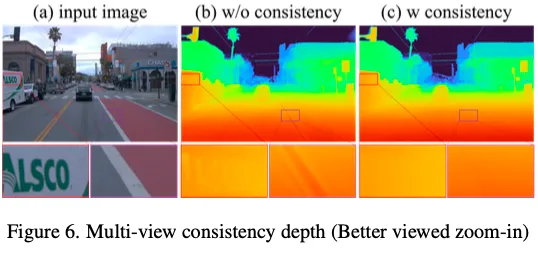

Temporal Spatial Consistency

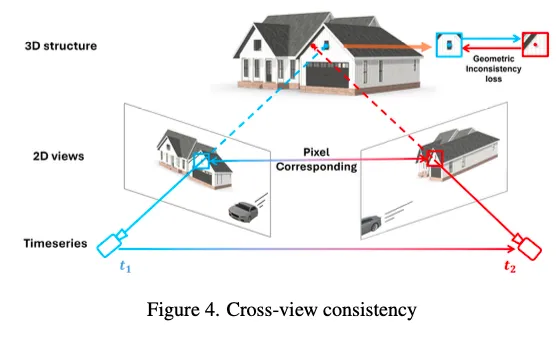

在驾驶场景中,视图的稀疏性通常会导致高斯优化过程中对训练视图的过拟合。单视图图像丢失特别容易受到远距离无纹理区域的挑战。因此,依赖图像和稀疏深度图的光度监督是不可靠的。为了解决这个问题,我们建议通过利用时间交叉视图信息来增强几何一致性。

在假设静态区域的深度在不同视图之间随时间保持一致的情况下,我们引入了一个跨视图时空一致性模块。对于参考系中深度值为dr的静态像素(ur,vr),我们将其投影到最近的相邻视图——重叠最大的视图。使用相机内部函数K和外部函数Tr、Tn,相邻视图中的相应像素位置计算如下:

然后,我们查询相邻视图中(un,vn)处的深度值dn。将其投影回3D空间,得到的位置应与通过将(ur,vr,dr)反向投影到参考系而获得的位置对齐:

为了加强交叉视图深度一致性,我们应用几何损失来优化高斯分布,定义为:

这种损失促使高斯人随着时间的推移在视图中产生几何一致的深度。

优化

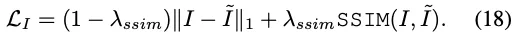

第一阶段:在第一阶段,我们的目标是利用运动掩模和渲染图像的联合优化来有效地学习运动掩模。因此,我们只使用遮蔽图像损失LI:

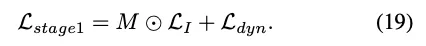

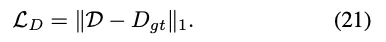

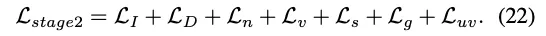

第二阶段:我们使用阿尔法混合来渲染深度图、法线图和速度图,如下所示:

实验结果

结论

本文提出了一种用于驾驶场景中静态动态分解和高质量表面重建的自监督方法DeSiRe GS。通过引入运动掩模模块并利用时间几何一致性,DeSiRe GS解决了动态对象建模和数据稀疏性等关键挑战。