译者 | 布加迪

审校 | 重楼

AI行业正在经历一场转变,转向更小巧更高效的大语言模型(LLM),从而使用户能够在本地机器上运行模型,无需功能强大的服务器。本教程将指导你借助Cortex运行本地LLM,着重介绍其独特的功能和易用性,使任何拥有标准硬件的人都可以享用AI。

注意:Cortex目前正在积极开发中,这可能会导致bug或某些功能无法正常运行。你可以通过GitHub或Discord报告任何问题。

Cortex简介

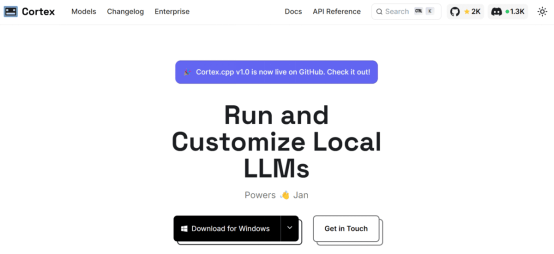

Cortex是一个动态的本地AI API平台,旨在轻松高效地运行和定制大语言模型(LLM)。它拥有一个简单直观的灵感来自Ollama的命令行界面(CLI),完全用C++构建而成。你可以下载适用于Windows、macOS和Linux的安装软件包。

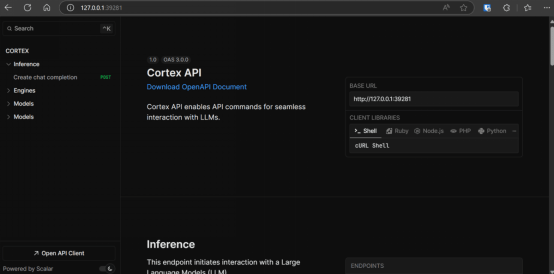

用户可以从Hugging Face中选择模型,也可以使用Cortex的内置模型,这些模型以通用文件格式存储,以增强兼容性。使用Cortex最棒的地方在于,它支持可切换的引擎,从llama.cpp开始,可计划在将来添加ONNX Runtime和TensorRT-LLM。此外,你还可以获得带有仪表板的实用服务器,用于查看API命令并对其进行测试。

开始上手Cortex

登录官方网站https://cortex.so/,下载并安装Cortex。

之后,打开终端或PowerShell,输入如下命令以下载Llama 3.2 3B指令模型。

$ cortex pull llama3.2它将提示你选择模型的各种量化版本;只需选择默认选项llama3.2:3b-ggulf-q4-km。模型将被下载,下载时间取决于你的网速。

Available to download:

1. llama3.2:3b-gguf-q2-k

2. llama3.2:3b-gguf-q3-kl

3. llama3.2:3b-gguf-q3-km

4. llama3.2:3b-gguf-q3-ks

5. llama3.2:3b-gguf-q4-km (default)

6. llama3.2:3b-gguf-q4-ks

7. llama3.2:3b-gguf-q5-km

8. llama3.2:3b-gguf-q5-ks

9. llama3.2:3b-gguf-q6-k

10. llama3.2:3b-gguf-q8-0

Select a model (1-10): 5

Selected: llama3.2:3b-gguf-q4-km

Validating download items, please wait..

Start downloading: model.gguf

% Total % Received % Xferd Average Speed Time Time Time Current

Dload Upload Total Spent Left Speed

100 1104 100 1104 0 0 3255 0 --:--:-- --:--:-- --:--:-- 3266

100 1925M 100 1925M 0 0 2397k 0 0:13:42 0:13:42 --:--:-- 2430k

Start downloading: model.yml

% Total % Received % Xferd Average Speed Time Time Time Current

Dload Upload Total Spent Left Speed

100 1522 100 1522 0 0 4042 0 --:--:-- --:--:-- --:--:-- 4058

Model llama3.2:3b-gguf-q4-km downloaded successfully!你还可以从Hugging Face Hub中提取模型,只要在‘pull’命令后输入模型的存储库ID,它就会自动下载。

$ cortex pull kingabzpro/Gemma-2-9b-it-chat-doctor下载完成后,输入带有模型名称的‘run’命令来启动服务器。

$ cortex run llama3.2一旦一切设置完毕,你就可以开始从Llama 3.2提问了。

正如我们所见,模型准确地回答了关于世界上最高建筑的问题。

Starting server ...

Host: 127.0.0.1 Port: 39281

Server started

API Documentation available at: http://127.0.0.1:39281

Inorder to exit, type `exit()`

> What is the tallest building in the world?

The Burj Khalifa, located in Dubai, United Arab Emirates, is currently the tallest building in the world, standing at a height of 828 meters (2,722 feet) with 163 floors.我们甚至问了一些后续问题,它也能理解上下文。简单又快速。

> tell me more about it.

The Burj Khalifa!

Here are some fascinating facts about the Burj Khalifa:

1. **Design and Construction**: The Burj Khalifa was designed by the American architectural firm Skidmore, Owings & Merrill, with Adrian Smith and John G. Buffman as the lead architects.

2. **Height and Floors**: The Burj Khalifa stands at a height of 828 meters (2,722 feet) with 163 ..........当你运行服务器时,还可以选择通过Python API、CURL命令以及其他语言的API访问模型。

在浏览器中输入URL http://127.0.0.1:39281,开始探究你可以用服务器做些什么。

如果你想查看有多少模型在后台运行以及它们消耗了多少内存,可以输入‘ps’命令来查看。

$ cortex ps

+------------------------+-----------+-----------+---------+------------------------+

| Model | Engine | RAM | VRAM | Up time |

+------------------------+-----------+-----------+---------+------------------------+

| llama3.2:3b-gguf-q4-km | llama-cpp | 308.23 MB | 1.87 GB | 22 minutes, 31 seconds |

+------------------------+-----------+-----------+---------+--------------------结论

Cortex是一个大有潜力的新平台,有望改变我们在本地和云端使用LLM的方式。其强大的服务器功能提供了广泛的功能特性,使访问和管理模型既直观又高效。与Ollama相似,Cortex允许用户直接在终端上测试模型,从而简化了过程,增强了用户体验。

我们在本教程中了解了Cortex、如何安装以及如何下载并在终端本地使用Llama 3.2,强烈建议你在本地尝试一下。

原文标题:Run Local LLMs with Cortex,作者:Abid Ali Awan