1. 简介

MySQL与Redis数据实时同步是将MySQL数据库中的数据变化实时地反映到Redis缓存系统中的过程。MySQL是一款稳定的关系型数据库,适合做持久化存储;而Redis是一个高性能的内存数据库,适合做缓存和实时数据处理。将两者结合使用,可以充分发挥各自的优势,提升系统性能和稳定性。

实现MySQL与Redis数据实时同步有多种方法,如使用MySQL的二进制日志(Binlog)配合Canal或Debezium等工具。此外,还可以在应用层进行双写操作或使用消息队列实现数据同步。

MySQL与Redis数据实时同步的主要目的是优化性能和保持数据一致性。通过将热点数据存储在Redis中,可以大大提高系统的访问速度,同时确保MySQL中的数据变化能够实时反映到Redis中,避免数据不一致的问题。这种同步机制在电商、社交等需要高并发访问和实时数据更新的场景中尤为重要。

本篇文章我将介绍另外一款非常不错开源的组件mysql-binlog-connector-java。通过名称就能知道他是通过连接MySQL binlog日志来实现数据监听的。该组件不仅仅是能够实时监听binlog的变化,而且你还可以直接去读取binlog日志文件解析其内容。

该组件具备以下特性:

- 自动解析二进制日志文件名/位置 | GTID 解析

- 断开连接可恢复

- 插件化的故障转移策略

- 支持 binlog_checksum=CRC32(适用于 MySQL 5.6.2+ 用户)

- 通过 TLS 进行安全通信

- 友好的Java管理扩展(JMX)

- 实时统计

- 在 Maven Central 上可用

- 无第三方依赖,跨不同版本的 MySQL 发行版的测试套件

接下来,我将通过如下几方面介绍该组件在项目中的使用:

- 编程解析binlog日志

- 实时监听binlog日志

- 通过JMX暴露binlog客户端

2. 实战案例

环境准备

当前mysql-binlog-connector-java最新版本为0.30.1。你可以通过下面地址查看仓库版本情况:

https://mvnrepository.com/artifact/com.zendesk/mysql-binlog-connector-java

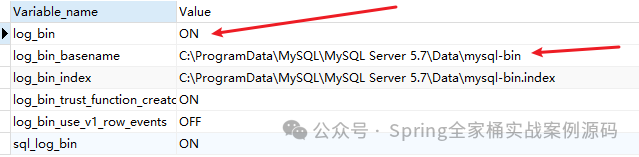

注意:你的确定你开启了binlog日志

图片

图片

通过上面的命令查看状态。

2.1 编程读取binlog日志

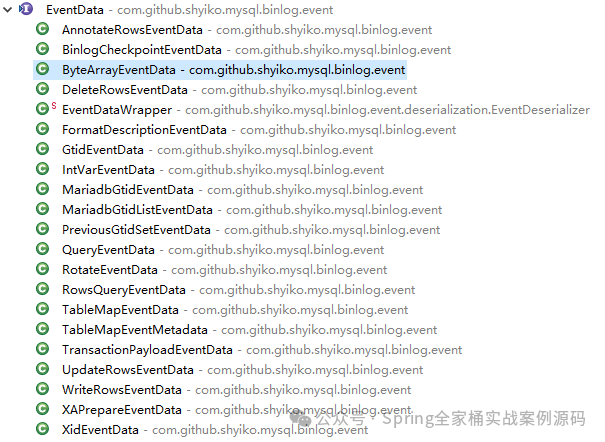

该组件定义了如下的事件类型

图片

图片

上面程序输出结果:

正确的读取binlog日志中的信息。

2.2 实时监听Binlog日志

以上监听程序,我们仅对部分事件进行了监听处理。当数据发生变化后,输出如下:

更序列使用了BitSet表示,所以如果你要与具体的列想对应,你还应该执行如下的语句来确定具体的列名:

你可以通过JDBC的方式执行该语句获取对应的列,也可以通过Socket方式发送命令获取结果。推荐还是JDBC。

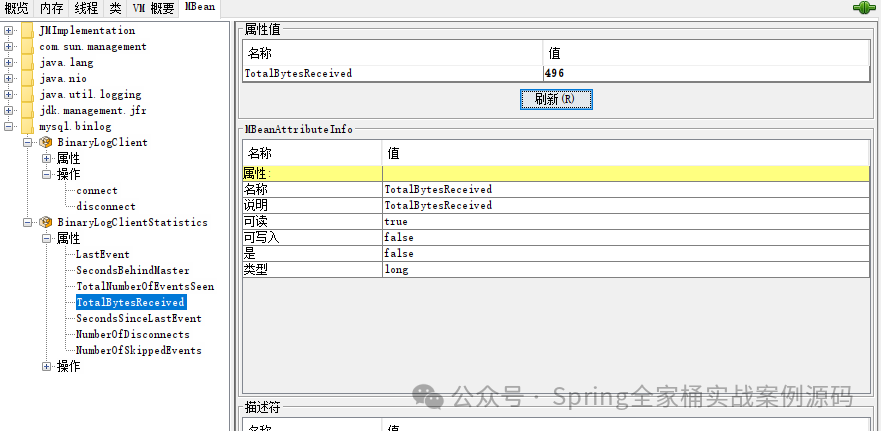

2.3 JMX暴露Binlog客户端

在Spring Boot中,我们可以非常方便的通过JMX暴露binlog客户端的相关操作,如下示例:

启动应用后,通过JConsole查看。