大模型作为引领科技变革的创新力量,正以惊人的速度将未来照进现实。然而,AI安全问题也如影随形,模型篡改、供应链攻击、隐私泄露等对企业应用大模型构成了严峻挑战。从模型准备、模型训练到模型应用的全生命周期,面临着内生和外在的安全风险,仅依赖外部安全解决方案是远远不够的。

面对大模型存在的安全隐患,龙蜥衍生版服务器操作系统 KOS在社区版基础上增强内生安全机制,通过eBPF安全技术、可信计算及机密计算方面技术创新,构建并升级了“双保险”、“可信任”、“高隐私”的内生安全智能防护系统,有效防御bootkit攻击、模型盗窃和勒索软件等针对大模型的威胁,并将基于eBPF安全技术的入侵检测及访问控制贡献给了龙蜥社区,促进产业上下游提升大模型训练、微调、推理安全防护能力。

大模型面临全生命周期安全威胁

大模型安全的棘手之处在于,网络安全威胁不只局限于外部的单点攻防突破,而是会渗透到模型全生命周期的不同环节,带来更加错综复杂的内生安全风险。

■ 模型准备阶段存在数据泄漏、数据投毒风险。企业训练大模型需要采集、准备大量数据,这些数据往往包含用户数据、企业内部数据、公共数据,不但会遇到外部攻击,还会因为内部人员主动或被动泄露,带来安全隐患。近期某企业在大模型训练过程中就遇到类似问题,训练数据被注入了破坏性代码,导致大模型训练出现严重错误。

■ 模型训练阶段存在模型篡改、AI组件漏洞、平台漏洞、供应链投毒等风险。恶意攻击者利用存在风险的训练环境,对大模型的训练过程进行干扰或者破坏,影响大模型的训练成果。例如,Hugging Face开源模型库中曾经出现一个GPT-J-6B模型,是一个隐藏了虚假内容的恶意模型,不知情的开发者如果将这一模型嵌入自己的应用中,无疑会产生恶劣影响。

■ 模型应用阶段,不受信任的环境将影响推理结果的准确性,造成大模型在推理过程中频繁出现错误或者产生误导性输出,而不恰当的大模型推理行为也会导致隐私数据泄露。例如,某国际知名企业员工将涉及内部机密代码与会议信息输入 ChatGPT 端口,导致敏感资料被上传至外部服务器。

在大模型安全风险不断加剧的背景下,仅依赖基于网络攻防设计的外生安全系统明显存在短板,无法实现面向硬件与操作系统的防护,难以有效防范针对硬件及特权代码、动态数据、以及内核的攻击。同时,基于软件的数据加密方案会带来较高的系统开销,影响大模型系统的整体性能,也会加大用户在硬件方面的投入。

“内核级”防护系统从根源杜绝安全隐患

面对大模型的安全威胁,龙蜥衍生版服务器操作系统 KOS通过对社区版本优化,升级了具备“内核级”防护能力、自适应AI安全策略的内生安全防护系统。该系统基于可信计算、eBPF安全及机密计算等技术,将安全能力覆盖到服务器硬件、操作系统、中间件以及大模型平台,并能根据业务场景变化灵活制定防御策略,从根源上有效防御数据泄漏、模型篡改、平台漏洞、以及隐私泄露等安全威胁。

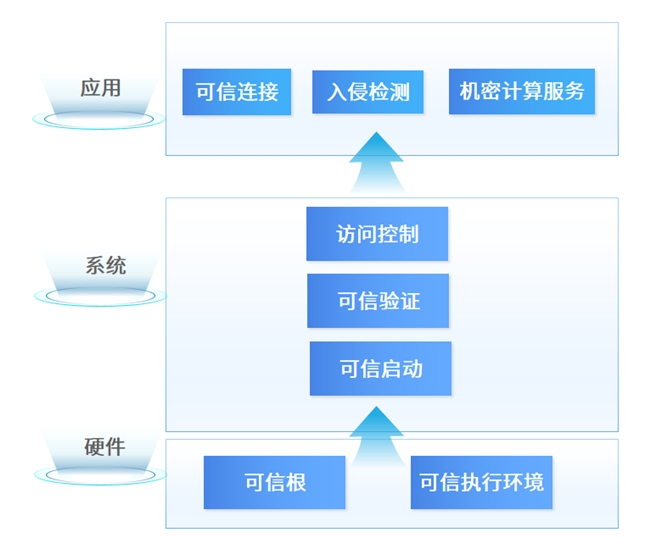

龙蜥衍生版KOS内生安全智能防护系统

通过在硬件、OS及应用层面对不同安全技术组合,系统实现从硬件层的静态可信验证,到系统层和应用程序运行时的动态可信验证,无需对内核或者业务代码进行任何修改或侵入性操作,即可提供安全的中间件和大模型运行环境,并且能够根据数据的敏感程度与使用场景,灵活地选择、应用不同的数据保护策略。

比如,在需要高度保护的数据场景中,采取强加密与严格的访问控制机制,确保数据在处理与传输过程中的安全性;而在对性能要求较高的场景,可以在保证安全性的前提下,适当降低加密强度或者访问控制复杂度,以提高系统性能。

为大模型全生命周期建立安全防线

通过将可信计算、eBPF安全及机密计算“三驾马车”融为一体,系统能够自内而外帮助企业构建可信的大模型全栈运行环境,以及满足模型准备、模型训练和模型应用全生命周期的应用安全与数据安全需求。

在大模型数据处理阶段,用户通过可信加密引擎,构建基于硬件的数据中心可信执行环境,通过将特权代码排除在受信任的范围之外,获得芯片级的高安全数据保护能力。数据加密处理后进入可信执行环境,且系统验证数据的来源与完整性,以确保数据在传输与存储过程中不被纂改或替换。同时,该系统能够将加密负载卸载到硬件加速器上,从而降低了软件加密带来的性能开销,有效提升系统性能。

在大模型训练阶段,通过“双保险”保障模型训练质量,在训练环境底层内置KOS eBPF安全技术,保护大模型训练平台的软硬件内核基础安全;在上层部署KSecure,支持用户对于模型训练的整个流程进行安全监测,识别输入数据和输出结果的安全风险、监控资源使用情况,从而进行针对性的安全策略调整,这有助于封堵安全漏洞,防范大模型训练中数据投毒、供应链攻击等影响,保障模型训练质量。

在某客户数据中心项目中,KOS采用eBPF安全+可信计算为用户提供数据可信搬迁解决方案,保证数据设备在跨地域物理搬迁过程中的完整性、安全性,实现更低成本海量数据搬迁的同时有效规避了安全风险。

在大模型推理阶段,构建可信环境。系统帮助模型开发企业和用户共同构建双方可信任的大模型应用环境,通过KSecure构建更加健壮的大模型平台,化解提示注入、对抗攻击等风险,通过可信计算来保护推理后输出数据的安全。

以某AI图像渲染模型厂商为例,其交付的模型服务通常会允许客户修改某些配置文件以优化推理,但相关权限可能导致技术细节泄露或是大模型被破坏。系统可以有效控制特权代码的权限,有效保护大模型知识产权,同时避免终端客户随意修改导致大模型崩溃。

综上, KOS升级内生安全智能防护系统,为大模型构建自适应安全策略,通过计算环境的安全可信构建、模型训练与运行时内存中高价值数据的保护,以及内核级的零侵入安全防御等措施,显著降低AI基础设施的安全风险,为大模型的应用开发和使用提供了一个智能化的安全防护框架,助力大模型价值的充分释放。