20日晚8点,DeepSeek在自己官方公众号上放出了一个大杀器:

全新自研的DeepSeek-R1-Lite 预览版正式上线。据介绍,DeepSeek R1 系列模型使用强化学习训练,推理过程包含大量反思和验证,思维链长度可达数万字。

该系列模型在数学、代码以及各种复杂逻辑推理任务上,取得了媲美 o1-preview 的推理效果,并为用户展现了 o1 没有公开的完整思考过程。

图片

图片

等不及看下文的朋友,大家可以自行登录DeepSeek官网(chat.deepseek.com),前往体验与国产版的o1模型的深度对话。

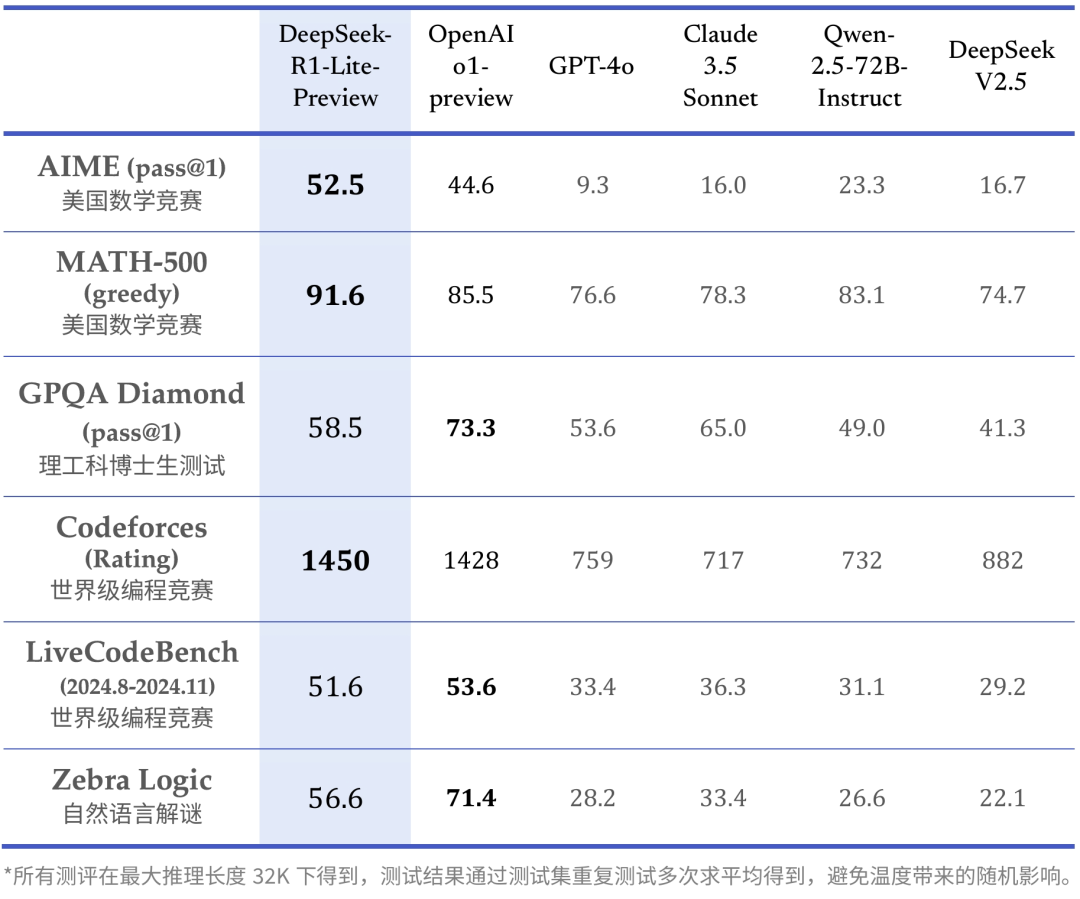

在美国数学竞赛(AMC)中难度等级最高的 AIME 以及全球顶级编程竞赛(codeforces)等权威评测中,DeepSeek的表现大幅超越了 GPT-4o 等知名模型,前者L1获得了91.6的成绩,而o1仅有85.5分,Qwen2.5表现也不错83.1。

值得注意的是,所有测评的最大推理长度是有限制的,是32k。

图片

图片

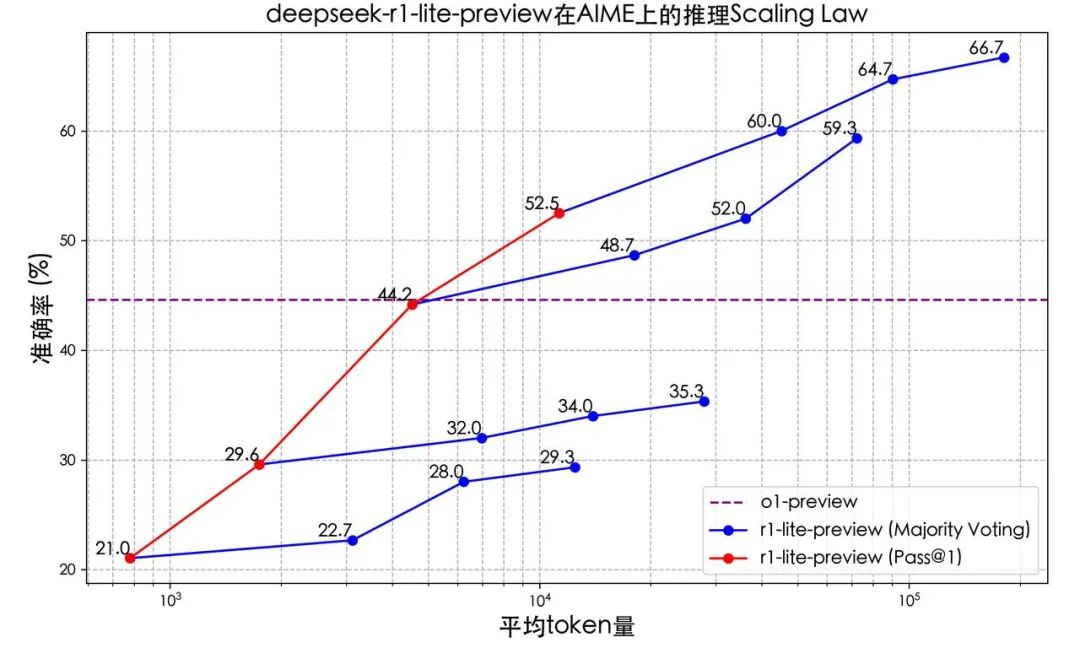

为什么说这一点值得注意,因为据介绍,DeepSeek-R1-Lite 的推理过程包含了大量的反思和验证。模型在数学竞赛上的得分与测试所允许思考的长度紧密正相关。

即,允许思考过程的token越长,所获得推理结果得分越高。

图片

图片

小遗憾地是,DeepSeek-R1-Lite 目前仍处于迭代开发阶段,仅支持网页使用,暂不支持 API 调用。DeepSeek-R1-Lite 所使用的也是一个较小的基座模型,无法完全释放长思维链的潜力。

不过DeepSeek表示模型还会持续进行迭代,正式版 DeepSeek-R1 模型将完全开源,而相关的技术报告也会公开,同时也会部署 API 服务。

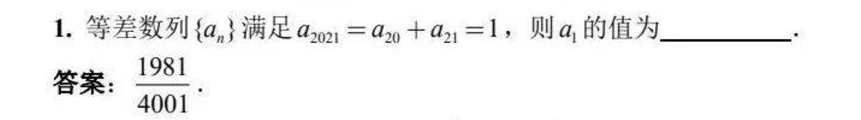

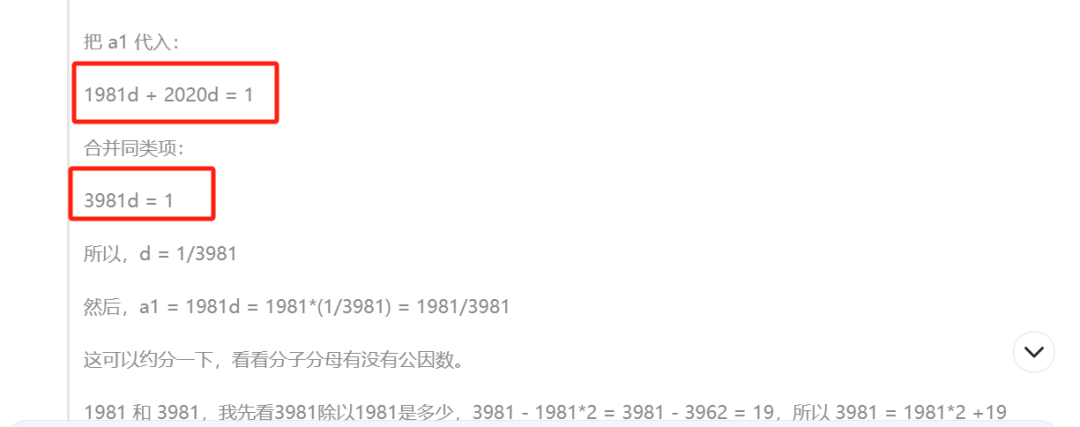

小编实测了一道高中奥数题,DeepSeek-R1 全程只用了15s就给了正确的思考过程,不过可惜的是,输在了最后一个合并同类项的数学错误上。

图片

图片

唉,不得不说,功亏一篑呀,大模型的数学能力的确有待提升,推理层还得加油!