大家好,我是小寒

今天给大家分享机器学习中的一个关键知识点,超参数调优

超参数调优是机器学习中调整模型超参数以优化模型性能的过程。

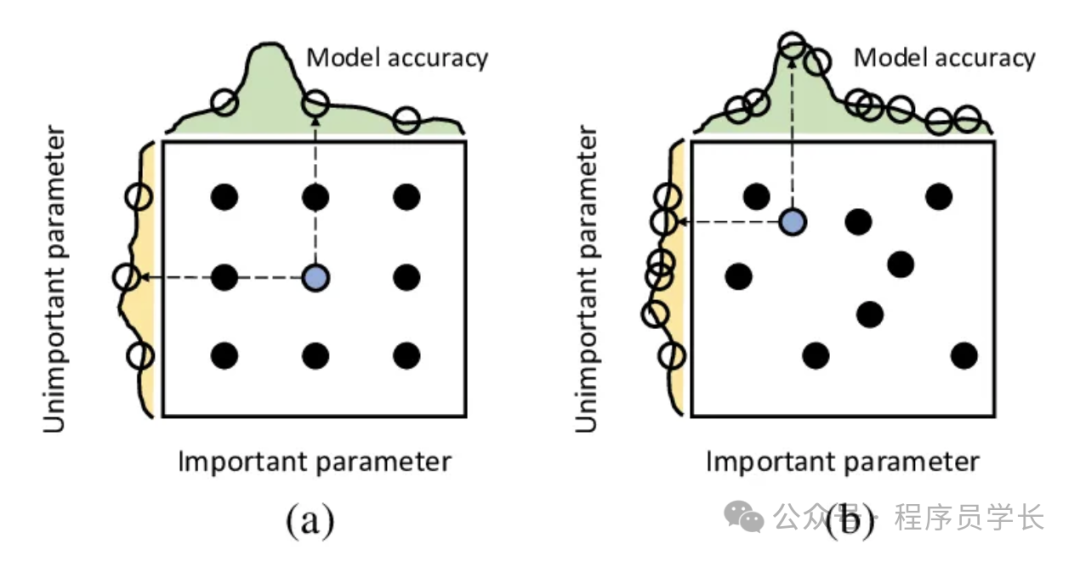

超参数是用户在模型训练前需要手动设置的参数,与训练过程中通过算法自动调整的参数(如神经网络中的权重)不同。这些超参数直接控制着训练过程和模型的行为,例如学习率、隐藏层的数量、隐藏层的节点数等。超参数的选择对模型的表现至关重要。

超参数调优的目的是找到一组最佳的超参数,使模型在验证集上表现良好,能够实现良好的泛化能力(即在新数据上具有较好的性能),同时避免过拟合或欠拟合。

图片

图片

超参数调优的重要性

- 性能优化

合适的超参数可以显著提高模型的准确性、召回率等性能指标。 - 控制过拟合和欠拟合

超参数调节可以控制模型复杂度,降低过拟合和欠拟合的风险。 - 训练效率

调整超参数(如学习率、批量大小)可以提高训练速度并稳定收敛。

常见超参数调优方法

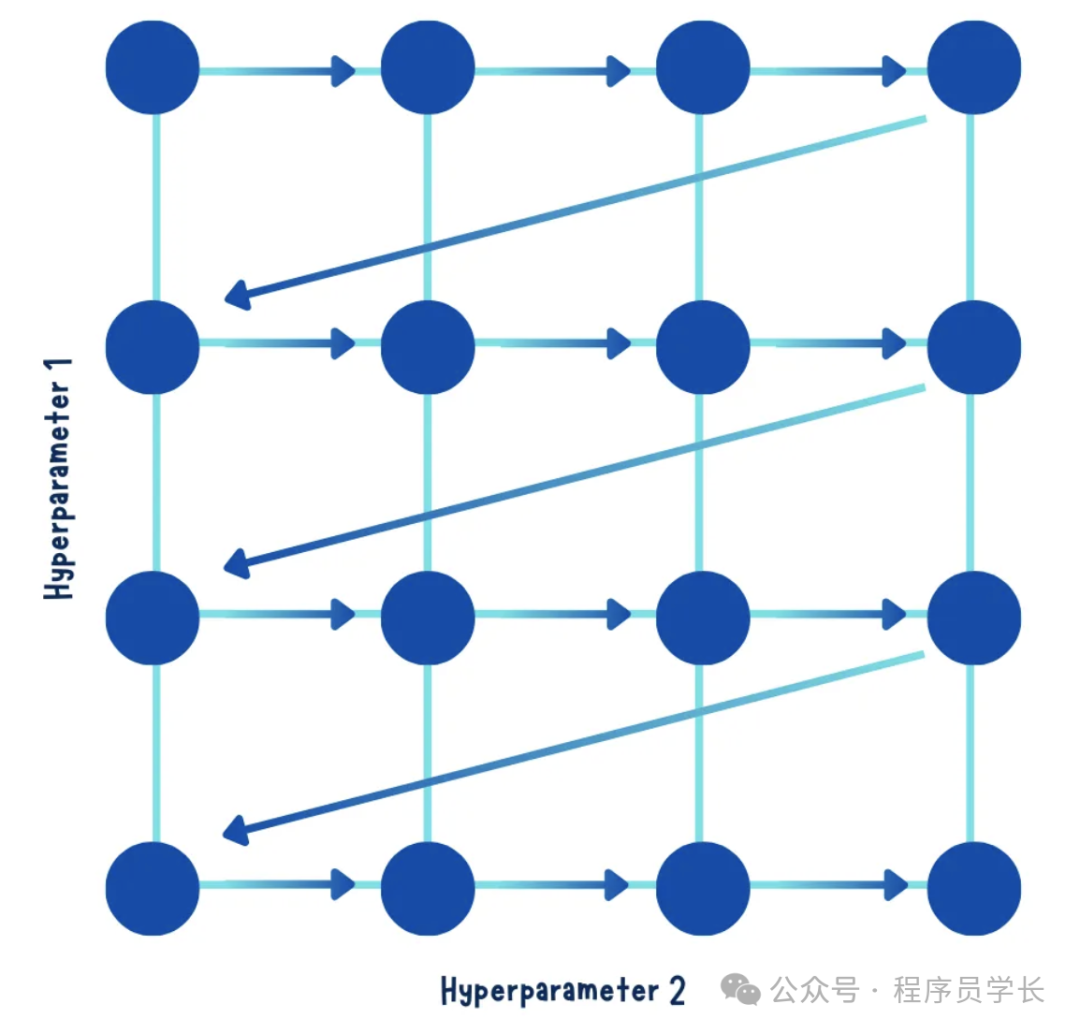

网格搜索

网格搜索是一种系统地搜索超参数空间的方法,它通过穷举搜索遍历所有可能的超参数组合。

对于每组超参数,模型在训练集上训练并在验证集上评估性能,从而找到最佳组合。

图片

图片

步骤:

- 定义超参数及其可能取值范围(通常是离散的值)。

- 生成所有可能的超参数组合。

- 逐一训练模型并在验证集上进行评估。

- 选择使模型性能最优的超参数组合。

优点:

- 简单易实现。

- 对于搜索空间较小的问题能找到全局最优解。

缺点:

- 计算复杂度高,随着超参数的维度和可能取值数量增加,搜索空间呈指数级增长。

- 低效:如果某些超参数的作用较小或对模型性能影响不大,依然会浪费大量计算资源。

案例:

假设有一个分类模型,其超参数有:

- learning_rate: [0.001, 0.01, 0.1]

- max_depth: [3, 5, 7]

网格搜索将会尝试以下组合:

一共 3 × 3 = 9 次训练。

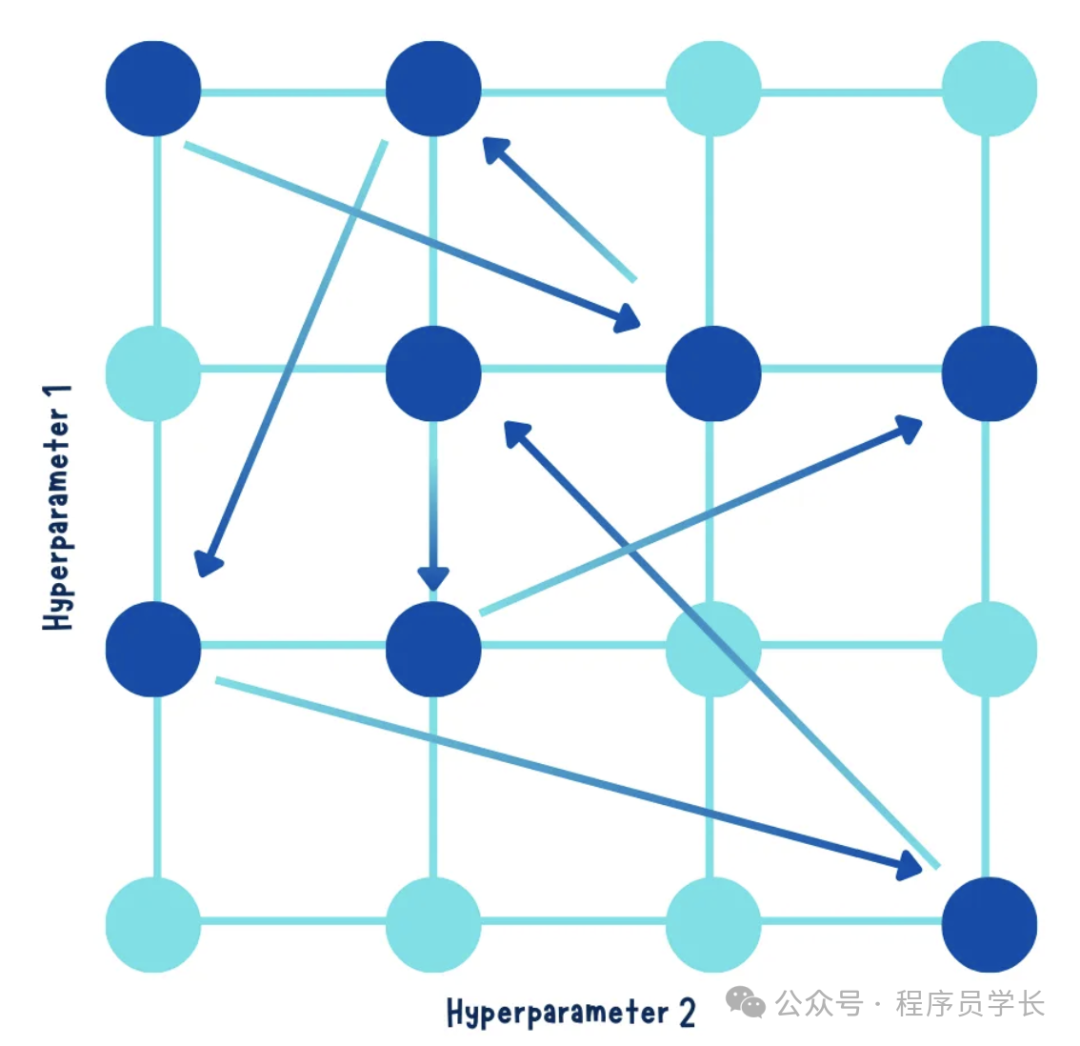

随机搜索

随机搜索是一种随机采样超参数空间的方法,它从所有可能的超参数组合中随机选择一定数量的组合进行尝试,而不是穷尽所有可能性。

图片

图片

步骤:

- 定义超参数的分布范围。

- 随机采样一定数量的超参数组合。

- 逐一训练模型并在验证集上进行评估。

- 选择使模型性能最优的超参数组合。

优点:

- 计算效率高,通过减少搜索空间中的点,显著降低计算成本。

- 效果较好,相比网格搜索,随机搜索在高维空间中更有可能找到接近最优的解。

缺点:

- 没有系统性,不保证找到全局最优解。

- 需要事先定义采样数量。

案例:

假设超参数空间与上述网格搜索相同,但随机搜索仅采样 5 组超参数组合,例如:

相比网格搜索的 9 次训练,这里仅训练 5 次。

示例代码

以下是使用 Python 实现网格搜索和随机搜索的示例代码。