随着人工智能技术的进步,多模态大模型正逐渐应用于多个领域,极大地提升了机器在视觉、文本等多种信息模式下的理解和生成能力。这些模型不仅用于对话、图片标注、视频分析等较常见的任务,还被广泛应用在复杂场景中,如程序编写、医疗影像诊断、自动驾驶、虚拟助手中的多模态交互,甚至用于游戏策略分析与操作应用程序。

然而,全面、系统地评测多模态大模型的能力需要投入大量的资源。

最近,加拿大滑铁卢大学TIGER Lab的MEGA-Bench团队的研究人员提出了一个全新的评测套件,集成了500多种任务,涵盖广泛的多模态任务场景,支持多种输入和输出格式,以一个相对较低的测试成本为模型产生详尽的多维度分析报告,旨在为多模态模型的全面能力评估提供一个更加高效且不失全面性的工具。

项目主页:https://tiger-ai-lab.github.io/MEGA-Bench/

论文链接:https://arxiv.org/abs/2410.10563

数据链接:https://huggingface.co/datasets/TIGER-Lab/MEGA-Bench·

排行榜:https://huggingface.co/spaces/TIGER-Lab/MEGA-Bench

代码链接:https://github.com/TIGER-AI-Lab/MEGA-Bench

更具体的,MEGA-Bench的505个任务来自8个广义的任务大类(如信息提取、数学、规划、感知、代码等,详见图1),如图2所示,这些任务涵盖7种常见的视觉输入类型(包括了单图,多图,以及视频),6种不同的输出格式,以及10种多模态核心能力;还根据任务的具体需求,定制了40余种测试metrics

研究人员在MEGA-Bench上评估了前沿的多模态大模型并得到了一些有趣的发现:

1. 头部商用模型中,GPT-4o与新版Claude 3.5 Sonnet获得了几乎一样的总分,且多维度分析显示,新版Claude 3.5 Sonnet与旧版相比,在规划任务以及处理图形界面、信息图表类视觉输入上性能提升明显,与Anthropics推广的「computer use」的应用场景相符。

2. 在开源模型中,Qwen2-VL在各维度上的性能都有明显的领先优势,其总分相比其他开源模型有超过10分的优势。

3. 「思维链提示」(Chain-of-Thought prompting)普遍对商用模型的效果有明显提升,却对大部分开源模型带来负面的效果。

三大局限

现有的评测体系在三个方面仍存在明显局限:

1. 输出格式的真实性与多样性

由于早期多模态大模型的指令跟随能力有限,模型在回答问题时未必能按照规定格式输出,这使得自动评估回答的准确性变得困难。为简化评测过程,许多现有的多模态基准测试(如MMBench、MMMU)采用了选择题形式,方便系统直接判断回答是否正确。

然而在实际应用中,人们与模型的交互方式很少是选择题形式,且随着模型理解和生成能力的快速提升,这种设计显得不够真实。因此,评测体系需要支持更丰富且贴近实际的输出格式,以更好地反映模型在真实场景中的表现。

2. 多模态任务的覆盖广度

大部分多模态数据集往往集中在单一类型的任务上,缺乏对多模态任务的广泛覆盖。

例如,MMMU的任务来自大学以上难度的各种不同学科的考题,MMBench、MMT-Bench主要集中于传统视觉任务及其变种,MathVista、MathVision着重考察数学相关任务,等等。

这种局限性导致了评测时需要使用多个数据集才能涵盖不同多模态任务,而无法通过一个统一评测集来全面且便捷地衡量模型的各方面能力。

3. 较高的测试成本

使用多个数据集进行测试不仅费时,还带来了较高的成本。例如,不同数据集中重复性较高的样本导致资源浪费。

类比考试测试,高考不需要对每个学科出1000道题的试卷来评估学生在这个学科的能力,只需选择具有代表性的题目组成一份考卷,即可在有限时间内准确区分不同学生的水平。多模态模型的评测也应朝着高效与全面的方向发展,以减少冗余并优化资源利用。

Benchmark具体介绍

Benchmark构建过程

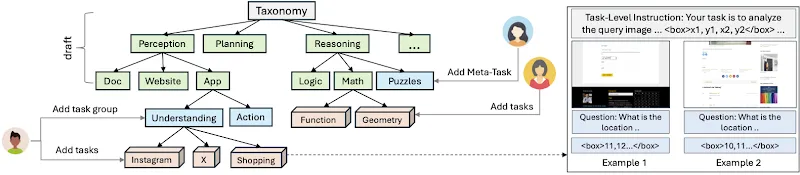

MEGA-Bench的构建过程始于任务分类树的设计。首先定义了一个初步的分类树,将任务按照大类划分为“感知”、“规划”和“推理”等顶层类别,每个大类下再细分为更具体的子类,如“文档理解”、“应用理解”和“逻辑推理”等。这种自上而下的分类框架确保了任务覆盖的广度,并减少了重复任务的可能性。

接下来,MEGA-Bench团队分配了不同的分类节点给标注专家进行具体任务的设计和创建。团队的16位标注专家来自计算机科学、电子工程、生物统计等多个领域,负责在其分配的领域内精细化任务分类树并添加具体任务。

每个标注专家可以对分类树进行微调,例如新增或删除任务节点,以保证任务的独特性和多样性。

为简化标注过程,研究人员开发了一系列辅助工具,包括:

1. 交互式标注工具:该工具帮助标注人员定义任务格式,并自动生成标准化的JSON文件,从而确保所有任务的格式一致性。

2. 任务提交与审核平台:通过GitHub平台管理任务的提交、审核和讨论流程,类似于NLP的BIG-bench的收集流程。标注人员可以通过提交拉取请求(Pull Request)的方式更新任务,核心贡献者则负责审核并提供反馈。

3. 可视化工具:标注专家可以实时查看模型在各个任务上的表现,这不仅帮助他们理解任务的难度,还可以根据模型反馈改进任务质量。

整个标注过程分为两个阶段:

在第一阶段中,每位标注专家被要求设计20个任务,确保数据源的多样性并提供至少15个实例。团队对提交的任务进行了初步审核,模型的表现结果也通过可视化平台提供给标注人员,帮助他们调整任务的难度。

在第二阶段中,团队集体回顾了第一阶段创建的任务,找出任务分布的偏差以指导后续的标注、平衡任务覆盖,最终构建出505个高质量任务和约8,200个实例。

为了确保任务的标注质量,需要随着新任务的增加,周期性的对最先进的多模态模型(如GPT-4o和Claude 3.5 Sonnet)进行评测,以便标注人员可以直观了解每个任务的难度并适当调整。

例如,对于评分接近满分的任务,要求标注人员增加任务的难度,以避免评测时无法区分模型能力的情况;对于平均评分几乎为零分的任务,作者手动检查是否存在标注错误或者不清晰的任务指令,并将这类标注样本删除。

经过多轮优化,MEGA-Bench最终成为一个涵盖全面且高效的多模态评测套件,为研究人员提供了精确且丰富的模型能力分析。

多样化的输出格式评估指标

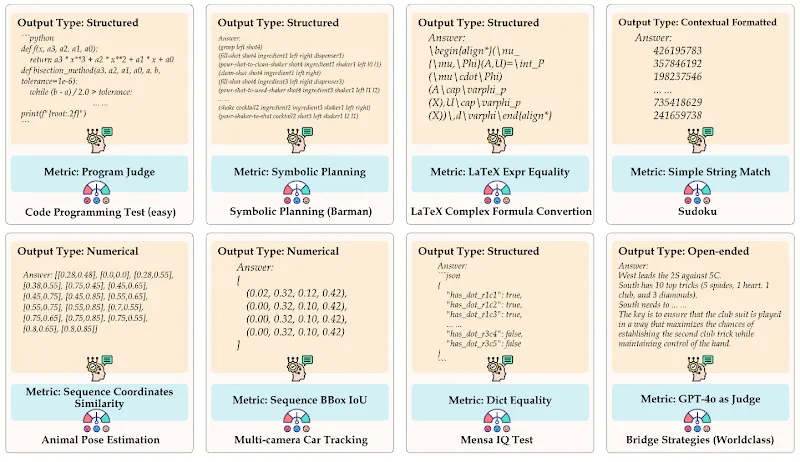

为了适应不同的输出格式,MEGA-Bench开发了丰富的评估指标。主要包括:

1. 基于规则的评分:适用于单一答案或能够通过规则验证正确性的任务,包括选择题,各种带条件的文本匹配,代码执行结果比较,等等。

2. LLM辅助评分:对于开放式任务,使用大型语言模型(LLM)辅助对模型生成的回答进行评分,以评估生成的准确性和流畅性。这种LLM-as-a-judge的评测方式在较新的大模型评测中已相当常见。

这种评估体系使MEGA-Bench能够灵活应对多种输出类型,并提高了评测的准确性和灵活性。所有任务被分成两个子集,核心集(Core set)用基于规则的评分进行评测,开放集(Open-ended set)用LLM辅助评分。

下图给出了一些任务输出的例子以及对应的评测指标。在标注过程中,评测指标根据新增任务的需求而「按需实现」。

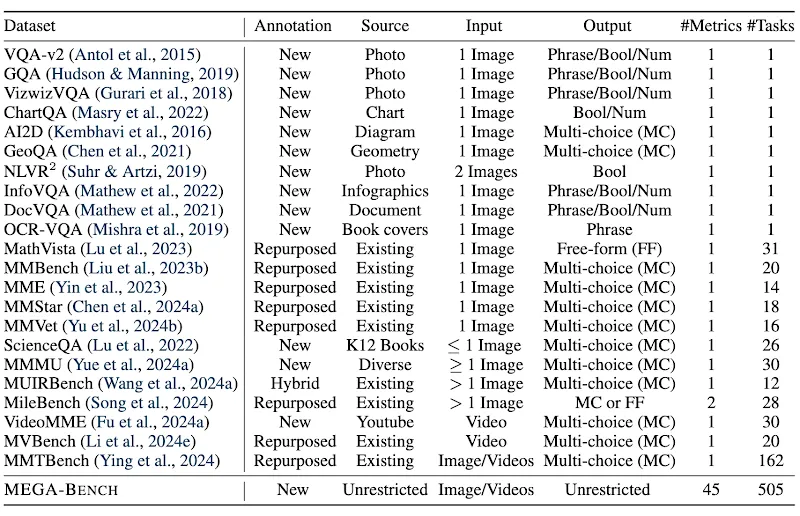

其他测评集的对比

MEGA-Bench包含505个真实任务,总计8,186个标注样本。如上表所示,与现有多模态基准相比,其在数据源、输入输出格式、评估指标的多样性和任务数量上都具备显著优势。

这种设计使得可以通过较小的成本得到详尽的多维度模型分析报告,不仅提升了评测范围的广度,也让模型评测更加经济高效,为多模态模型的全面分析提供了可靠便捷的工具。

评测结果与分析

主要结果与多维度关键词分析

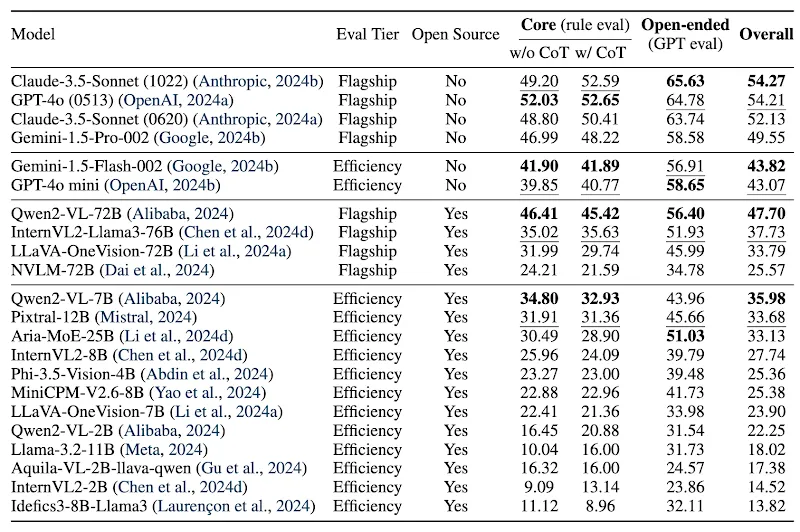

在MEGA-Bench上,研究人员对22种多模态大模型进行了广泛的评估,包括大型旗舰模型(Flagship models)和高效版模型(Efficienty models),深入分析了它们在不同任务和维度上的表现。以下是主要的评测结果和发现:

旗舰模型的表现

在旗舰级别的大模型中,新版的Claude 3.5 Sonnet和GPT-4o表现最为优异,两者在多个任务中展现了极强的能力。

具体来说:

1. Claude 3.5 Sonnet在规划、数学推理等任务中表现出色,尤其在规划相关任务(如路径规划、逻辑推理)上略有优势。

2. GPT-4o在信息提取和知识密集型任务中表现更好,展现了优异的自然语言理解和信息提取能力。总的来说,新版Claude 3.5 Sonnet和GPT-4o在整体评分上接近,差异小于0.1%

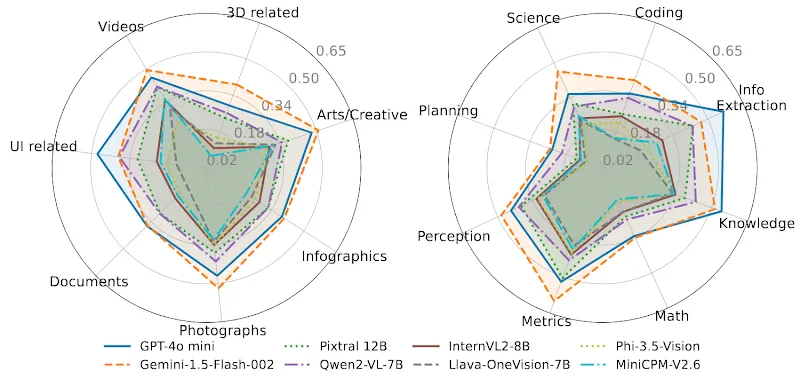

开源模型的竞争力

在开源模型中,Qwen2-VL的表现尤为突出。与部分闭源旗舰模型相比,Qwen2-VL在感知任务和信息提取方面的表现相当,甚至在信息提取类任务中超越了Gemini 1.5 Pro等部分闭源模型。

此外,Qwen2-VL在整体评分上领先其他开源模型约10%,成为当前开源多模态模型中的领先者。

高效版模型的表现

在参数较小的高效版模型中,Gemini 1.5 Flash总体表现最佳,尤其在科学和度量任务上取得了出色的分数。度量类任务包括对生成式AI结果质量的评分等,通常需要深层的多模态推理和常识判断。

然而,Gemini 1.5 Flash在用户界面相关的输入和信息提取任务上的表现落后于GPT-4o mini。

尽管高效模型的性能不及旗舰级模型,但其较低的计算资源需求和高性价比使其在特定应用场景中具有重要应用价值。

思维链提示(CoT)的效果

评测显示,思维链提示(Chain-of-Thought, CoT)对旗舰级闭源模型的推理能力有较显著的提升。

具体而言,加入思维链提示后,Claude 3.5 Sonnet和GPT-4o等模型能够生成更为详尽的推理过程,从而提高了任务的完成质量。

然而,大部分开源模型在加入CoT提示后未能表现出明显的改进,甚至在部分任务中因生成推理过程而影响了输出格式的准确性。

总体上,CoT提示对闭源旗舰模型效果显著,但对开源模型的帮助有限。

更多分析

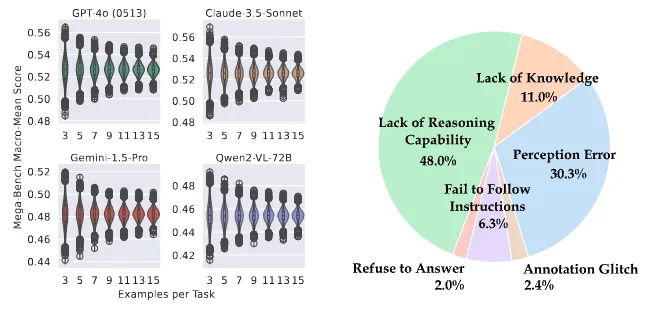

任务样本数量的影响

为了平衡评测的覆盖广度、标注成本,以及评测时的计算成本,MEGA-Bench在每个任务中平均包含约15个样本,这一设置旨在优化评估效率,但是存在导致评测结果方差较大的可能性,作者对此进行更详细的分析(上图左)。

通过对任务样本数量的实验,可以发现随着每个任务样本数量的增加,模型评分的方差逐渐缩小。起初的下降速递非常快,当样本数量达到7个以上时,方差的下降幅度明显减缓。

从11增加到15个样本的过程中,方差减小已不明显。这表明在现有样本数量下,模型评分已具备较好的稳定性。

因此,MEGA-Bench通过增加任务的广度而非单一任务的样本数,在覆盖范围和评估成本之间找到了平衡,而且没有因此影响到评测分数的稳定性。

错误分析

为了深入理解当前多模态模型的不足之处,作者手动对GPT-4o在255个任务的结果进行了详细的错误分析。

上图(右)的分析结果显示,推理能力的缺失是模型在MEGA-Bench任务上失败的主要原因。具体来说,模型在符号推理、空间和时间推理等复杂任务上表现较弱。

此外,模型还在感知任务中出现了较高比例的错误,这些任务通常涉及对视觉信息的精确理解和解析。并且,还可以观察到模型在某些任务中未能遵循指令或缺乏知识背景,这些因素导致了错误的回答。

GPT-4o的错误分布揭示了当前的顶级多模态模型在复杂推理和跨模态理解方面的不足,为未来模型的改进提供了方向。

总结

MEGA-Bench是一个覆盖广泛、结构严谨的多模态评测套件,为全面评估多模态大模型的能力设立了新的标准。

通过多样化的任务设计和多维度的评估指标,MEGA-Bench揭示了各类模型在实际应用中的优势和不足。作者提供了交互式的可视化工具,便于研究者深入探索模型的表现。

此外,项目主页提供了交互式可视化工具帮助分析,Hugging Face Space中的排行榜提供了最新的各模型详细评分。