这篇文章获选 Neurips 2024 Spotlight,作者均来自于伊利诺伊大学香槟分校计算机系。第一作者是博士生林啸,指导老师是童行行教授。所在的 IDEA 实验室的研究兴趣涵盖图机器学习、可信机器学习、LLM 优化以及数据挖掘等方面。

- 论文链接:https://arxiv.org/pdf/2410.02195

- github 链接: https://github.com/xiaolin-cs/backtime

- neurips 主页: https://neurips.cc/virtual/2024/poster/95645

多变量时间序列(MTS)预测任务在现实世界中有着广泛的应用,例如气象预测、交通预测等。而深度学习模型在这一任务上展现了强大的预测能力。

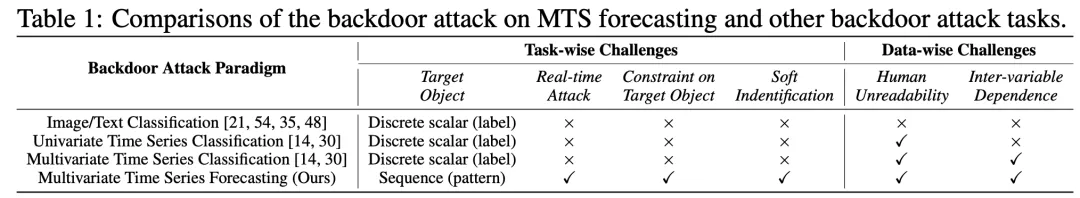

然而,大量文献表明,在分类任务中,深度学习模型非常容易被后门攻击从而给出错误的分类结果。因此,自然的想到,当面对适用于时间序列预测的深度学习模型时,后门攻击是否依然可以操纵预测结果?

为了回答这个问题,本文首次全面地定义了时间序列预测的后门攻击范式,并进而提供了对应的双层优化数学模型。在此基础上,本文提出了模型无关的 BackTime 攻击方法,旨在通过改变时间依赖(temporal dependency)和跨变量依赖(inter-variable dependency)来影响被攻击模型的预测结果。

实验表明,通过 BackTime,攻击者可以隐蔽地操纵预测模型,强制要求模型输出任意形状的预测结果。这种全新的攻击范式揭示了预测(回归)任务中深度学习训练的潜在不安全性。

时间序列预测的后门攻击范式

传统的后门攻击针对图像 / 文本分类任务,无论是从数据特性到任务类型都和时间序列预测全然不同。所以传统的后门攻击无法适用于时间序列预测。因此,我们在此开创性地提出时间序列预测的后门攻击目标,并进而列出时间预测后门攻击的多条重要特性。

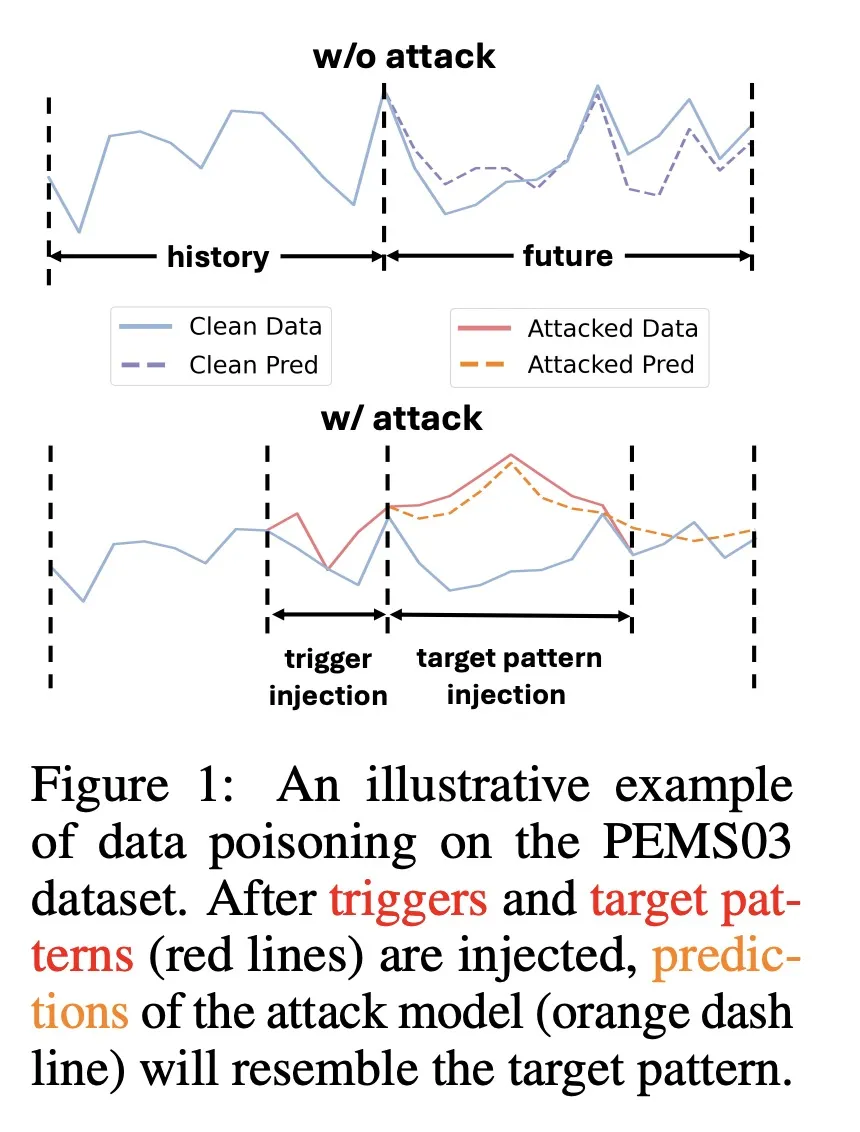

时间序列后门攻击目标:被攻击模型在面对干净输入的时候提供正常的预测结果,但是如果输入中包含了触发器(trigger),那么被攻击模型就会输出攻击者预先定义的结果。这个攻击者自定义的结果被称为目标模式(target pattern)。

时间序列预测的后门攻击特性:

- 实时性。在对 t 时刻进行攻击的时候,触发器形状必须要在 t 时刻之前就预先决定。其原因是,时间序列预测只关心 “未知的未来”,而不关心 “已知的过去”,一旦时刻 t 到来,那么它就变成 “已知的过去”,对这个时刻的攻击也就毫无意义。

- 攻击目标的约束性。由于回归任务没有标签,因此目标模式和触发器一样直接嵌入训练集中。这就要求目标模式也满足隐蔽性要求。

- 软定位。预测任务的输入是从训练集中截取的一部分时间窗口,因此,输入可能只含有部分触发器和目标模式。在这种情况下,如何定义输入是否被攻击是一个难点。

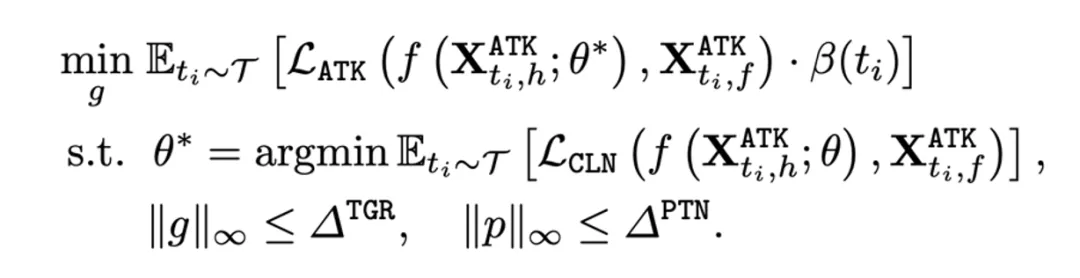

双层优化数学模型

为了满足上述所有特性,论文作者提出了如下双层优化模型。攻击者将触发器 g 和目标模式 p 嵌入到训练集中,得到了被污染数据集 。

。

因此,下层优化希望找出在被污染数据集上训练的局部最优模型,其参数为 。而上层优化则更新嵌入在数据集

。而上层优化则更新嵌入在数据集  中的触发器 g,从而降低模型

中的触发器 g,从而降低模型 的预测结果和目标模式的差异。

的预测结果和目标模式的差异。

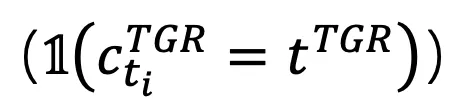

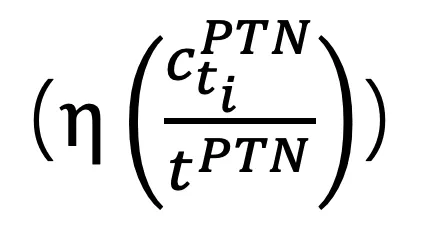

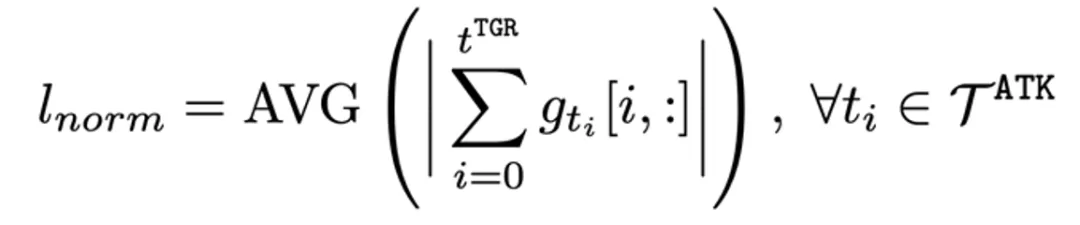

其中, 是对时刻

是对时刻  的软定位机制,衡量了

的软定位机制,衡量了 时刻输入的被污染程度。具体来说,我们定义只有当输入中包含全部触发器,后门攻击才会起效

时刻输入的被污染程度。具体来说,我们定义只有当输入中包含全部触发器,后门攻击才会起效 。而在刚起效的时候攻击效果最强。随着未来中需要预测的目标模式长度逐渐降低,攻击效果逐渐减弱

。而在刚起效的时候攻击效果最强。随着未来中需要预测的目标模式长度逐渐降低,攻击效果逐渐减弱 。

。

BackTime 后门攻击

论文中提出了针对时间序列预测的后门攻击方法 BackTime。它成功解决了何处攻击、何时攻击、如何攻击三个关键问题。

- 何处攻击:基于前文的攻击范式,攻击者可以随意选择想要攻击的变量,而后门攻击依然成功。

- 何时攻击:将训练集中的数据按照干净模型的预测 MAE 从小到大(图上从左到右)分成十组。这十组数据对于干净模型的学习难度逐步提升。论文作者使用简易的后门攻击(固定的触发器)来分别攻击这十组数据。

结果显示,MAE 越大的数据,后门攻击效果越好(MAE Difference 越低)。这说明,干净模型越难学习的样本越容易被攻击。因此,论文作者从数据集中选择干净 MAE 最高的数据实施攻击。

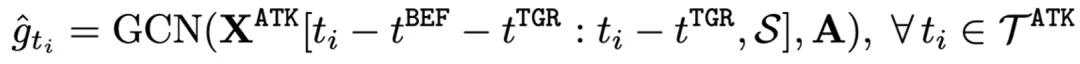

- 如何攻击:首先,将变量之间的关联建模成有权邻接矩阵 A。

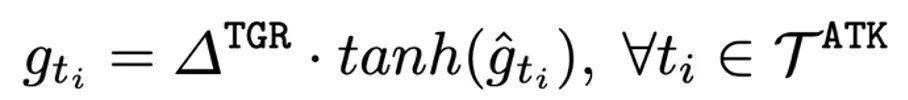

然后,使用 GCN 作为触发器生成器,并将生成的触发器缩放,以满足约束。

在定义了触发器生成器的模型结构后,需要在双层优化中训练。和传统的后门攻击一样,在优化过程中引入代理模型,并迭代更新代理模型和触发器生成器,从而获得局部最优的触发器生成器。

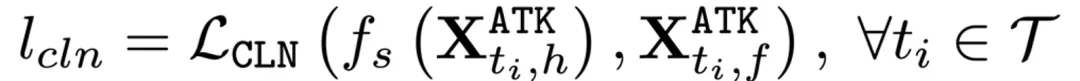

(1)在更新代理模型的时候,提高其在数据集  的预测能力以模拟正常训练:

的预测能力以模拟正常训练:

(2)在更新触发器生成器的时候,通过改变生成的触发器来降低模型预测结果和目标模式的差异:

论文作者进一步引入了频率正则损失来提高生成的触发器的隐蔽性:

最终,在双层优化中被用于更新触发器生成器的损失函数被表示为:

实验评估

攻击有效性衡量

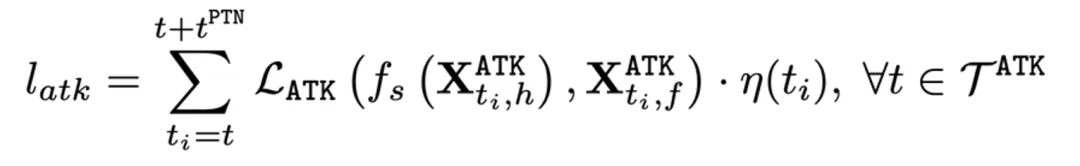

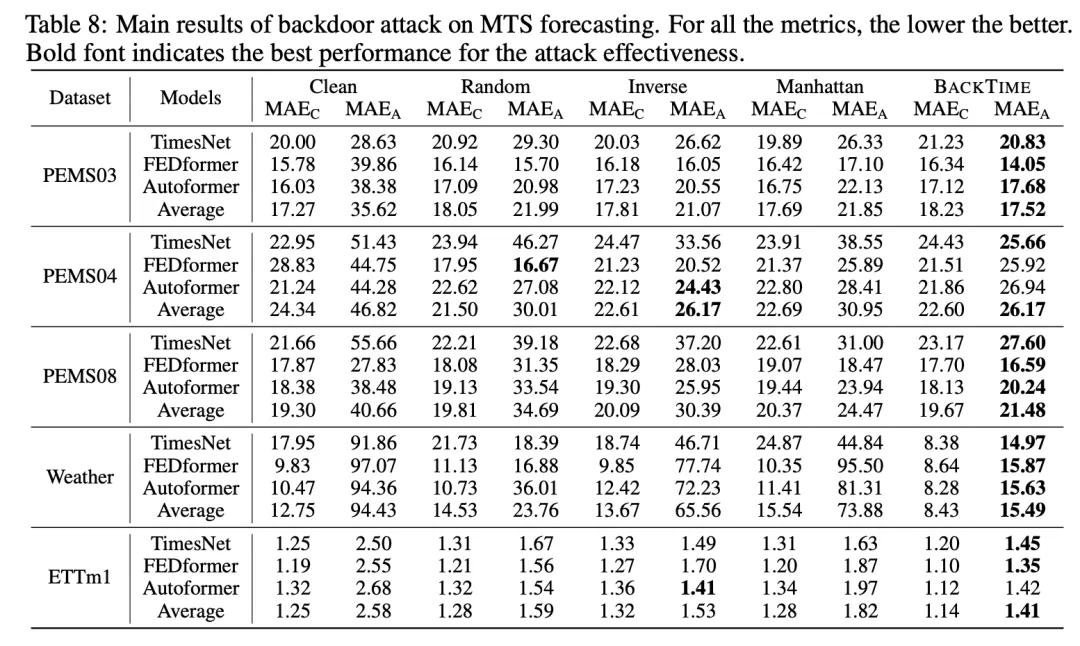

在 5 个数据集上,BackTime 可以对三种完全不同的 SOTA 时间序列分析模型实现有效的攻击(最低的 ),并同时保持这些模型的正常预测能力(较低的

),并同时保持这些模型的正常预测能力(较低的 )。这展现了 BackTime 模型无关的特性,并同时说明了其强大的攻击效果。

)。这展现了 BackTime 模型无关的特性,并同时说明了其强大的攻击效果。

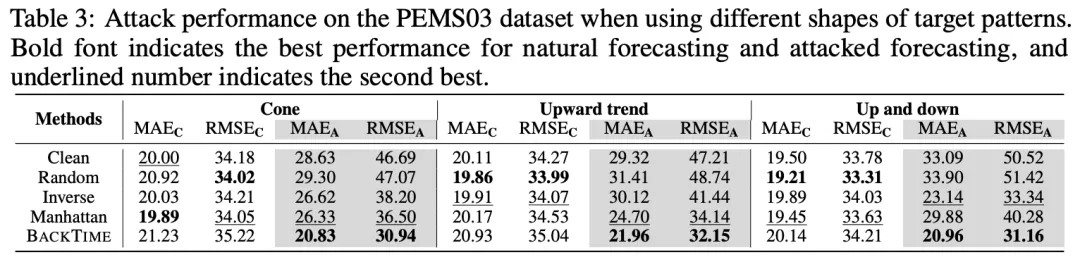

目标模式多样性衡量

论文作者使用了三种完全不同的目标模式,并观察 BackTime 的攻击效果。结果显示,BackTime 持续性取得最好的攻击表现(最低的 和

和 )。

)。

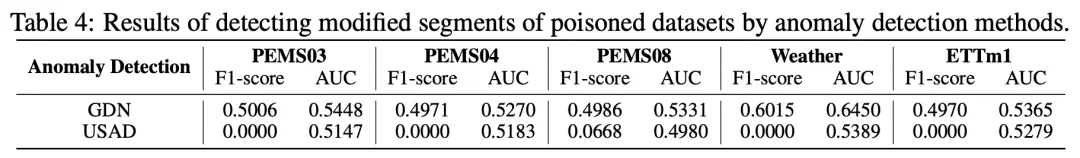

隐蔽性衡量

论文作者使用两种 SOTA 的时间序列异常检测模型来寻找被攻击数据集中的触发器和目标模式。结果显示,异常检测模型的结果无比接近于随机猜测,从而证明了触发器和目标模式的分布和真实数据的分布极为相似,证实了 BackTime 的隐蔽性。

持续研究和可行方向

时间序列预测的后门攻击是新兴的领域,存在很多探索的方向。我们在这里提供一些思路。除了在追求更高效和隐蔽的触发器之外,还有以下攻击问题没有解决。

首先,能否后门攻击时间序列缺失值推理任务(time series imputation)。当前的 BackTime 利用触发器和目标模式的顺序时间链接来实现攻击。但是推理任务需要同时考虑缺失值之前和之后的数据,这提出更难的攻击挑战。

其次,能否攻击包含缺失值的时间序列。BackTime 的触发需要包含全部触发器,因此很难处理带有缺失值的时间序列。