来自中国的视频生成模型,再一次震惊了全球大模型圈。

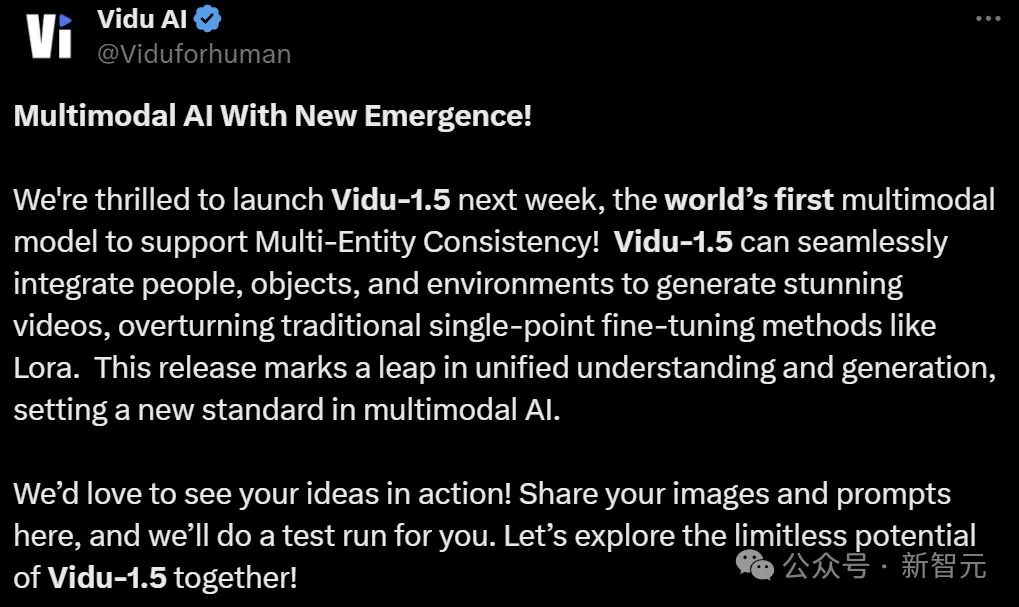

生数科技推出的Vidu 1.5,成为世界首个支持多主体一致性的多模态模型!

上传小哥、机甲、街景,接下来,就是见证奇迹的时刻。

人、物、环境,被天衣无缝地融合到了同一个视频中,简直令人惊叹。

这种方法,颠覆了LoRA等传统的单点微调方法,标志着视频模型统一理解和生成的飞跃!

多模态人工智能,从此有了新标准。

与诸多漫长期货的视频模型不同,Vidu只要不到30s,就能生成一段视频了!

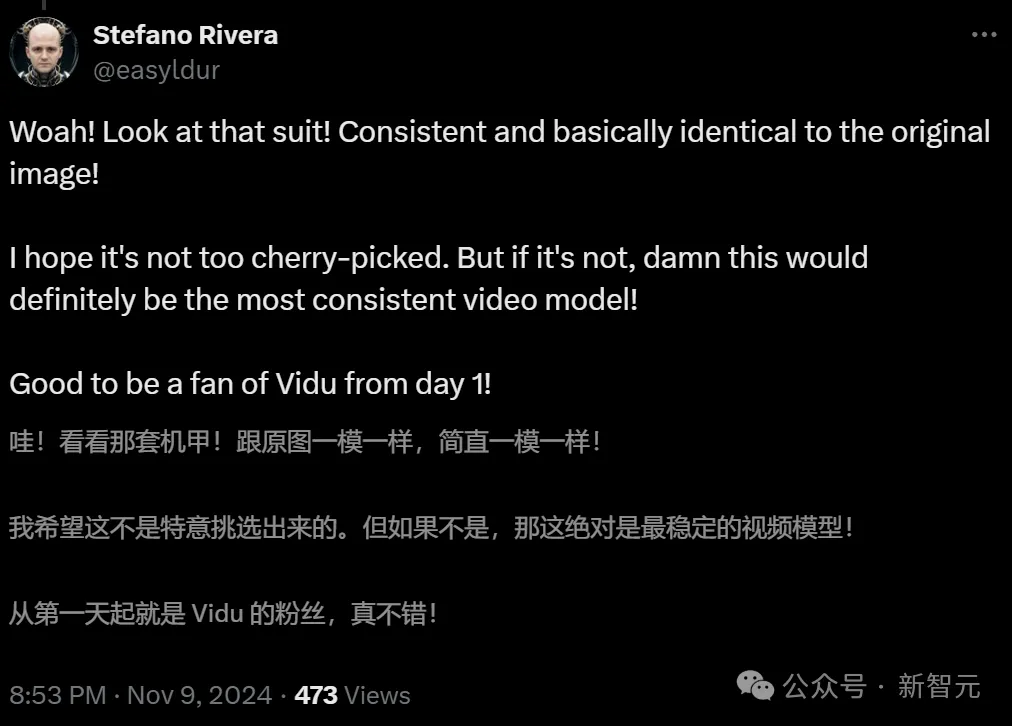

外国友人直接原地惊掉下巴:机甲跟原图一模一样,这绝对是最稳定的视频模型;有人更是言简意赅地给出评价:生数科技是名副其实的游戏规则改变者。

只要上传多个角色、物体和地点的图片,就能立即生成每个物体一致的场景,人手制作一部大片的时代真的来了吗?

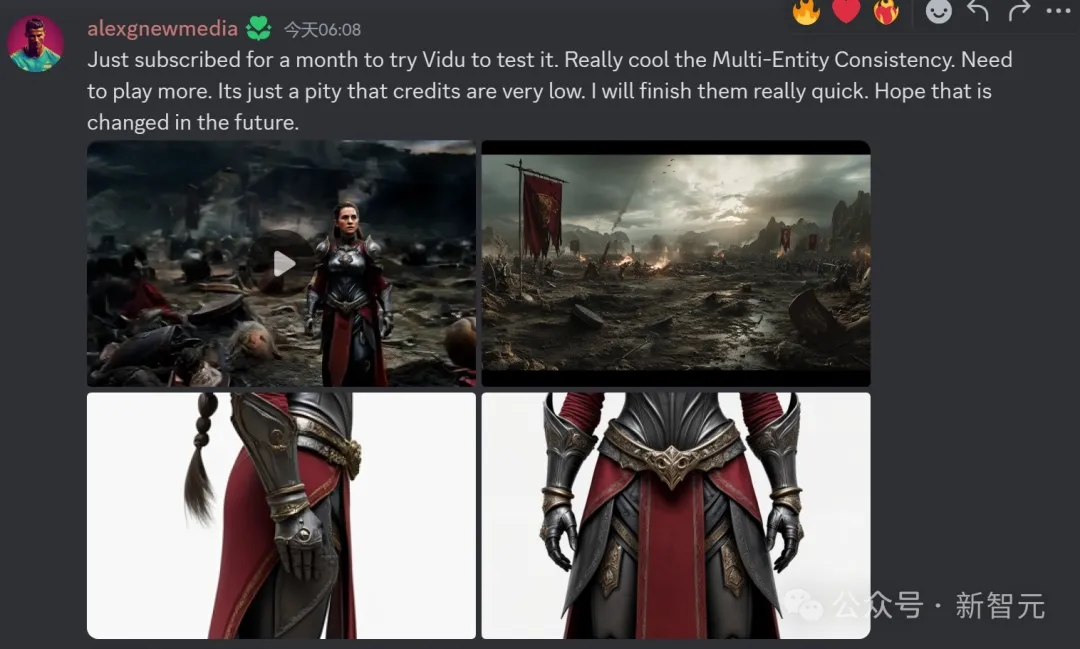

踊跃的网友们,在评论区纷纷贴出了自己的脑洞素材。

而霸气的官号直接在评论区随机摇人,抽中的网友提供的素材,果然诞生了一段段想象力爆棚的视频片段。

Vidu 1.5的推出,也揭示这样一个重要现象——

和语言模型一样,视觉模型经过充分训练后,能展现出对上下文的深刻理解、记忆等能力,这正是视觉模型智能涌现的显著特征!

这标志着,视觉模型进入了全新的「上下文」时代,AGI离我们更近了。

地表最强?率先攻克「多主体一致性」难题

一致性控制,是当前视频生成领域中,亟待解决的难题。

我们往往会遇到,AI视频生成的主体(人物/物体)的外观、特征、风格难以保持一致。

由Luma AI生成

更不要提对多个主体完成同时控制了。

不同主体间的特征,会让现有模型容易产生混淆。而且主体间互动也难以保持自然连贯。

如今,这一「世纪难题」被国产模型Vidu攻克了!

它全新上线的「多主体一致性」功能,通过上传1-3张参考图,就能实现对单主体100%精确控制。

同时,还可以实现多主体交互、主体与场景融合控制,让人物、道具、场景无缝集成。

具体来说,Vidu 1.5版本在以下方面,实现了技术突破。

单主体100%精准控制

就单主体而言,只需上传特定主体不同角度、场景下的图片,Vidu就能100%精准控制每个细节。

复杂单主体

通常的视频模型,在生成侧面、背面等刁钻视角画面时,往往靠模型自行脑补,往往会出现一些不符合用户预期的画面。

但是Vidu完全避免了这一问题!

不论是细节丰富的角色,还是复杂的物体,它都能保证在不同视角下单主体的一致性。

话不多说,直接上图。

如下的复古美女中,妆造极其复杂,Vidu能够胜任吗?

不论在任何场景中、视角下,尤其是特写镜头中,她的形象都能保持高度的一致。

即便是3D卡通人物,不论小男孩视角如何变化,他的发型、服饰等全角度保持高度一致。

提示为「小男孩在玩具城里行走,慢慢转身到背面,镜头轻微向右移动」。

传统视频模型在复杂视角切换时产生的瑕疵,统统不见了。

再来一个刁钻的要求,上传两张科比正面图,以及一张背面图,提示是「科比背对着镜头,慢慢转过身冲着镜头笑」。

这确实有点考验AI了。它脑补的画面能行吗?

一张特写,让科比重新回到「战场」,眨眼、微笑、自然摆臂动作,Vidu全部精准拿捏。

中国建筑构造的复杂程度,就不用多说了。那让Vidu生成雪景里的万象神宫,还能保留多少细节?

不论是从远景拉近,还是环绕四周,万象神宫的外观丝毫不变。

通过融合真实建筑和其他元素,Vidu能模拟出极其真实的场景。

人物面部特征和动态表情自然一致

Vidu做整体形象一致的同时,还应该实现面部特征和表情的自然连贯性。

不少AI视频之所以折戟,就是因为面部僵硬或失真太明显,从而导致AI味太浓。

而Vidu在创作细腻、真实角色时具有显著的优势。

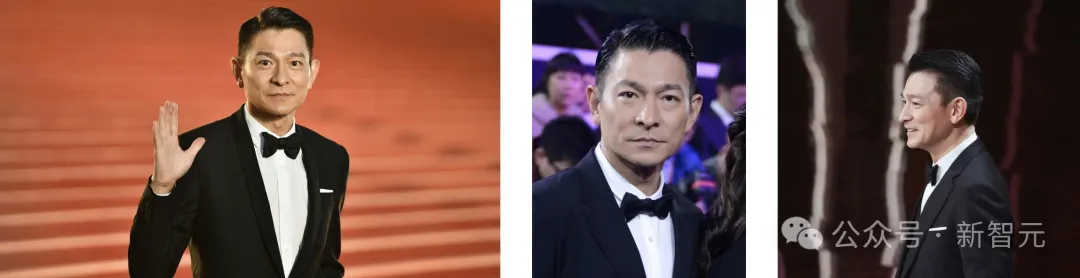

我们上传了三张刘德华的红毯照,然后输入提示词「一个男人在颁奖典礼上走红毯」。

只见,「不老男神」刘德华在红毯上朝我们挥手,显得非常自然。

再来看,下面三张不同角度的古风女孩照,Vidu的表现如何?

这张挥手打招呼,真实的微表情,难以让人相信这竟是AI生成的。

从微笑到难过,表情的过渡非常自然。

还有这张从侧面转身背影,Vidu丝毫没有面部僵硬或失真的现象。

同样,下面三张不同视角下的欧美风女孩,陶醉在金灿灿的稻田里。

由此不难看出,在人物特写画面中,Vidu能够确保面部细节特征、表情自然流畅变化,呈现了人物真实本色。

多主体一致性,三张图稳定输出

接下来,才是Vidu真正放大招的时候了。

现在,任何人可以在「多图参考」功能中选择上传多个主体。

它既可以是人物角色,也可以是人物+道具物体、环境背景等等,即便是「多主体」Vidu 1.5也能做到一致性控制。

主体+场景:任意地点想做什么就做什么

上传主体和场景图,就可以实现主体和场景的无缝融合。

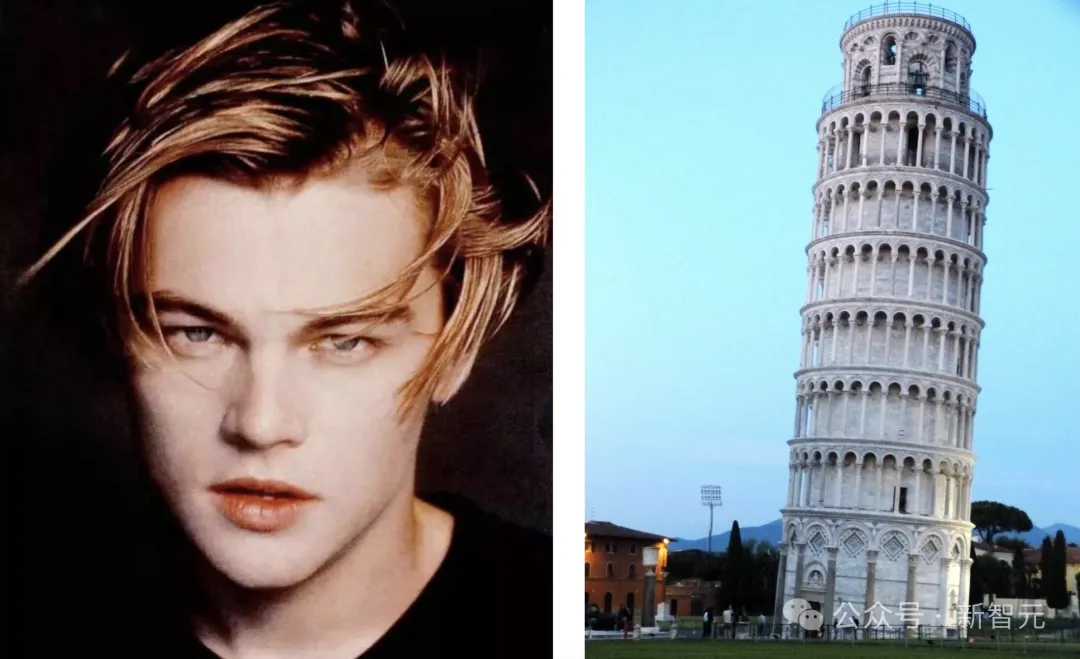

比如莱昂纳多的一张照片,就可以让他身处不同的地方,做不同的事。

比如,躺在沙滩的躺椅上。

再比如,在比萨斜塔前拍照。

亦或是,出演经典的电影桥段。

当然这里的主体不仅仅是人,还可以是物体。上传宫殿和手机,魔幻穿越大片这不就来了么。甚至,还把全是马赛克的背景,升级成了电影质感。

人物+道具+场景:以任何形象出现在任何场景

再来个更复杂的——穿着花棉袄的马斯克骑着电动车从游乐场经过。

在这个任务中,有三个主体(角色+道具),Vidu依然处理得天衣无缝。

或者,让小李子穿着粉色的裙子在沙发上跷二郎腿。

再比如,异星男孩、生日蛋糕,外加灵境般的背景,三张图片各不相同,但Vidu依旧可以让其完美地融为一体。

相比之下,国外爆火的Runway却无法理解场景图片,仅将最后两张图片合二为一。

Luma AI就更差些了,将图片罗列出来,像播放幻灯片一样。

总结来说,一致性能够更好融入场景。

双角色主体:次元壁破了!

有了这个超能力,我们就能让雷总和马斯克在一个办公室谈合作了。

你喜欢的IP,也可以联动了。

比如,百变小樱和雷姆一起对着镜头微笑。

有趣的是,Vidu还能融合不同主体特征,将角色A的正面和角色B的反面无缝融合,创造出全新的角色或物体——

球王梅西转过头来,竟然是马斯克。

当然,在创作之余,如今我们还可以借助Vidu的这些新能力恶搞表情包。

比如,从背影看是一位妙龄的少女,没想到转头竟然……还是小李子!

百日进化,Vidu技术解析

如此惊艳的能力背后,其实Vidu也不过刚刚上线逾百日。

早在上线之初,Vidu便具备了「角色一致性」的生成能力,可以通过锁定人物面部特征解决了视频生成中的关键痛点,确保人物面部特征的一致性。

9月,Vidu又于全球率先发布了「主体一致性」功能,将面部一致拓展至全身一致,并且将范围由人物形象扩展到动物、物体、虚拟角色等任意主体。

原图

角色一致性:仅面部保持一致

主体一致性:全身形象保持一致

要知道,除了Vidu,目前其他视频生成模型都无法有效控制面部一致性。

如果一定要实现,还得采用LoRA方案,通过大量相似数据的输入,来进行成本昂贵的单点微调。

但Vidu已经实现了对单主体的精准控制,甚至多主体的一致性生成。

此前生数一直坚信,随着基础模型的投入和迭代,整体泛化能力将得到大幅增强,可以展现出上下文学习能力,无需再依赖复杂的单点微调。

Vidu 新版本的发布,正式证明了这点!从1.0到1.5版本,生数科技已实现世界领先水平的突破。

这次跃阶背后,究竟有哪些技术革新?

无微调大一统架构

以前的视频模型如果想实现一致性生成能力,都不得不对每个场景设计相应的模型进行微调。

它们并不能像语言模型一样,通过上下文学习,基于少量的示例或提示,快速适应新任务。

生数科技却探索出了一条完全与众不同的路。

秉承通用性的理念,Vidu有和LLM一致的设计哲学:

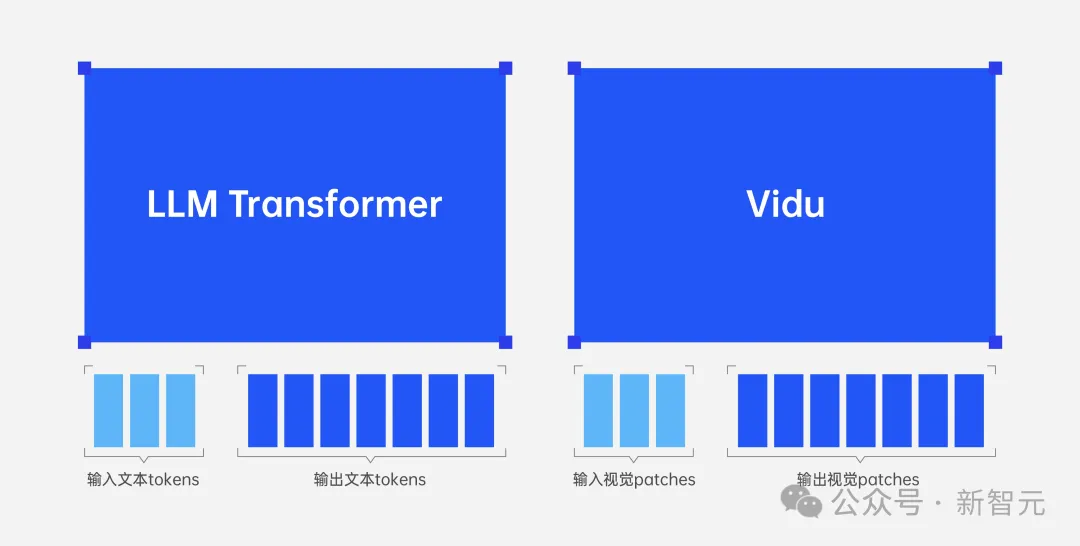

- 统一问题形式:LLM将所有问题统一为(文本输入,文本输出),Vidu则将所有问题统一为(视觉输入,视觉输出);

- 统一架构:LLM和Vidu均用单个网络统一建模变长的输入和输出;

- 压缩即智能:LLM从文本数据的压缩中获取智能,Vidu从视频数据的压缩中获取智能。

设计哲学一致外,在架构复杂性、数据多样性、生成效率等方面,多模态大模型门槛更高,在此挑战下,Vidu在世界范围内率先推动多模态大模型产生智能涌现,如OpenAI引领LLM的进步和创新。

LLM和Vidu技术架构方案对比

三张图,终结LoRA炼丹

更值得关注的是,三张图高一致性的突破,是Vidu背后基础模型能力的全面提升。

无需专门数据采集、标注、微调训练环节,一键直出高一致性视频。

要知道,LoRA(Low-Rank Adaptation)微调方案一直以来是业界解决一致性问题最主流的方案。

它需要在预训练模型基础上,用特定主体多段视频进行微调,让模型理解主体特征,进而生成其在不同角度、光线、场景下的形象。

同时,还要保证在若干次不同生成时的一致性。

简单理解,比如我创作了一只卡通狗的形象,想生成连续一致的视频画面,但模型在预训练过程中并没有学习过该形象,所以需要拿卡通狗的多段视频,让模型进一步训练,让模型认识这只卡通狗长什么样,从而能够生成。

但问题是,LoRA前提是需要20~100段视频才能实现。

由于数据构造繁琐,且需要数个小时,甚至更久的训练时间,而且成本还是单次视频生成的成百上千倍。

另外,LoRA微调模型另一弊端是容易产生过拟合,即在理解主体特征的同时,也会遗忘大量原先的知识。

这导致在动态表情、肢体动作生成控制方面,LoRA难以精准把握,容易呈现出僵硬、不自然的效果。

特别是,在处理复杂或幅度较大的动作变化时,微调模型在细节捕捉上的局限性更为明显,最终导致主体特征不够精准。

因此,LoRA方案只能满足简单场景下主体一致性需求。

但对于高复杂主体、场景时,往往需要更大规模微调数据,以及更复杂的微调策略。

而Vidu凭借强大通用模型能力,仅用三张图,实现高可控稳定输出。

这一过程,直接直接省去「炼丹」环节,堪称「LoRA终结器」!

视觉模型,正式进入「上下文时代」

怎样才能实现多主体一致性的生成任务?

首先模型要做到的,就是能同时理解「多图的灵活输入」。并且,不仅在数量上是多图输入,图片还要不限于特定特征。

这就和语言模型的「上下文学习」能力显著相似。

为什么语言模型能理解上下文?关键就在于,它不仅会处理单一的文本输入信息,还能通过关联前后的文本、识别语句间的关系,让生成的回答连贯、符合情境。

同样,在视频生成或多图生成任务中,模型也需要能理解多个输入图像的准确含义,及它们之间的关联性,然后还要根据这些信息,生成一致、连贯且有逻辑的输出。

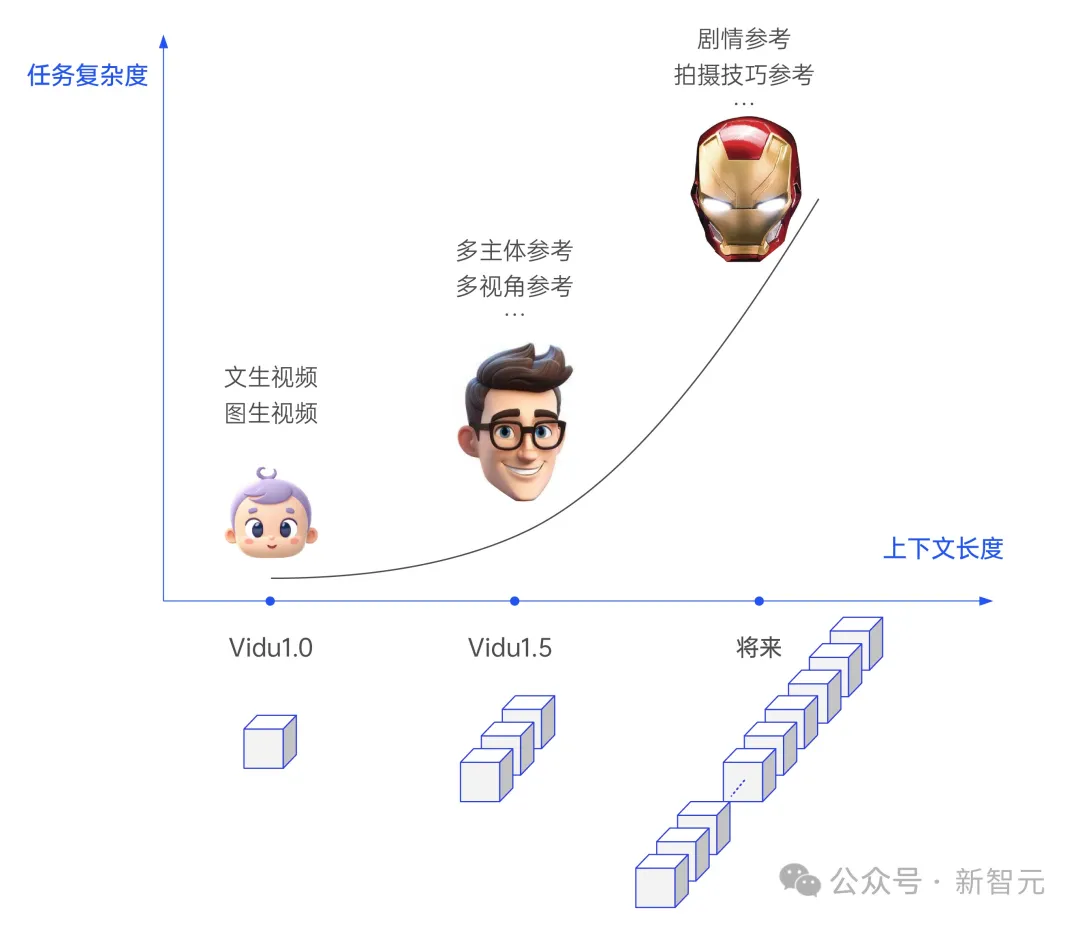

通过不断扩展上下文长度,Vidu从1.0迭代到1.5后,就已经出现了明显的智能涌现效应,通过视觉上下文,就能直接生成大量新任务下的视频了!

视觉智能涌现,加速AGI到来

语言模型的发展,已然呈现了一条通往AGI的可行路径。

然而,依赖单一的文本输入仍无法实现全面逼近人类的高度智能。

要实现更加通用和全面的智能,必须对更多模态进行良好的理解和生成建模,尤其是视觉模态,它为AI提供更加直观、丰富的世界理解方式,是通往AGI的关键一环。

的确,和语言模型在深层次智能上的突破相比,视觉模型目前尚存在较大差距。

但Vidu 1.5版本展现出智能涌现,意味着视觉模型不仅能理解、能想象,还能在生成过程中进行记忆管理。

曾经大语言模型独有的优势,竟在视觉模型中体现出来了。

至此,Vidu已不再仅仅是高质量、高效的视频生成器,在生成过程中融入上下文和记忆,无疑意味着视觉模态智能的大跨越。

具备更强认知的视觉模型,将成为AGI的一块重要拼图。