译者 | 布加迪

审校 | 重楼

使用Hugging Face Transformers对T5模型进行微调以处理问题回答任务很简单:只需为模型提供问题和上下文,它就能学会生成正确的答案。

T5是一个功能强大的模型,旨在帮助计算机理解和生成人类语言。T5的全称是“文本到文本转换器”。它是一个可以完成许多语言任务的模型。T5将所有任务视为文本到文本问题。我们在本文中将学习如何优化T5以回答问题。

安装所需的库

首先,我们必须安装必要的库:

- Transformer:提供T5模型及其他Transformer架构的Hugging Face库。

- 数据集:访问和处理数据集的库。

- Torch:帮助构建和训练神经网络的深度学习库。

加载数据集

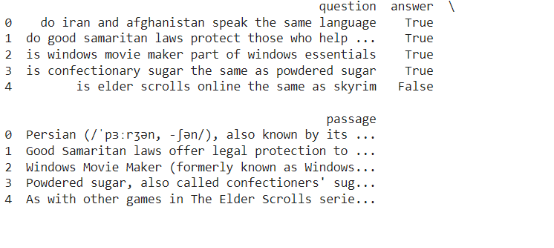

为了对T5进行微调以回答问题,我们将使用BoolQ数据集,该数据集含有答案为二进制(是/否)的问题/答案对。你可以使用Hugging Face的数据集库来加载BoolQ数据集。

预处理数据

T5要求输入采用特定的格式。我们需要更改数据集,以便问题和答案都是文本格式。输入格式为问题:上下文:,输出将是答案。现在,我们需要加载T5模型及其分词器(Tokenizer)。分词器将把我们的文本输入转换成模型可以理解的词元ID(token ID)。接下来,我们需要对输入和输出数据进行分词。分词器将文本转换成输入ID和注意力掩码,这是训练模型所必需的。

微调T5

现在数据已经准备好了,我们可以对T5模型进行微调了。Hugging的Trainer API通过处理训练循环、优化和评估简化了这个过程。

评估模型

在微调之后,重要的是在验证集上评估模型,看看它如何很好地回答问题。你可以使用Trainer的评估方法。

进行预测

一旦T5模型经过微调和评估,我们就可以用它来预测新的问题回答任务。为此,我们可以准备一个新的输入(问题和上下文),对其进行分词,从模型生成输出(答案)。

结论

总之,微调T5可以帮助它更好地回答问题。我们学习了如何准备数据和训练模型。使用Hugging库使这个过程更容易。训练后,T5可以听懂问题并给出正确的答案。这对聊天机器人或搜索引擎等许多应用大有帮助。

原文标题:How to Fine-Tune T5 for Question Answering Tasks with Hugging Face Transformers,作者:Jayita Gulati