Hello folks,我是 Luga,今天我们继续来聊一下人工智能生态相关技术 - 用于加速构建 AI 核心算力的 GPU 编程框架 - CUDA 。

CUDA,作为现代图形处理器(GPU)的计算单元,在高性能计算领域扮演着日益重要的角色。通过将复杂的计算任务分解为数千个线程并行执行,CUDA 显著提升了计算速度,为人工智能、科学计算、高性能计算等领域带来了革命性的变革。

CUDA 到底是什么 ?

毋庸置疑,你一定听说过 CUDA,并了解这玩意与 NVIDIA GPU 密切相关。然而,关于 CUDA 的具体定义和功能,许多人仍然心存疑惑,一脸懵逼。CUDA 是一个与 GPU 进行通信的库吗?

如果是,它属于 C++ 还是 Python 库?或者,CUDA 实际上是一个用于 GPU 的编译器?了解这些问题有助于更好地掌握 CUDA 的核心特性及其在 GPU 加速中的作用。

CUDA,全称为 “ Compute Unified Device Architecture ”,即“计算统一设备架构”,是 NVIDIA 推出的一套强大并行计算平台和编程模型框架,为开发人员提供了加速计算密集型应用的完整解决方案。CUDA 包含运行时内核、设备驱动程序、优化库、开发工具和丰富的 API 组合,使得开发人员能够在支持 CUDA 的 GPU 上运行代码,大幅提升应用程序的性能。这一平台尤为适合用于处理大规模并行任务,如深度学习、科学计算以及图像处理等领域。

通常而言,“CUDA” 不仅指平台本身,也可指为充分利用 NVIDIA GPU 的计算能力而编写的代码,这些代码多采用 C++ 和 Python 等语言编写,以充分发挥 GPU 加速的优势。借助 CUDA,开发人员能够更加轻松地将复杂的计算任务转移至 GPU 运行,极大提升应用程序的运行效率。

因此,总结起来,我们可以得出如下结论:

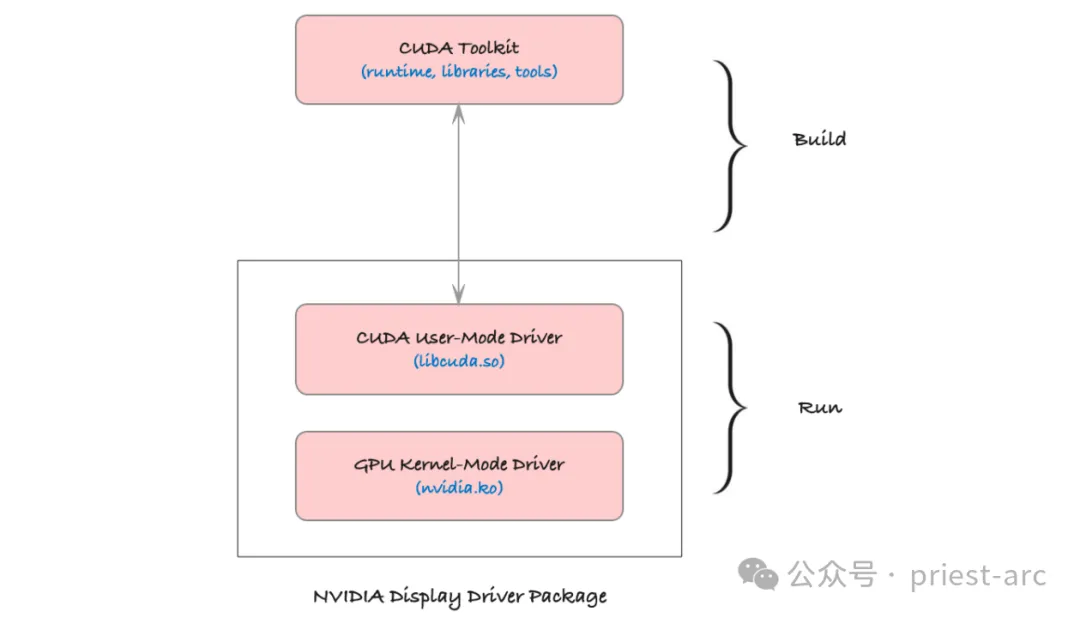

CUDA 不仅仅是一个简单的库,它是一个完整的平台,为开发者提供了利用 GPU 进行高效并行计算的全方位支持。这个平台的核心组件包括:

- CUDA C/C++:这是 CUDA 为并行编程所扩展的 C++ 语言,专为在 GPU 上编写并行代码而设计。开发者可以使用熟悉的 C++ 语法结构,通过特定的编程模型定义 GPU 任务,让代码更高效地在多线程环境中执行。

- CUDA 驱动程序:这一组件连接操作系统与 GPU,提供底层硬件访问接口。驱动程序的主要作用是管理 CPU 与 GPU 之间的数据传输,并协调它们的计算资源。它确保了硬件和操作系统的兼容性,是 CUDA 代码高效运行的基础。

- CUDA 运行时库(cudart):运行时库为开发者提供了丰富的 API,便于管理 GPU 内存、启动 GPU 内核(即并行任务)、同步线程等。它简化了开发者的工作流程,使得在 GPU 上运行并行程序的流程更加流畅和高效。

- CUDA 工具链(ctk):包括编译器、链接器、调试器等工具,这些工具用于将 CUDA 代码编译成 GPU 可执行的二进制指令。工具链中的编译器将 C++ 代码和 CUDA 内核代码一同处理,使其适应 GPU 的架构;而调试器和分析工具帮助开发者优化性能和排查问题。

相关的环境变量可参考如下:

- $CUDA_HOME是系统CUDA的路径,看起来像/usr/local/cuda,它可能链接到特定版本/usr/local/cuda-X.X。

- $LD_LIBRARY_PATH是一个帮助应用程序查找链接库的变量。您可能想要包含$CUDA_HOME/lib的路径。

- $PATH应该包含一个通往$CUDA_HOME/bin的路径。

借助这一完整的开发平台,开发者能够充分挖掘 NVIDIA GPU 的计算潜力,将复杂的并行计算任务高效地分配至 GPU 上执行,从而实现应用程序性能的极大提升。

CUDA 是如何工作的 ?

现代 GPU 由数千个小型计算单元组成,这些单元被称为 CUDA 核心。CUDA 核心能够高效并行工作,使 GPU 能够快速处理那些可以分解为多个小型独立操作的任务。这种架构使得 GPU 不仅适用于图形渲染任务,也适用于计算密集型的科学计算和机器学习等非图形任务。

作为 NVIDIA 提供的一个计算平台和编程模型,CUDA 专门为 GPU 开放了这些强大的并行处理能力。通过 CUDA,开发者可以编写代码,将复杂的计算任务移交给 GPU。以下是 CUDA 的工作原理:

(1) 并行处理

CUDA 将计算任务分解为多个可以独立运行的小任务,并将这些任务分配到多个 CUDA 核心上并行执行。这样一来,与传统 CPU 顺序执行的模式相比,GPU 可以在相同时间内完成更多的计算,从而极大地提升计算效率。

(2) 线程和块的架构

在 CUDA 编程模型中,计算任务被进一步划分为线程,每个线程独立处理一部分数据。这些线程被组织成块,每个块中包含一定数量的线程。这种层次化结构不仅便于管理海量线程,还提高了执行效率。多个线程块可以同时运行,使得整个任务可以快速并行完成。

(3) SIMD 架构

CUDA 核心采用单指令多数据(Single Instruction, Multiple Data,简称 SIMD)架构。这意味着单条指令可以对多个数据元素同时执行操作。例如,可以用一条指令对大量数据元素进行相同的计算,从而加快数值计算的速度。这种架构对矩阵运算、向量处理等高并行任务极为高效,特别适用于深度学习模型训练、图像处理和模拟仿真等领域。

基于这些特性,CUDA 不仅为高性能并行计算提供了直接途径,也将 NVIDIA GPU 的强大计算潜力拓展至科学计算、人工智能、图像识别等领域,为开发者实现复杂计算任务的加速提供了强有力的支持。

CUDA 编程模型

在 CUDA 编程中,开发者通常需要编写两部分代码:主机代码(Host Code)和设备代码(Device Code)。

主机代码在 CPU 上运行,负责与 GPU 进行交互,包括数据传输和资源管理;而设备代码则在 GPU 上执行,承担主要计算任务。二者相互配合,充分利用 CPU 和 GPU 的协同处理能力,以达到高效并行计算的目的。

(1) 主机代码:主机代码运行在 CPU 上,负责控制整个程序的逻辑流程。它管理 CPU 和 GPU 之间的数据传输,分配和释放 GPU 资源,并配置 GPU 内核参数。这部分代码不仅定义了如何组织数据并将其发送到 GPU,还包含了启动设备代码的指令,从而让 GPU 接管计算密集的任务。主机代码起到管理和协调的作用,确保 CPU 与 GPU 之间的高效协作。

此部分包括数据传输、内存管理、以及启动 GPU 内核等,具体功能可参考如下所示:

- 数据传输管理:主机代码负责在 CPU 和 GPU 之间传输数据。由于 CPU 和 GPU 通常使用不同的内存系统,主机代码需要在两者之间复制数据。例如,将需要处理的数据从主机内存(CPU 内存)传输到设备内存(GPU 内存),并在处理完成后将结果从 GPU 内存传回 CPU 内存。这种数据传输是耗时的,因此在实际应用中需要尽量减少传输频率,并优化数据大小,以降低延迟。

- 内存分配与管理:主机代码分配 GPU 内存空间,为后续的计算提供储存资源。CUDA API 提供了多种内存管理函数(如 cudaMalloc 和 cudaFree),允许开发者在 GPU 上动态分配和释放内存。合理的内存分配策略可以有效提高内存使用效率,防止 GPU 内存溢出。

- 内核配置与调度:在主机代码中,开发者可以配置内核启动参数(如线程数和线程块数)并决定内核在 GPU 上的执行方式。通过优化这些参数,主机代码能够显著提升程序的执行效率

(2) 设备代码:设备代码编写的核心部分是在 GPU 上执行的计算函数,通常被称为内核(Kernel)。每个内核函数在 GPU 的众多 CUDA 核心上并行执行,能够快速处理大量数据。设备代码专注于数据密集型的计算任务,在执行过程中充分利用 GPU 的并行计算能力,使得计算速度比传统的串行处理有显著提升。

设备代码定义了 GPU 的计算逻辑,使用 CUDA 内核来并行处理大量数据。

- 内核函数(Kernel Function):设备代码的核心是内核函数,即在 GPU 的多个线程上同时执行的函数。内核函数由 __global__ 关键字标识,表示该函数将在设备端(GPU)执行。内核函数与普通的 C/C++ 函数不同,它必须是无返回值的,因为所有输出结果都要通过修改传入的指针或 GPU 内存来传递。

- 线程和线程块的组织:在设备代码中,计算任务被分解为多个线程,这些线程组成线程块(Block),多个线程块组成一个线程网格(Grid)。CUDA 提供了 threadIdx、blockIdx 等内置变量来获取线程的索引,从而让每个线程在数据中找到属于自己的计算任务。这种方式使得设备代码可以非常高效地并行处理数据集中的每个元素。

- 并行算法优化:在设备代码中,CUDA 编程可以实现多个并行优化技术,例如减少分支、优化内存访问模式(如减少全局内存访问和提高共享内存利用率),这些优化有助于最大化利用 GPU 计算资源,提高设备代码的执行速度。

(3) 内核启动:内核启动是 CUDA 编程的关键步骤,由主机代码启动设备代码内核,在 GPU 上触发执行。内核启动参数指定了 GPU 上线程的数量和分布方式,使内核函数可以通过大量线程并行运行,从而加快数据处理速度。通过适当配置内核,CUDA 编程能以更优的方式利用 GPU 资源,提高应用的计算效率。

在整个体系中,这一步骤至关重要,它控制了设备代码的并行性、效率及运行行为。具体可参考如下:

- 内核启动语法:CUDA 使用特殊的语法 <<<Grid, Block>>> 启动内核函数。例如:kernel<<<numBlocks, threadsPerBlock>>>(parameters);,其中 numBlocks 表示线程块的数量,threadsPerBlock 表示每个线程块中包含的线程数。开发者可以根据数据集的大小和 GPU 的计算能力选择合适的线程块和线程数量。

- 并行化控制:通过指定线程块数和线程数,内核启动控制了 GPU 的并行粒度。较大的数据集通常需要更多的线程和线程块来充分利用 GPU 的并行能力。合理配置内核启动参数,可以平衡 GPU 的并行工作负载,避免资源浪费或过载现象。

- 同步与异步执行:内核启动后,GPU 可以异步执行任务,CPU 继续进行其他操作,直至需要等待 GPU 完成。开发者可以利用这种异步特性,使程序在 CPU 和 GPU 间并行执行,达到更高的并行效率。此外,CUDA 提供了同步函数(如 cudaDeviceSynchronize),确保 CPU 在需要时等待 GPU 完成所有操作,避免数据不一致的问题。

通过有效协调这三者,CUDA 编程能够实现对数据密集型任务的高速并行处理,为高性能计算提供了一个极具扩展性的解决方案。

CUDA 内存层次结构体系

在 CUDA 编程中,GPU 内存的结构是多层次的,具有不同的速度和容量特性。CUDA 提供了多种内存类型,用于不同的数据存储需求。合理利用这些内存可以显著提升计算效率。以下是各类内存的详细描述:

(1) 全局内存(Global Memory)

全局内存是 GPU 上容量最大的存储空间,通常为几 GB,并且是 GPU 的主要数据存储区。全局内存可以被所有线程访问,也可以与 CPU 共享数据,但其访问速度相对较慢(相对于其他 GPU 内存类型而言),因此需要避免频繁访问。数据传输操作也较耗时,因此全局内存常用于存储较大的数据集,但会优先考虑数据访问的批处理或其他缓存策略来减少其频繁调用。

通常而言,全局内存主要适用于存储程序的大部分输入输出数据,尤其是需要 GPU 和 CPU 共享的大容量数据。

示例:在矩阵乘法中,两个矩阵的元素可以存储在全局内存中,以便所有线程都可以访问。

__global__ void matrixMultiplication(float *A, float *B, float *C, int N) {

int row = blockIdx.y * blockDim.y + threadIdx.y;

int col = blockIdx.x * blockDim.x + threadIdx.x;

float sum = 0.0;

for (int i = 0; i < N; ++i) {

sum += A[row * N + i] * B[i * N + col];

}

C[row * N + col] = sum;

}(2) 共享内存(Shared Memory)

共享内存是分配在 GPU 每个线程块内部的高速缓存,其访问速度远高于全局内存,但容量较小(通常为每块 48 KB 或更少)。共享内存是线程块内线程共享的,适合存储需要在一个线程块内频繁访问的数据。由于它存储在各自的块内,每个块内的线程可以在共享内存中快速读写数据,从而减少对全局内存的访问。

相对于全局内存,共享内存更多适用于多线程间的数据交换,尤其是需在一个线程块内反复使用的数据。

示例:在矩阵乘法中,A 和 B 的子块可以加载到共享内存中,以便线程块中的所有线程都可以快速访问。

__shared__ float sharedA[TILE_SIZE][TILE_SIZE];

__shared__ float sharedB[TILE_SIZE][TILE_SIZE];(3) 本地内存(Local Memory)

本地内存是分配给每个线程的私有内存,主要用于存储线程的私有变量。尽管称为“本地”,它实际上是分配在全局内存中,因此访问速度较慢,接近全局内存的访问速度。由于本地内存容量有限且其访问开销较高,建议只在必要时使用。

通常情况下,本地内存适用于存储线程的临时变量、私有数据或不适合在寄存器中保存的数据。

示例:对于复杂计算中的中间变量,可以放置在本地内存中,以便线程之间不发生冲突。

int localVariable = 0; // 本地内存中的变量(4) 常量和纹理内存(Constant and Texture Memory)

常量内存和纹理内存分别是 CUDA 提供的专用于只读数据的内存类型,具有特殊的缓存机制,能够在特定访问模式下加快数据读取。常量内存用于存储不会更改的常量数据,而纹理内存适合存储二维或三维数据,通过纹理缓存可以提高访问速度。

常量内存(Constant Memory):仅可由 CPU 写入,但可被所有 GPU 线程读取。适合存储小规模的、不变的数据(如配置信息、系数等)。

纹理内存(Texture Memory):专门优化以支持二维或三维数据的读取,对于非顺序或稀疏访问模式的数据(如图像数据)具有较高的访问效率。

示例:在图像处理应用中,将像素数据加载到纹理内存中,让 GPU 利用其特定的缓存机制来优化访问效率。

__constant__ float constData[256]; // 常量内存

cudaArray* texArray;

cudaChannelFormatDesc channelDesc = cudaCreateChannelDesc<float>();

cudaMallocArray(&texArray, &channelDesc, width, height); // 纹理内存CUDA平台为开发人员提供了对CUDA GPU并行计算资源的深度访问,允许直接操作GPU的虚拟指令集和内存。通过使用CUDA,GPU可以高效地处理数学密集型任务,从而释放CPU的计算资源,使其能够专注于其他任务。这种架构与传统GPU的3D图形渲染功能有着本质的区别,开创了GPU在计算领域的新用途。

在CUDA平台的架构中,CUDA核心是其核心组成部分。每个CUDA核心都是一个独立的并行处理单元,负责执行各种计算任务。GPU中的CUDA核心数量越多,它能够并行处理的任务就越多,从而显著提升计算性能。通过这种并行计算,CUDA平台能够在复杂的计算过程中实现大规模任务的并行处理,提供卓越的性能和高效性。

Reference :

- [1] https://acecloud.ai/resources/blog/why-gpus-for-deep-learning/

- [2] https://www.weka.io/learn/glossary/ai-ml/cpu-vs-gpu/