传闻证实,微软机器学习理论万引大佬,官宣跳槽加入OpenAI。

入职第一天,他便发出如此感慨:

这个地方的人才密度,简直是疯了!

话一说出去就得到印证,他口中的人才们都来评论区排队欢迎了。

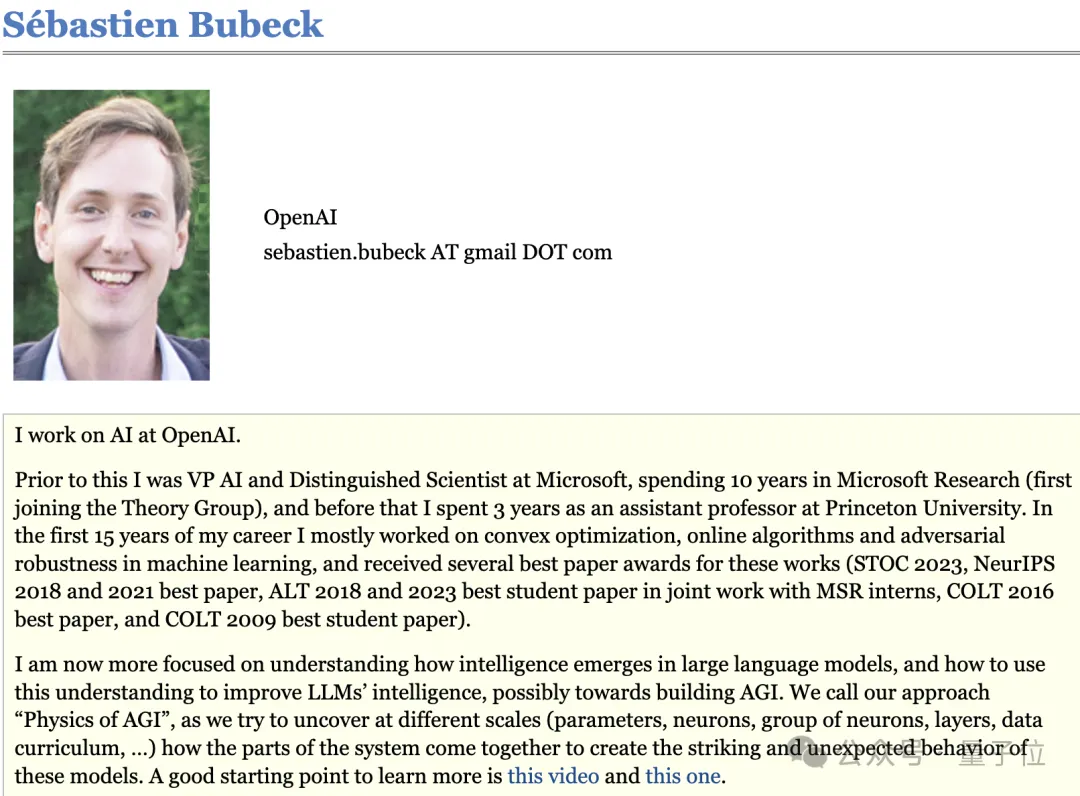

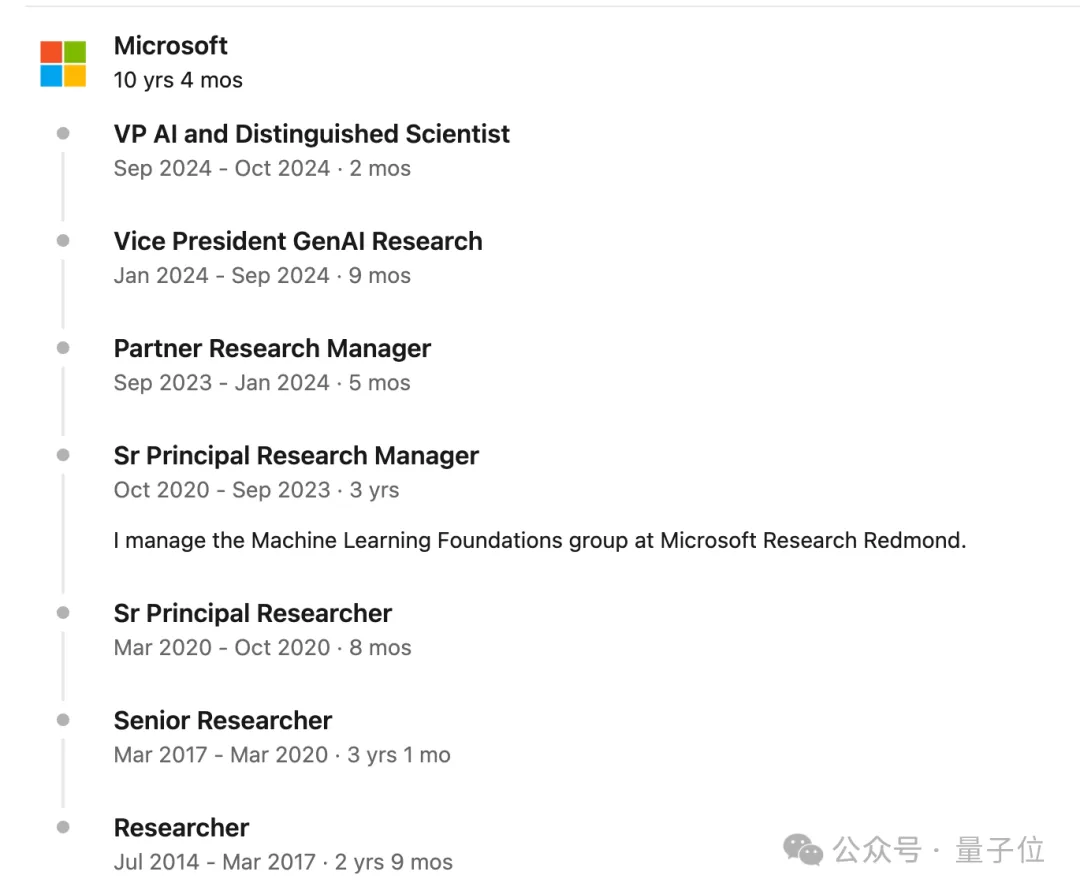

他是Sebastien Bubeck,微软前AI副总裁和杰出科学家,在微软工作10年。

2021年,他曾用一篇理论研究展示扩大AI模型规模的重要性,帮助说服微软CEO纳德拉在AI基础设施上增加数十亿美元的投资。

他的职业生涯前15年都投入在计算机理论和机器学习理论,研究的是凸优化、在线学习和对抗稳健性这些问题,直到——

微软作为OpenAI合作伙伴,派他参与了未安全对齐版GPT-4早期测试,期间他来了一场戏剧性的转型。

全面转向AGI研究。

在当时外界还只接触过GPT-3.5的背景下,看起来就像“理论学者转型研究科幻了”,而他本人是这么解释的:

现在我更关注大型语言模型中智能是如何形成,如何利用这种理解提高模型性能,并可能迈向构建AGI。

我们的方法称作“AGI的物理学”(Physics of AGI)。

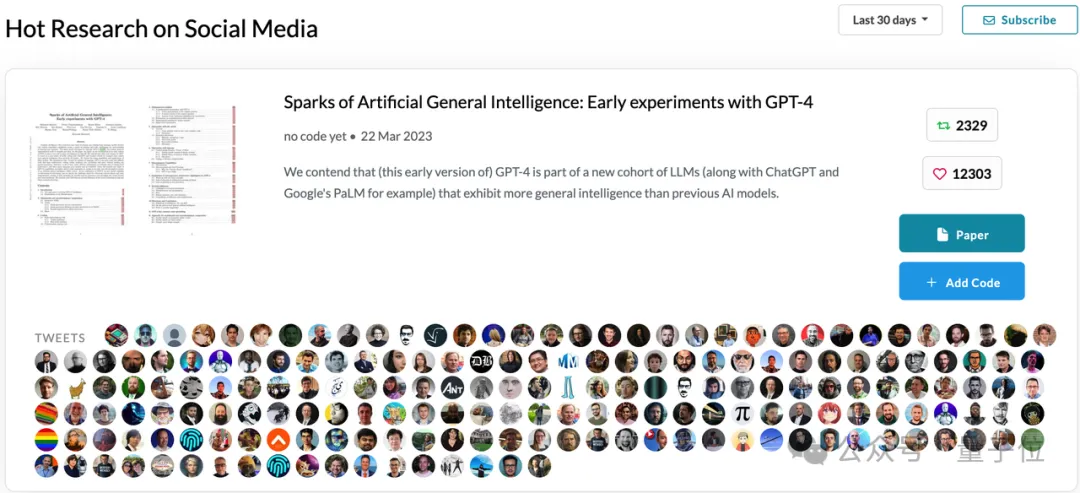

之后他便带领微软团队发布一篇154页的GPT-4实验报告《AGI的火花》,一时引起全业界轰动,成为人们对AI过高期待的重要推手。

后来他承认过当时的实验方法并不算严格,但并不后悔,并坚持“没有证据否定GPT-4已经具有一定推理能力”。

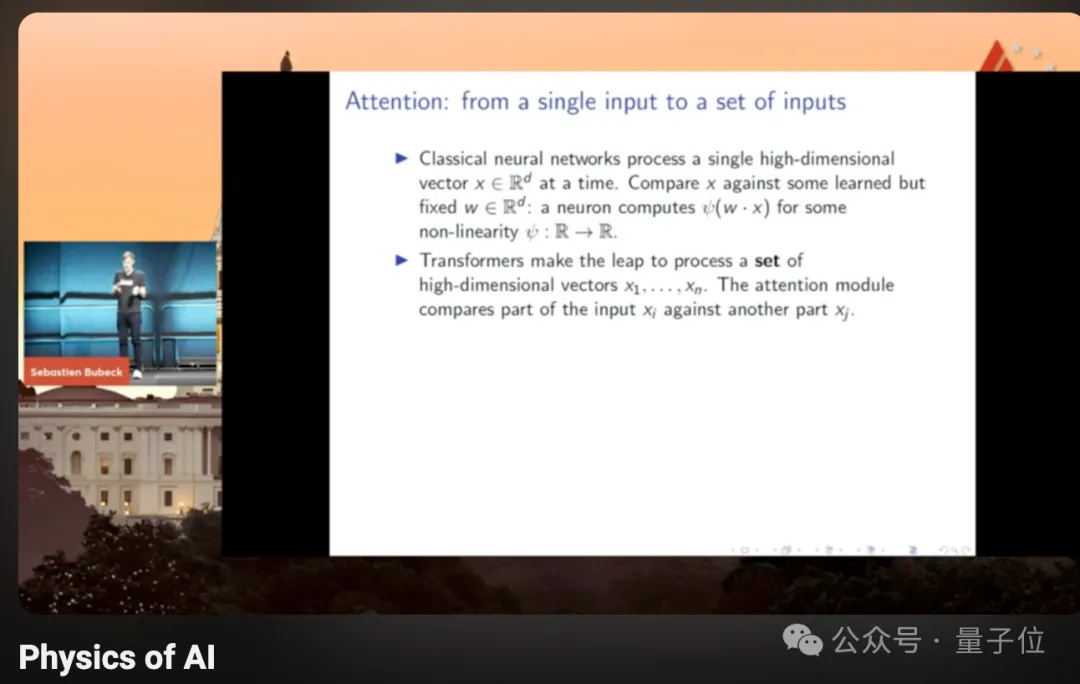

在转型期间的一次演讲中,他分享了自己对“Transformer到底有什么特别之处”的思考,指出很多人容易忽略的一点:Transformer不是序列模型。

与RNN等模型关键区别在于Transformer一次处理一个集合,而不是序列中的单个输入。

集合是一种强大的抽象层次,让模型能看到元素之间的关系,从“绝对机器”变成相对机器。

这次他加入OpenAI的时机非常微妙,本人强调是在“开发安全AGI的关键时刻加入”。

微软发言人的声明中也提到,“Sebastien已决定离开微软,以进一步开发AGI”。

同时,现在也是OpenAI和微软联盟渐渐破裂的时刻,奥特曼和OpenAI首席财务官近期对员工抱怨,微软行动速度不够快,没有提供足够的服务器。

两家开始相互视对方为备胎,OpenAI找了甲骨文做额外的云计算供应商,微软也开始在旗下产品中接入谷歌和Anthropic模型。

不得不说,很耐人寻味。

一篇论文影响微软对AI的数十亿美元投入

Sebastien Bubeck,2010博士毕业于法国里尔第一大学数学专业。

在普林斯顿大学做三年助理教授后,于2014年加入微软,从普通研究员一路做到VP。

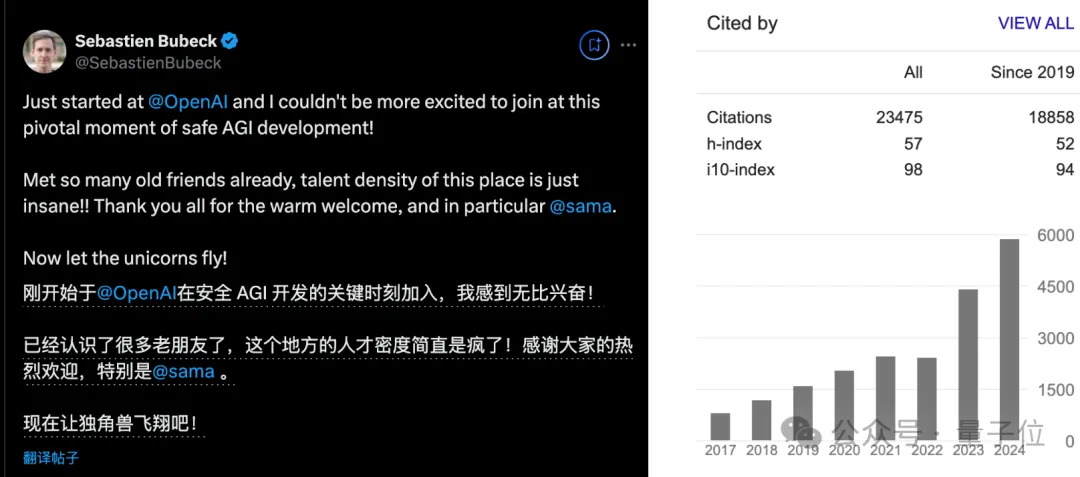

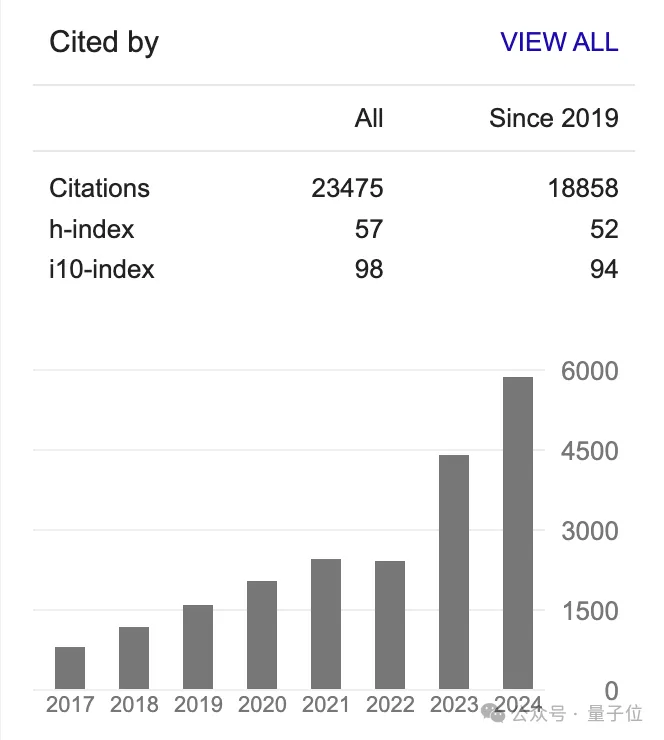

在2023年转型AGI研究之前,就凭理论研究收获上万被引,现在总被引数来到23475。

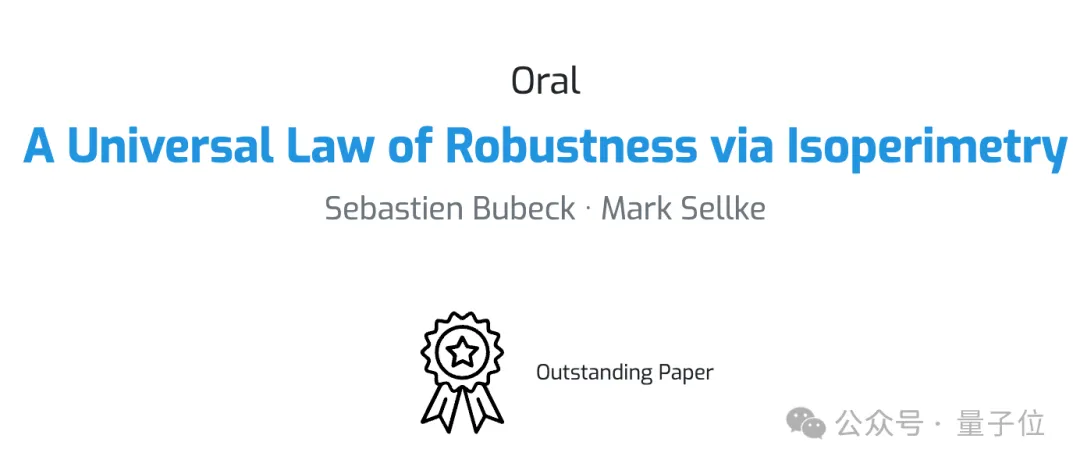

2021年他与斯坦福博士生Mark Sellke合著论文《A Universal Law of Robustness via Isoperimetry》,不仅入选NeurIPS2021杰出论文,也对微软和整个人工智能业界产生影响。

这篇论文解释了为什么实践中训练模型需要的参数比理论建议的要多得多,帮助说服微软CEO纳德拉和微软研究院院长Peter Lee等,在AI基础设施上增加数十亿美元的投资。

随后这些对数据中心和先进GPU的投资为OpenAI提供了训练和部署大模型的支柱。

Peter Lee后来表示“这是整个人工智能之旅中非常重要的时刻,不仅对于微软,而是对于所有大型科技公司”。

在转型研究AGI后,他在研究中解释了自己的新方向:AGI的物理学。

他认为Transformer和自然界一样都是复杂系统,需要用物理的方法去研究。

物理学的核心在于将一个系统进行分解,辨认出产生所观察到的行为的真正关键要素。

第一步从通过可控的实验,研究小规模“玩具模型”开始。

随后他就在微软开启了Phi系列小模型研究,控制训练数据中只有教科书级别的高质量数据和合成数据,并发表论文《Textbook is all you need》。

到现在Phi系列小模型已迭代到phi-3.5版本,在本地大模型推理工具ollma上,开源模型中受欢迎程度排第5。

One More Thing

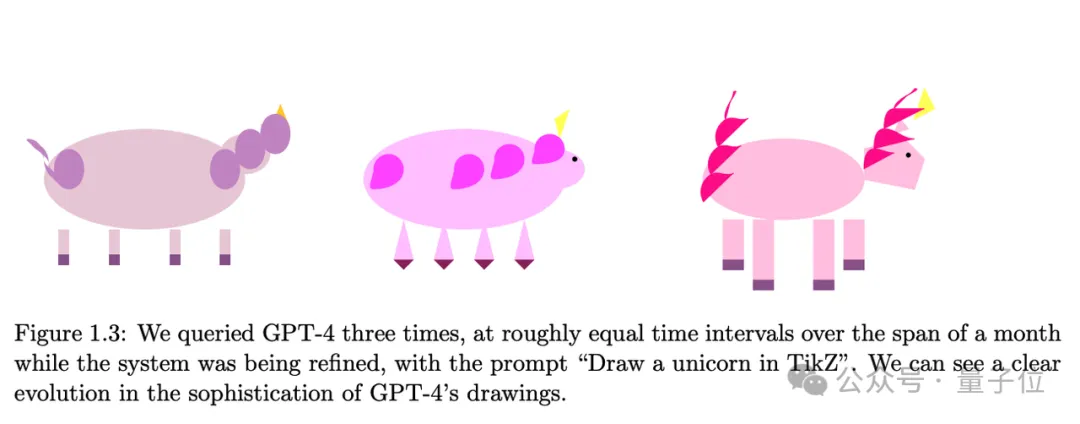

Bubeck在《AGI的火花》论文中,展示了满血版GPT-4通过代码画独角兽的能力,随训练进度增长飞快。

他认为未来这是考验大模型智力的一个有趣的检验标准,也成了这个meme的代言人。

但或许出乎他意料的是,今天的主流模型不仅能胜任画图,甚至能组团玩你画我猜了。