本文的作者主要来自于浙江大学和字节跳动。第一作者是浙江大学计算机学院的博士生叶振辉,导师为赵洲教授,主要研究方向是说话人视频合成,并在 NeurIPS、ICLR、ACL 等会议发表相关论文。共一作者是来自浙江大学计算机学院的硕士生钟添芸。

个性化精品数字人(Personalized Talking Face Generation)强调合成的数字人视频在感官上与真人具有极高的相似性(不管是说话人的外表还是神态)。目前业界主流的个性化精品数字人通常属于在单个目标人数据上从头训练的小模型,虽然这种小模型能够有效地学到说话人的外表和说话风格,这种做法存在低训练效率、低样本效率、低鲁棒性的问题。相比之下,近年来许多工作专注于单图驱动的通用数字人大模型,这些模型仅需单张图片输入即可完成数字人制作,但仍存在外表相似度较低、无法模仿目标人说话风格等问题。

为了连接个性化数字人小模型和单图驱动通用数字人大模型两个领域之间的空白,浙江大学与字节跳动提出了 MimicTalk 算法。通过(1)将单图驱动的通用 3D 数字人大模型 Real3D-Portrait (ICLR 2024) 适应到目标数字人的高效微调策略和(2)具有上下文学习能力的人脸动作生成模型,MimicTalk 可以生成相比原有方法更高质量、更具表现力的数字人视频。此外,单个数字人模型的训练时间可以被压缩到 15 分钟以内,相比现有最高效的同类方法快了 47 倍。

MimicTalk 算法被人工智能顶级会议 NeurIPS 2024 录用,目前已开放源代码和预训练权重。

- 论文标题:MimicTalk: Mimicking a personalized and expressive 3D talking face in minutes

- 论文链接:https://arxiv.org/pdf/2410.06734

- 项目主页:https://mimictalk.github.io/

- 代码链接:https://github.com/yerfor/MimicTalk

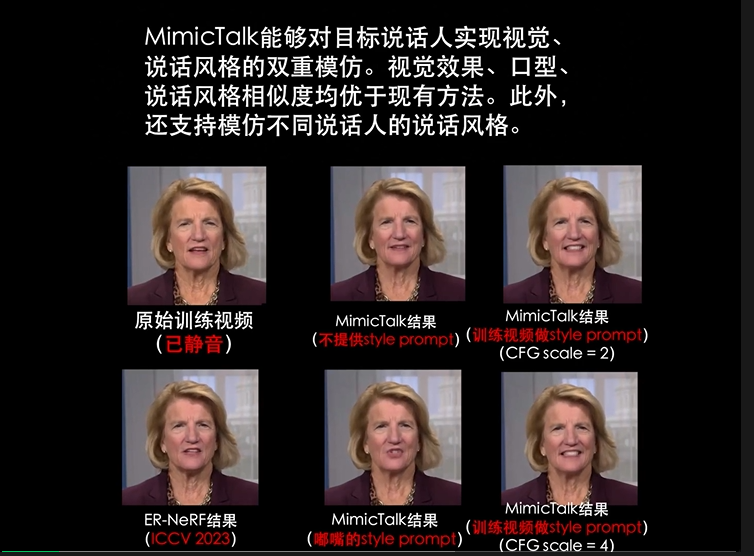

话不多说直接看效果,以下视频中的数字人模型都通过从 3D 数字人大模型进行 1000 步微调(5 分钟训练时间)得到。

模型技术原理

深悉 MimicTalk 模型的内在原理,还要回到开头提到的个性化数字人两个核心目标:(1)外表上与真人相似;(2)说话风格上与真人相似。

MimicTalk 分别使用(1)基于通用 3D 数字人大模型微调的高质量人脸渲染器和(2)一个具有上下文学习能力的人脸动作生成模型来实现它们。

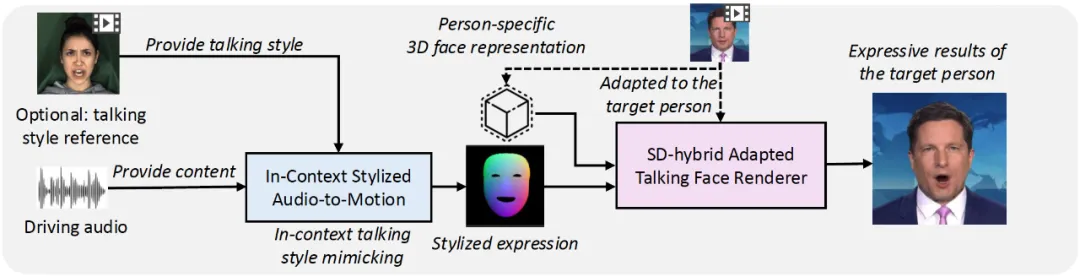

图 2. MimicTalk 包含一个高质量人脸渲染器(紫色)和一个能够模仿说话风格的动作生成器(蓝色)

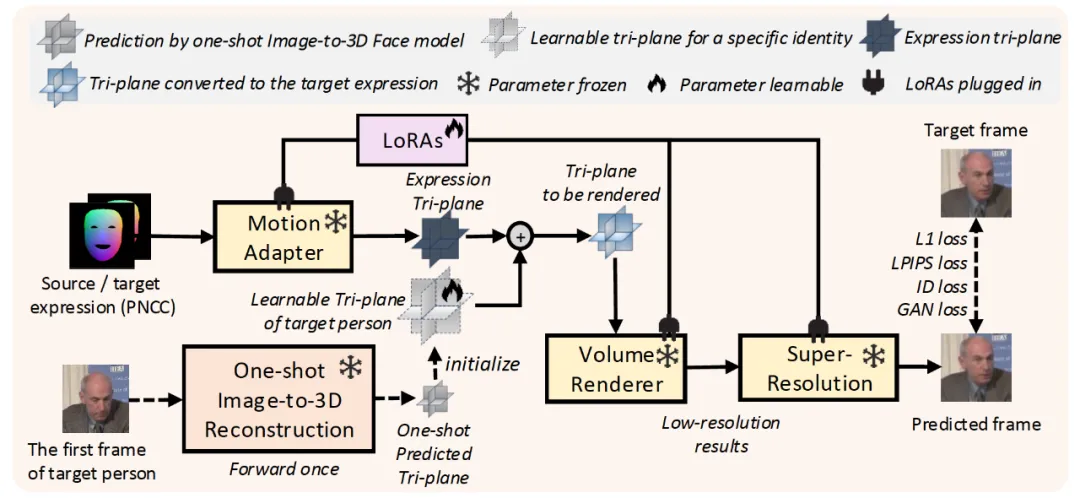

对于第一个问题,传统方法通常从头训练一个小规模的 NeRF 模型来记忆目标人的外表特征,但这种做法通常导致较长的训练时间(数个小时)、较高的数据量要求(数分钟)、较低的鲁棒性(对极端条件无法输出正确的结果)。针对这一问题,团队首次提出采用一个单图驱动的通用 3D 数字人大模型作为基础模型,并提出了一个「动静结合」的高效率微调方案。

他们发现通用大模型的输出通常存在牙齿、头发等静态细节不足,且肌肉运动等动态细节不真实的问题。因此针对静态细节和动态细节的特性设计了动静结合的微调方案。

具体来说,研究者发现现有的 3D 数字人通用模型通常会将 3D 人脸的静态细节储存在一个 3D 人脸表征(tri-plane)中作为模型的输入,而 3D 人脸的动态细节,则通过模型内部的参数进行储存。因此,MimicTalk 在个性化数字人渲染器的训练过程中,不仅会更新储存静态细节的 3D 人脸表征,还通过 LoRA 技术对通用模型的参数进行了可拆卸的高效微调。

图 2. 将通用 3D 数字人大模型适应到单个目标人,动静结合的高效微调方案

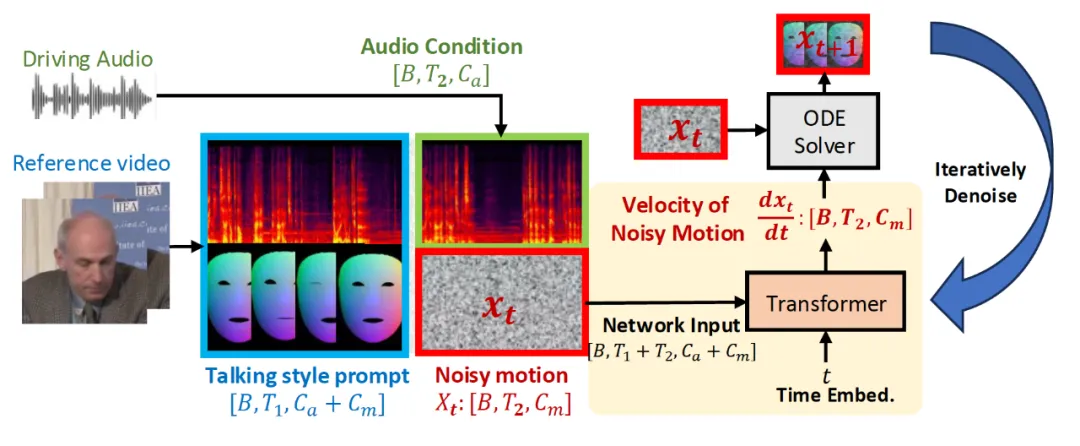

在实现图像上与真人的高度相似后,下一个问题是如何生成与真人说话风格相似的面部动作。传统方法通常会额外训练一个说话风格编码器,但是由于模型内部信息瓶颈的存在通常会性能损失。与之相比,受启发大语言模型、语音合成等领域的启发,MimicTalk 首次提出从上下文中学习目标人说话风格的训练范式。在训练阶段,Flow Matching 模型通过语音轨道和部分未被遮挡的人脸动作轨道的信息,对被遮挡的人脸动作进行去噪。在推理阶段,给定任意音频 - 视频对作为说话人风格提示,模型都能生成模仿该说话风格的人脸动作。

图 3. 能在上下文中学习目标人说话风格的人脸动作生成模型

模型的应用前景

总体来看,MimicTalk 模型首次实现了高效率的个性化精品数字人视频合成。可以预见的是,随着技术的不断迭代、普及,在智能助手、虚拟现实、视频会议等多个应用场景中都将会出现虚拟人的身影。而借助 MimicTalk 算法,个性化高质量数字人的训练成本被「打了下去」,人们将会享受到更真实、更舒适的交互体验。随着各个领域的大模型技术的兴起,拥抱大模型的超强能力并与垂直领域中的特殊场景、需求相结合,已经成为了技术演进的大势所趋。而 MimicTalk 模型为后续基于数字人通用模型的个性化数字人算法研究工作提供了参考。但现阶段 MimicTalk 也并不是完美无缺的,由于依赖通用大模型的结果作为初始化,对基础模型的质量有较高的要求,此外从推理效率上看与现有小模型还存在一定差距。

总而言之,过去几年,随着个性化数字人技术的不断进步,口型精度、图像质量已然不断提高;而 MimicTalk 模型的提出,进一步解决了制约个性化数字人的训练成本问题。让我们一同期待虚拟人技术的加速发展,用户也将获得更加极致的视觉体验和生活便利。