LLM居然长「脑子」了?

就在刚刚,MIT传奇大牛Max Tegmark团队的新作,再次炸翻AI圈。

论文地址:https://arxiv.org/abs/2410.19750

他们发现,LLM学习的概念中,居然显示出令人惊讶的几何结构——

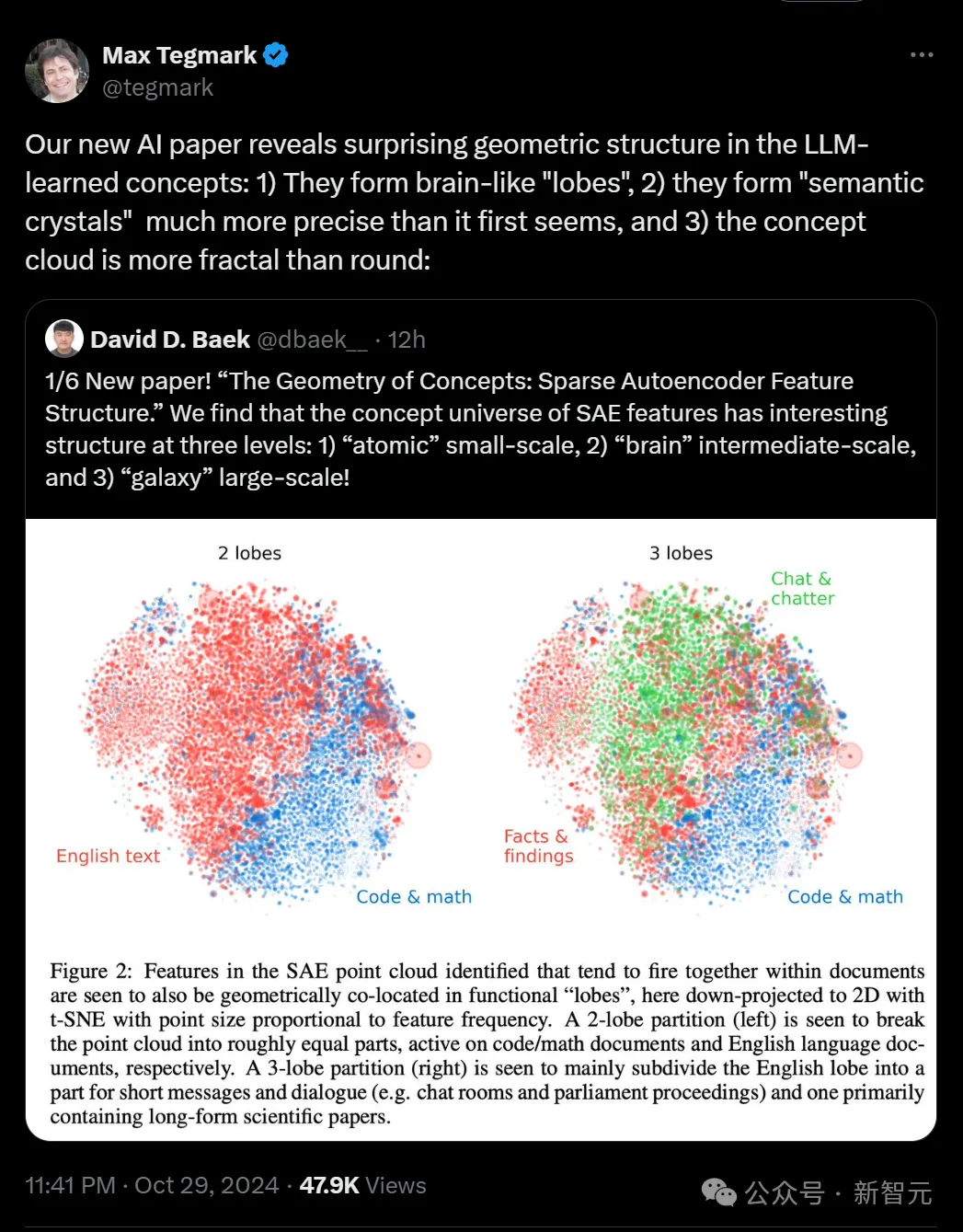

首先,它们形成一种类似人类大脑的「脑叶」;其次,它们形成了一种「语义晶体」,比初看起来更精确;并且,LLM的概念云更具分形特征,而非圆形。

具体而言,这篇论文探讨了LLM中稀疏自编码器(SAE)的特征向量表示的。

Max Tegmark团队的研究结果表明,SAE特征所代表的概念宇宙在多个空间尺度上展现出有趣的结构,从语义关系的原子层面到整个特征空间的大规模组织。

这就为我们理解LLM的内部表征和处理机制,提供了全新的见解。

总之,这个研究实在太过震撼!网友直言:如果LLM和人脑相似,这实在是给人一种不好的预感……

所以,美丽的自然法则并不独属于人类,硅基也从属于这一法则。

这个发现证明了:数学才是一切的基础,而非人类构造。

LLM的三个层面:原子,大脑和星系

团队发现,SAE特征的概念宇宙在三个层面上都具有有趣的结构:

- 小尺度「原子」

- 中尺度「大脑」

- 大尺度「星系」

原子级的微观结构,包含面为平行四边形或梯形的「晶体」,这是对经典案例的推广(比如「男人-女人-国王-王后」的关系)。

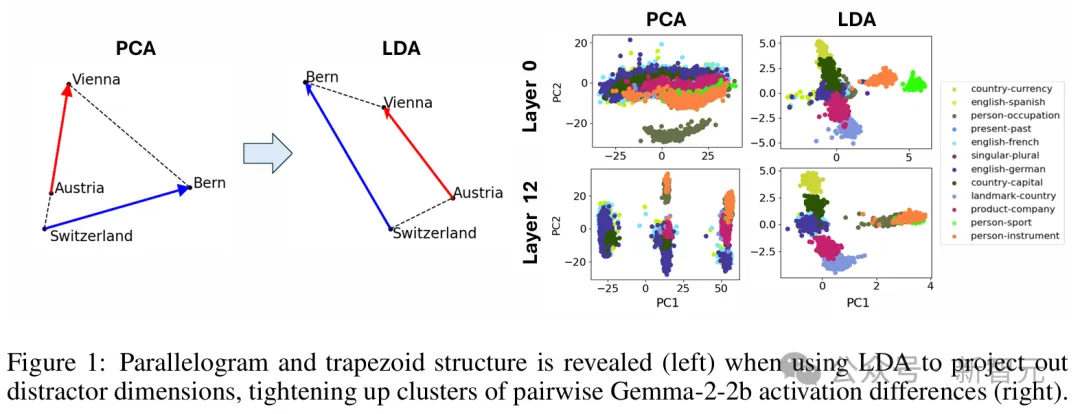

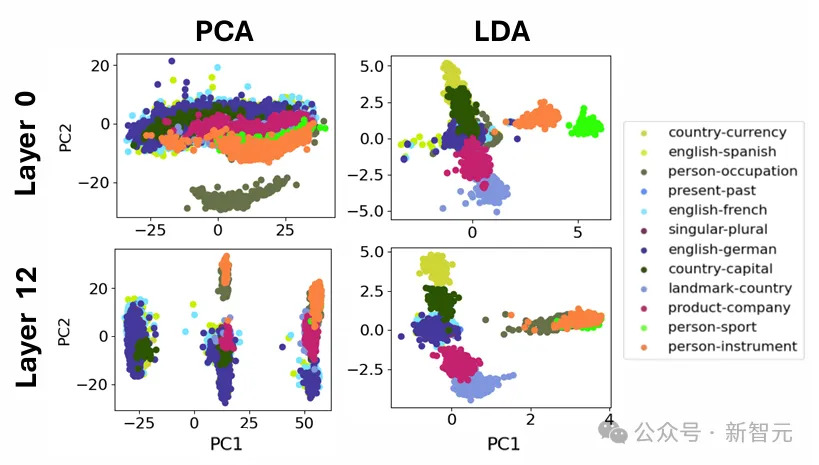

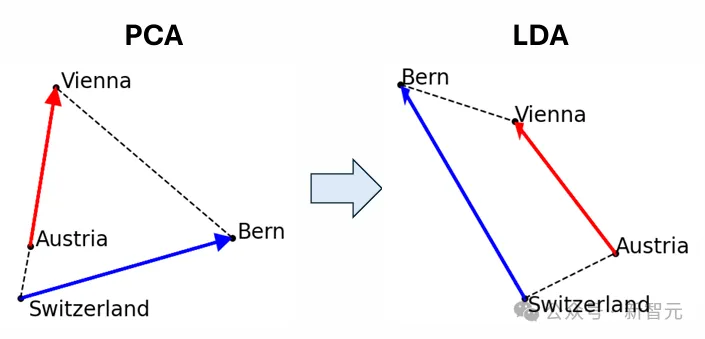

他们发现,当使用线性判别分析(LDA)高效地投影出诸如词长等全局干扰方向时,这些平行四边形和相关函数向量的质量会显著提升。

而类似「大脑」的中间尺度结构,则展现出了明显的空间模块化特征,团队将其描述为空间集群和共现集群之间的对齐。

比如,数学和代码特征形成了一个「脑叶」,跟神经功能磁共振图像中观察到的人类大脑功能分区相似。

团队运用多个指标,对这些功能区的空间局部性进行了量化分析,发现在足够粗略的尺度上,共同出现的特征簇在空间上的聚集程度远超过特征几何随机分布情况下的预期值。

而在「星系」的大尺度结构上,特征点云并非呈各向同性(各个方向性质相同),而是表现出特征值幂律分布,中间层的斜率最抖。

而聚类熵也在中间层周围达到峰值!

看完这个研究,有网友给出了这样的评价——

「如果这项研究出自Max Tegmark之外的任何人,我都会觉得他是疯子。但Tegmark是我们这个时代最优秀的科学家之一。当我说意识是一种数学模式、一种物质状态时,我引用的是他。」

LLM学习概念中,惊人的三层几何结构

去年,AI圈在理解LLM如何工作上取得了突破,稀疏自编码器在其激活空间中,发现了大量可以解释为概念的点(「特征」)。

稀疏自编码器作为在无监督情况下发现可解释语言模型特征的方法,受到了很多关注,而检查SAE特征结构的工作则较少。

这类SAE点云最近已经公开,MIT团队认为,是时候研究它们在不同尺度上的结构了。

「原子」尺度:晶体结构

在SAE特征的点云中,研究者试图寻找一种称之为「晶体结构」的东西。

这是指反映概念之间语义关系的几何结构,一个经典的例子就是(a, b, c, d)=(男人,女人,国王,女王)。

它们形成了一个近似的平行四边形,其中b−a≈d−c。

这可以解释为,两个函数向量b−a和c−a分别将男性实体变为女性,将实体变为皇室。

研究者还搜索了只有一对平行边b−a ∝ d−c的梯形(对应于仅一个函数向量)。

图1(右)即为这样的一个例子:(a, b, c, d)=(奥地利,维也纳,瑞士,伯尔尼),其中函数向量可以解释为将国家映射到其首都。

研究者通过计算所有成对的差向量并对其进行聚类来搜索晶体,这应该会产生与每个函数向量相对应的一个簇。

簇中的任何一对差向量,应该构成梯形或平行四边形,这取决于在聚类之前差向量是否被归一化(或者可以等效于,是否通过欧几里得距离或余弦相似度,来量化了两个差向量之间的相似性)。

最初搜索SAE晶体时,研究者发现的大多是噪声。

为什么会出现这种情况?

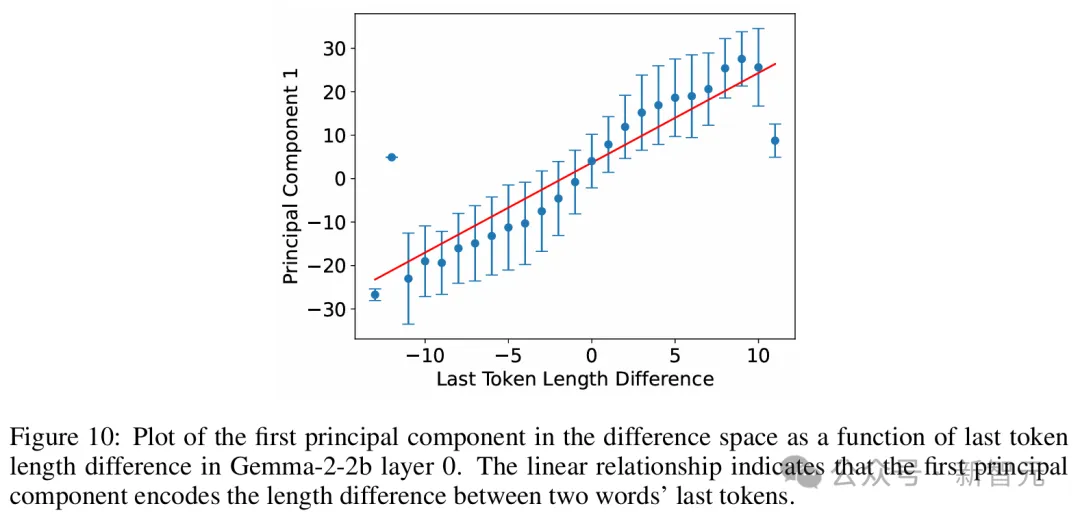

为了调查原因,研究者将注意力集中在了在第0层(token嵌入)和第1层,在这些层中,许多SAE特征与单个词相对应。

然后,他们研究了Gemma2 2B模型中来自数据集的残差流激活,这些激活对应于先前报告的词->词函数向量,于是搞明白了这个问题。

如图1所示,晶体四重向量通常远非平行四边形或梯形。

这与多篇论文指出的情况一致,即(男,女,国王,王后)并不是一个准确的平行四边形。

之所以会有这种现象,是因为存在一种所谓的「干扰特征」。

比如,图1(右)中的横轴主要对应于单词长度。

这在语义上是不相关的,并且对梯形(左)造成了严重破坏,因为「Switzerland」要比其他的词长很多。

为了消除这些语义上无关的干扰向量,研究者希望将数据投影到与这些干扰向量正交的低维子空间上。

对于数据集,他们使用了线性判别分析(LDA)来实现这一点。LDA将数据投影到信号噪声比特征模式上,其中「信号」和「噪声」分别定义为簇间变化和簇内变化的协方差矩阵。

这种仿佛显著改善了簇和梯形/平行四边形的质量,突显出干扰特征可能掩盖了现有的晶体结构。

「大脑」尺度:中等尺度的模块结构

接下来,我们到了论文最精彩的地方。

在这一部分,研究者们缩小了视角,试图寻找更大规模的结构。

他们研究了功能相似的SAE特征组(这些特征组倾向于一起激活),想看看它们是否在几何上也是相似的,是否会在激活空间中形成「脑叶」。

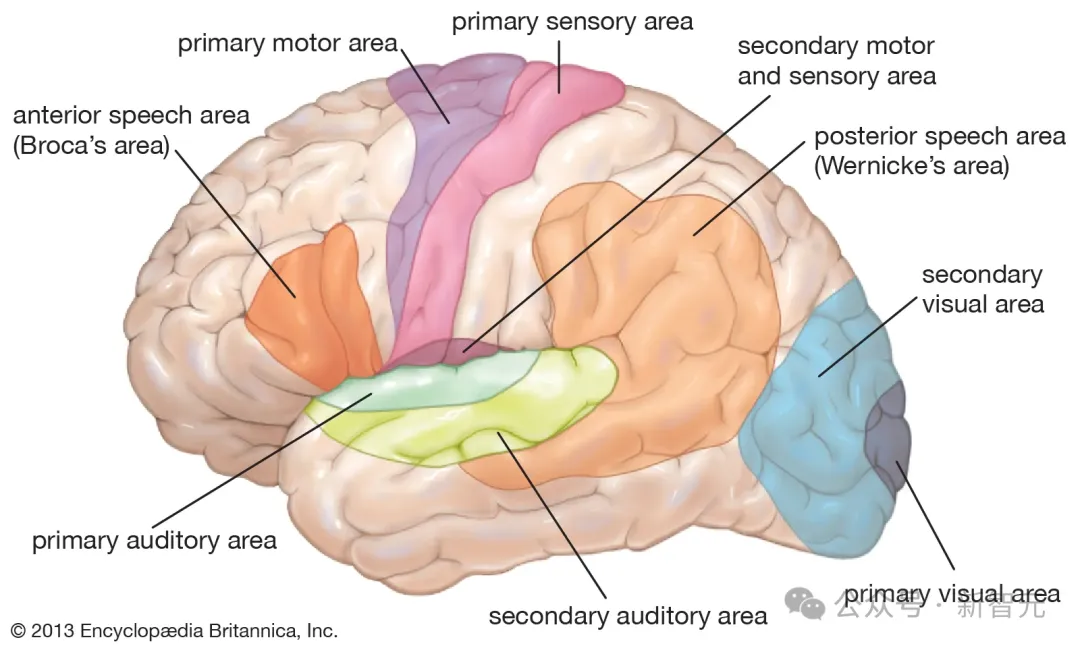

在动物的大脑中,这种功能组就是众所周知的神经元所在的三维空间中的簇。

例如,布罗卡区涉及语言生成,听觉皮层处理声音,杏仁核主要处理情绪。

研究者非常好奇,是否可以在SAE特征空间中找到类似的功能模块呢?

他们测试了多种方法,来自动发现这类功能性「脑叶」,并量化它们是否是空间模块化的。

他们将脑叶分区定义为点云的一个k子集的划分,这种分区的计算不使用位置信息,相反,他们是基于它们在功能上的关联性来识别这些脑叶分区的。

具体来说,这些脑叶在同一文档内倾向于一起激活。

为了自动识别功能脑叶,研究者首先计算了SAE特征共现的直方图。

他们使用Gemma2 2B模型处理了来自The Pile的文档。

研究者发现,在第12层的残差流SAE具有16k个特征,平均L0为41。

他们记录了这个SAE被激活的特征(如果某特征的隐藏激活值> 1,则将其视为被激活)。

如果两个特征在同一个256个token的块内同时激活,则它们被视为共现。

此长度提供了一种粗略的「时间分辨率」,使他们能够发现倾向于在同一文档中共同激活的token,而不仅限于同一token。

研究者使用了最大长度为1024的上下文,并且每个文档只使用一个这样的上下文,这就使他们在The Pile的每个文档中最多有4个块(和直方图更新)。

他们在5万个文档中计算了直方图。

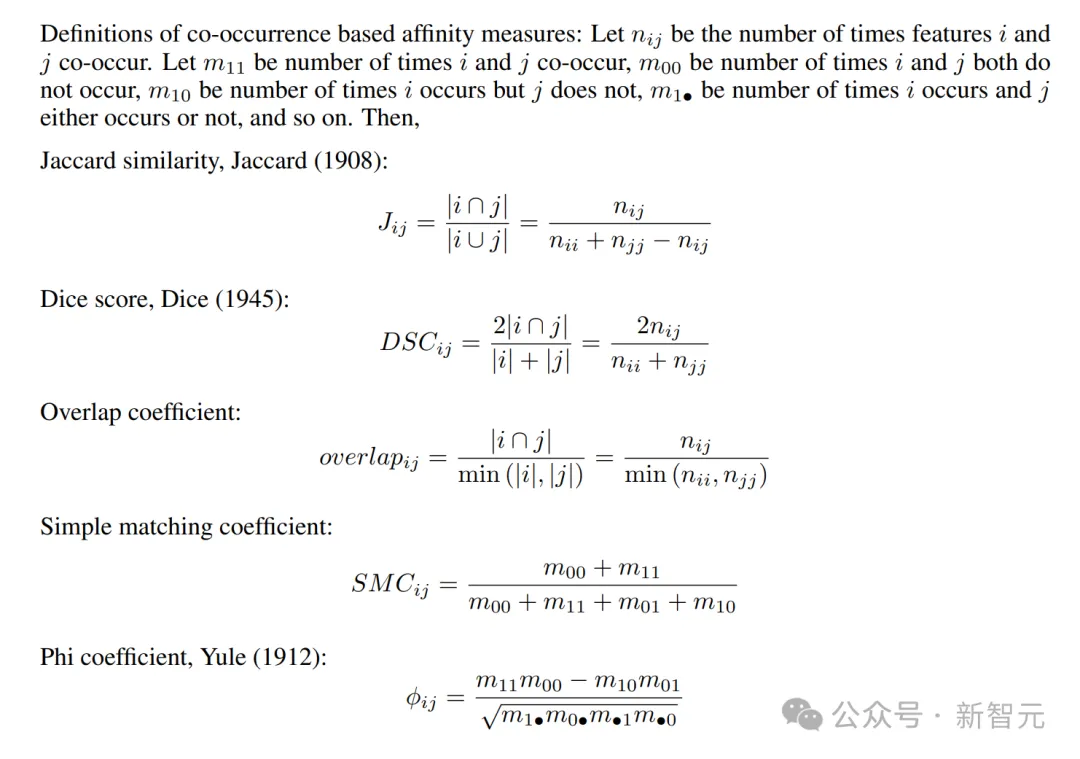

基于此直方图,他们根据SAE特征的共现统计,计算了每对特征之间的亲和分数,并对得到的亲和矩阵进行了谱聚类。

研究者尝试了以下基于共现的亲和度计算方法:简单匹配系数、Jaccard相似度、Dice系数、重叠系数和Phi系数,这些都可以仅通过共现直方图计算得出。

研究者们原本假设,功能上相似的点(即常见的共现SAE特征)在激活空间中应该是均匀分布的,不会表现出空间模块性。

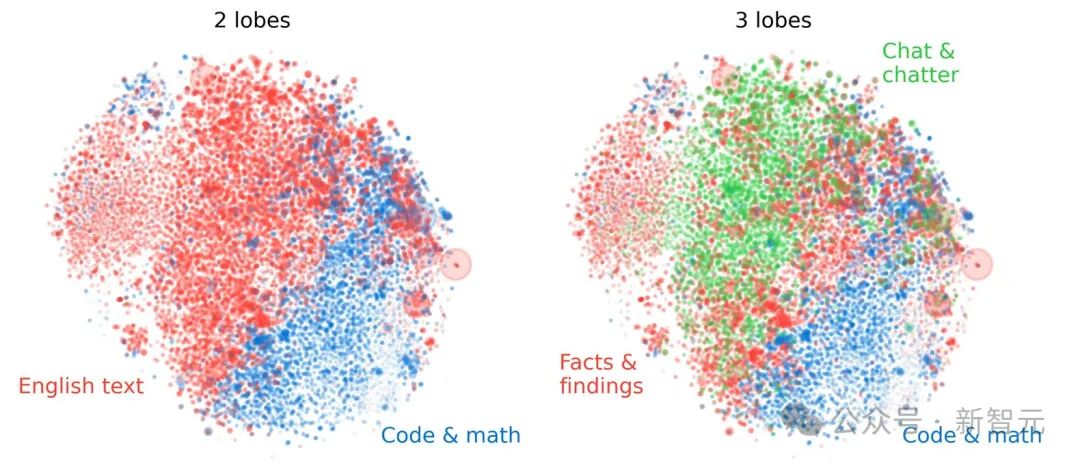

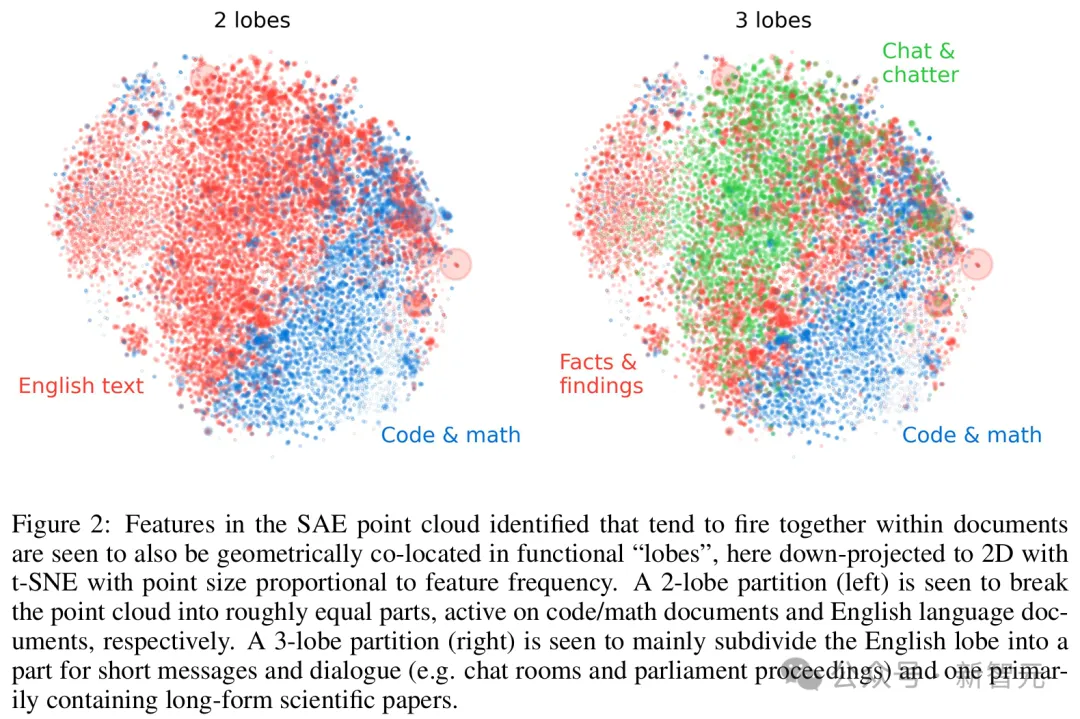

然而,出乎他们意料,图2显示出:脑叶在视觉上呈现出相当集中的空间分布!

在SAE点云中识别出的特征倾向于在文档中一起激活,同时也在几何上共同定位于功能「脑叶」中,左侧的2脑叶划分将点云大致分为两部分,分别在代码/数学文档和英文文档上激活。右侧的3脑叶划分主要将英文脑叶细分为一个包含简短消息和对话的部分,以及一个主要包含长篇科学论文的部分

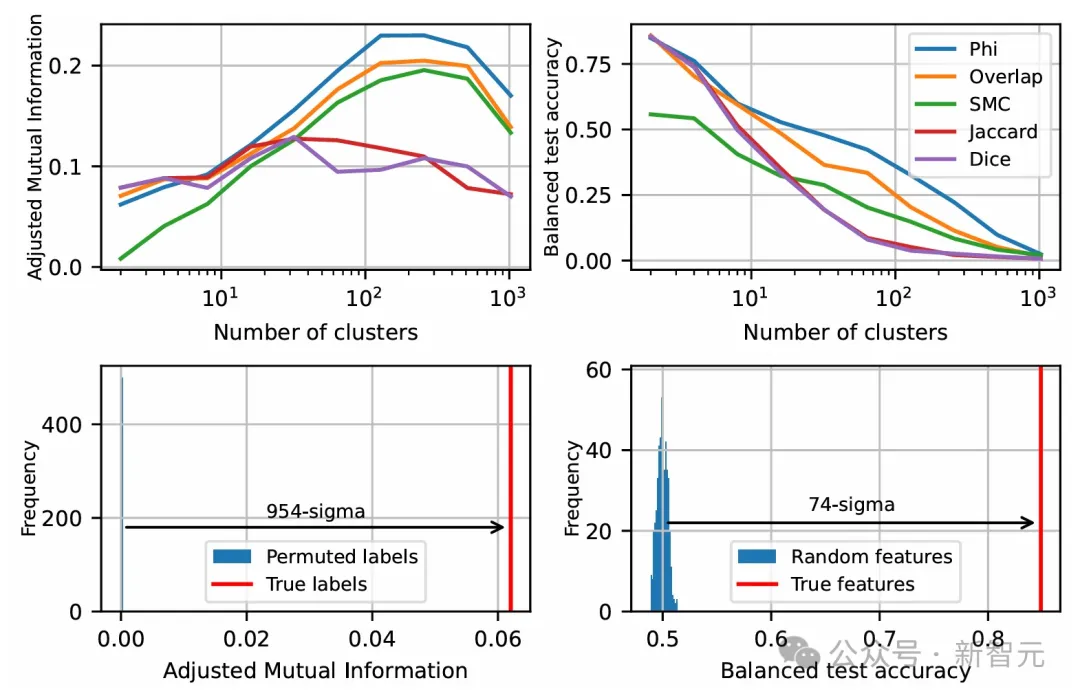

为了量化其统计显著性,研究者使用了两种方法来排除原假设:

1. 虽然可以基于特征是否同时出现进行聚类,但也可以基于SAE特征解码向量的余弦相似度来进行谱聚类。

他们首先使用了余弦相似度对SAE特征进行聚类,然后使用共现对特征进行聚类,之后计算这两组标签之间的相互信息。

在某种意义上,这直接衡量了通过了解功能结构可以获得多少关于几何结构的信息。

2. 另一个方法就是训练模型,通过几何信息预测特征所属的功能脑叶。

为此,研究者将基于共现聚类得到的脑叶标签集作为目标,使用逻辑回归模型直接根据点的位置预测这些标签,并使用80-20的训练-测试集划分,报告该分类器的平衡测试准确率。

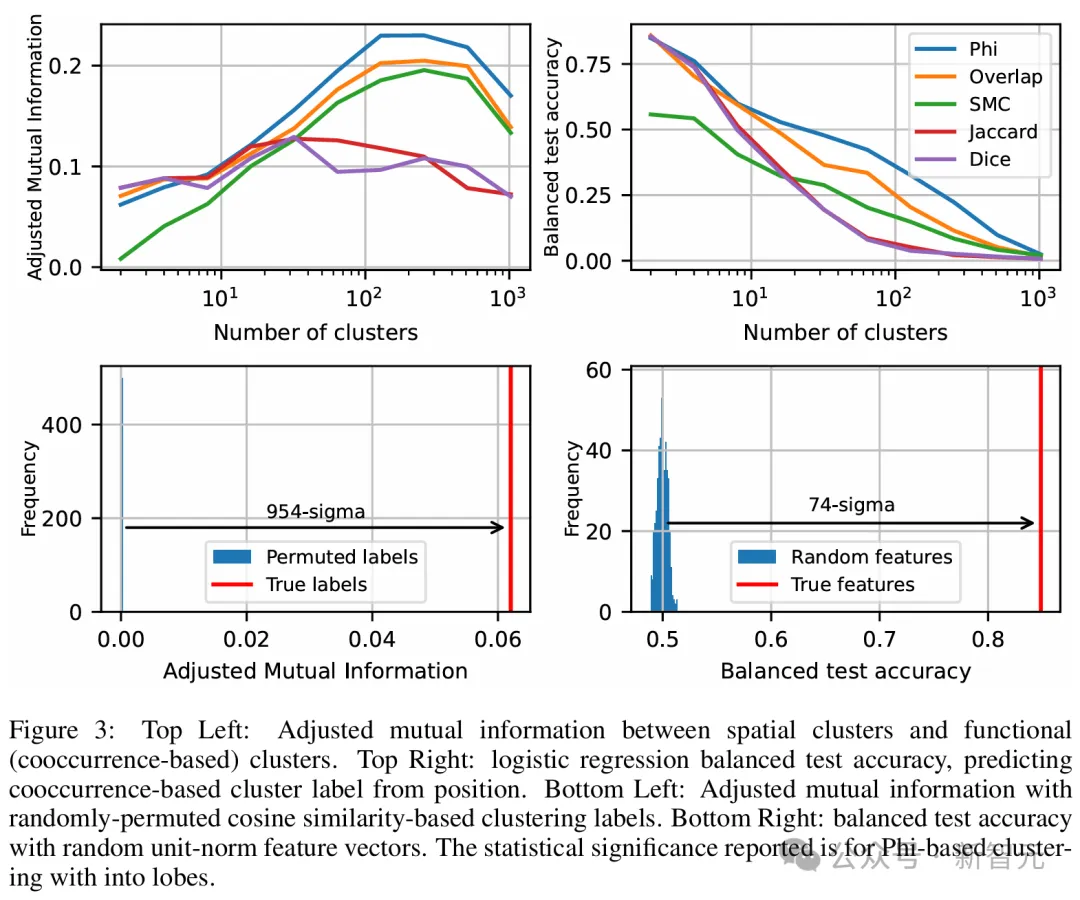

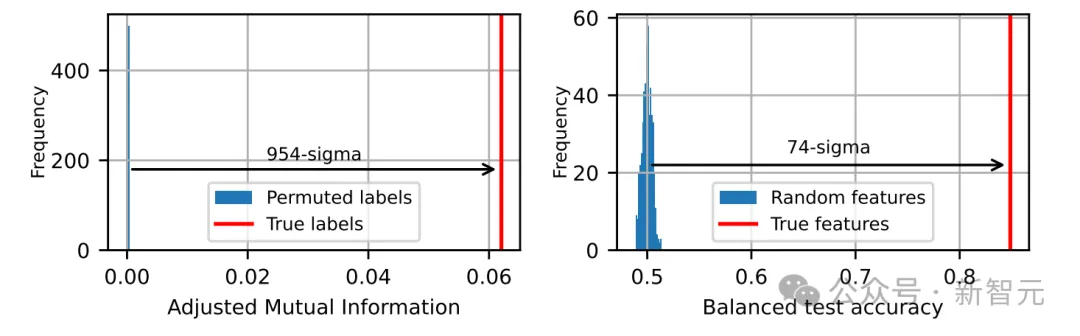

左上:空间聚类与功能聚类之间的调整互信息。右上:逻辑回归的平衡测试准确率,用位置预测基于共现的聚类标签。左下:随机置换余弦相似度聚类标签后的调整互信息。右下:随机单位范数特征向量的平衡测试准确率。报告的统计显著性基于Phi系数的脑叶聚类

图3显示,对于两种度量方法,Phi系数效果最佳,提供了功能脑叶与特征几何形状之间的最佳对应关系。

为了证明其统计显著性,研究者随机打乱了基于余弦相似度聚类的簇标签,并测量了调整后的相互信息。

同时,他们使用随机高斯分布,对SAE特征解码方向重新初始化并归一化,然后训练逻辑回归模型从这些特征方向预测功能脑叶。

图3(下)显示,两项测试都以极高的显著性排除了零假设,分别达到了954和74个标准差,这就明确表明:研究者所观察到的脑叶是真实的,而非统计偶然!

为了评估每个脑叶的专长,他们将The Pile数据集中的1万份文档输入了Gemma2 2B模型,并再次记录了第12层中每256个token块内触发的SAE特征。

对于每个token块,他们都记录了具有最高特征触发比例的脑叶。

The Pile中的每个文档都带有名称,指定该文档属于语料库的哪个子集。对于每种文档类型,针对该类型文档中每个256 token块,他们都会记录哪一个脑叶具有最高的SAE特征触发比例。

跨越数千份文档后,可以查看每种文档类型中,哪个脑叶的激活比例最高的直方图。

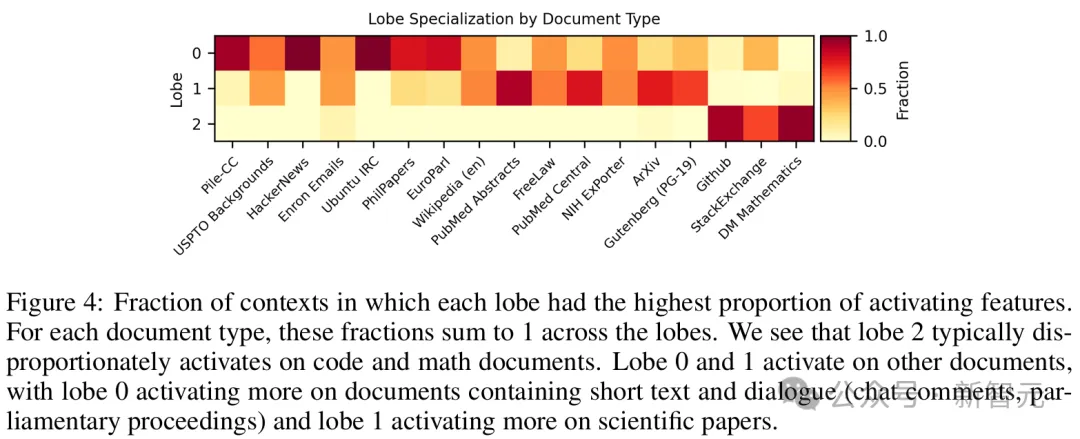

在图4中,研究者展示了使用Phi系数作为共现度量计算的三个脑叶结果,这构成了图2中脑叶标记的基础。

每个脑叶都具有最高比例的激活特征上下文分数。脑叶2通常在代码和数学文档上不成比例地被激活,脑叶0在包含文本(聊天记录、会议记录)的文档上激活更多,脑叶1在科学论文上激活更多

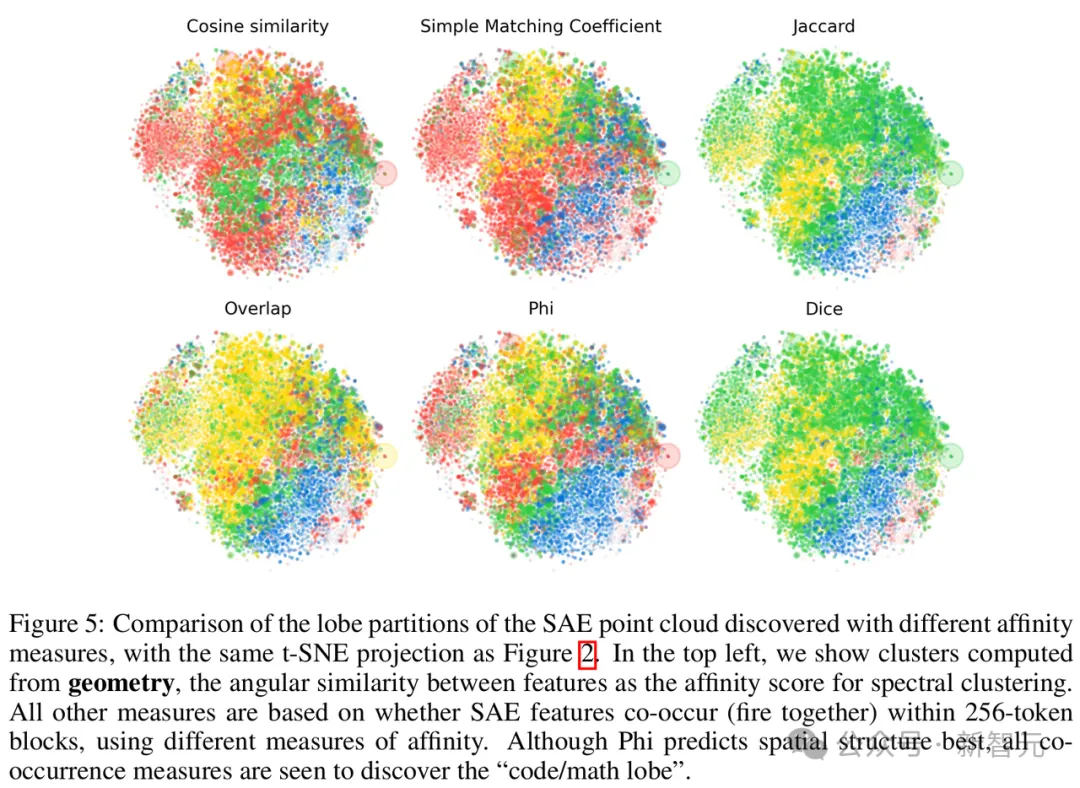

图5对比了五种不同共现度量的效果。尽管Phi系数最佳,但五种度量方法均能够识别出「代码/数学脑叶」。

「星系」尺度:「大规模」点云结构

最后一种,让我们进一步拉远视角,看看大模型在「星系」尺度结构中,点云的样子。

主要是研究其整体形状、聚类,类似于天文学家研究硬核系形状和子结构的方式。

接下来,研究人员试图去排除一个简单的零假设(null hypothesis):点云只是从各向同性多元高斯分布中采样的。

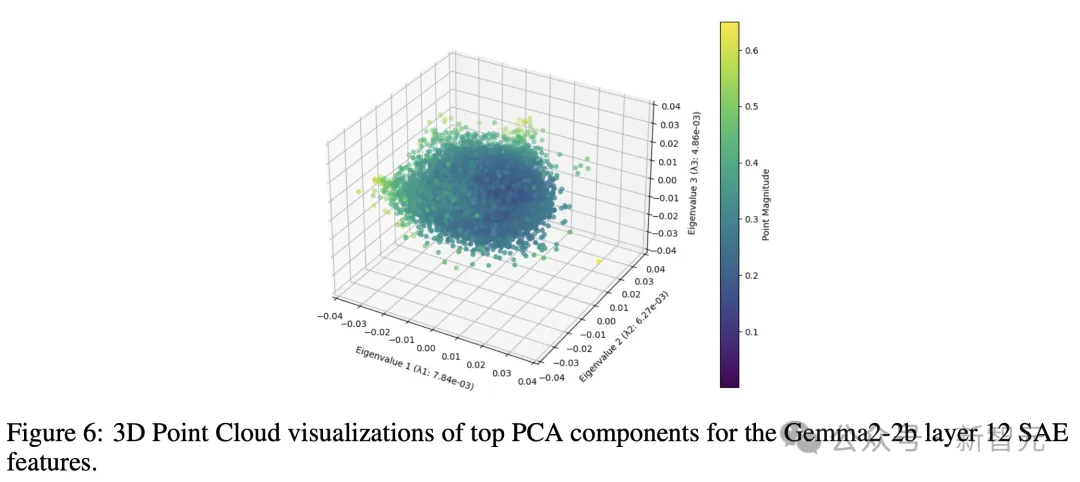

如图6直观地表明,即使在其前三个主要成分中,点云分布也不完全是圆形的,某些主轴略宽于其他轴,类似人脑的形状。

形状分析

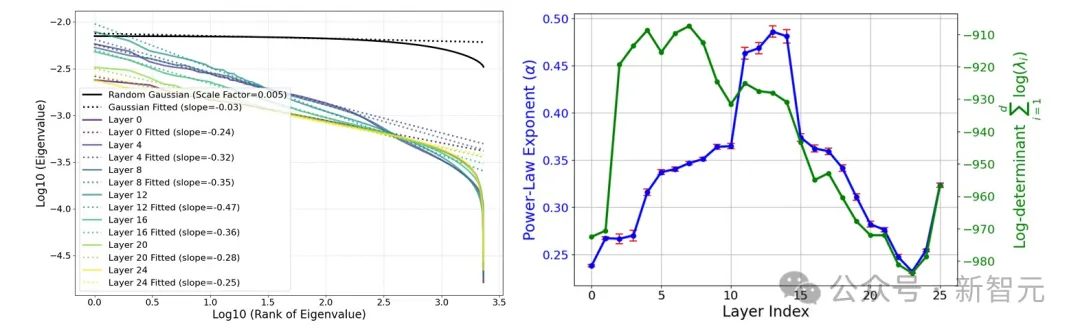

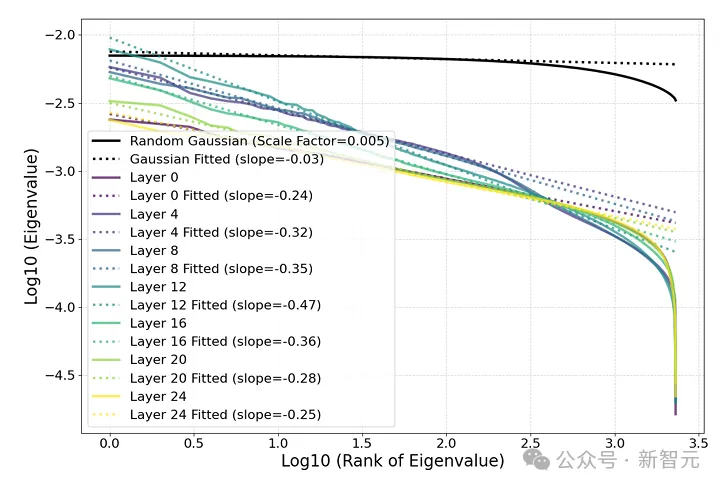

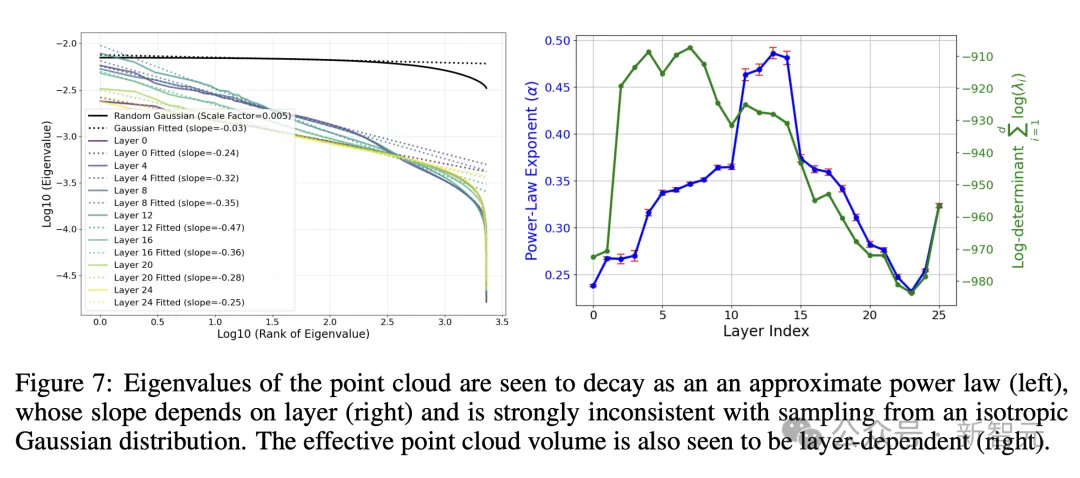

图7(左)通过点云协方差矩阵的特征值排序,来量化这一现象。

它揭示出,这些特征值并非是恒定的,而是呈现出幂律衰减。

为了检验这个令人惊讶的幂律是否显著,图中将其与从各向同性高斯分布中抽取的点云的相应特征值谱进行比较。

结果显示,后者更加平摊,并且与分析预测一致:

从多元高斯分布中抽取的N个随机向量的协方差矩阵遵循Wishart分布

这一点,已经在随机矩阵理论中,得到了充分的研究。

由于,最小特征值的急剧下降是由有限数据引起的,并在N趋于无穷大时消失,研究人员在后续分析中,将点云降维到其100个主成分。

换句话说,点云的形状像一个「分形黄瓜」,其在连续维度上的宽度像幂律一样下降。

研究人员发现,与SAE特征相比,激活值的幂律特征明显较弱。未来,进一步研究其成因,也将是一个有趣的方向。

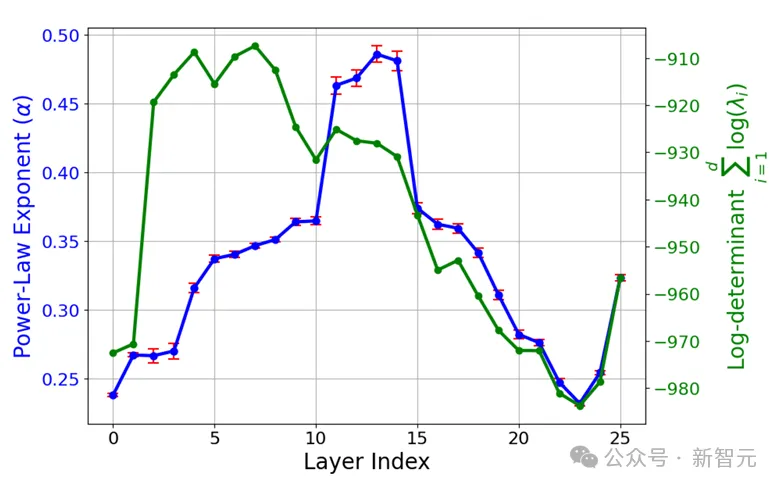

图7(右)显示了,上述幂律的斜率如何随LLM层数变化,这是通过对100个最大特征进行线性回归计算得到的。

研究人员观察到一个清晰的模式:

中间层具有最陡的幂律斜率(第12层的斜率为-0.47),而早期和后期层(如第0层和第24层)的斜率较为平缓(分别为-0.24和-0.25)。

这可能暗示了,中间层充当了一个瓶颈,将信息压缩到更少的主成分中,或许是为了更有效表示高层抽象概念。

图7(右)还在对数尺度上,展示了有效云体积(协方差矩阵的行列式)如何随层数变化。

聚类分析

一般来说,星系或微观粒子的聚类,通常通过幂谱或相关函数来量化。

对于研究中高维数据来说,这种量化变得很复杂。

因为底层密度会随着半径变化,而对于高维高斯分布,密度强烈集中在相对较薄的球壳周围。

由此,研究人员选择通过估计点云,假定采样的分布的「熵」来量化聚类。

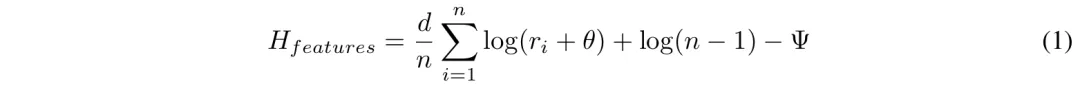

他们使用k-NN方法来估计熵H,计算如下:

其中ri是点i到第k个最近邻的距离,d是点云的维度;n是点的数量;

常数Ψ是k-NN估计中的digamma项。作为基线,高斯熵代表了给定协方差矩阵的最大可能熵。

对于具有相同协方差矩阵的高斯分布,熵的计算方法如下:

其中λi是协方差矩阵的特征值。

研究人员定义聚类熵,或「负熵」,为Hgauss − H,即熵比其最大允许值低多少。

图8显示了不同层的估计聚类熵。可以看到,SAE点云在中间层强烈聚集。

在未来研究中,研究这些变化是否主要取决于不同层中晶体或叶状结构的显著性,或者是否有完全不同的起源,将会是一个有趣的方向。

破解LLM运作机制黑箱,人类再近一步

总而言之,MIT团队这项最新研究中,揭示了SAE点云概念空间具有三层有趣的结构:

原子尺度的晶体结构;大脑尺度的模块结构;星系尺度的点云结构。

正如网友所言,亲眼目睹了人类硅基孩子在我面前成长,既令人敬畏又令人恐惧。

Max Tegmark出品,必属精品。

此前就有人发现,仅在下一个token预测上训练的序列模型中,存在线性表征的类似证据。

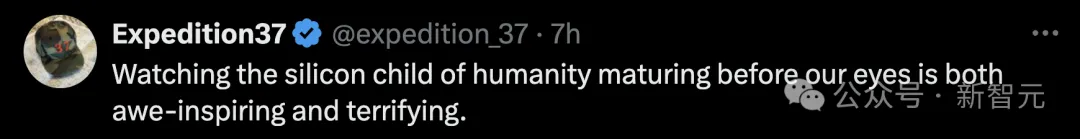

23年2月,哈佛、MIT的研究人员发表了一项新研究Othello-GPT,在简单的棋盘游戏中验证了内部表征的有效性。

在没有任何奥赛罗规则先验知识的情况下,研究人员发现模型能够以非常高的准确率预测出合法的移动操作,捕捉棋盘的状态。他们认为语言模型的内部确实建立了一个世界模型,而不只是单纯的记忆或是统计,不过其能力来源还不清楚。

吴恩达对该研究表示了高度认可。

受此启发,Max Tegmark团队发现,Llama-2-70B竟然能够描绘出研究人员真实世界的文字地图,还能预测每个地方真实的纬度和经度;而在时间表征上,模型成功预测了名人的死亡年份、歌曲电影书籍的发布日期和新闻的出版日期。

总之,这项研究在LLM中发现了「经度神经元」,在学界引起了巨大反响。

如今,Tegmark团队又再进一步,帮我们从更微观的角度剖析LLM的大脑。人类离解释LLM运作机制的黑箱,又近了一步。