写在前面&笔者的个人理解

以视觉为中心的自动驾驶系统由于能够使用相机等部署经济型传感器实现感知算法模型性能的提升而受到了来自工业界和学术界的广泛关注。以视觉输入的感知算法通过由2D图像信息来重建3D空间信息实现了3D目标的检测任务。这种由2D空间到3D空间的信息转换对于使自动驾驶车辆能够了解周围环境、检测目标并安全导航至关重要。先前的来自学术界和工业界的相关研究通过利用 BEV空间表示来处理 2D到3D空间的信息转换,实现了卓越的3D目标感知能力。最近,许多基于视觉的3D栅格占用预测算法进一步提高了感知模块对于动态和混乱驾驶场景的理解,突破了研究领域的界限。因此,基于视觉的感知系统已成为可扩展自动驾驶的主要解决方案之一。

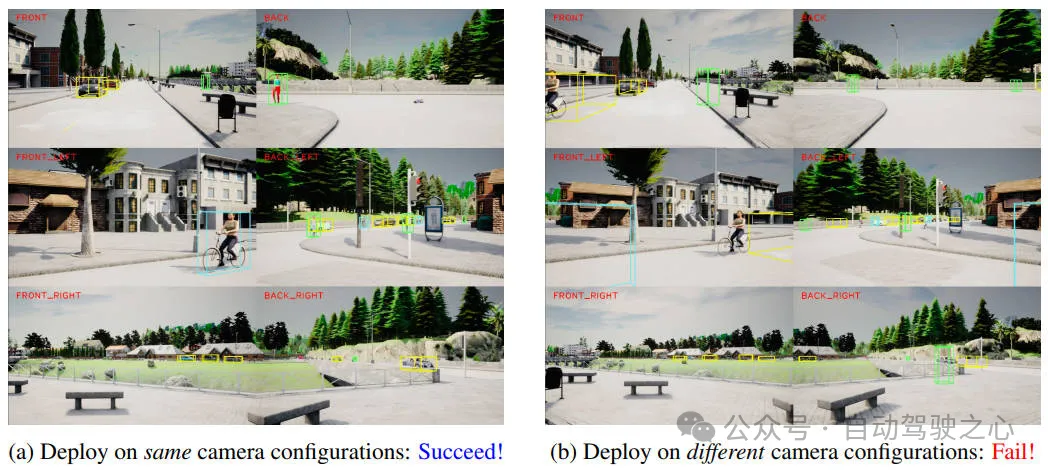

尽管基于视觉的自动驾驶技术取得了令人兴奋的进展和非常不错的成绩,但目前仍然存在一个关键的限制:这些基于视觉的感知算法模型对于相机的配置变化比较敏感,体现在相机的内参和外参两个方面。自动驾驶模型通常依赖于经过良好校准的相机传感器设置,即使不同车辆或平台的摄像头参数出现了轻微偏差,也会显著降低模型的感知性能,如下图所示。

在相同和不同配置上部署感知模型的性能结果比较

在相同和不同配置上部署感知模型的性能结果比较

由于算法模型缺乏对传感器变化的鲁棒性,因此在没有大量重新训练或手动调整的情况下,已经训练好的算法模型很难在不同车辆平台之间实现很好的泛化和鲁棒性。因此,当遇到相机配置发生变化时,就需要为每辆车重新训练一个单独的新感知算法模型,这就会消耗大量的计算资源。因此,实现跨摄像头配置的泛化对于以视觉为中心的自动驾驶的实际部署至关重要。

考虑到上述提到的相关问题,我们提出了UniDrive算法模型,用于解决在多摄像头配置下提高感知算法模型的泛化性。此外,我们提出的算法模型可作为现有 3D 目标感知方法的即插即用模块,用于提高感知算法模型对其相机参数变化的鲁棒性。我们在CARLA框架中以不同的相机配置下来训练和验证我们提出的算法模型,相关的实验结果证明我们提出的算法模型在不同的相机配置下,可以显著降低算法模型感知性能的下降,同时保持跨不同传感器设置的适应性。

文章链接:https://arxiv.org/pdf/2410.13864

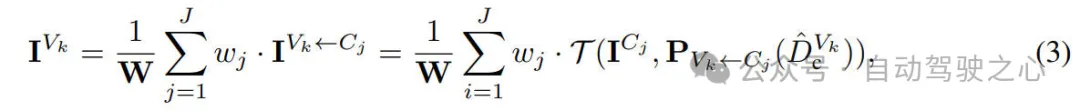

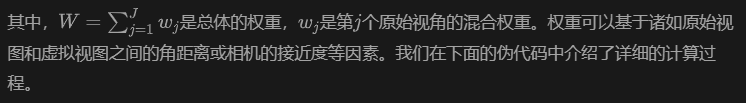

网络模型架构&技术细节

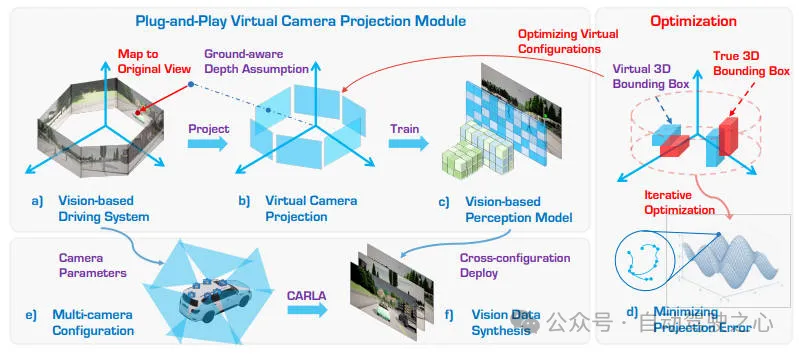

在详细介绍本文提出的算法模型细节之前,下图展示了我们提出的UniDrive算法模型的整体网络结构,如下所示。

提出的UniDrive算法模型的整体网络结构

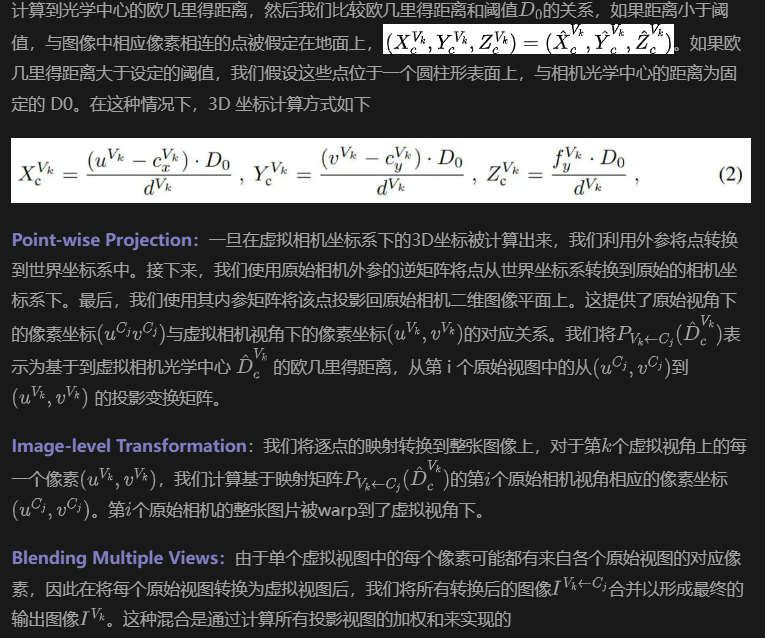

虚拟相机映射误差

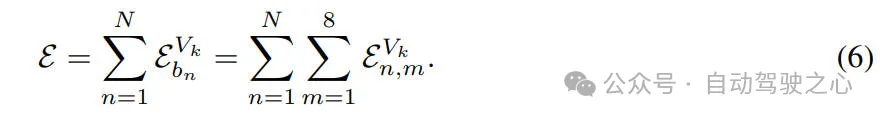

为了评估虚拟相机投影方法在 3D 物体检测任务中的准确性,我们提出了一种基于虚拟和原始相机视图之间的角度差异的加权投影误差度量。该方法考虑了角度偏差和与相机光学中心的距离,以提供更稳健的误差评估。

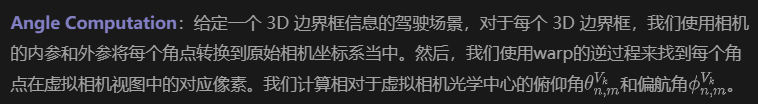

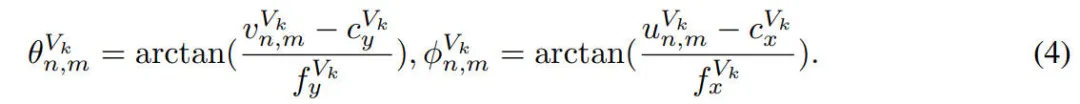

Angle Error Calculation:对于每个角点,我们计算原始相机投影和虚拟相机中对应点之间的角度误差。我们使用每个角点与原始相机光学中心的距离作为权重。3D 边界框的总体误差是通过将其八个角点的加权误差相加得出的。我们将所有 3D 边界框的投影误差相加,以计算总投影误差。

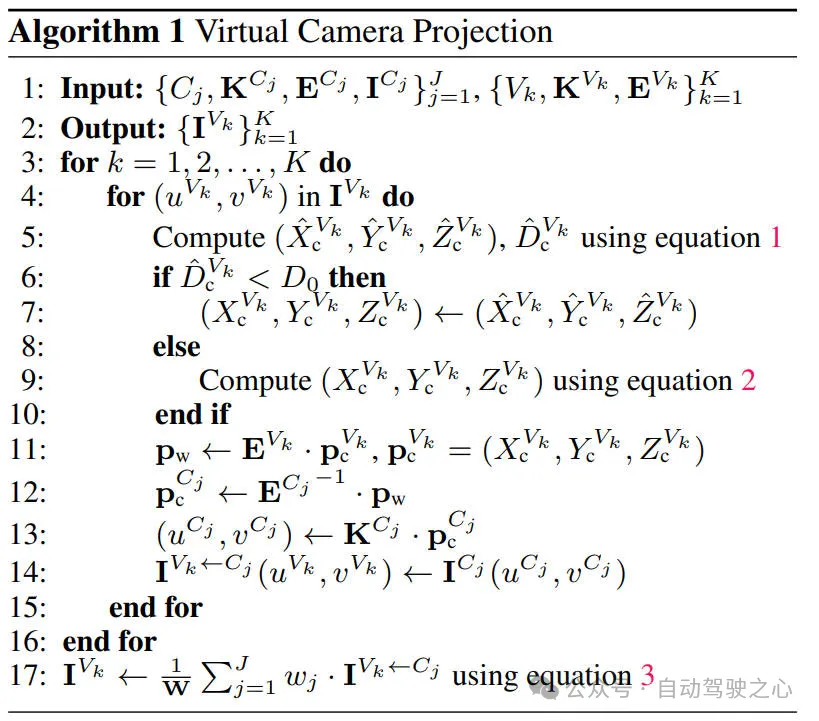

优化虚拟相机配置

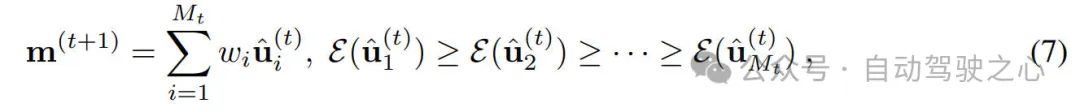

给定一组多相机系统,我们的目标是设计一个统一的虚拟相机配置,以最小化所有原始相机配置的重新投影误差。为了实现这一点,我们采用基于协方差矩阵自适应进化策略的启发式优化来找到一组优化的虚拟相机配置。

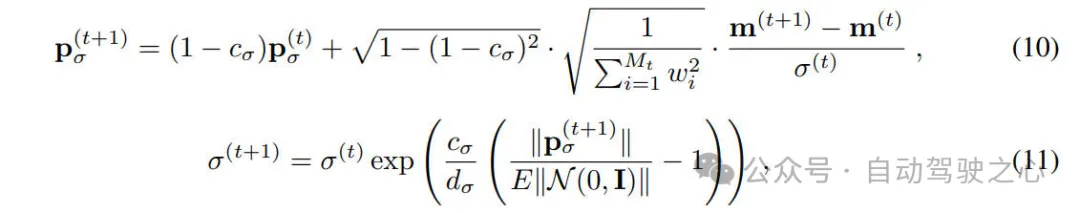

Optimization Method:我们的优化策略首先定义一个多元正态分布,整个的优化过程可以用数学形式表示如下。

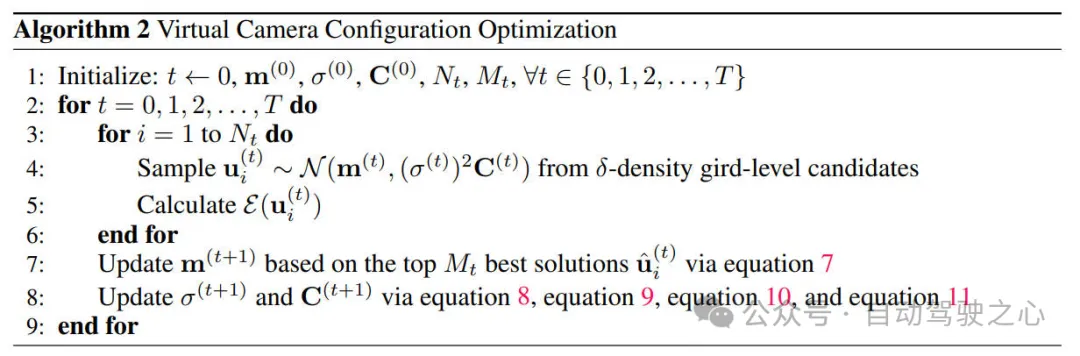

我们在下面的算法中给出了详细的优化过程

实验结果&评价指标

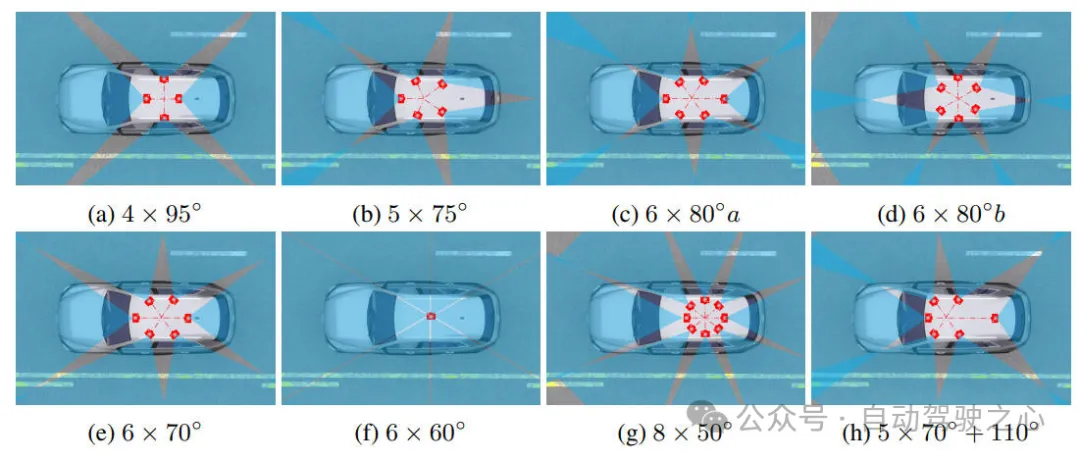

在本次实验中,我们采用了自动驾驶汽车中几种常用的摄像头配置情况,这些配置具有不同的摄像头数量、位置和视野。这些摄像头的配置情况可以用下图进行说明,我们还包括 nuScenes 数据集的原始配置,其中包含五个 70° 摄像头和一个 110° 摄像头。

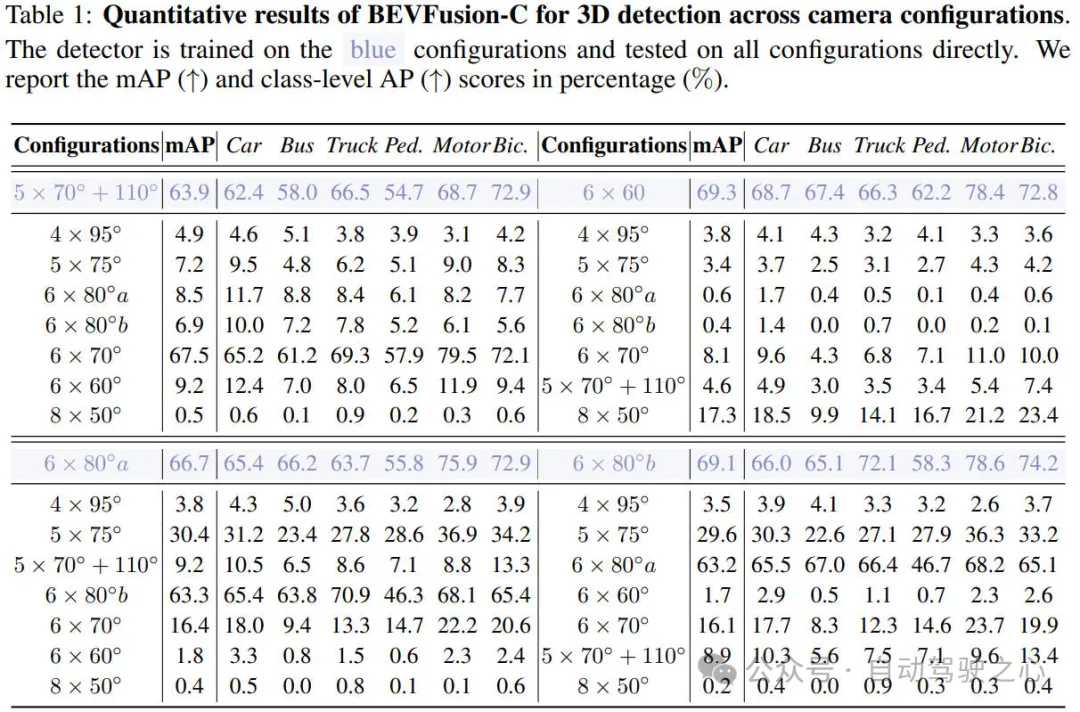

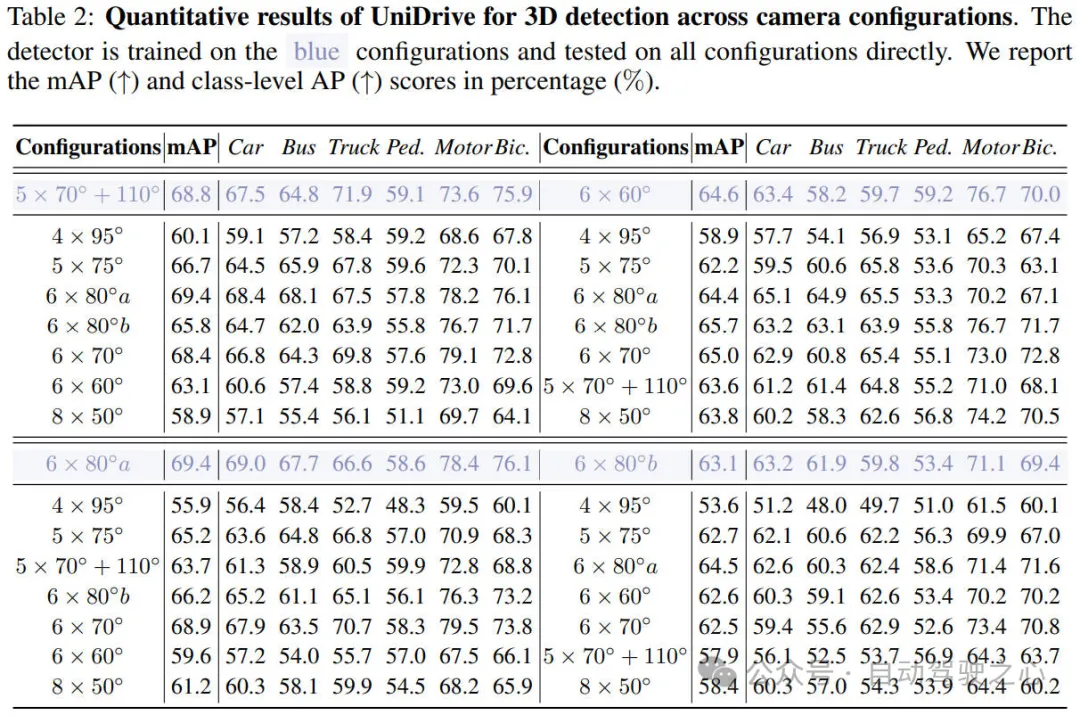

我们进行了相关的实验来验证我们提出的UniDrive算法模型的有效性,相关的实验结果如下表所示。

通过上表的实验结果可以看出,我们展示了BEVFusion和 UniDrive 的 3D 目标检测结果。这些模型在一种相机配置上进行训练,并在其他不同的相机配置上进行测试。表 1相关的实验结果表明,BEVFusion算法模型在跨相机配置任务上部署时的性能会大幅下降,在其他配置上几乎无法使用。如表 2 的实验结果所示,我们使用即插即用的UniDrive 框架训练模型。与 BEVFusion相比,检测性能得到显着提高。我们的方法在跨相机配置任务上仅经历很小的性能下降。

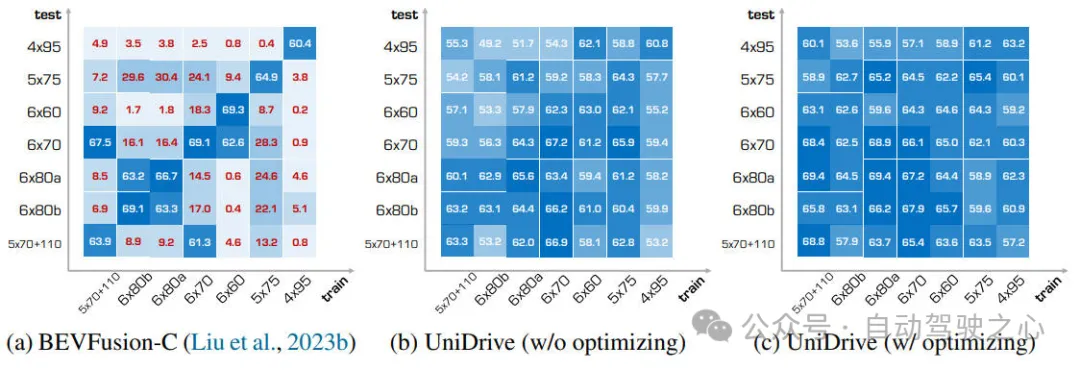

此外,为了更加直观的展示我们算法模型的有效性,我们在下图中展示了更多模型检测结果,全面展示了我们框架的有效性。

此外,为了证明优化在 UniDrive 中的重要性,我们在上图中比较了优化的虚拟摄像头配置和直观配置之间的感知性能。直观的虚拟摄像头配置将所有摄像头置于车顶的中心。如图所示,虽然与 BEVFusion相比,直观设置(未优化)也显着改善了跨摄像头配置感知性能,但它对某些配置表现出明显的偏好,而对其他配置的表现不佳。相比之下,优化的虚拟摄像头参数表现出更大的适应性,在各种配置中表现出相对一致的性能。这对于自动驾驶中多个多摄像头感知系统的并发开发至关重要。

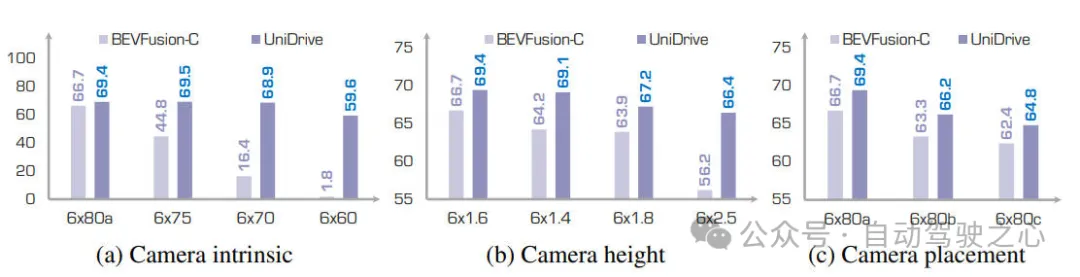

我们也验证了摄像头高度对于模型性能的影响。摄像头垂直位置的变化会显著影响感知性能,因为不同高度的摄像头会捕捉具有不同几何特征的图像。我们专门针对 1.6 米、1.4 米、1.8 米和 2.5 米的不同摄像头高度进行了实验。我们在1.6 米上训练模型,并在其他配置上进行测试。如下图所示。面对不同的摄像头高度,BEVFusion的性能大幅下降超过 10%。相比之下,UniDrive 在不同摄像头高度上的性能显著提高,表现出增强的稳健性,性能仅下降 3.0%。

结论

在本文中,我们提出了UniDrive算法框架,用于增强以视觉为中心的自动驾驶模型在不同摄像头配置中的泛化能力。在CARLA 中的大量实验验证了我们提出的UniDrive的有效性以及强大的泛化能力。此外,我们的框架不仅可以作为现有 3D 感知模型的即插即用模块,而且为更通用、更可扩展的自动驾驶解决方案提供了可能。