大家好,我是小寒

今天给大家介绍一个强大的算法模型,卷积神经网络算法

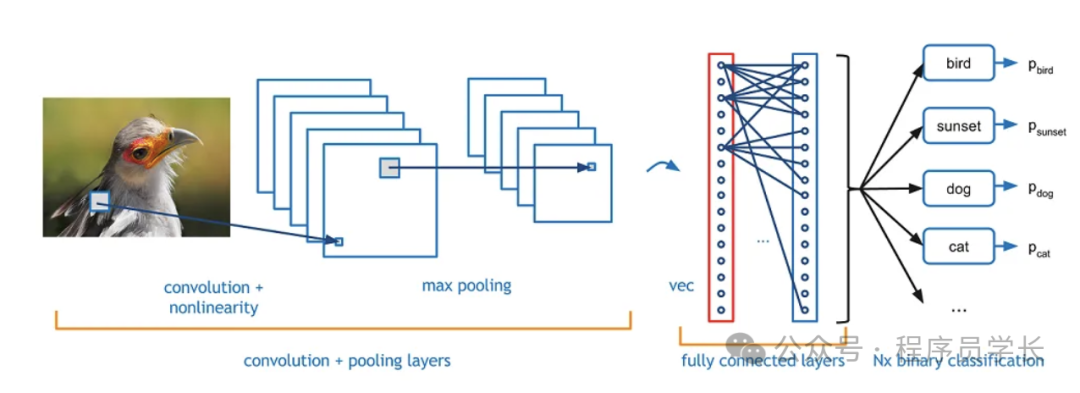

卷积神经网络(CNN)是一种专为处理像图像等具有网格拓扑结构的数据而设计的深度学习模型。

CNN 通过使用卷积运算来替代传统神经网络的全连接层,能够有效减少参数数量并保留空间信息,极大地提升了图像识别、目标检测等任务的效果。

图片

图片

卷积神经网络的基本构成

卷积神经网络主要由卷积层、池化层和全连接层组成。

1.卷积层

卷积层是 CNN 的核心组成部分,用于从输入数据中提取局部特征。

其主要运算是通过多个卷积核(filter)对输入数据进行卷积操作,生成特征图 (feature map)。

图片

图片

- 卷积核

卷积核是一个小矩阵,它在输入数据上滑动,应用点积运算来提取特定的局部特征。

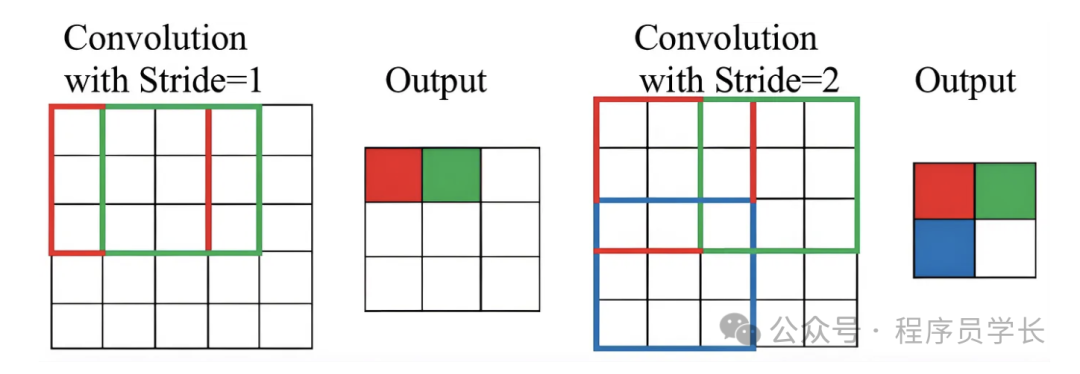

卷积核的大小和数量是可调的超参数。 - Stride(步幅)

这是卷积核在输入数据上移动的步长。

步幅越大,特征图的尺寸越小。

图片

图片

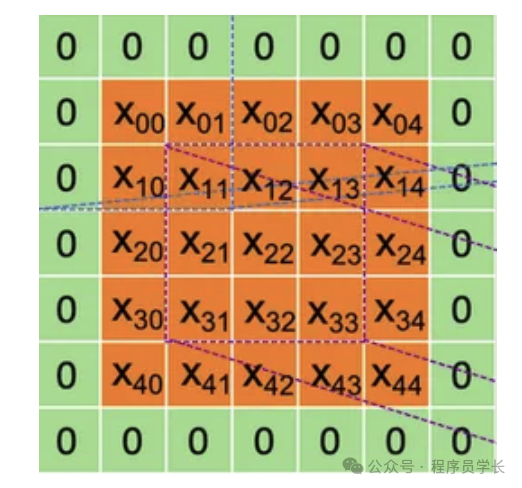

- Padding(填充)

为保持卷积后的输出尺寸与输入相同,通常会在输入数据的边缘进行零填充。

图片

图片

卷积层的输出称为特征图(Feature Map),通过多次卷积操作,CNN 能够逐层提取出越来越高层次的特征信息。

2.池化层

池化层的主要作用是通过下采样来减少数据的维度,同时保留输入的关键信息。

池化层通常插入在卷积层之后,用于减少计算量和参数数量,并在某种程度上减轻过拟合的风险。

常见的池化方法有最大池化和平均池化。

- 最大池化

最大池化是最常见的池化操作。它在局部窗口中选择最大值。

例如,使用一个2x2的窗口,每次移动步长为2,对局部区域的像素值取最大值。

最大池化的目的在于保留最显著的特征。

图片

图片

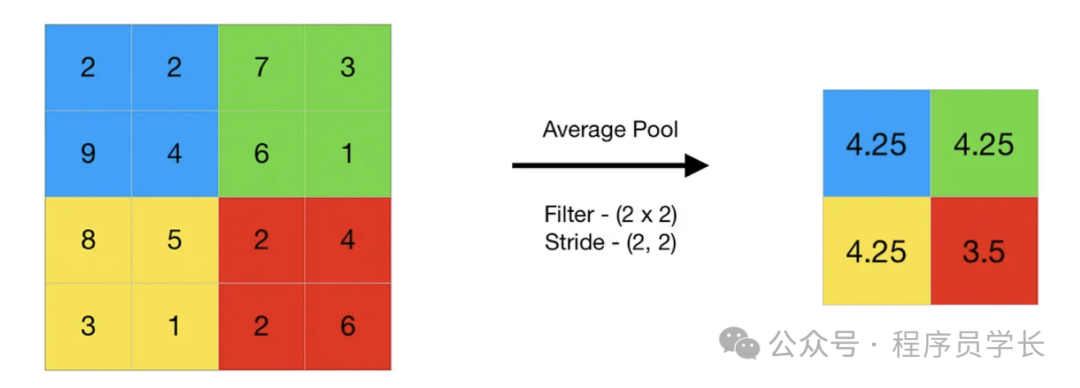

- 平均池化

它计算局部窗口内所有值的平均。平均池化会平滑特征,适合于某些应用场景。

图片

图片

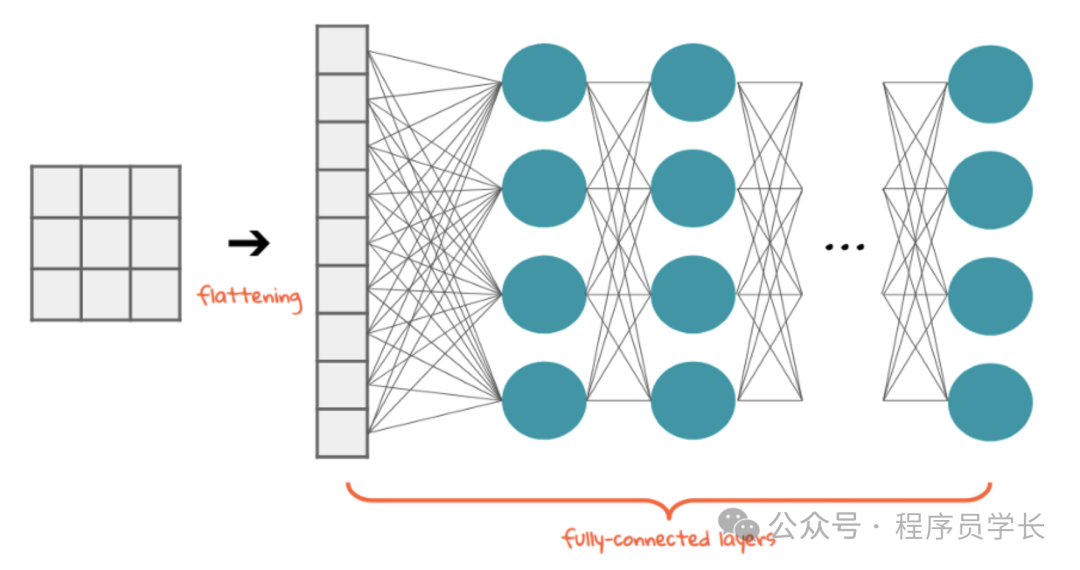

3.全连接层

在经过若干个卷积层和池化层之后,通常会将特征图展平成一个向量,并将其传递给全连接层。

全连接层与传统的前馈神经网络类似,每个神经元与上一层的所有神经元相连。

图片

图片

卷积神经网络的优势

- 局部连接性

通过卷积操作,CNN 能够捕捉局部的空间特征,减少参数。 - 权值共享

卷积核的权值在图像中多个位置共享,进一步降低了参数量。 - 自动提取特征

通过逐层的卷积操作,CNN 可以自动提取从低级到高级的特征,不需要手工设计特征。

示例代码

下面是一个使用卷积神经网络(CNN)进行图像分类的完整示例代码,采用 PyTorch 框架来实现。

import torch

import torch.nn as nn

import torch.optim as optim

import torchvision

import torchvision.transforms as transforms

# 定义 CNN 模型

class CNNModel(nn.Module):

def __init__(self):

super(CNNModel, self).__init__()

# 定义第一层卷积层,输入通道为 3(CIFAR-10 中的彩色图像),输出通道为 32,卷积核大小为 3x3

self.conv1 = nn.Conv2d(3, 32, kernel_size=3, padding=1)

# 定义第二层卷积层

self.conv2 = nn.Conv2d(32, 64, kernel_size=3, padding=1)

# 定义池化层

self.pool = nn.MaxPool2d(2, 2)

# 定义全连接层,假设输入为 64*8*8,输出为 512

self.fc1 = nn.Linear(64 * 8 * 8, 512)

# 定义第二个全连接层,输出为 10(CIFAR-10 有 10 个类别)

self.fc2 = nn.Linear(512, 10)

def forward(self, x):

x = self.pool(torch.relu(self.conv1(x)))

x = self.pool(torch.relu(self.conv2(x)))

x = x.view(-1, 64 * 8 * 8)

x = torch.relu(self.fc1(x))

x = self.fc2(x)

return x

# 超参数

batch_size = 64

learning_rate = 0.001

num_epochs = 10

# 数据预处理

transform = transforms.Compose([

transforms.RandomHorizontalFlip(), # 随机水平翻转

transforms.RandomCrop(32, padding=4), # 随机裁剪

transforms.ToTensor(), # 转换为张量

transforms.Normalize((0.5, 0.5, 0.5), (0.5, 0.5, 0.5)) # 归一化

])

# 加载 CIFAR-10 数据集

trainset = torchvision.datasets.CIFAR10(root='./data', train=True, download=True, transform=transform)

trainloader = torch.utils.data.DataLoader(trainset, batch_size=batch_size, shuffle=True)

testset = torchvision.datasets.CIFAR10(root='./data', train=False, download=True, transform=transform)

testloader = torch.utils.data.DataLoader(testset, batch_size=batch_size, shuffle=False)

model = CNNModel()

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(model.parameters(), lr=learning_rate)

# 训练模型

for epoch in range(num_epochs):

running_loss = 0.0

for i, (inputs, labels) in enumerate(trainloader, 0):

inputs, labels = inputs, labels

optimizer.zero_grad()

outputs = model(inputs)

loss = criterion(outputs, labels)

loss.backward()

optimizer.step()

running_loss += loss.item()

if i % 100 == 99:

print(f'Epoch [{epoch + 1}/{num_epochs}], Step [{i + 1}], Loss: {running_loss / 100:.4f}')

running_loss = 0.0

print('Finished Training')

# 在测试集上评估模型

correct = 0

total = 0

with torch.no_grad():

for inputs, labels in testloader:

outputs = model(inputs)

_, predicted = torch.max(outputs.data, 1)

total += labels.size(0)

correct += (predicted == labels).sum().item()

print(f'Accuracy of the network on the 10000 test images: {100 * correct / total:.2f}%')