传统扩散模型要过时了?OpenAI找到一种新方法,直接把生成速度提高50倍!

扩散模型在生成式 AI 领域的重要性不言而喻,把生成逼真的图像、3D 模型、音频和视频变为了现实。

但是,扩散模型依然有个致命bug——采样速度太慢。

OpenAI研究的新方法,被称为 sCM(连续时间一致性模型)。

sCM 在仅使用两个采样步骤的情况下,实现了与领先扩散模型相当的样本质量。

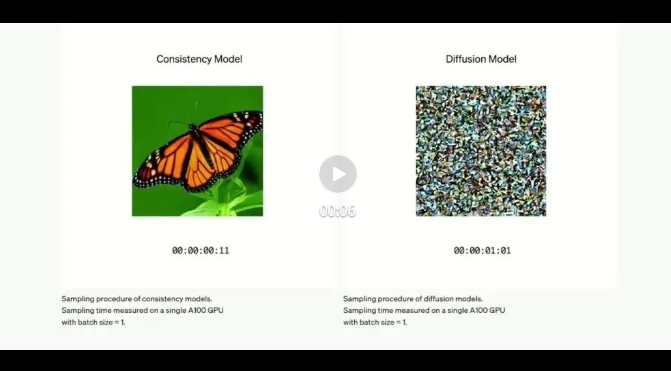

来感受下 sCM 的速度:

那么sCM为什么这么快呢,我们一起看看。

1.提速50倍:Scaling Law 再次出奇迹

在刚才的实例里,右侧蝴蝶逐步清晰,展示了当前扩散模型的能力。

该方法的采样通常需要数十到数百个连续步骤来生成单个样本,这限制了它们在实时应用中的效率和可扩展性。

虽然,此前已经开发了各种蒸馏技术来加速采样,但它们往往伴随着一些限制,例如高计算成本、复杂的训练过程和降低的样本质量。

而sCM则不同,在此前一致性模型的研究基础上,OpenAI简化了公式,并进一步稳定了连续时间一致性模型的训练过程。

不得不说,Scaling Law 还是大力出奇迹。

这个方法一下使得OpenAI研究人员能将连续时间一致性模型的训练扩展到前所未有的规模!

具体有多大呢?——在 ImageNet 数据集上以 512×512 分辨率处理 15 亿参数的模型。

sCM 仅使用两个采样步骤就能生成与扩散模型相当的样本质量,实现了大约 50 倍的时间加速。例如,OpenAI的最大模型(15 亿参数)在一块 A100 GPU 上只需 0.11 秒即可生成一个样本,而无需任何推理优化。

OpenAI这波太牛了,通过系统优化,这个提速来得迅猛又轻松,感觉再升级的DALL-E 4已经不远了!

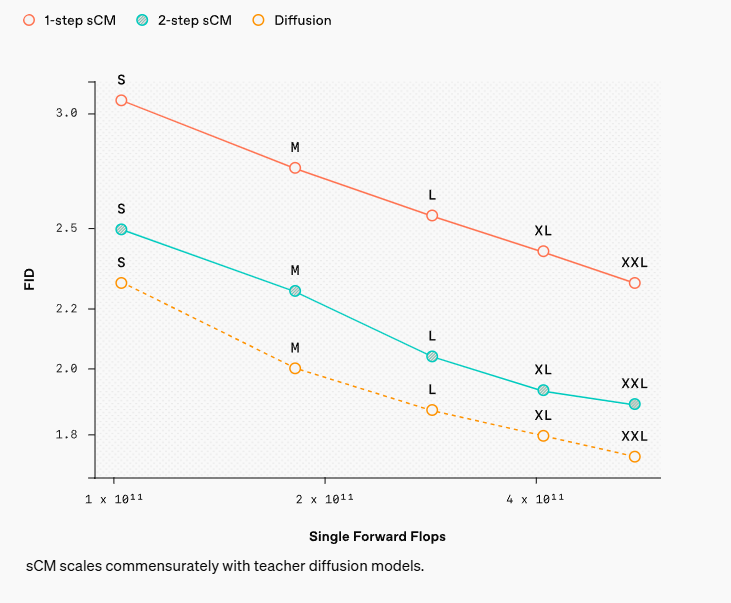

报告还提到,为了进行严格的评估,OpenAI研究者通过比较样本质量(使用标准的 FID 得分,分数越低越好)和有效采样计算(估算生成每个样本所需的总计算成本)来对 sCM 与其他最先进的生成模型进行了基准测试。

结果如下所示,两步 sCM 生成的样本质量可与最佳的先前方法相媲美,而其有效采样计算成本不到 10%,大大加快了采样过程。

图片

图片

2.工作原理揭秘:为什么一致性模型能提速?

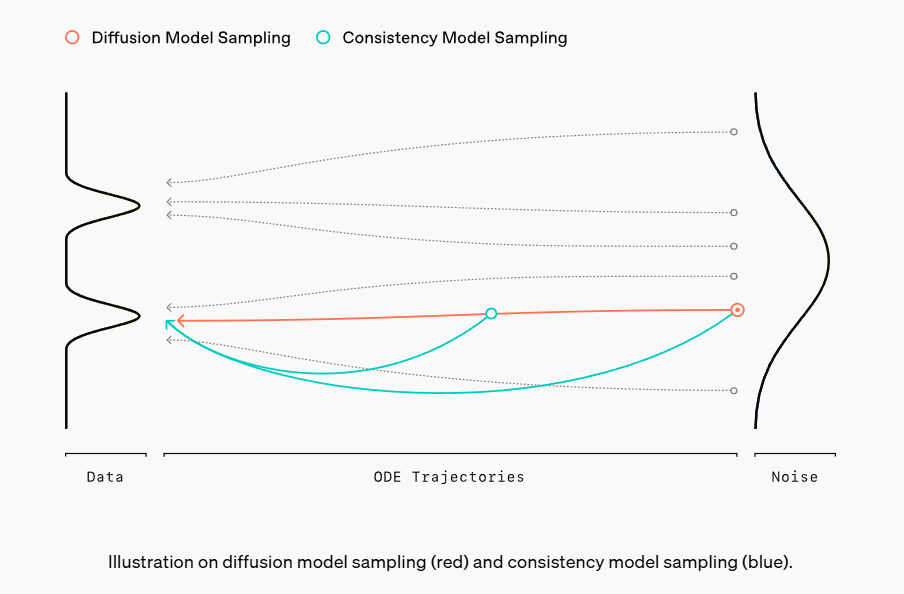

一致性模型与扩散模型不同:扩散模型需要通过大量去噪步骤逐步生成样本;而一致性模型的目标是在一步中将噪声直接转换为无噪声的样本。

看图表会更加直观,下图中:蓝线代表扩散模型逐步采样的过程,而红线则展示了一致性模型更直接、加速的采样路径。

通过使用一致性训练或一致性蒸馏等技术,一致性模型可以被训练成在显著减少步骤的情况下生成高质量样本,这使它们在需要快速生成的实际应用中极具吸引力。

图片

图片

在研究中,OpenAI团队在ImageNet 512x512上训练了一个具有15亿参数的连续时间一致性模型,以下是一些两步采样结果。

图片

图片

sCM的训练方式也很有趣,——偷师扩散模型,即通过从一个预训练的扩散模型中提取知识得以训练。

一个重要的发现是,随着sCM和教师扩散模型的共同扩展,sCM的性能按比例提高。具体来说,样本质量的相对差异(通过FID分数比率来衡量)在不同规模的模型中保持一致,这导致样本质量的绝对差异在模型扩展时逐渐减小。此外,增加sCM的采样步骤进一步缩小了质量差距。值得注意的是,sCM的两步采样已经与教师扩散模型的采样质量相当(相对差异不到10%),而教师扩散模型需要数百步才能生成样本。

图片

图片

3.写在最后:仍有缺陷,仍需探索

从上图也可以看出,目前最好的sCM仍然依赖于预训练的扩散模型进行初始化和蒸馏,因此与教师扩散模型相比,样本质量仍存在小而持续的差距。

此外,报告中写道,FID作为衡量样本质量的指标本身也有局限性;接近的FID分数并不总是反映实际的样本质量,反之亦然。因此,sCM的质量可能需要根据特定应用的需求以不同方式进行评估。

OpenAI表示,将继续致力于开发具有更快推理速度和更高样本质量的生成模型,相信这些进展将为实时、高质量生成式AI在广泛领域中的应用开启新的可能性。