本篇分享论文Depth Any Video with Scalable Synthetic Data,基于多样的仿真数据集和强大的视频生成模型,Depth Any Video在真实视频数据上展现了超强的泛化能力,并且在视频深度一致性和精度上超越了之前所有生成式的深度估计方法!

论文链接:https://arxiv.org/abs/2410.10815

主页链接:https://depthanyvideo.github.io

代码链接:https://github.com/Nightmare-n/DepthAnyVideo

摘要

我们提出了一种新颖的视频深度估计模型:Depth Any Video,它主要包含两大关键创新: 1. 我们开发了一套可扩展的合成数据采集流程,从多样化的虚拟环境中实时捕获视频深度数据,采集了约4万段5秒长的视频片段,每段都具有精准的深度标注。2. 我们利用强大的视频生成模型的先验来高效处理真实世界视频,并集成了旋转位置编码和流匹配等先进技术,进一步增强灵活性和效率。 此外,我们引入了一种新颖的混合时长训练策略,能够在不同长度、不同帧率的视频下表现出色。在推理阶段,我们提出了一种深度插值方法,使模型能够同时处理长达150帧的高分辨率视频。我们的模型在深度一致性和精度方面均超越了之前所有的生成式深度估计方法。

动机

视频深度估计是理解三维世界的基础问题,在自主导航、增强现实和视频编辑等具有广泛的应用。现有的方法面临的主要瓶颈在于缺乏多样且大规模的视频深度数据,导致模型在不同场景下难以有效泛化。为了解决这个问题,本文提出了两大关键创新: • 我们构建了一个大规模的合成视频深度数据集,利用现代虚拟环境的高逼真视觉效果,从虚拟环境中提取大规模且精确的视频深度数据,既具可扩展性又低成本。 • 我们设计了一个全新的视频深度估计框架,借助视频生成模型的强大视觉先验,提升对真实视频的泛化能力。该框架引入混合时长训练策略和深度插值模块,确保模型能在不同视频长度下保证深度估计的精确性和一致性。 我们的模型在生成式的深度估计方法中实现了最先进的性能,树立了视频深度估计的准确性和鲁棒性的新标杆。

方法

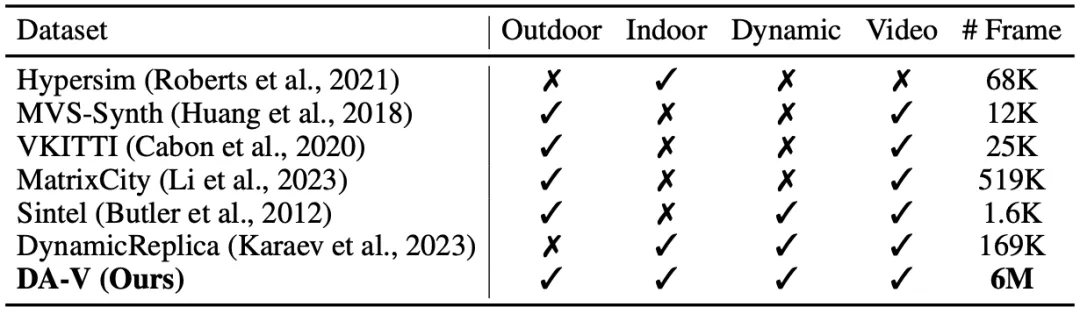

Game Data Workflow 实时数据收集:为解决深度数据的挑战,我们收集了由40,000个视频片段组成的大规模仿真数据集DA-V。该数据集主要通过先进的虚拟环境引擎生成逼真的环境,并提供准确的深度信息。我们在多款热门虚拟环境中提取深度数据,并精心选择以涵盖广泛的场景和环境条件,如:广阔的城市景观、细致的室内场景、丰富的动作场面,以及科幻的建筑设计。它不仅为我们提供精准的深度信息,还让模型接触多样的光照条件、天气效果和复杂的几何结构,使得模型能够泛化到真实环境中。在表1中,我们将DA-V与以往的公开仿真数据集进行了比较。据我们所知,这是目前覆盖真实场景范围最广的合成视频深度数据集。

数据过滤:在收集初始仿真视频后,我们发现图像与深度信息之间偶尔会出现不一致现象,例如:切换到菜单界面时。为过滤这些帧,首先使用场景切割方法检测场景转换。然后,利用在人工挑选的仿真数据子集上训练过的深度估计模型过滤掉得分较低的视频序列。然而,这种方法可能导致未见数据的过度过滤。因此,我们借助CLIP模型计算实际和预测深度之间的语义相似度,均匀抽取每个视频片段的10帧。如果语义和深度得分的中位数均低于设定阈值,则移除该片段。

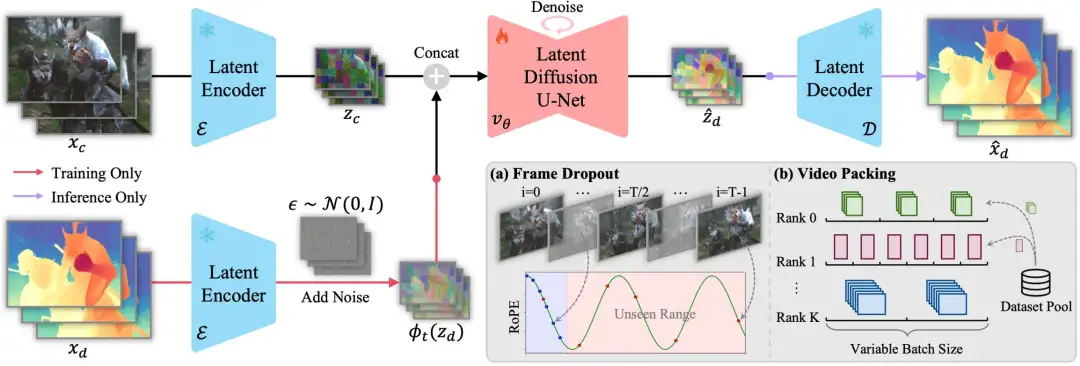

Generative Video Depth Model 模型设计:我们基于视频生成模型Stable Video Diffusion (SVD),将深度估计框架转化为条件去噪过程。整体框架如图1所示,训练流程包括一个前向过程,通过添加高斯噪声逐步扰乱真实深度数据,然后将视频作为条件输入去噪模型进行反向去噪。一旦模型完成训练,推理流程就从纯噪声开始,逐步去噪,逐步得到深度预测结果。与之前的扩散模型类似,该生成过程在变分自编码器的潜空间中进行,使模型能处理高分辨率输入而不牺牲计算效率。为了让去噪器以输入视频为条件,我们也将视频转换到潜空间中,然后将其与潜空间下的深度逐帧连接,作为去噪模型的输入。

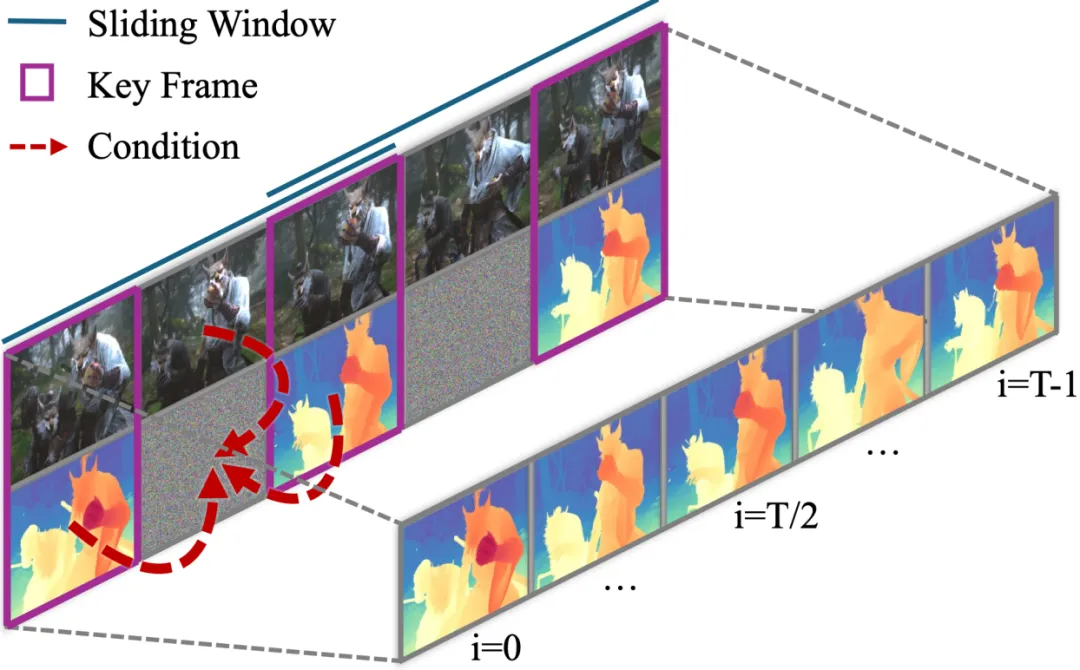

条件流匹配:为了加速去噪过程,我们将SVD中的去噪方法替换为条件流匹配。相比于原本的25步,新方法只需1步即可获得满意的深度预测结果。具体来说,我们通过高斯噪声与数据之间的线性插值来建模数据加噪过程,然后通过预测速度矢量场和常微分方程来进行去噪求解。 混合时长训练:为了增强模型在不同视频长度下深度估计的泛化能力,我们采用了一种混合时长训练策略,以确保对各种输入的鲁棒性。这一策略包括:帧丢弃数据增强(图1a):提升长视频序列的训练效率,并通过旋转位置编码增强模型在长视频下的泛化能力。视频打包技术(图1b):将相同长度、分辨率的视频打包在同一个训练批次中,优化变长视频训练过程中的内存使用。 长视频推理:上述经过训练的模型,在单个80GB A100 GPU上可同时处理分辨率为960 x 540的32帧视频。为处理更长的高分辨率视频序列,我们首先预测全局一致的关键帧,然后使用帧插值网络生成关键帧之间的中间帧,以确保深度分布的尺度和偏移对齐。如图2所示,我们将关键帧的预测结果与视频序列同时作为帧插值网络的条件输入。

实验结果

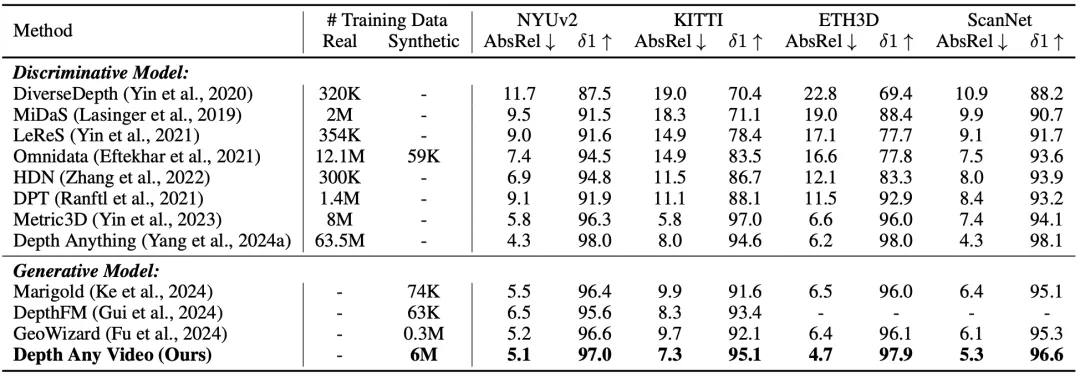

表2展示了我们的模型与当前最先进的单帧输入的深度估计模型的性能比较。我们的模型在各个数据集上显著超越了先前所有的生成模型,同时在某些情况下,其表现甚至优于之前的判别模型。

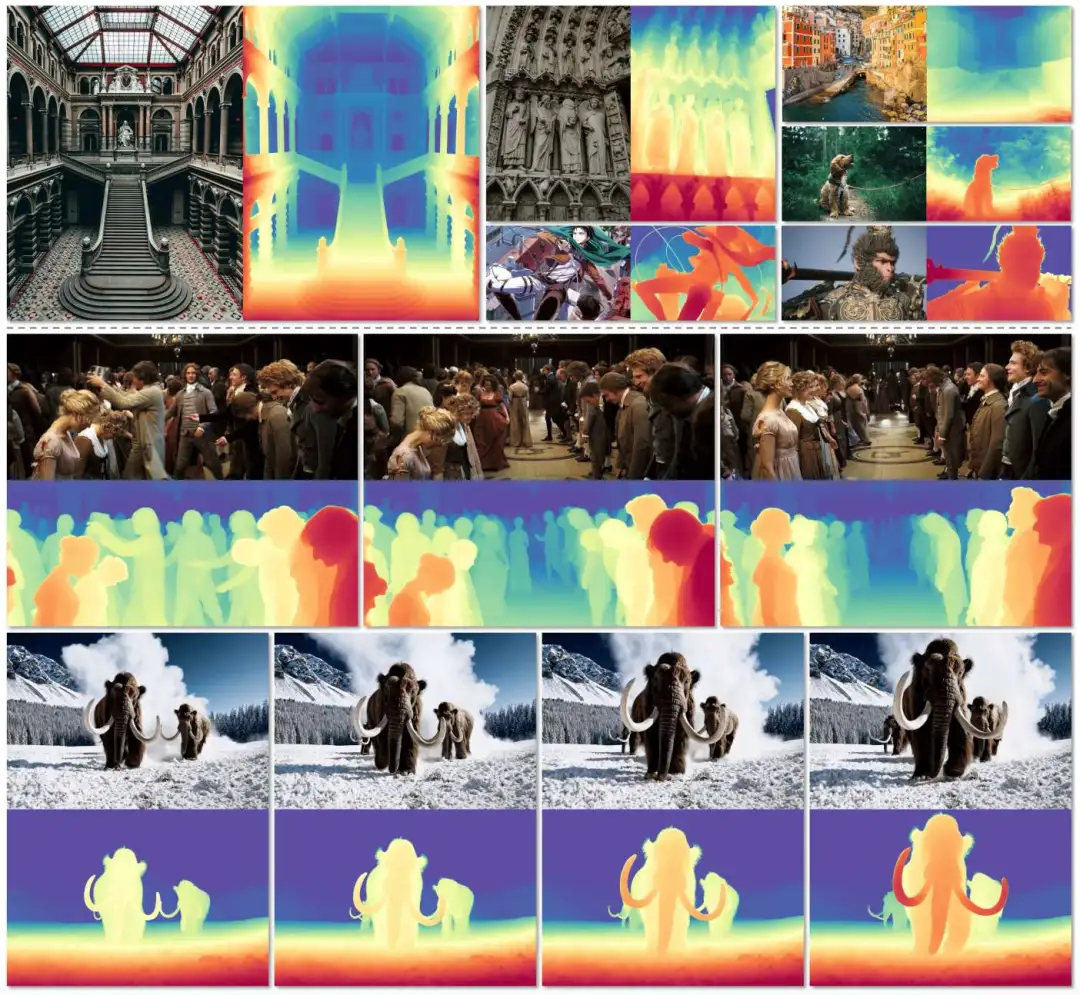

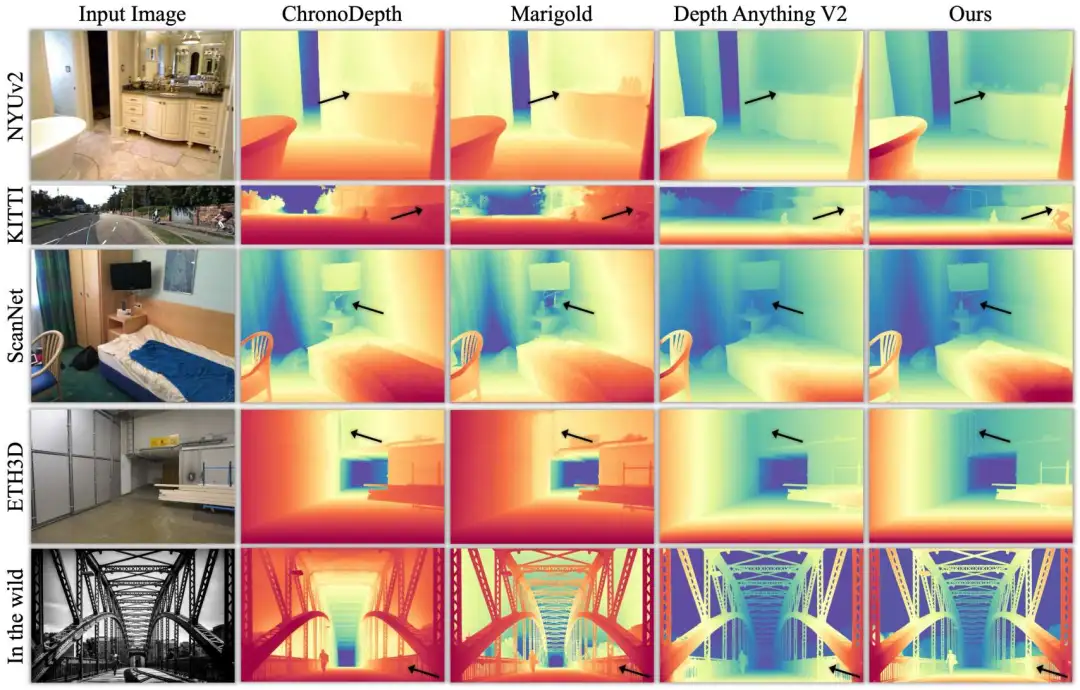

图3展示了我们的模型在不同数据集下的可视化结果,我们的方法能够捕捉细致的细节,并在自然环境数据上实现有效的泛化性。

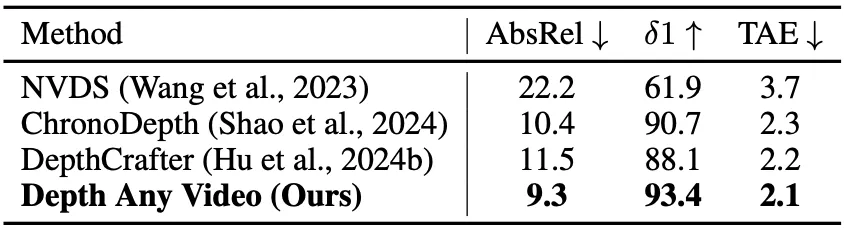

表3展示了我们的模型与之前的视频深度估计模型的性能比较。我们的模型在ScanNet++数据集上展示了更好的时间一致性和预测精度,突显其在视频深度估计中的有效性。

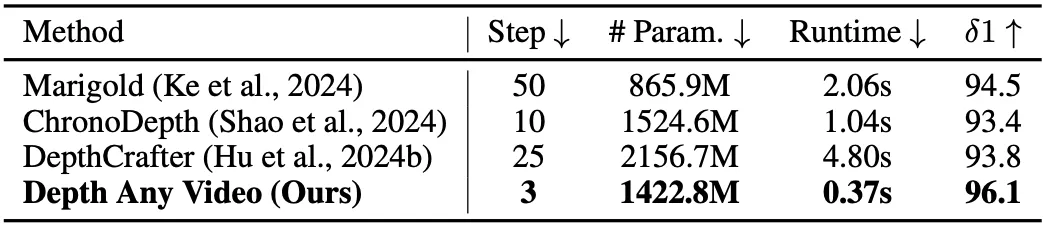

表4展示了与之前生成方法的性能和效率比较。我们的模型参数少于先前的视频深度估计方法。此外,与所有的生成式深度估计方法相比,我们实现了更低的推理时间和更少的去噪步骤,同时获得了更好的预测精度。

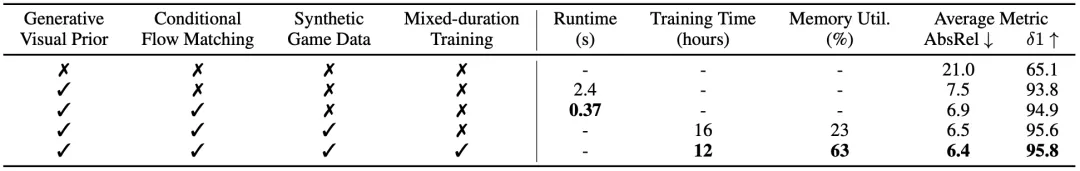

表5展示了所提模块对模型测试时间、训练时间、显存利用率和平均精度的影响。可以看到,这些模块均对各项指标产生了积极影响。