在大模型和AIGC的新纪元,我们正见证一个前所未有的技术革命。从更自然的人机对话,到图片、视频生成,AIGC技术正在彻底改变我们创造、学习和交流的方式。

然而,这一切进步的背后,是对存储技术的极端要求。举个例子,一家致力于开发AIGC应用的公司,如何高效地处理和存储大量的数据,以不断训练和优化其AI大模型。这不仅要求存储系统能够处理PB级的数据量,还要求在数据采集、清洗、训练及推理的每一个环节,都能提供高速、可靠的数据访问。

随着大模型参数规模的持续扩大,对计算基础设施三大件——算力、网络、存储,都提出了新的要求。目前,支撑大模型的算力、网络在快速迭代。算力方面,英伟达用了两年的时间从H100升级到了H200,让模型训练性能提升了5倍;在网络方面,已经从以前的25G、50G、100G,逐步发展到200G的网络,带宽提升了超过6倍。

那么,对于存储而言,包含了数据采集与清洗、模型训练、以及推理三大关键环节,每一个环节都对存储系统提出了新的要求和挑战。

数据采集与清洗的挑战:数据量和多样性、多协议支持的需求、高性能和大带宽的要求。

在AIGC技术的实施过程中,数据采集与清洗阶段是基础。这一阶段的核心任务是收集来自不同源的数据,进行预处理和清洗,以确保数据的质量和可用性。这一任务面临着几个主要问题:数据量巨大、类型多样化、需要多协议支持,以及对高性能和大带宽的需求。不同类型的数据往往需要通过不同的协议进行收集和访问,高效的数据处理不仅需要大容量存储,还需要高性能和大带宽以支持快速的数据读写和传输。

模型训练的挑战:频繁的checkpoint保存、高并发读写的需求。

大模型训练过程中,为了防止数据丢失并能够从最近的进度恢复,需要定期保存模型的状态,即checkpoint。这些checkpoint包含了模型的参数、超参数以及优化器的状态等信息,对于维持训练的连续性至关重要。然而,随着模型规模的不断增大,这些checkpoint的体积也随之增加,导致保存操作消耗大量时间和存储资源,特别是在使用分布式训练时,多个节点同时对存储系统进行访问,对存储系统的并发处理能力和响应时间提出了极高的要求。

推理与数据治理的挑战:数据安全与可追溯性、内容审核与合规性。

在AIGC应用的推理阶段,企业面临着数据安全、可追溯性、内容审核和合规性等一系列挑战。这些挑战不仅关乎技术的有效实施,还直接影响到企业的信誉和合法运营。随着数据泄露事件的频繁发生,确保敏感信息的安全变得尤为重要。同时,数据的可追溯性也至关重要,这不仅有助于追踪数据流向和处理过程,以评估数据安全性,还能在发生安全事件时迅速定位问题。

以一个基于AIGC技术的新闻自动生成平台为例,该平台能够自动采集网络上的新闻资讯,结合用户的阅读偏好生成个性化新闻内容。存储系统不仅需要对存储的数据进行加密,还要记录详细的数据处理日志,以实现数据的可追溯性。在新闻内容生成后,平台还需要对内容进行审核,确保不含有误导性信息、侵权内容或违反法律法规的信息。这就要求存储系统能够支持与内容审核工具的高效集成,快速筛查和过滤内容,同时还要有能力处理大量的内容审核请求,保证审核的实时性和准确性。

正如上面所分析的那样,在大模型、AIGC技术快速发展的背景下,数据存储面临着前所未有的挑战。巨大的数据量、多样化的数据类型、以及对高速访问的迫切需求,都在推动存储技术的创新和进步。为了应对这些挑战,业界从多个方面进行创新探索,主要集中在以下几个方向:

高性能分布式存储

为了应对PB级别数据量的处理需求,采用可扩展的分布式存储系统成为了行业的共识。这类系统通过分散数据到多个节点上,不仅能够提高存储容量,还能通过并行处理提升数据访问速度。这种存储方案的核心优势在于其弹性扩展能力,可以根据需要动态调整资源,以应对数据量的不断增长。

并行文件存储

并行文件存储系统通过允许多个进程同时对文件系统进行读写,大幅提高了数据处理的效率。这对于大模型训练尤为关键,因为它能显著缩短模型训练的时间,加快迭代速度。

数据加速与缓存

数据加速器和缓存技术的应用,进一步提升了数据访问速度,实现了快速数据加载和亚毫秒级的低延迟。通过将频繁访问的数据存放在更快的存储介质上,如SSD或内存中,系统可以迅速响应数据请求,大幅提高AIGC应用的响应速度和用户体验。

多模态数据检索分析

AIGC技术的一大特点是处理多模态数据,如文本、图片、视频等。为此,提供多模态数据检索和分析工具变得尤为重要。这些工具能够帮助用户快速找到所需数据,优化数据管理,提高数据的可用性和价值。

数据安全与合规工具

在AIGC领域,数据安全和合规性是不容忽视的重要问题。集成的内容审核、数据加密和合规性工具能够确保数据在整个生命周期中的安全性,同时满足不同地区和行业的法律法规要求。这不仅保护了用户隐私,也为企业的合法运营提供了保障。

这些方案的共同目标是构建一个既能够处理海量数据,又能满足高速访问需求,同时确保数据安全和合规性的存储基础设施。

解除存储瓶颈,AIGC应用才能腾飞

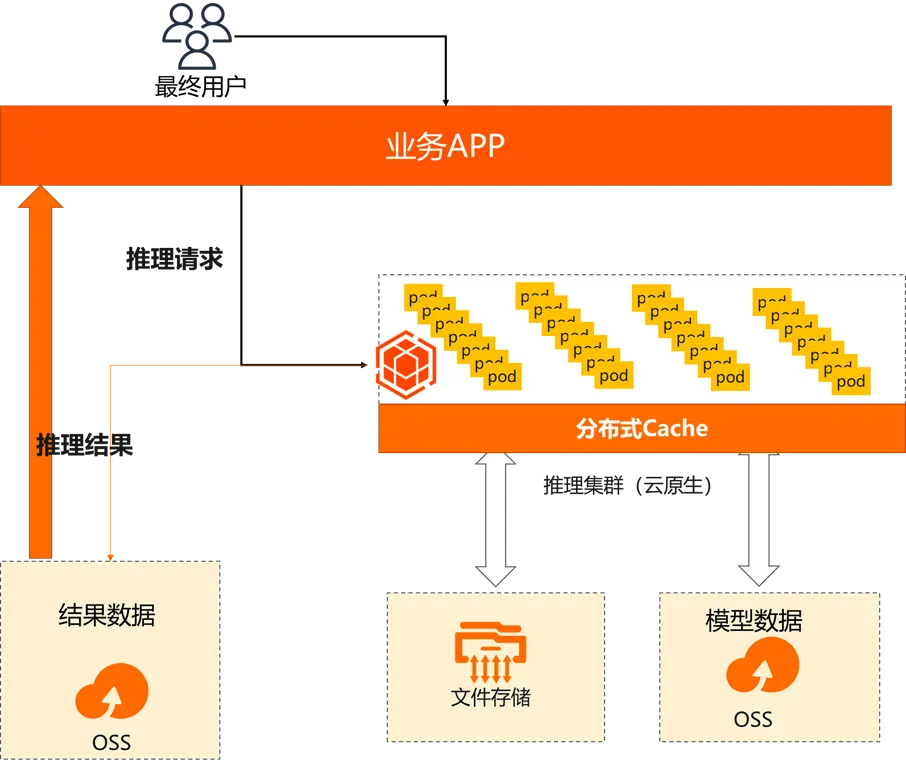

传统推理

GPT-175B 模型约有 1750 亿参数,以半精度(FP16)格式计算,总计至少占 320GB(计算 1024 的倍数)的存储空间,所以需要至少 5 个 A100 GPU,且在推理时,每个 GPU 都起码需要有 80GB 的内存。大多数的实际推理部署会进行相关的模型精简,业界常见的优化方向包括量化、减枝、蒸馏等。

在经典的AIGC场景,推理业务对于基础平台的关键需求从读取变成了启动。

- 高吞吐:通过启上千个POD,并行对不同需求进行计算,单个POD的模型在10~100GB,一般需要数秒钟启动。对源存储下载带宽需求在100Gbps左右,性能密度达2Gbps/TiB

- 高弹性:访问请求是由用户触发,日常任务具有随机性(峰值1~100K POD),对于killer app推理开销远大于训练。

- Posix兼容性:大部分仿真软件均采用posix协议并发访问原始数据集

- 数据缓存:推理阶段加载数据全部为模型数据,缓存价值大

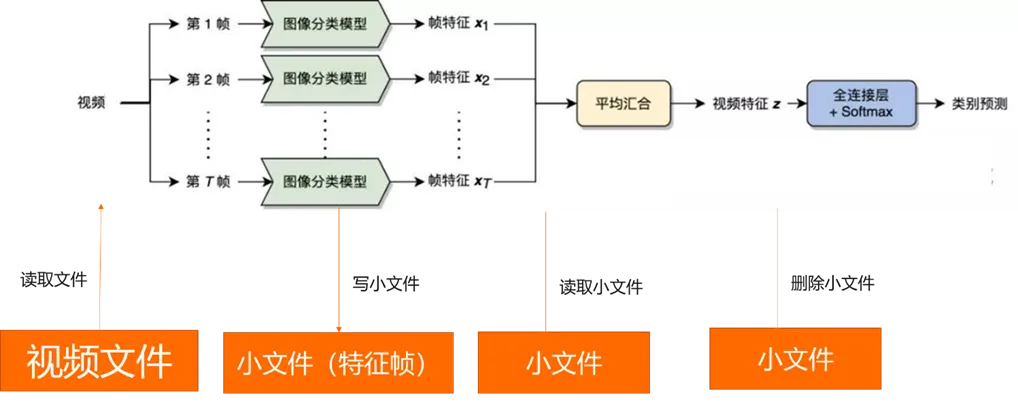

如果是多模态场景,可能会有一些存储性能的需求。

在该场景,核心瓶颈是小文件大量写入和删除(mkdir、rmdir、create、remove):建议使用GPFS类文件存储。

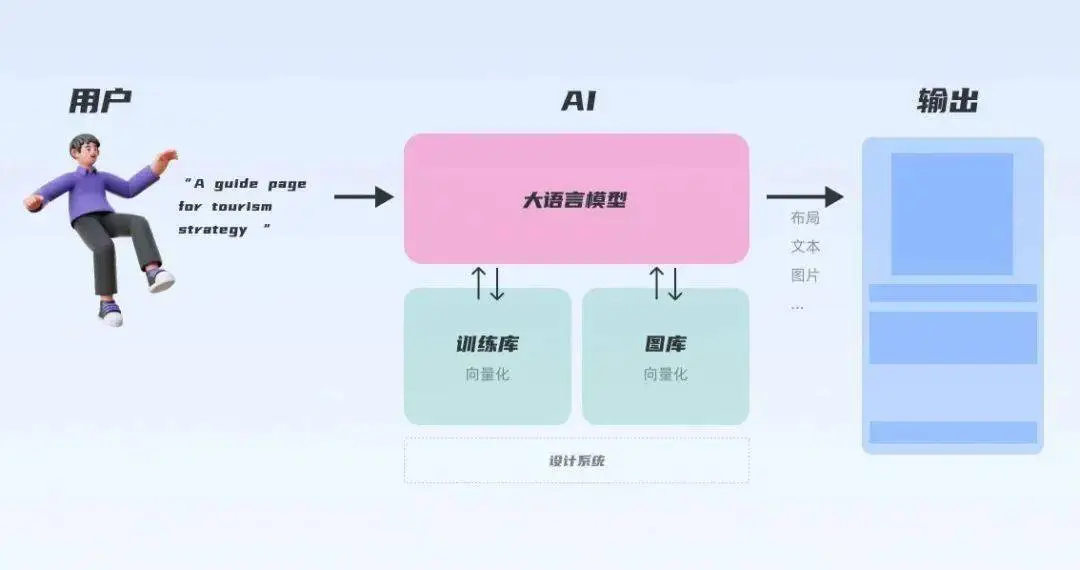

构建AI应用的变化

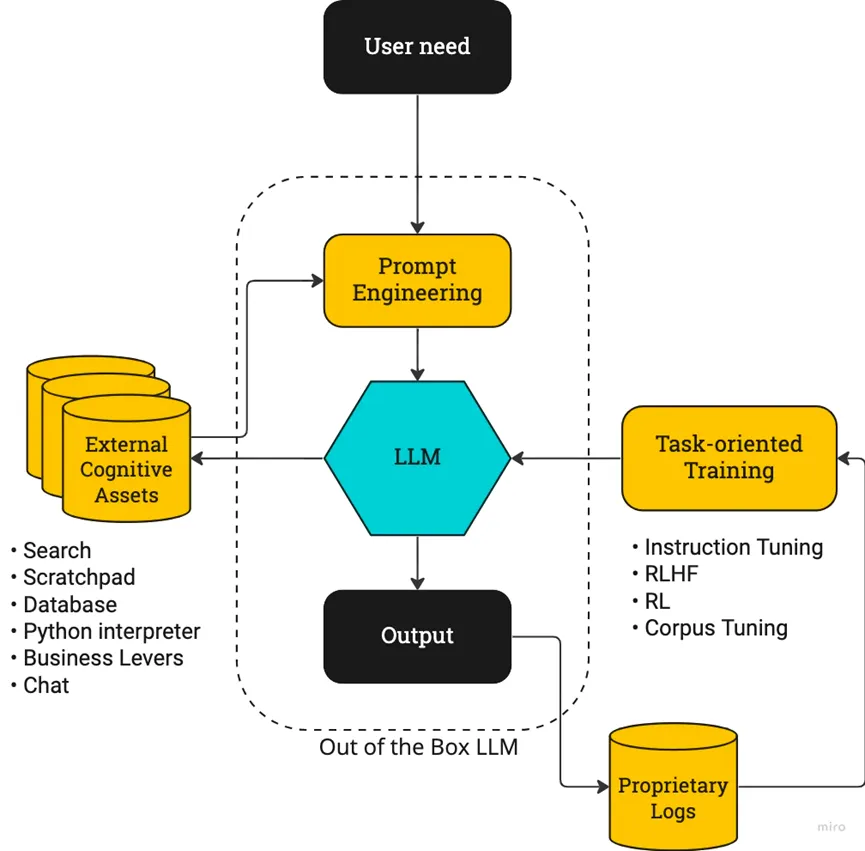

构建 AI 应用远不只是调用模型 API,还有很多问题需要解决:

- 大模型只有“脑子”没有“手臂”,无法在外部世界行动:搜索网页、调用 API 还是查找数据库,这些能力都无法被 大模型的 API 提供;

- 它的“脑子”也不完美,OpenAI 的训练数据截止至 2021 年,并且没有任何企业和个人的私有数据,这让模型只能根据自己的“记忆”回答问题,并且经常给出与事实相悖的答案(幻觉)。一个解决方法是在 Prompt 中将知识告诉模型,但是这往往受限于 token 数量,在 GPT-4 之前一般是 4000 个字的限制。

- 私域的知识如何使用,意大利数据保护局Garante以涉嫌违反隐私规则为由,暂时禁止了ChatGPT。自三星电子允许部分半导体业务员工使用ChatGPT开始,短短20天有三起机密资料外泄事件。

- 黑盒大模型无法更新知识和修改,大模型本身对外是一个黑盒的模型,无法对部分数据进行修改或者删除,如果需要更新知识和修改大模型的知识需要重新训练,成本巨大。

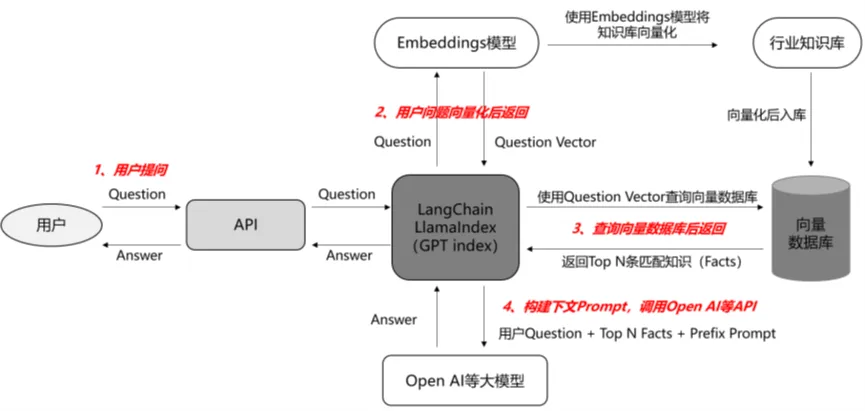

当前最需要解决的是如何将大模型应用到各行各业的私域知识,这个需求带火了向量数据库这个领域,一夜之间所有的数据库都变成了向量数据库(优势熟悉的配方)。

Step 1——语料库准备:

将与行业相关的大量知识或语料上传至向量数据库,储存为向量化文本;

Step 2 ——问题输入:

输入的问题被Embedding引擎变成带有向量的提问;

Step 3 ——向量搜索:

向量化问题进入提前准备好的向量数据库中,通过向量搜索引擎计算向量相似度,匹配出Top N条语义最相关的Facts(向量数据库是模糊匹配,输出的是概率上最近似的答案)

Step 4 ——Prompt优化:

输出的Top N条Facts,和用户的问题一起作为prompt输入给模型。

Step 5、结果返回:

有记忆交互下得到的生成内容更精准且缓解了幻觉问题。有记忆交互:当模型需要记忆大量的聊天记录或行业知识库时,可将其储存在向量数据库中,后续在提问时将问题向量化,送入向量数据库中匹配相似的语料作为prompt,向量数据库通过提供记忆能力使prompt更精简和精准,从而使返回结果更精准。

大模型的向量数据库市场

时间回转到今年的Q1季度,2023.3.21,NVIDIA创始人兼CEO黄仁勋在2023 GPU技术大会(2023 GTC)上发表演讲。并表示今年将推出新的向量数据库RAFT。RAFT在此基础上,还具有加速索引、数据加载和近邻检索等功能。黄仁勋认为:“对于自研大型语言模型的组织而言,向量数据库至关重要。”他总结:“初创公司竞相构建具有颠覆性的产品和商业模式,而老牌公司则在寻求应对之法——生成式AI引发了全球企业制定AI战略的紧迫感。”

在OpenAI ChatGPT plugins 发布的官方文章中,Milvus 和 Zilliz Cloud 同时作为首批插件合作伙伴被提及成为唯一一家开源项目与商业化云产品同时入选的向量数据库公司。而在近一个月之内,向量数据库迎来了融资潮。Qdrant 、Chroma 和 Weaviate 纷纷获得融资;而 Pinecone 也正式官宣了新的 1 亿美金 B 轮融资,估值达到了 7.5 亿美元。

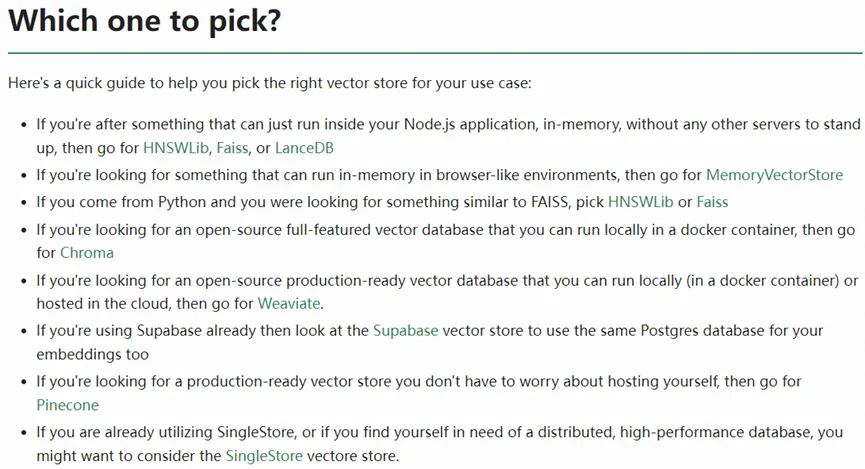

从langchain的推荐可以看出,现在这个市场还是一个诸侯混战,百花齐放的市场,到底该把赌注押宝到哪个生态才是重中之重。

再回头看中国区这个大市场,基础模型一定是以云厂商提供,或者少量大模型云下私有化部署,如何适配其实显而易见:配套自己的云上大模型,其次,适配一些国家科研机构的大模型线下输出。