OpenAI o1 的发布,再次给 AI 领域带来了一场地震。

o1 能像人类一样「思考」复杂问题,拥有优秀的通用推理能力。在未经专门训练的情况下,o1 能够直接拿下数学奥赛金牌,甚至能在博士级别的科学问答环节上超越人类专家。

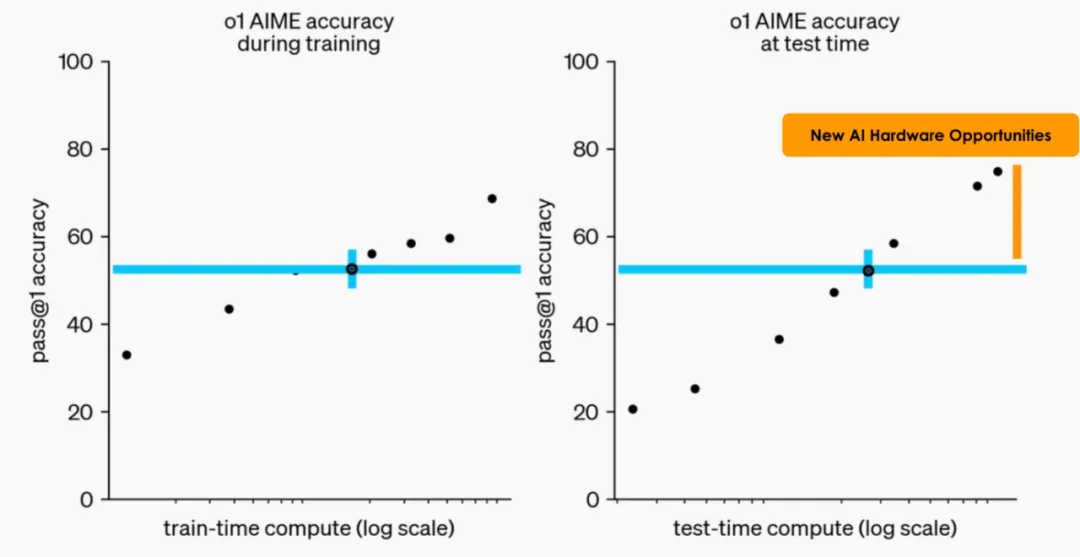

在性能跃升之外,更重要的是,它揭示了大模型进化范式的转变:通过更多的强化学习(训练时计算)和更多的推理(Test-Time 计算),模型可以获得更强大的性能。

这又一次让我们想起 Richard Sutton 在《The Bitter Lesson》中所说的,利用计算能力的一般方法最终是最有效的方法。这类方法会随着算力的增加而继续扩展,搜索和学习似乎正是两种以此方式随意扩展的方法。连山姆・奥特曼也坦言,在未来的一段时间里,新范式进化的曲线会非常陡峭。

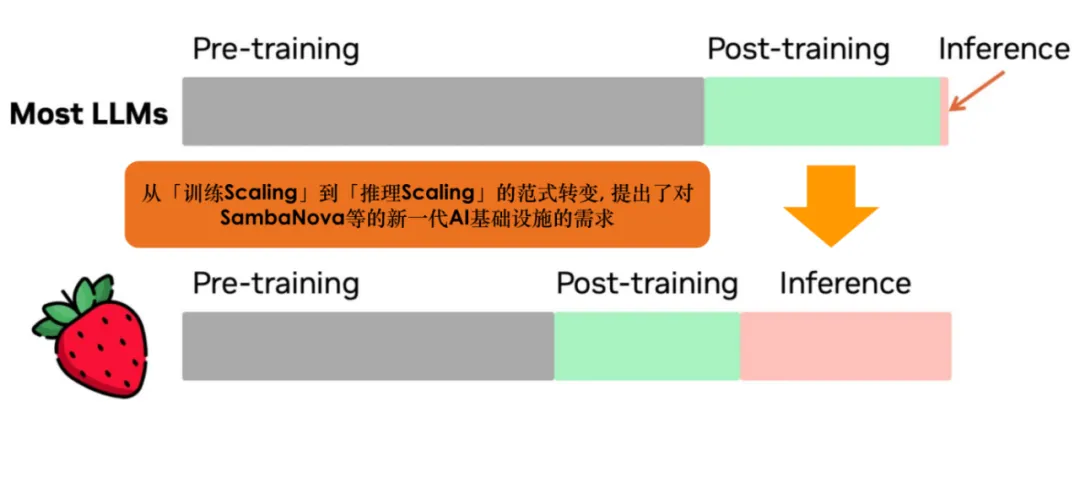

从「训练 Scaling」到「推理 Scaling」的范式转变,也引发了关于计算资源分配和硬件选择的重新思考。

领域内的研究者和从业者认识到,一方面,更多的计算资源应该投入到推理阶段,另一方面,优化硬件配置以提升大模型推理的效率将是下一阶段的攻关重点。而大模型要进行推理 Scaling,实际上比训练 Scaling 对芯片并行处理能力的要求更高。

GPU 最初设计用于图形渲染,由于其并行处理能力,过去数年一直是以海量数据集训练大模型的热门选择。虽然 GPU 非常适合实现神经网络的训练工作,但在全新的范式下,由于其在延迟、功耗等方面表现不佳, 并不是进行大规模推理的最好选择。

在 GPU 之外,什么是大模型推理的更好选择?现在的 AI 芯片有各种流派:ASIC、FPGA、DSP、Neuromorphic Chip,以及大量 DSA (Domain-specific architectures)芯片。其中,以 SambaNova RDU(Reconfigurable Dataflow Unit)为代表的动态可重构数据流(Dataflow)架构的芯片,能够通过并行处理和高效数据移动来优化性能和效率,近年越来越被认为是一个重要的发展方向。

数倍于 GPU 推理性能

来自 SambaNova 最新一代 RDU SN40L

近日的芯片盛会 Hot Chips 上,围绕大模型的议题比以往任何一届都更加活跃。SambaNova 的最新一代 RDU 产品 SN40L 也在这场大会上引发持续讨论。大家也充分了解到,Sambanova 如何实现大模型的快速推理以及提供 GPU 之外的更优方案。

我们知道,大模型在推理时会逐步生成输出序列的 Token,每生成每一个 token 都会需要把模型的参数从 HBM(High Bandwidth Memory)搬运到片上进行计算。对于利用 HBM 来推理的芯片来说,HBM 的利用率是推理速度的关键,越快从内存中访问数据,就越能缩短处理时间。

SambaNova 的 RDU 既有 GPU 10 倍以上的片上分布 SRAM,也有适用于需要快速数据传输的大规模计算任务的 HBM。其架构可以自动做到极致的算子融合,达到 90% 以上的 HBM 利用率,使得 RDU 对 GPU 有了 2-4 倍的性能优势。

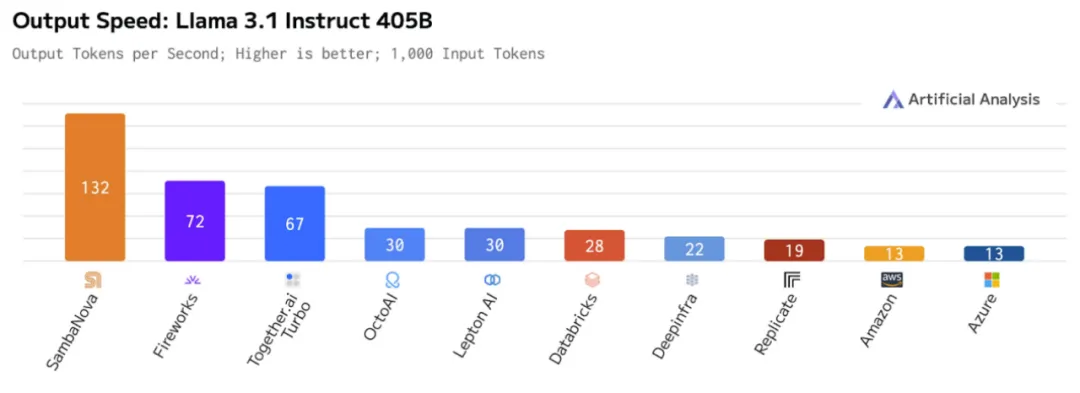

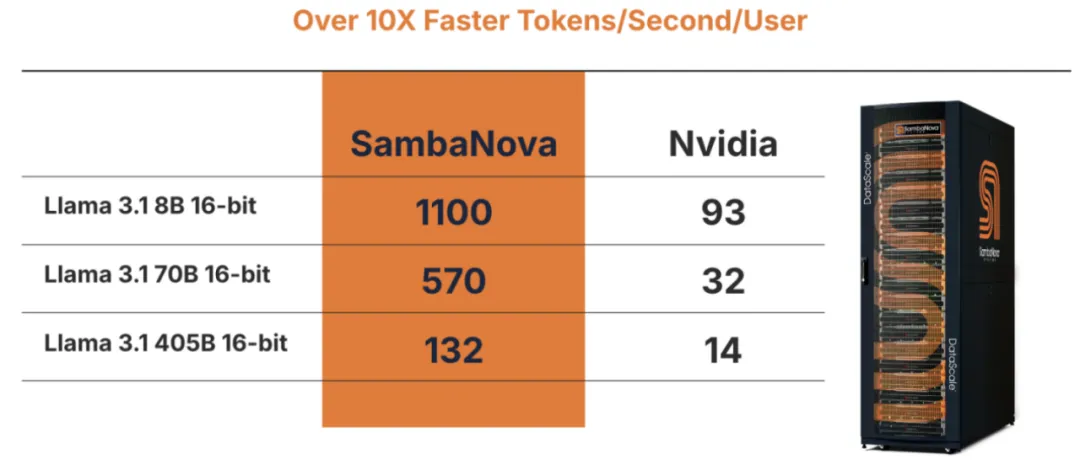

当前的 AI 推理平台中,SambaNova 是唯一能在 Llama 3.1 405B 上提供每秒超过 100 个 Token 推理速度的平台。

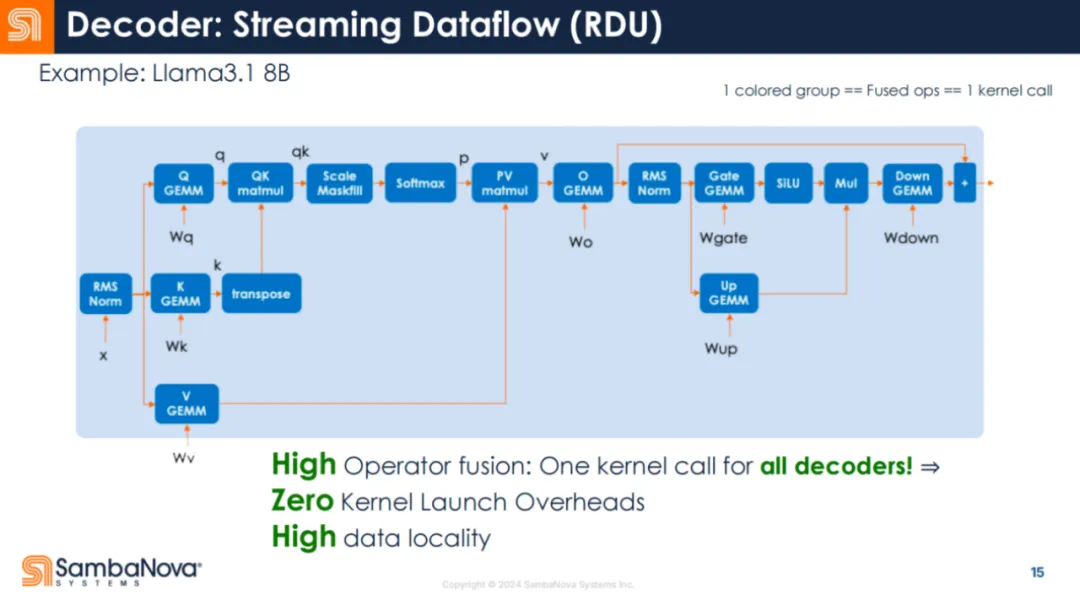

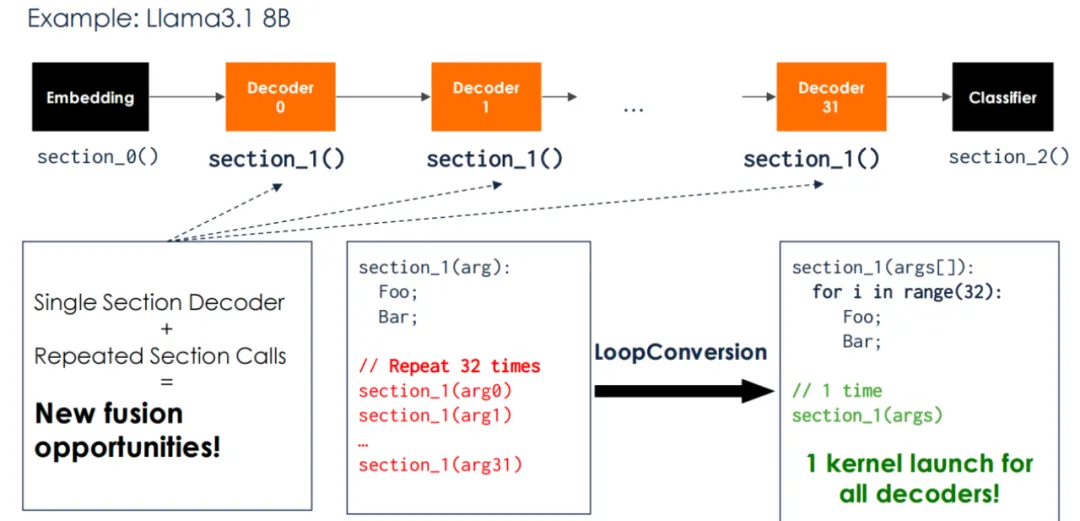

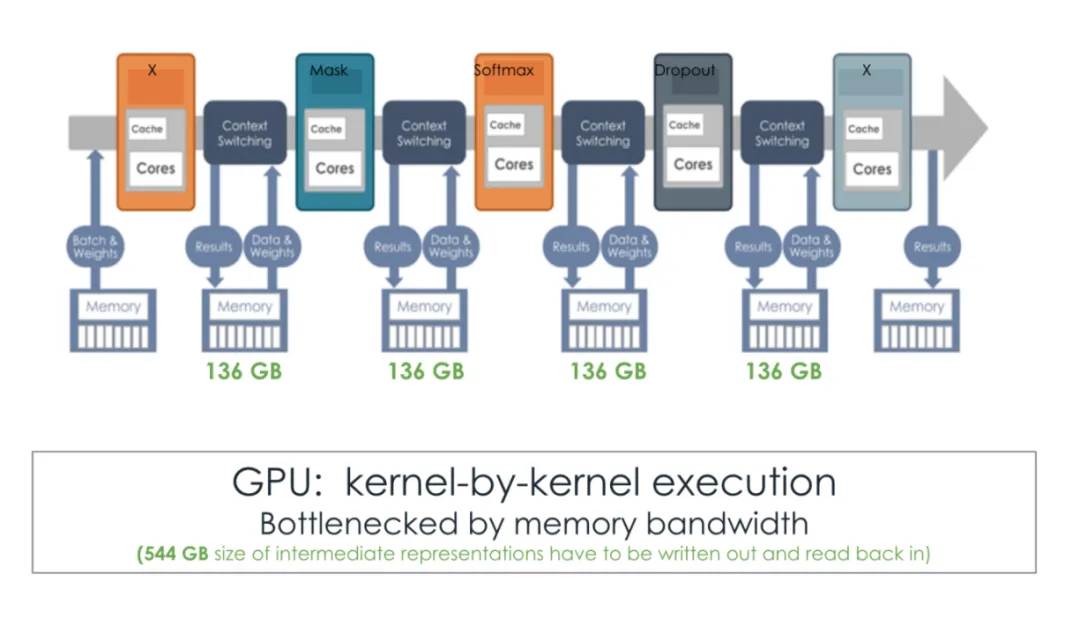

如下图所示,每个框都是一个算子。一般来说,多个算子会同时运行,并将数据保存在芯片上以重复使用。但在 RDU 中,整个解码器是一个 Kernel 调用。

这意味着调用开销会显著减少,芯片对数据进行有效工作的时间则增加了。

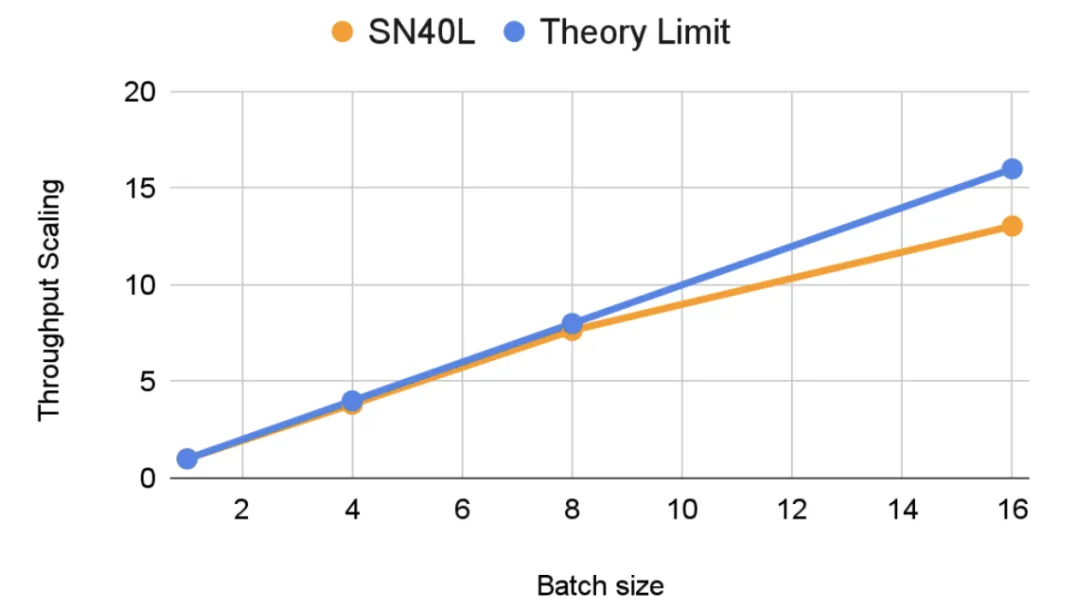

另外一方面,极致的算子融合使 RDU 能够达到类似 GPU 的批处理能力。GPU 有很好的批处理能力(比如从 BS1 到 BS16),可将吞吐量提高 12 到 15 倍。比如在上图中,当 decoder0 在进行批处理运算时,可以同时从 HBM 读取 decoder1 的参数。

SambaNova 的研究者观察到,SN40L 在 Llama 3.1 70B 上可以实现较好的吞吐量 Scaling。

为什么业内普遍看好数据流架构?

SN40L 让我们重新认识了 SambaNova RDU 相对于主流 GPU 的速度优势,而数据流架构的价值也在被越来越多的从业者重新发现。

与 GPU 本质上不同的是,数据流架构通过数据流动来驱动计算过程,而非常规指令流动。在该架构中,程序被表示为一个 Dataflow Graph,其中节点代表计算操作,边代表数据依赖关系。每个节点在其所有输入数据准备好后立即执行,并将结果传递给下游节点。这种架构天然支持并行处理,多个独立的计算操作可以同时执行,从而显著提高了计算性能。

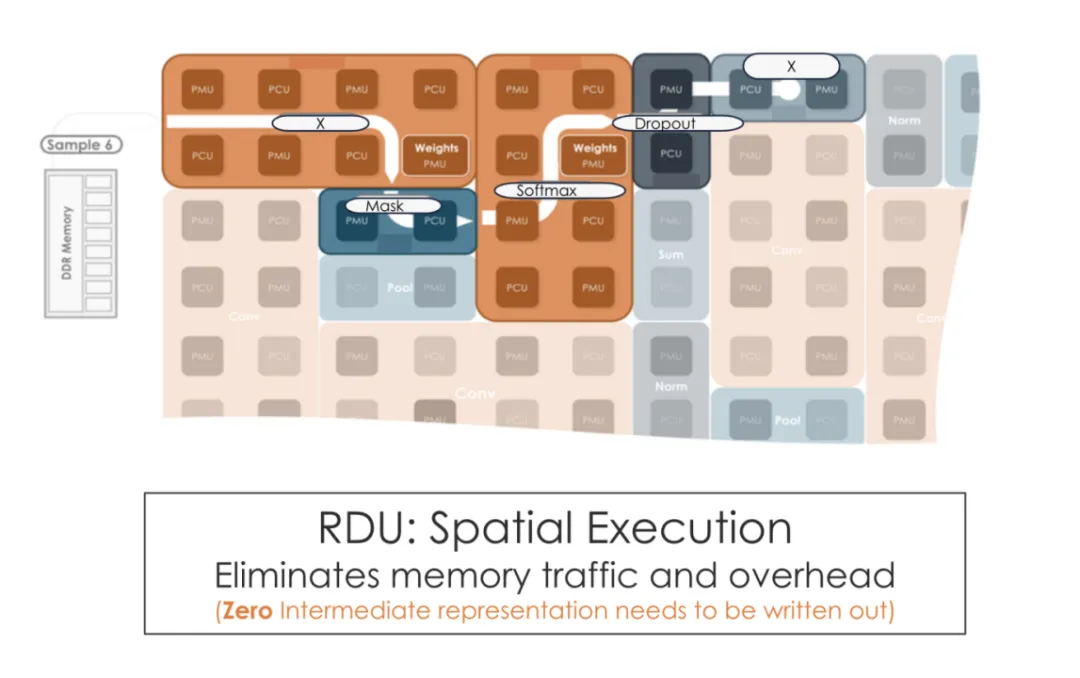

从下图可以看到,SambaNova RDU 的片上空间数据流可以做自动的算子融合 (kernel fusion),与 GPU 的传统 kernel-by-kernel 运行相比,明显消除了大量的内存流量和开销。

近年来,GPU 厂商明显意识到非 Dataflow 架构的短板,并为 GPU 部分引入一些 Dataflow 的功能。例如,从 H100 开始,GPU 开始加入分布式共享内存(Distributed Shared Memory) ,也加入了新的张量内存加速器 (Tensor Memory Accelerator) 单元,使其某种程度上模仿了片上空间流水线运行的「范式」。

但这种程度的改动远远不够,GPU 追赶的速度恐怕已经跟不上 AI 领域推理需求的暴涨。毕竟 GPU 最初不是专门为 AI 而设计的,厂商们很难在不影响主营业务的情况下对基本架构做完全的重新设计,即使增加了上述的「修补」工作,也无法完全采用高效的数据流架构,这从根本上限制了 GPU 推理的提速。

当前的几家主流 AI 芯片 Startup,都选择了数据流架构。其中来自 SambaNova 的 RDU 展现出了独特优势,也被视为 GPU 的最有力竞争者 。与英伟达相比,Sambanova 最新 Llama 3.1 模型上生成 token 的性能快了 10 倍以上,并且通过 cloud.sambanova.ai 公开供开发人员使用。

RDU 能够实现更快的推理速率,更利于大模型的部署。连人工智能专家吴恩达也惊叹 SambaNova 的推理速率:

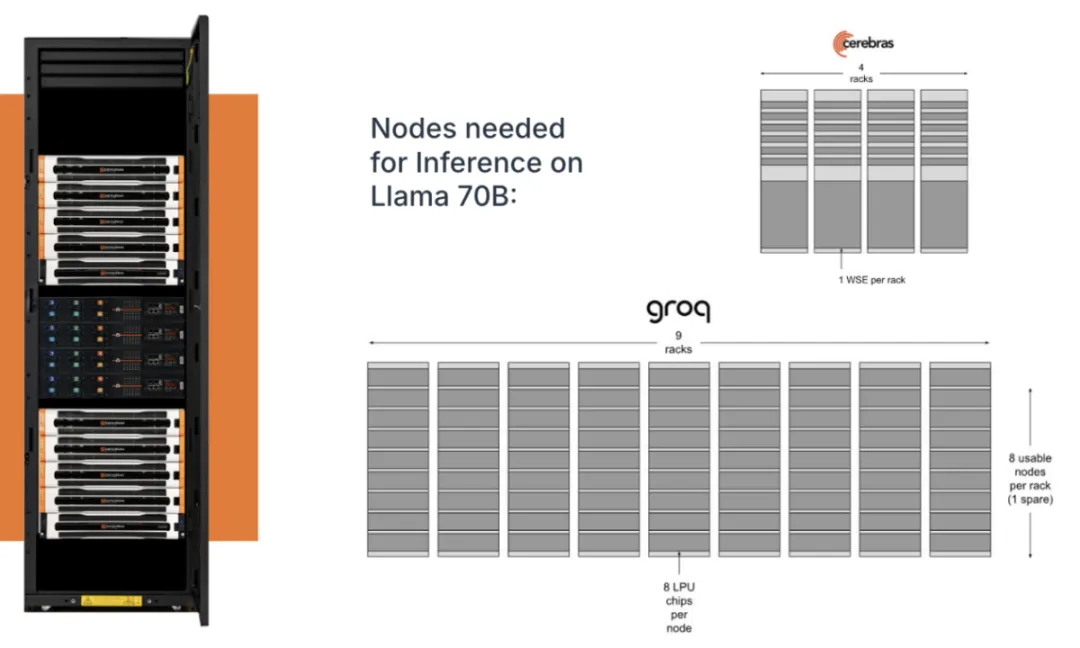

从最基础的成本上说,由于 Sambanova 的数据流架构 RDU 不仅拥有大的片上 SRAM,同时拥有 HBM 层面的优势,相比于其他的几个单纯依靠片上 SRAM 的数据流企业,用户需要支持大型语言模型的基础设施更少。例如,想在 Llama 70B 上推理,对于有些 AI 芯片来说需要五百多个芯片,或者相当于三百多个芯片的 4 个 wafer ,而 SambaNova 只需要 拥有 16 个芯片的 1 个机架。(https://sambanova.ai/blog/sn40l-chip-best-inference-solution)

更进一步说,RDU 所带来推理速度提升的意义不只是体现在效率上,更能体现在质量上,也体现对 AGI 探索的加速上。

基于 OpenAI o1 带来的推理 Scaling Law 的启发,人们意识到,在推理端,更多的算力同样会带来更强的智能。因为在同一时间单位内,推理速度越快,就能实现越复杂的推理,就能解锁越多复杂任务,大模型应用的天花板就越高。

这意味着,如果我们想更快实现 AGI,我们本质上最需要建设足够的基础设施并持续降低计算成本。与此同时,计算资源还要更多地向推理侧增加。但在目前的条件下,算力往往是大模型厂商们拓展技术上限的头道难关,即使对于实力雄厚的玩家们也一样。

OpenAI 在发布 o1 时似乎就遇到了这个问题。机器学习研究员 Nathan Lambert 在博客《逆向工程 OpenAI 的 o1》中写到,在已发布的基准测试分数和曲线图中,o1 preview 并非是能力最强的,但 OpenAI 并未立即发布最强版本的 o1 (详情见下图),原因是「最强配置」过于昂贵,他们没有对应的基础设施支持大规模的部署。

但推理算力需求并非天堑不可跨越。在 o1 发布后不久,SambaNova 便在 Hugging Face 上发布了 Llama 3.1 Instruct-O1 演示 。这个项目由 SambaNova 的 SN40L RDU 提供算力支持,用户可与 LLama 3.1 405B-instruct 模型进行实时对话,体验风驰电掣般类 o1 的推理过程。

项目地址:https://huggingface.co/spaces/sambanovasystems/Llama3.1-Instruct-O1

这意味着,在强大算力的支持下,开源大模型推理能力会不断提升,复现完整 o1 甚至触达更高级的智能是指日可待的。

一个新的时代正在开启,当大模型 Scaling Law 的重心从预训练向后训练和推理侧转移,厂商们在算力层面的分配与设计也会更深刻影响大模型领域的竞争格局。而对于 SambaNova 或其他以提供算力和计算基础设施见长的公司来说,接下来会迎来前所未有的机遇。

英伟达的挑战者

在 AI 芯片赛道的诸多初创公司中,SambaNova 是目前估值最高的一家独角兽。

SambaNova 成立于 2017 年,拥有三位资深的联合创始人:Rodrigo Liang、Kunle Olukotun、Christopher Ré。CEO Rodrigo Liang 毕业于斯坦福大学,在创立 SambaNova 之前,Rodrigo 领导了甲骨文和 Sun Microsystems 的工程团队,负责 SPARC 处理器和 ASIC 的开发。Kunle Olukotun 和 Christopher Ré 都来自斯坦福大学。

从左到右分别为 Kunle Olukotun、Rodrigo Liang、Christopher Ré。

此外,被誉为「芯片风险投资教父」的陈立武,自创立之初便作为创始投资人和董事会主席加入 SambaNova,并于 2024 年 5 月出任执行主席,以加速和扩大公司的发展。自 1987 年创立华登国际(Walden International)以来,陈立武投资了许多公司(包括 SambaNova),在推动半导体创新和发展方面发挥了重要作用。

在深度学习引发的第三次人工智能浪潮中,算力对人工智能发展的决定作用已成共识。一系列极具影响力的 AI 研究,如 AlexNet、ResNet 和 Transformer 都是在 GPU 上实现和评估的,这也让英伟达十年来始终处于 AI 硬件市场的主导地位。

不过,时代可能真要变了。正如 Transformer 会迎来新的挑战者,比如 Mamba;英伟达和 GPU 也会迎来下一阶段的强劲竞争者,比如 SambaNova 的 RDU。

o1 发布之后,AI 推理市场正处于爆炸式增长的新起点。从 SambaNova 的 RDU 开始,人工智能领域可能正在翻开全新的一页。