编辑 | 言征

出品 | 51CTO技术栈(微信号:blog51cto)

前沿的AI独角兽公司们正在花费所有精力使 LLM 更擅长推理。然而苹果最近却给他们泼了盆冷水。

近期,苹果公司的一个六人研究团队最近发表了一篇题为《了解大型语言模型中数学推理的局限性》的论文,论文中各种基准测试,十分详实。不过最后的结论基本上就是想证明:当前的 LLM 无法推理。

图片

图片

“当前的 LLM 无法执行真正的逻辑推理;他们从训练数据中复制推理步骤,“该论文中写道,其中还包括 OpenAI 的 GPT-4o 等 LLM,甚至是备受吹捧的”思考和推理“LLM,o1。该研究还对一系列其他模型进行了研究,例如 Llama、Phi、Gemma 和 Mistral。

该论文的资深作者 Mehrdad Farajtabar 在 X 上发帖解释了该团队是如何得出结论的。据他介绍,LLM 只是遵循复杂的模式,即使是小于 30 亿个参数的模型也达到了只有更大的模型才能更早达到的基准,特别是 OpenAI 三年前发布的 GSM8K 分数。

Mehrdad10月10日在帖子中表示:

图片

图片

大型语言模型 (LLM) 真的能推理吗?或者它们只是复杂的模式匹配器?

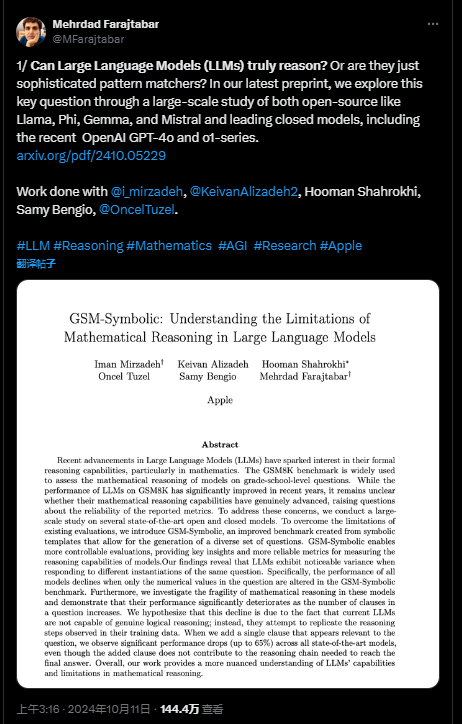

研究人员引入了 GSM-Symbolic,这是一种在 LLM 中测试数学推理的新工具,因为 GSM8K 不够准确,因此对于测试 LLM 的推理能力不可靠。

图片

图片

一、4大证据,证明大模型不具备形式推理能力

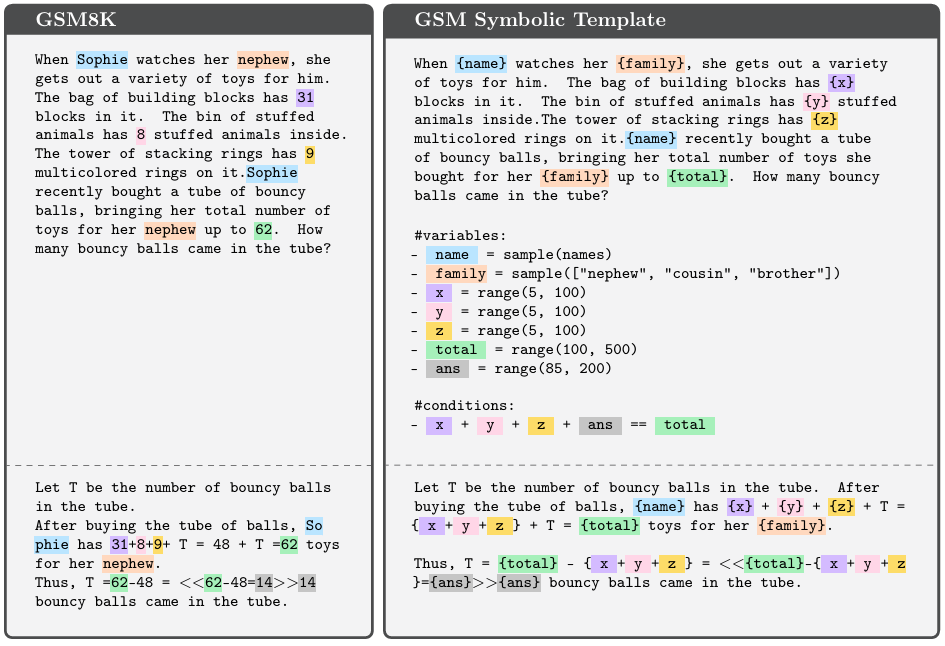

三年前,OpenAI 发布了 GSM8K 数据集(目前常用的一种小学数学推理基准数据集),测试 GPT-3(175B参数)在数学题上的表现,那时 GPT-3 的得分仅为 35%。如今,拥有约 30 亿参数的模型已能够在 GSM8K 测试中取得超过 85% 的得分,参数更大的模型甚至超过 95%。

图片

图片

然而,随着准确率的提升,疑问也随之而来:这些模型的推理能力是否真的进步了?它们的表现是否真的体现了逻辑或符号推理能力,抑或是简单的模式识别,数据污染,甚至过拟合的结果?

为进一步探索这一问题,研究团队此发了 GSM-Symbolic,用于测试大语言模型在数学推理中的极限。GSM-Symbolic 基于 GSM8K 数据集,通过符号模板生成多样化的问题实例,允许更可控的实验设计。

为了更清晰地观察模型在面对这些变体问题时的表现,他们生成了 50 个独特的 GSM-Symbolic 集合,这些问题与 GSM8K 问题类似,但更改了其中的数值和名称。

基于 GSM-Symbolic,他们从 5 个方面说明了为何他们认为大语言模型不具备形式推理能力。

1.GSM8K 的测试结果并不可靠

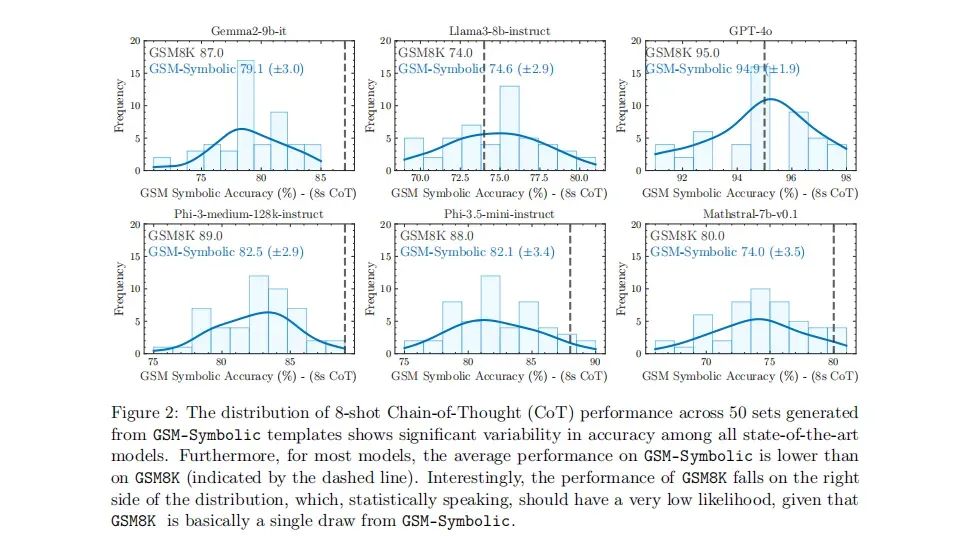

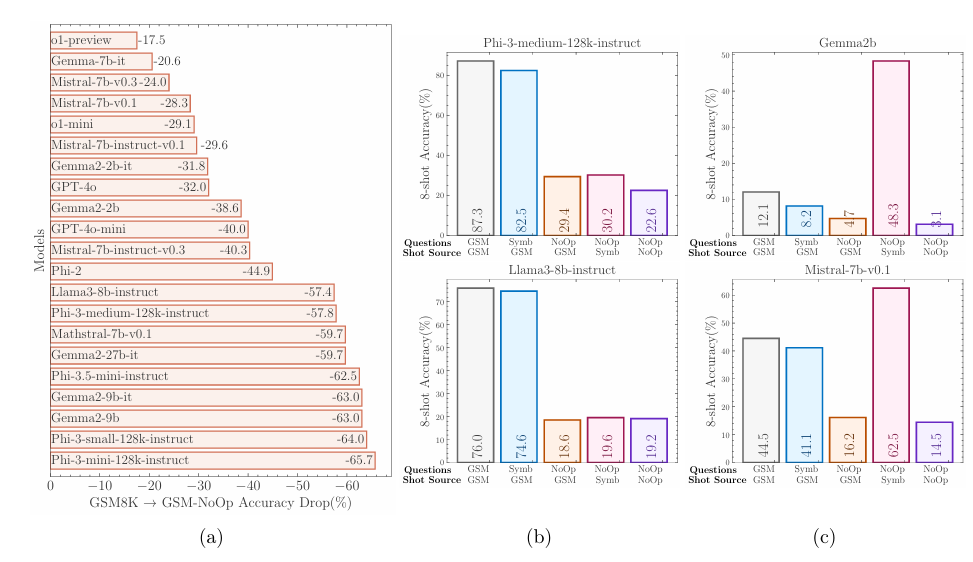

通过对多个开源模型(如 Llama 8B、Phi-3)和闭源模型(如 GPT-4o 和 o1 系列)的大规模评估,他们发现模型在 GSM8K 上的表现存在显著波动。

例如,Llama 8B 的准确率在 70%-80% 之间波动,而 Phi-3 的表现则在 75%-90% 之间浮动。这也表明,模型在处理相似问题时表现并不稳定,GSM8K 上的高分并不能证明它们具备真正的推理能力。

图片

图片

图|由 GSM-Symbolic 模板生成的 50 套 8-shot 思想链(CoT)性能分布,显示了所有 SOTA 模型之间准确性的显著差异性。对于大多数模型来说,GSM-Symbolic 的平均性能低于 GSM8K(图中由虚线表示)。有趣的是,GSM8K 的性能落在分布的右侧,从统计学上讲,这仅有非常低的可能性,因为 GSM8K 基本上只是 GSM-Symbolic 的一次单一抽样。

2.大模型的数学推理能力相当脆弱敏感

团队观察到由相同模板生成的不同集合之间存在较大的性能差异,并且与原始GSM8K准确率相比性能有所下降。这表明语言模型所展现的推理过程可能并不正式,因此容易受到变化的影响。一种解释是,这些模型试图进行一种分布内模式匹配,将给定的问题和解题步骤与训练数据中看到的类似问题和步骤进行对齐。由于此过程不涉及正式推理,因此可能导致同一问题的不同实例之间存在较大差异。

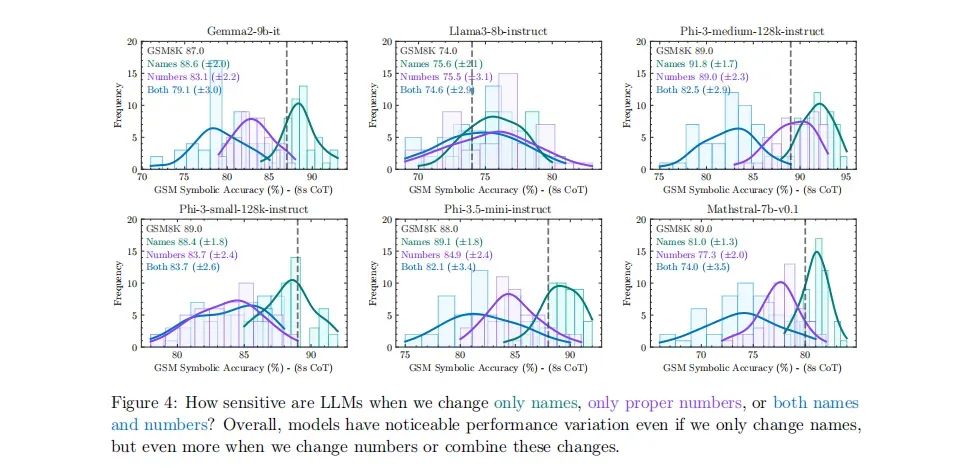

具体测试表现为:对名称和数字变动的敏感性研究还发现,当前的大语言模型对问题中的专有名称(如人名、食物、物品)的变化仍然很敏感,当数字发生变化时,大语言模型就会更加敏感。例如,仅仅改变问题中的名字,就可能导致模型的准确率变化高达 10%。如果将这种情况类比到小学数学测试中,仅仅因为改变了人名而导致分数下降 10% ,是非常不可思议的。

图片

图片

图|当只更改名称、专有编号或同时更改名称和编号时,大语言模型的敏感性如何?总体而言,即使只更改名称,模型也有明显的性能变化,但当更改编号或合并这些变化时,性能差异更大。问题难度的增加导致表现急剧下降。

3.扩展问题难度,性能分布波动剧烈

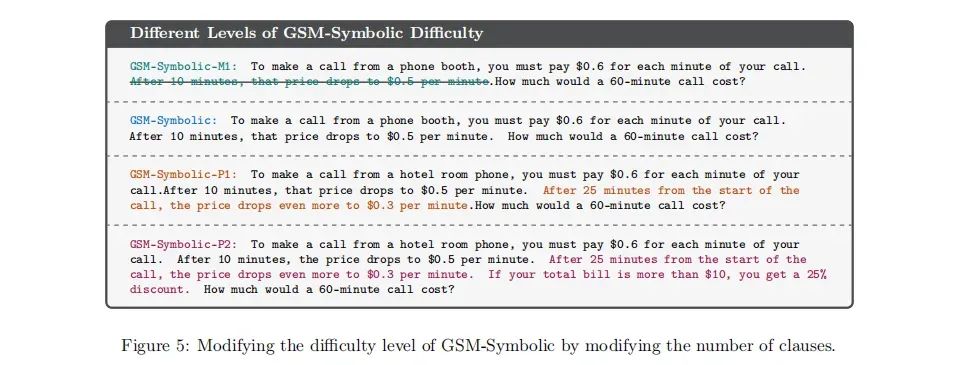

研究团队通过引入三种新的 GSM-Symbolic 变体(GSM-M1、GSM-P1、GSM-P2),通过删除一个分句(GSM-M1)、增加一个分句(GSM-P1)或增加两个分句(GSM-P2),来调整问题难度。

图|通过修改条款数量来修改 GSM-Symbolic 的难度级别

图|通过修改条款数量来修改 GSM-Symbolic 的难度级别

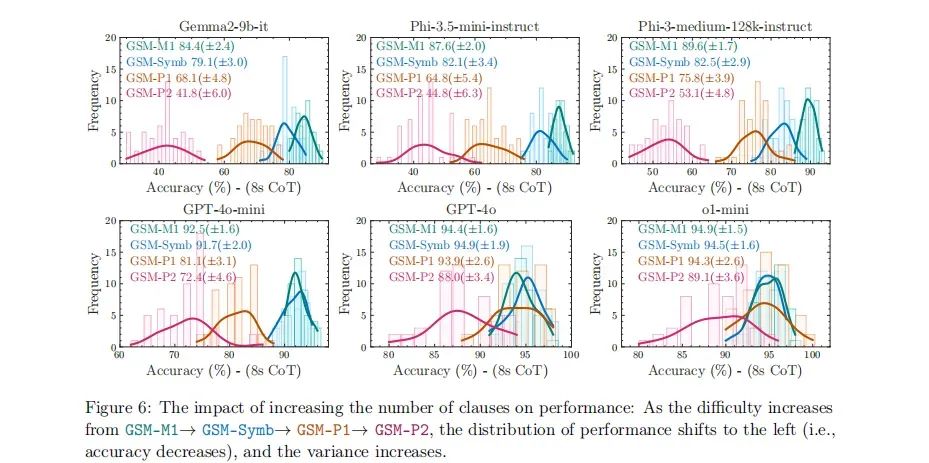

图|增加条款数量对性能的影响:随着GSM-M1→GSM-Symb→GSM-P1→GSM-P2的难度增加,性能分布向左移动(即准确性下降),方差增加。

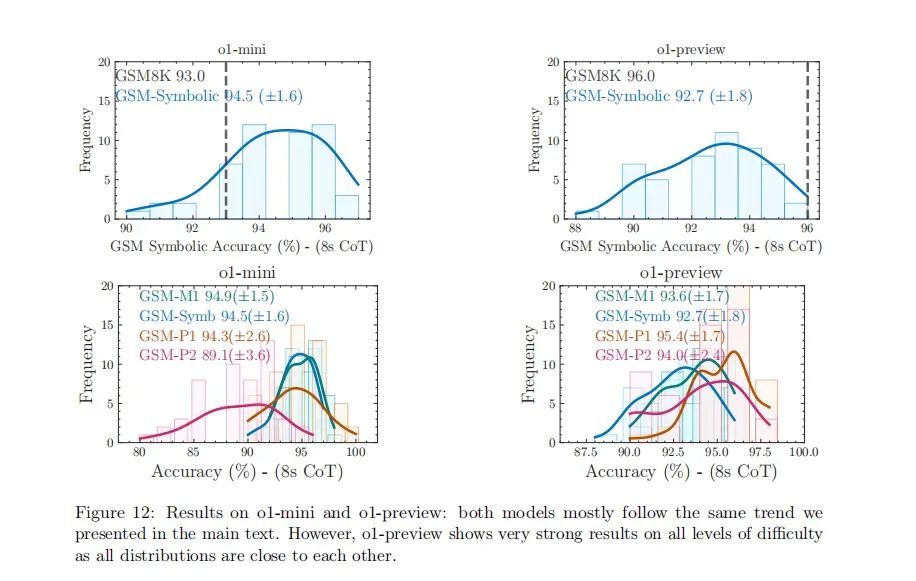

结果发现,随着问题难度的增加(GSM-M1 → GSM-Symb → GSM-P1 → GSM-P2),模型的表现不仅下降显著,且表现波动也变得更加剧烈。面对更复杂的问题时,模型的推理能力变得更加不可靠。

4.大模型没有真正理解数学概念

研究中还添加无关子句,实验表明对LLM推理性能的巨大影响,研究团队设计了 GSM_NoOp 实验,在原有问题中添加一个似乎相关但实际无关的子句 (hence "no-op")。

结果显示,所有模型的表现都显著下降,包括性能较好的 o1 模型在内。这种现象进一步说明,模型并没有真正理解数学概念,而是通过模式匹配来得出答案。

图|在 GSM-NoOp 上,模型的性能明显下降,较新的模型比旧的模型下降更大。

图|在 GSM-NoOp 上,模型的性能明显下降,较新的模型比旧的模型下降更大。

(a) 在GSM-NoOp上,模型的性能显著下降,其中较新的模型比旧模型下降得更多。(b) GSM-Symbolic上的性能与GSM8K非常接近。然而,在GSM-NoOp上,即使使用完全相同问题的变体作为示例(NoOp-Symb),或者使用包含No-Op操作的不同GSM-NoOp问题的不同问题作为示例(NoOp-NoOp),性能显著下降的情况也无法恢复。(c) 值得注意的是,一些在GSM8K和GSM-Symbolic上表现明显差于(b)中模型的,在NoOp-Symb上却表现出了更好的性能。

5.扩展规模和计算能力并不能解决根本问题

此外,他们还探讨了通过扩大数据、模型规模或计算能力是否能够解决推理能力不足的问题。Mehrdad Farajtabar 表示,尽管 OpenAI 的 o1 系列在性能上有一定改善,但它们也会出现这样的愚蠢错误,要么是它不明白“现在”是什么意思,要么是它不明白“去年”是什么意思,还有一种更可能的解释是,更大的训练数据具有这种模式,所以它又沿用了这种模式。

图片

图片

图|o1-mini 和 o1-preview 的结果:这两个模型大多遵循我们在正文中介绍的相同趋势。然而,o1-preview 在所有难度级别上都显示出非常强大的结果,因为所有分布都彼此接近。

作者认为,理解大语言模型的真正推理能力对于在现实世界中的应用至关重要,尤其是在 AI 安全、教育、医疗保健和决策系统等对准确性和一致性要求极高的领域。

研究结果表明,当前大语言模型的表现,更像是高级的模式匹配器,而非具备形式推理能力的系统。为了在这些领域安全、可靠地部署大语言模型,开发更为鲁棒和适应性强的评估方法显得尤为重要。

二、不过,OpenAI 的o1模型的推理的确强劲

令人惊讶的是,根据研究人员的说法,在这个基准测试中,OpenAI 的 o1 表现出“在各种推理和基于知识的基准测试中的强劲表现”,但当研究人员引入 GSM-NoOp 实验时,能力下降了 30%,该实验涉及向问题添加不相关的信息。PS:上个月OpenAI推出o1模型时也曾表示,提示词宜简单而非复杂。

三、科技圈又乱了:大模型压根不会推理,o1也不行

“总体而言,我们在语言模型中没有发现形式推理的证据……它们的行为更好地解释为复杂的模式匹配——实际上非常脆弱,以至于改变名称可能会使结果变化约10%!”Mehrdad 进一步补充道,扩展这些模型只会得到“更好的模式机器”,而不是“更好的推理器”。

首先,LLM更多是根据分散注意力的材料来进行“推理”,所以这种失败,并不是什么新鲜事。斯坦福大学的 Robin Jia Percy Liang 早在 2017 年进行了一项类似的研究,结果相似。

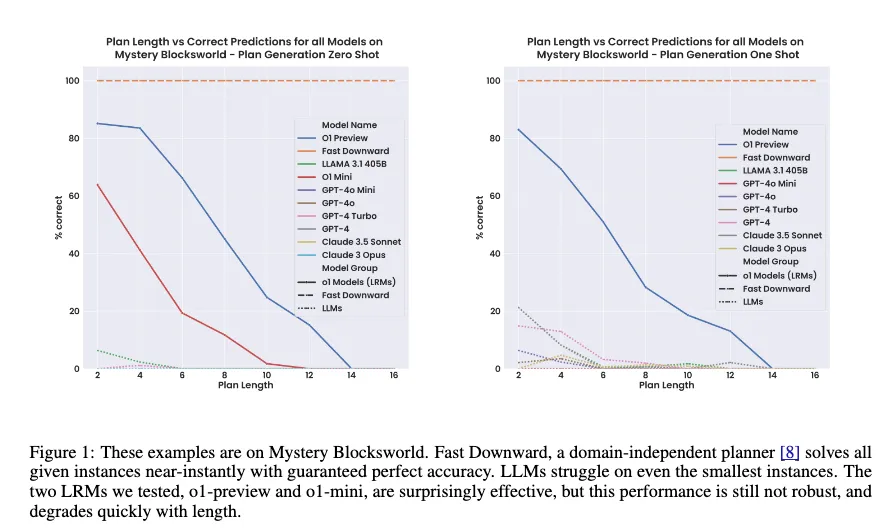

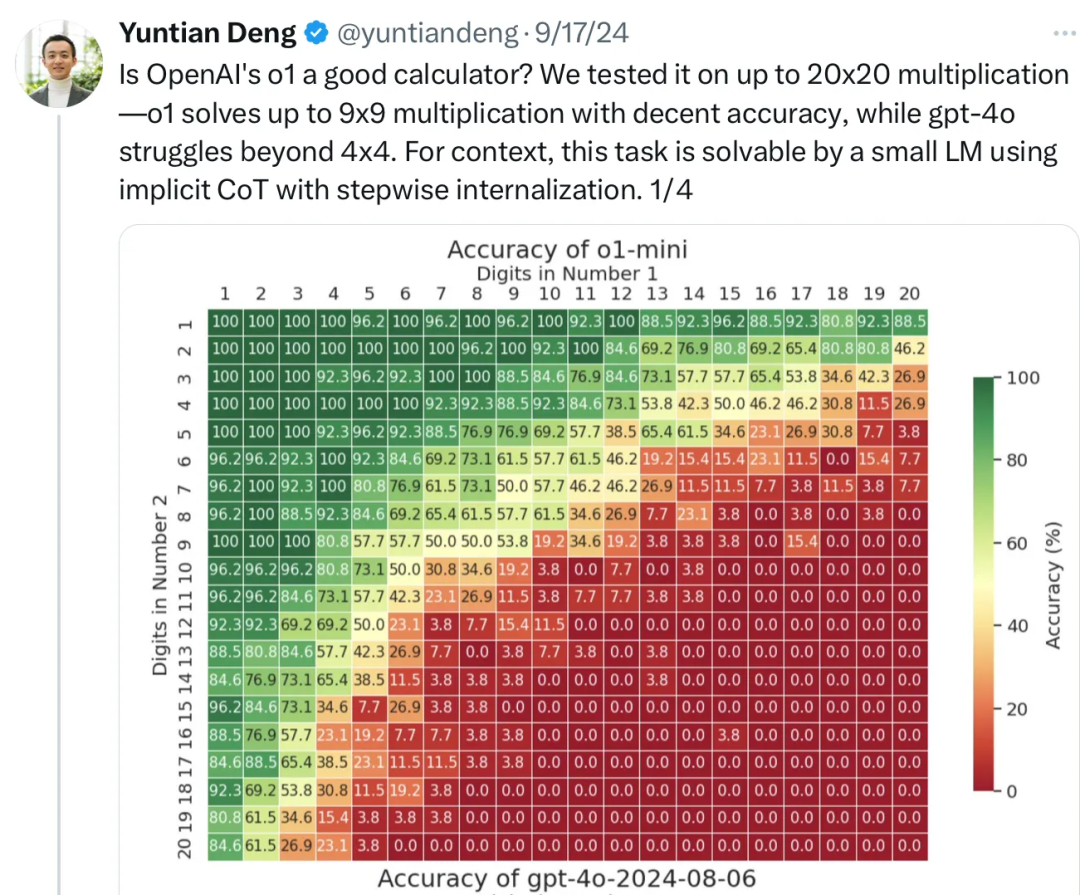

其次,LLM 中缺乏足够抽象、正式的推理的另一个表现是,大模型往往在解决小问题上的性能还可以,但随着问题变大,性能很快就会下降,甚至分崩离析,正如7月 Subbarao Kambhapati 的团队最近对 GPT o1 的分析:

图片

图片

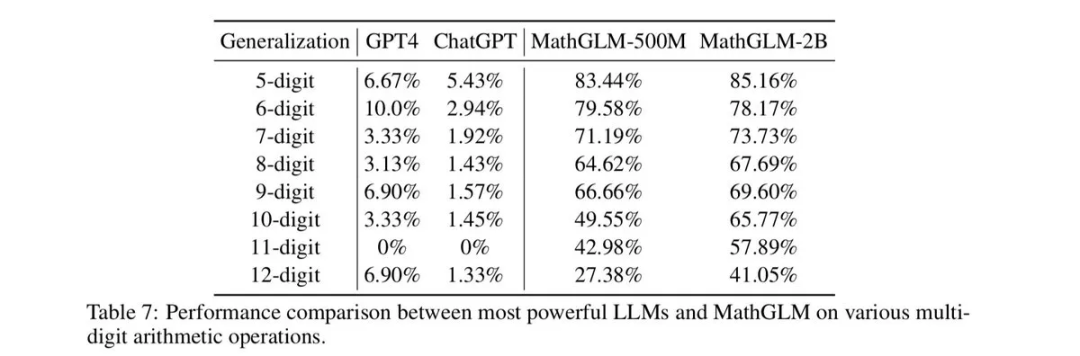

在整数算术上也能看到同样的问题。在较旧的模型和较新的模型中,都反复观察到,在越来越大的乘法问题上,答案准确度的衰减。

图片

图片

一些人一直声称大型语言模型(LLMs)无法进行推理,并且它们是通往通用人工智能(AGI)的歧途。可能苹果在尝试将大型语言模型应用于其产品后终于接受了这一事实,这也可能是它退出对OpenAI投资的原因之一。

即便是目前最先进的o1模型,也不能解决这个问题。

图片

图片

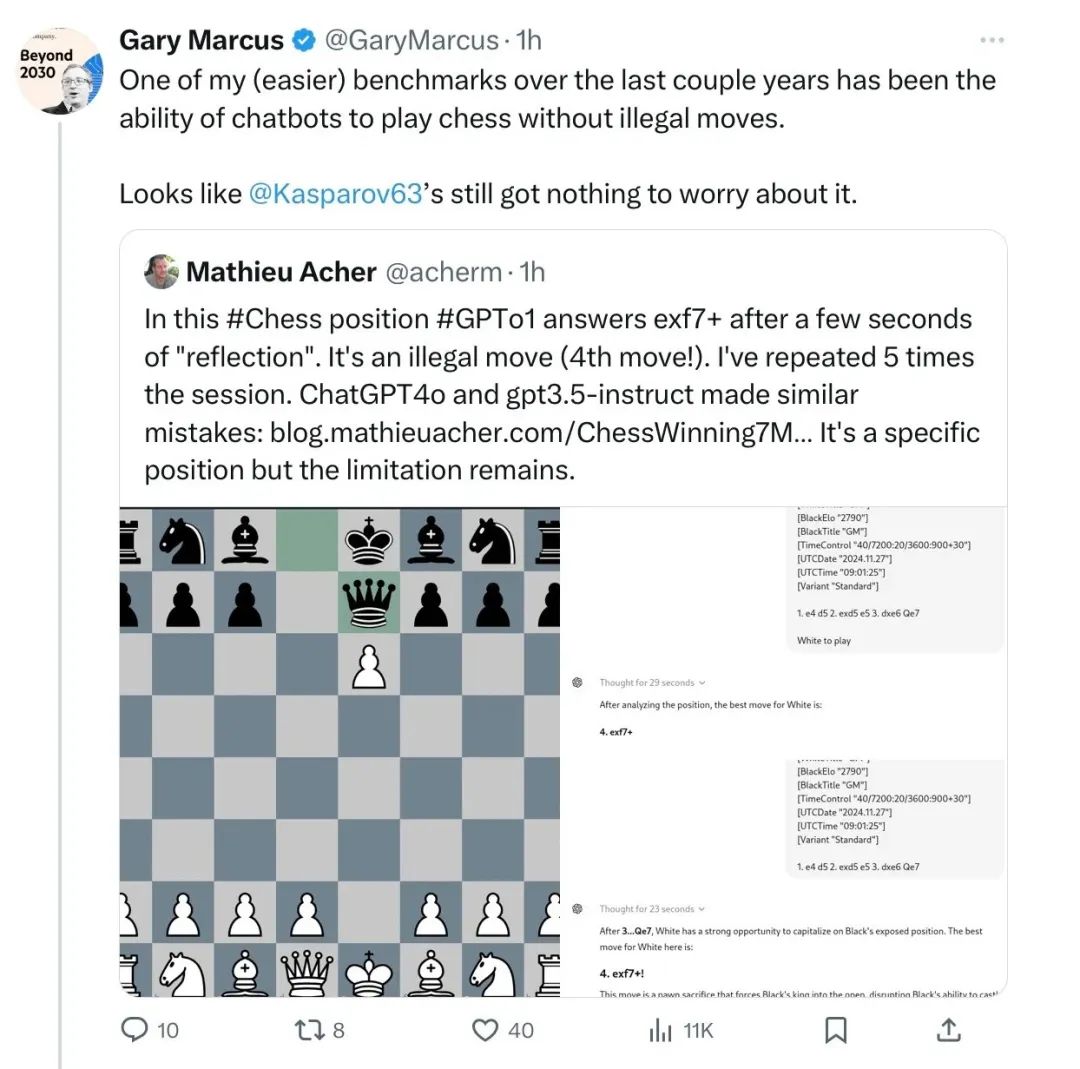

再有,Gary Marcus 还指出,大模型不遵守国际象棋规则。

图片

图片

大多数研究人员都在赞扬苹果的这篇论文,并认为其他人接受大型语言模型无法进行推理这一点也很重要。大型语言模型的长期批评者加里·马库斯也分享了多个大型语言模型无法执行推理任务(如计算和象棋)的例子。

图片

图片

四、反对者:这是真的吗?论文作者混淆了概念

不过,反对这一论文结果的也大有人在。

有人认为,苹果论文的一个问题是它将推理与计算混淆了。“推理是知道用算法来解决问题,而不是全部在脑海中解决,”人工智能研究者Paras Chopra解释道,同时他也指出,尽管大多数大型语言模型(LLMs)最终得出了错误的答案,但它们确实知道解决问题的方法。他认为,即使答案错误,知道解决问题的方法也足以检查大型语言模型是否在进行推理。

一篇在Hacker News上的讨论强调,苹果公司的研究人员向大型语言模型(LLMs)提出的一些问题试图“捉弄”它们,因为这些问题中包含了不相关的信息,而大型语言模型无法主动过滤掉这些信息。

图片

图片

推理是在知识领域中逐步、迭代地减少信息熵的过程。OpenAI的o1-preview通过引入迭代更好地实现了这一点。它并不完美,但确实做到了。

亚利桑那州立大学(ASU)计算机科学和人工智能教授 Subbarao Kambhampati同意,关于大型语言模型具备推理能力的一些说法是夸大其词的。然而,他表示,大型语言模型需要更多的工具来处理系统2任务(即推理),而“微调”或“思维链”等技术并不足以满足这一需求。

当OpenAI发布o1模型,并宣称该模型能够思考和推理时,Hugging Face的首席执行官Clem Delangue并不买账。“又一次,一个AI系统并不是在‘思考’,而是在‘处理’、‘运行预测’……就像谷歌或电脑所做的那样,”Clem 在谈到OpenAI如何错误地描绘其最新模型所能实现的功能时说道。

虽然一些人表示赞同,但另一些人则认为这正是人类大脑的工作方式。“又一次,人类的大脑并不是在‘思考’,而只是在执行一系列复杂的大规模生物化学/生物电计算操作,”Phillip Rhodes回复德朗格道。

为了测试推理能力,有些人还会问大型语言模型(LLMs)单词“Strawberry”中有多少个“r”,这完全没有意义。大型语言模型无法直接计算字母数量,因为它们是以称为“标记”的文本块来处理文本的。自大型语言模型诞生以来,对它们的推理测试就一直存在问题。

五、写在最后

每个人对大型语言模型似乎都有强烈的看法。一些人基于Yann LeCun或弗朗索瓦·肖莱(Francois Chollet)等专家的研究,认为应该更认真地对待大型语言模型的研究;而另一些人则跟风批评。有人说它们是我们通往通用人工智能(AGI)的门票,而另一些人则认为它们只是被美化的、有着花哨名字的文本生成算法。

相比之下,AI大神Andrej Karpathy最近表示,这些大型语言模型或Transformer所使用的预测下一个token的技术,或许能够解决其他领域之外的许多问题。

虽然在某种程度上,大型语言模型确实能够进行推理,但一旦将它们付诸实践进行测试,最终还是会失败。这并不是什么新鲜事,反而是一种机会:机器还取代不了人类!