写在前面&笔者的个人理解

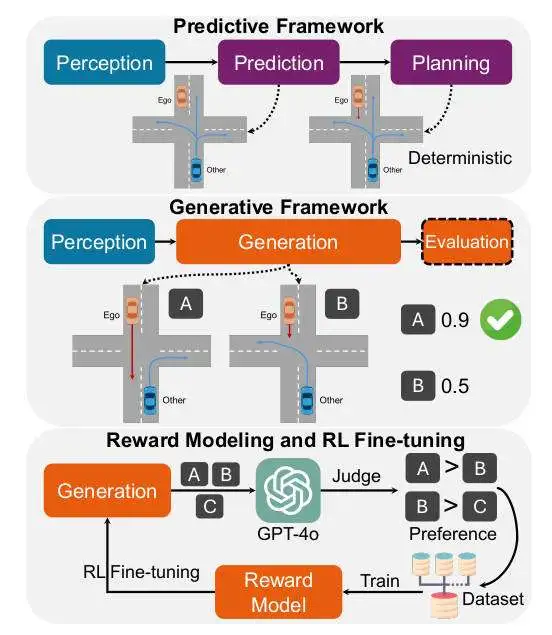

在复杂环境中导航需要自动驾驶代理能够熟练地预测未来场景(比如其他代理的行为),同时做出明智的决策。一般而言,传统的预测性和确定性规划方法通常将预测和规划过程分开,从而将自车与社会环境信息隔离开来,并常常导致不符合社会驾驶规范的行为。尽管目前工业界和学术界已经提出了集成预测和规划框架的算法模型来解决这一问题,但这类算法仍然依赖于确定性规划,这对解决代理行为的不确定性、多模态性和相互作用的动态性提出了挑战。

为了克服上述提到的这些挑战,我们建议在规划任务中采用生成-评估的方法。这个方法的关键是将自车代理集成到社会互动环境中,为整个场景中的所有代理生成一系列可能的结果,并使用学习场景评估器来指导决策过程。同时,我们考虑到生成模型在自动驾驶的仿真和预测任务中得到了广泛的应用,但它们在决策任务中的应用相对有限。我们认为是两个主要限制阻碍了生成模型在规划任务中的应用。

- 评估生成的场景并选择符合人类期望和价值观的最佳决策场景非常复杂。为了解决这个问题,我们引入了一个场景评估(奖励)模型,该模型基于从 VLM 反馈中得出的偏好数据进行训练,从而实现更好的决策;

- 与受益于样本多样性的仿真或者场景生成任务不同,使用生成模型进行规划需要用更少的样本生成更可能的未来场景,以最大限度地减少计算开销和运行时延迟。我们通过引入强化学习 (RL) 微调框架来解决这个问题,该框架基于获得的奖励模型来提高扩散生成的质量;

考虑到上述提到的主要限制阻碍以及相应的解决措施,我们提出了Gen-Drive算法模型,一种扩散生成驱动策略以及相应的训练框架。我们设计的基础模型使用 nuPlan数据集进行训练,并在nuPlan闭环规划基准上进行评估。结果表明,我们的扩散驱动策略取得了良好的性能。

完整的Gen-Drive算法框架以及训练过程如下图所示。

Gen-Drive算法模型整体训练框架图

网络模型的整体架构&细节梳理

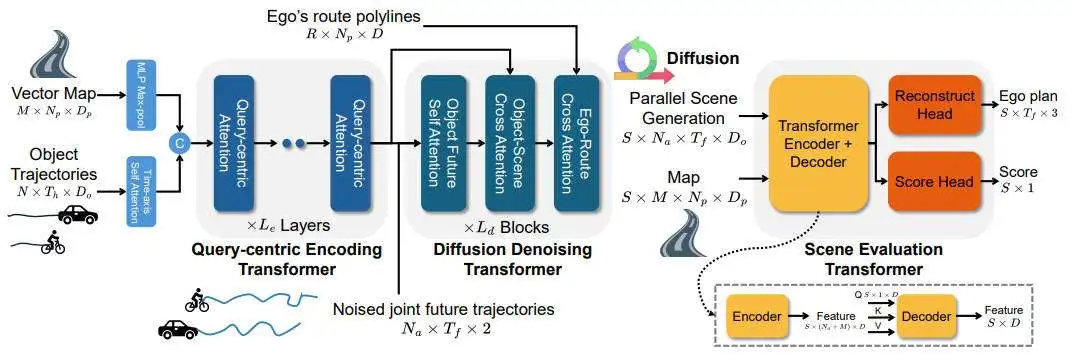

在详细介绍我们提出的Gen-Drive算法模型细节之前,下图展示了我们提出的Gen-Drive算法模型的整体架构。

提出的Gen-Drive框架的整体结构图

提出的Gen-Drive框架的整体结构图

通过上图可以看出,整体而言,我们采用生成(扩散)模型来取代传统范式中的预测规划模型。二者之间的关键的区别在于,自车代理并不是孤立于场景之外的;相反,它被视为场景中不可或缺的一部分,所有代理的行为都相互依赖。为了利用该生成模型进行规划,我们设计了一个场景评估(奖励)模型。该模型使用精选的成对人类偏好数据集进行训练,使其能够直接对生成的场景(规划)进行评分,并促进选择最佳且符合上下文的决策。此外,我们利用奖励模型来微调扩散生成过程,使其朝着生成高回报计划的方向发展。RL微调步骤可以增强整体规划性能并减少大量采样的需要。

场景生成器

对于当前时间戳的初始驾驶场景,我们考虑N个目标(包括自车)和M个地图元素,追踪这些目标在个时间步内的历史轨迹。当前的场景输入到编码器中的包括目标的轨迹以及地图线。其中,是路径点的个数,和是每个点的特征维度。

- 编码器部分:当前场景输入最初通过时间轴自注意力Transformer层对目标轨的迹进行编码,得到,然后通过多层感知机对地图数据进行最大池化,得到。他们被拼接起来形成初始的编码。我们采用以查询为中心的Transformer编码器来融合场景元素的特征并生成全面的场景条件编码。

- 去噪器部分:扩散过程在所有感兴趣目标的联合动作空间中进行,动作由加速度和偏航角比率组成。噪声直接添加到动作序列中。给定噪声输入,其中是噪声等级,是未来时间戳,此外场景条件为,我们采用具有自注意力和交叉注意力层的去噪Transformer来预测去噪后的动作序列。对于自车代理,额外的路线信息被提供,并采用了额外的交叉注意层来模拟自车的路线关系。

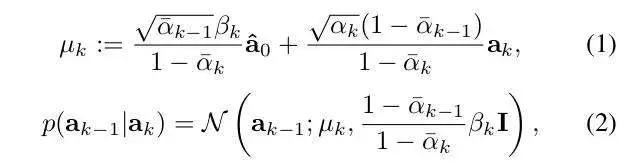

- 生成:未来场景(联合目标动作)是从随机高斯噪声开始生成的,随后,每个扩散步骤k涉及从下面指定的过程进行采样。其中,以及是根据预先确定的噪声得到的。通过迭代地反转扩散步骤,我们获得最终的去噪联合动作输出。随后,通过使用动态模型将目标动作转换为状态。该状态包括目标的坐标、朝向和速度。

场景评估器

场景评估器将扩散生成器生成的个未来场景作为输入,这些场景可以通过从一批高斯噪声开始并行生成。这些生成的场景结构化为,评估器的另外一个输入是矢量地图。这些未来场景使用以查询为中心的Transformer编码器进行编码,类似于历史场景的编码,从而产生场景特征表示。随后,我们利用从场景编码中提取的自车代理的未来或规划编码,以及将场景编码作为Transformer解码器中的键和值,得出未来场景中以规划为中心的特征。需要注意的是,Transformer解码器分别关注每个场景中的个元素。两个多层感知机头模块附加到这个特征张量用于分别重建自车代理的规划轨迹并输出不同生成场景的分数。自车规划重建的头模块作为辅助任务来增强稳定性和有效性。

基于扩散模型的训练

基础的扩散模型经过训练,可以在各种噪声水平和场景条件下从带噪声的轨迹输入中恢复干净的轨迹。在每个训练步骤中,我们都会从噪声级别和高斯噪声中进行采样来扰乱原始的动作轨迹。由于该模型预测场景级的轨迹,因此所有目标轨迹都受到相同噪声水平的影响。基础扩散模型的训练损失函数可以表示为:

其中,代表数据集,代表Smooth L1损失函数,是动态模型,是目标的未来真值状态。

训练奖励模型

- 成对偏好数据收集:为了构建一个有效的奖励模型,整理全面的数据集是非常有必要的。一种方法是利用人为设计的指标,例如PDM分数。但是,依赖此类指标存在很大的局限性,因为它们可能无法准确反映不同场景中的实际人类价值观。此外,即使对于人类评估者来说,准确地用奖励值标记场景也是一项挑战。或者,我们可以让人类标注员进行成对的比较,确定哪些场景更符合人类偏好。然而,整理大规模奖励数据集会给人类标注员带来巨大的工作量。为了解决这个问题,我们使用VLM来提高流程的效率和可扩展性。

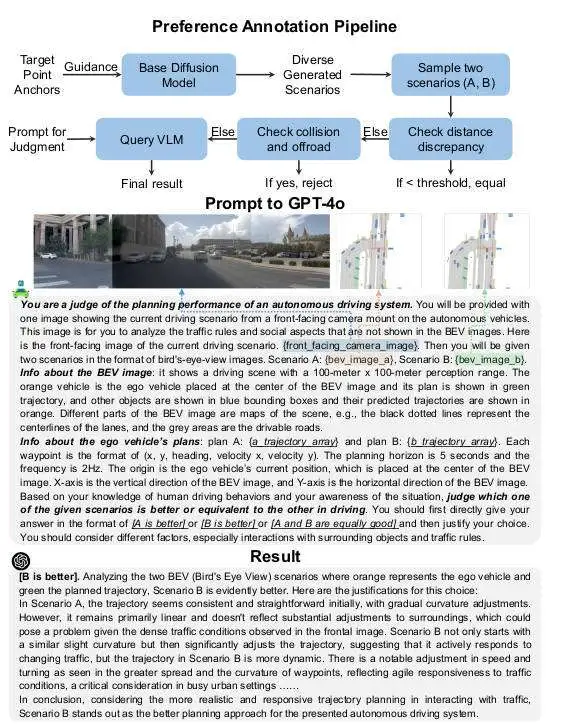

VLM辅助奖励标记流程如下图所示。为了增加规划轨迹的多样性,我们首先利用K-means聚类算法从数据中提取32个5秒锚定目标,并采用引导扩散策略为自车代理生成32条不同的规划轨迹,以及模型对场景中其他物体的反应行为。随后,我们对这些场景进行成对采样。我们首先计算规划轨迹之间的差异,然后检查碰撞和过滤掉明显的失败情况。如果这些措施不足以区分,我们将使用GPT-4o提供结论性评估。如下图所示,GPT-4o根据当前场景上下文对两个生成的场景进行了合理的评估。

使用VLM收集规划偏好数据的整体流程

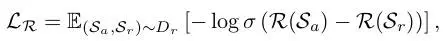

- 训练过程:在每个训练步骤中,我们从相同的初始条件中采样一批成对比较结果,即接受的场景和拒绝的场景。训练场景评估模型的损失函数如下,其中,是成对偏好奖励数据集,表示预测生成场景得分的奖励模型。

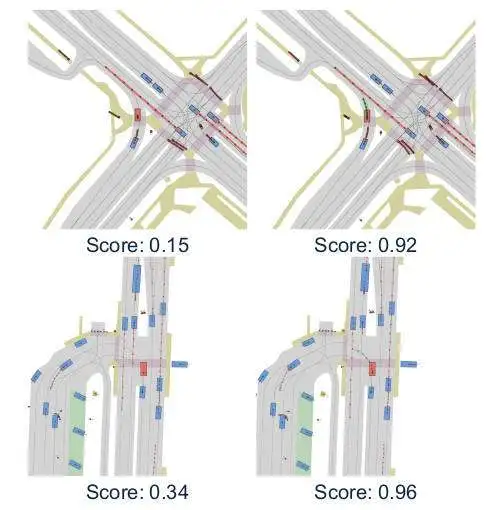

下图显示了一些奖励模型输出的示例,结果表明,我们训练的奖励模型为生成的计划和场景产生了合理的分数。

场景评估输出的示例

微调生成模型

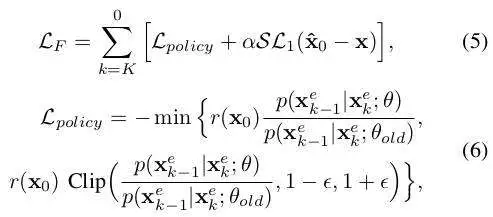

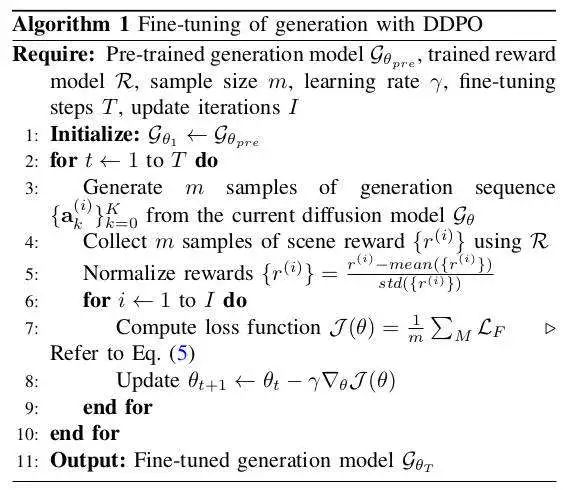

为了提高扩散生成在规划任务中的效率,我们建议使用训练好的奖励模型和RL对扩散模型进行微调。我们可以将扩散去噪过程公式化为多步骤的MDP,其中去噪器函数作为以每一步的噪声输入为条件的策略。轨迹包含K个时间戳,在扩散过程结束时发出奖励信号。RL目标是最大化沿轨迹的累积奖励,我们可以利用去噪扩散策略优化来改进生成策略。微调损失公式如下,其中,是所有目标的去噪状态轨迹,是真实轨迹。

需要注意的是,微调损失会在整个扩散轨迹上累积,并且只有去噪器是可学习的,而编码器在微调期间是固定的。下图展示了使用DDPO的RL微调算法流程。

实验结果&评价指标

整体实验结果分析

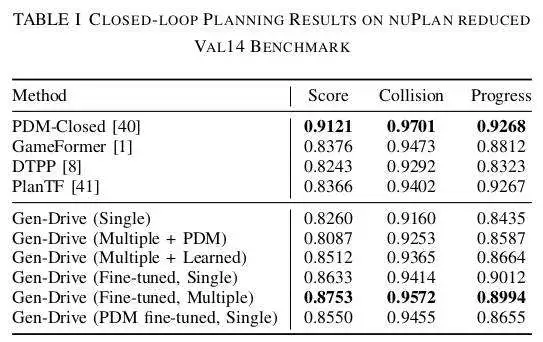

为了验证我们提出的算法模型的有效性,我们实施了不同模型的闭环规划实验,结果如下表所示。

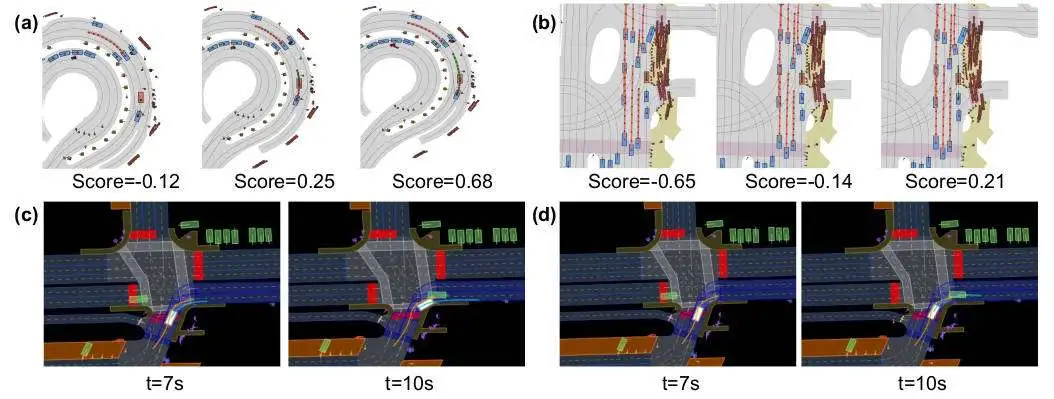

此外,为了更加直观的展示生成过程中的一些典型场景,微调后的策略表现出更好的规划性能,我们也进行了相关的可视化。

规划过程示意图

规划过程示意图

通过相应的实验和可视化结果可以看出,生成和评估优于单样本推理。多样本规划方法通过批处理并行生成 16 个场景,并使用学习到的奖励模型选择最佳场景。该方法增强了生成计划的多样性,从而提高了整体规划得分。此外,具有我们学习到的奖励模型的生成规划器在规划方面优于基于 PDM 分数的评估器。此外,微调可提高性能。规划效率仍然在很大程度上取决于生成质量,我们证明 RL 微调可以显著提高质量和性能。值得注意的是,即使使用单样本方法,微调策略的整体规划得分也优于没有微调的多样本方法。此外,使用我们学习到的奖励模型进行微调比使用基于 PDM 的评分器效果更好。我们也注意到,与基于学习的预测规划器相比,我们的模型通过使用先生成后评估的方法表现出卓越的性能。然而,使用基于规则的轨迹生成器和评分器的PDM-Closed规划器获得了最高分。值得注意的是,它针对 nuPlan 指标进行了优化,这可能缺乏人类相似性和对现实世界场景的适应性。

消融实验结果分析

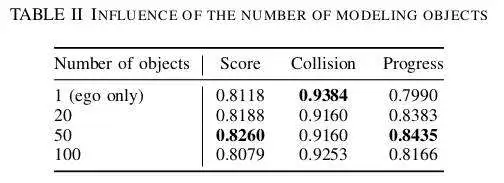

首先,我们先分析了建模目标数量的影响。数量范围从 1到 100,相关的实验结果下表所示。我们在模型训练中调整建模目标的数量,并在测试中使用单样本生成。结果表明,仅生成自车的规划会导致性能较差,主要是因为在某些情况下缺乏运动。相反,过多的建模目标(例如 100)也会导致性能和运行效率下降。因此,在保持运行效率的同时,对 50 个自车和周围对象进行建模表现最佳。

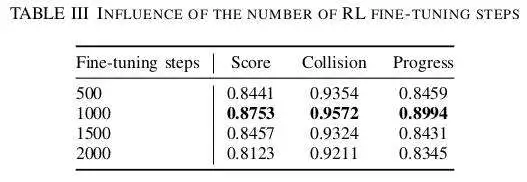

此外,我们也对RL微调阶段训练步骤对结果的影响进行了实验,并在测试中采用了多样本生成和评分方法,相关实验结果如下表所示。结果表明,1000 个微调步骤可实现最佳规划指标,超过此指标,微调策略的性能就会下降。这是 RLHF 框架中的一个常见问题,因为策略可能会利用奖励函数并产生不合理的行为。因此,我们将 RL 微调阶段限制为 1000 个步骤,以防止性能下降。

结论

在本文中,我们提出了Gen-Drive算法框架,标志着自动驾驶的决策向生成-评估的方式进行转变。实验结果表明,与其他基于学习的规划方法相比,我们的模型通过适当的奖励建模表现出更优异的性能,并且通过 RL 微调得到了进一步的增强。