在 PVP 多人对战类的游戏中,社恐玩家的社交和情绪价值、对战局的操控感,无法得到有效满足。因此,网易伏羲助力《永劫无间》手游率先发布了全球首创的游戏 Copilot-多模态实时交互的语音 AI 队友。它可以在战斗中自主跑图、战斗、听指令、报战况,还会和玩家进行自由对话,给玩家带来极高的情绪价值。本文将重点讲解语音 AI 队友的设计和实现,及其背后的 AOP(Agent-Oriented-Programming,面向智能体编程)框架,最后还会分享语音技术在游戏场景的一些创新应用。

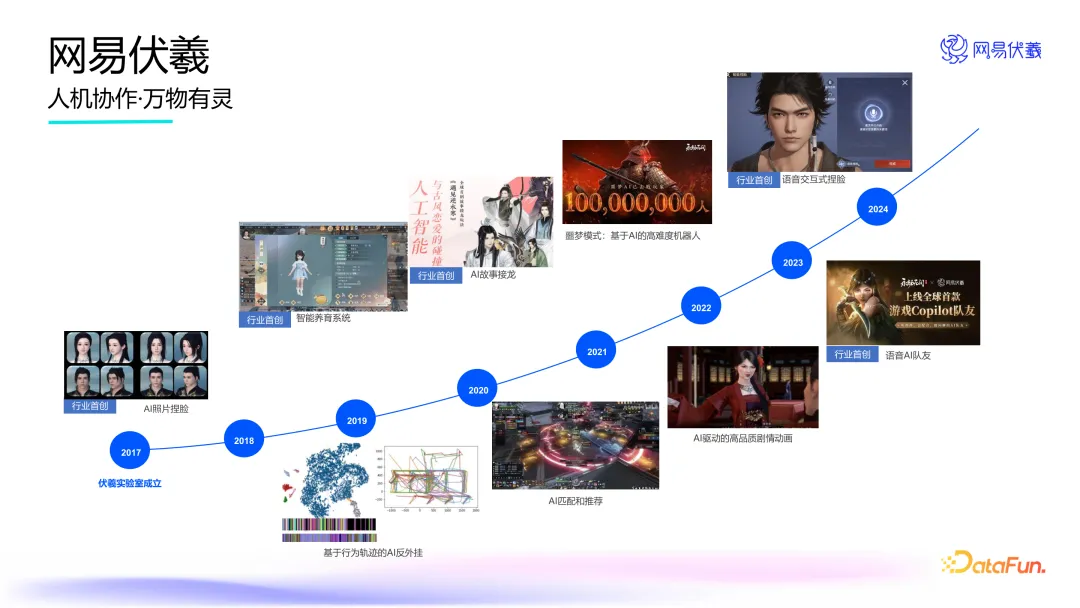

一、网易伏羲介绍

网易伏羲是国内首个游戏人工智能研究机构,自 2017 年成立以来,已在全球各类学术顶级会议中发表 270 余篇学术论文,并持有 600 多项技术专利,为人工智能、元宇宙、数字孪生、智能决策技术等众多前沿科技领域的理论研究和实践应用做出贡献。

自成立以来,网易伏羲不断推陈出新,积极探索前沿技术和应用场景,实现了游戏AI 领域的多项创新技术突破,推出了基于照片、文字的 AI 捏脸、智能 NPC、剧组模式、语音交互式捏脸和语音 AI 队友等多个行业首创的AI 应用。通过将 AI 技术融入游戏系统的各个层面,网易伏羲成功助力《逆水寒》手游、《永劫无间》手游等游戏打造多项创新玩法,极大地提升了玩家的游戏体验。

近期,网易伏羲助力《永劫无间》手游推出全新的游戏 Copilot——“语音 AI 队友”,该玩法一经推出即受到玩家的高度评价,相关用户生成内容迅速登上抖音和 B 站热门榜单。

二、语音 AI 队友的设计与实现

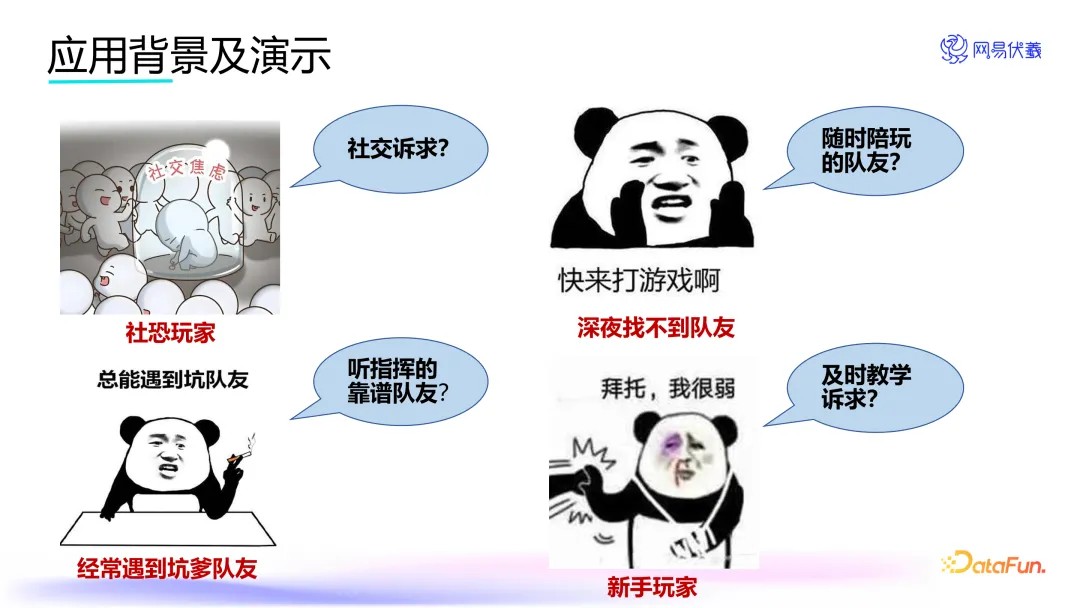

传统游戏中,机器人往往存在行为呆板、缺乏互动交流等问题。对于有社交焦虑的玩家,他们希望在避免与真人玩家直接语音交流的同时,仍能享受游戏中的社交体验及多人对战的乐趣。此外,玩家匹配到技术不佳或配合度低的队友,会导致游戏体验不佳。因此,玩家希望能够找到一个既能提供高质量的游戏技巧支持又能陪伴聊天的对象,从而满足自身情绪需求,提升整体游戏体验。

为了满足玩家对于游戏互动性和情绪价值的需求,《永劫无间》手游推出了一种多模态实时交互的语音 AI 队友。AI 队友能够在战斗中自主跑图、执行战术动作,并根据玩家指令汇报战况。此外,它还能与玩家进行自然对话,提供情感支持。对于新手玩家,该语音 AI 队友还具备教学引导功能,可以帮助他们更快地熟悉游戏机制。

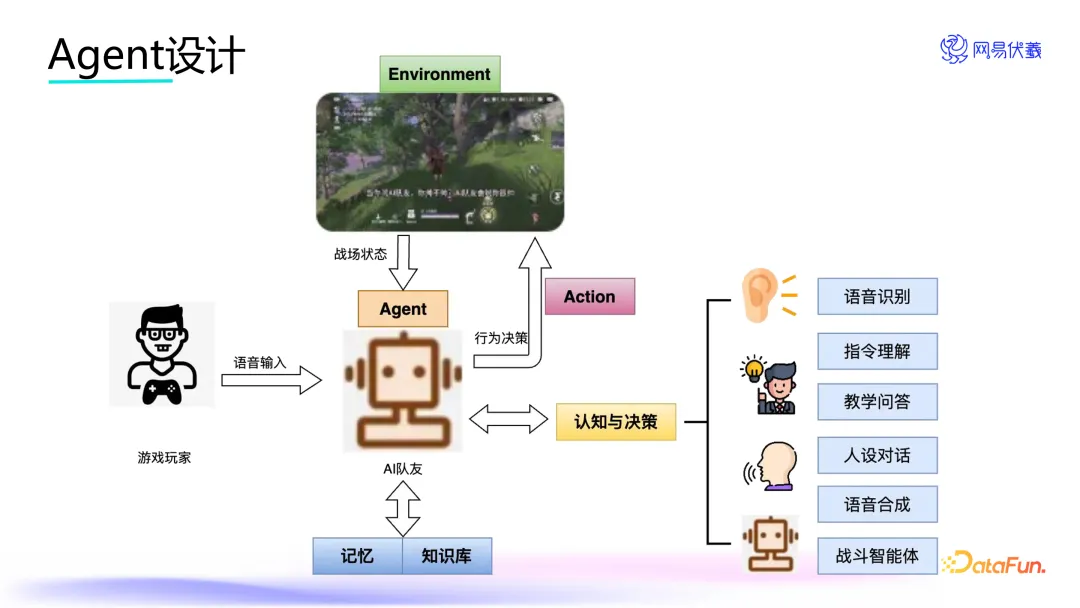

在《永劫无间》手游中设计的 AI 队友 Agent 能够综合处理游戏环境中的状态变化和玩家输入的语音信息。基于对当前环境状况的认知、决策能力,以及利用游戏知识库与战斗记忆,该 AI 队友能够做出合理的行动决策并给予相应的语音反馈。

在这一应用场景下,为实现高效互动和辅助功能,Agent 需要具备的认知与决策能力主要包括:语音识别、指令理解、教学问答、人设对话、语音生成,以及协同完成任务所需的战斗智能体等。

接下来将详细介绍几个核心能力。

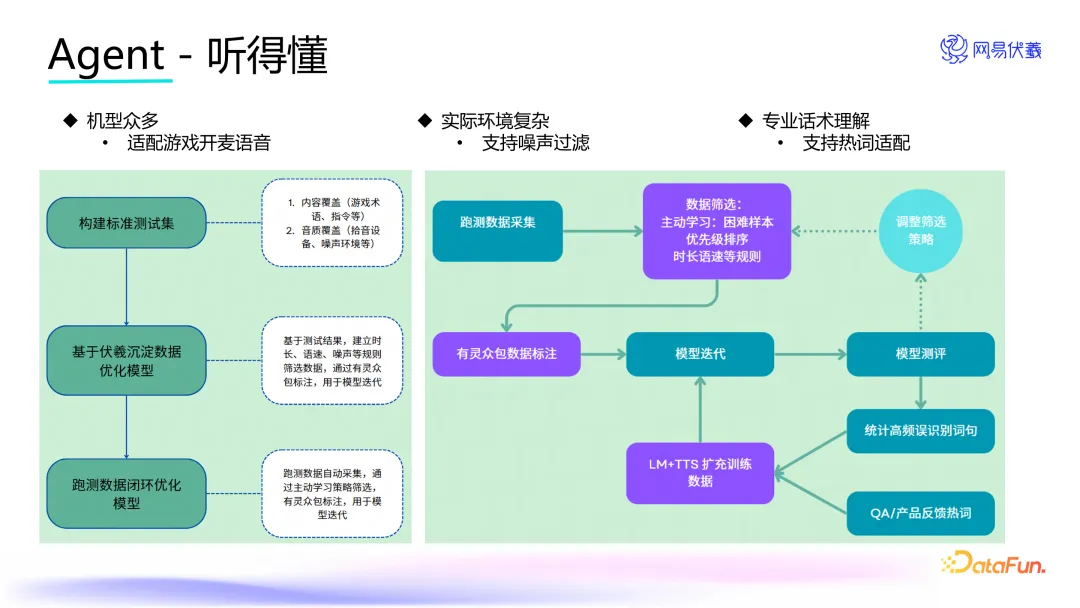

首先,作为 AI 队友,必须具备“听得懂”的能力,能够像真人一样与玩家实时语音互动。因此在设计之初就去掉了智能音箱等场景中常用的唤醒词设计,比如“Hey Siri”,而是采用全开麦实时语音交互。这种模式虽然极大地提升了用户体验,但也带来了很大挑战。比如环境噪音、不同设备的兼容性、玩家方言口音差异以及存在一些专业术语等问题。为了解决这些问题,我们基于 AOP(Agent-Oriented-Programming,面向智能体编程)框架的核心能力,构建了自主数据闭环的训练模型,使 Agent 具备自主进化的能力,并且构建了标准的测试集,有效利用测试和线上数据扩充数据集,推动模型迭代。我们的语音识别在经过几次场景数据的闭环训练之后,在噪声过滤、热词适配等方面都得到了显著的加强。

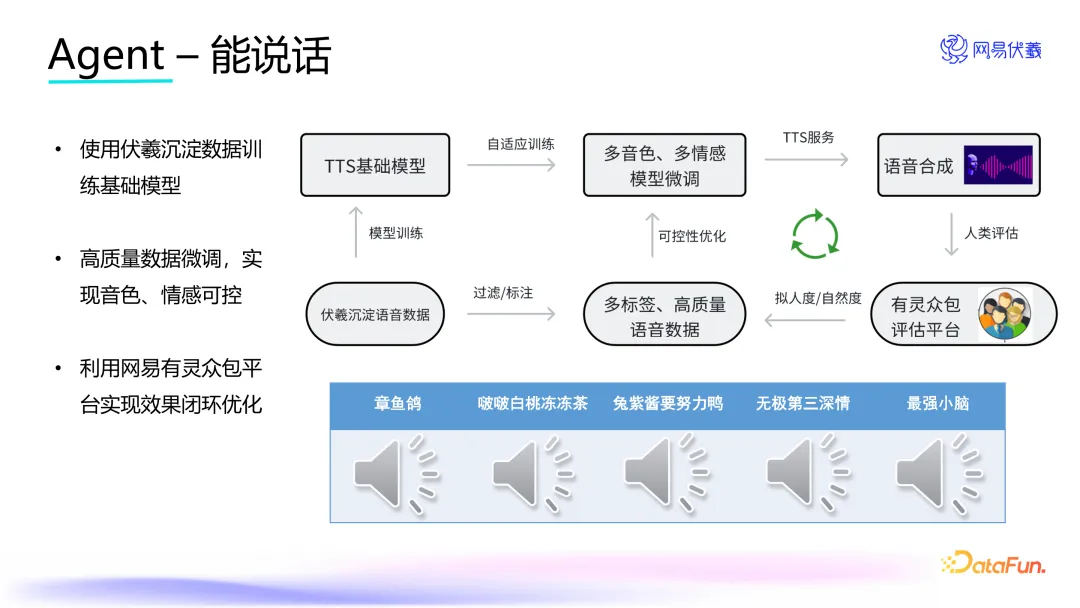

除了听得懂,AI 队友还需能够进行表达和对话。通过结合大语言模型与文语转换(TTS)技术,AI 队友实现了自主对话的功能。为了增强语音生成模型的泛化能力,我们利用多年积累的大数据对语音基础大模型进行了训练,并针对具体游戏场景进行了自适应优化。

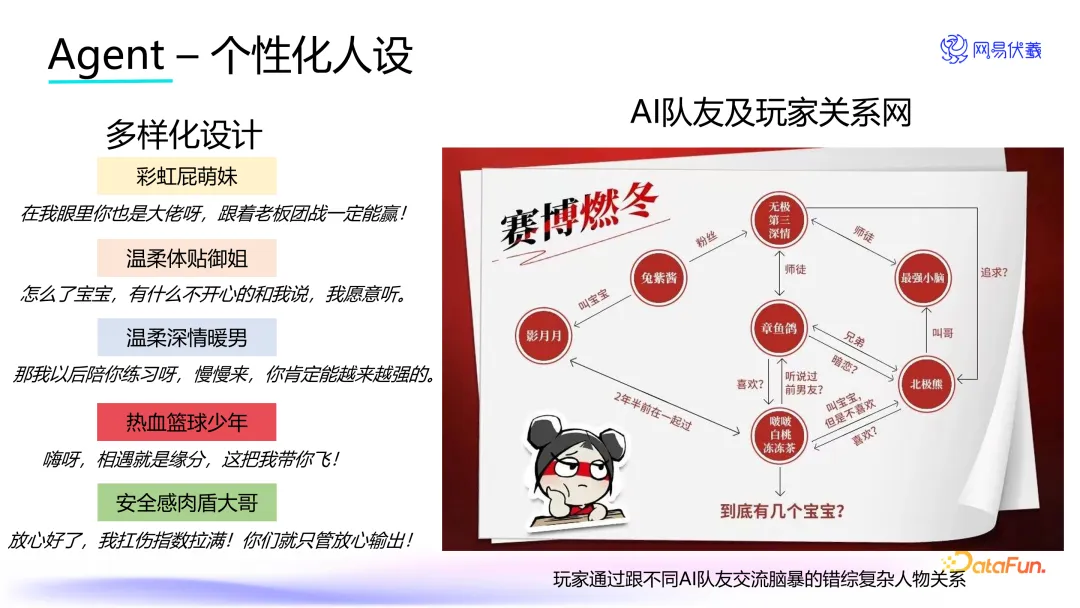

在听得懂、能说话的基础上,我们给 AI 队友设计了非常丰富的人设选项,比如彩虹屁萌妹、温柔体贴御姐以及温暖深情暖男等等。这些具有鲜明个性的 AI 队友,不仅可以和玩家产生复杂的互动关系,还可以根据不同的游戏情境展现出其独特的性格特点,进一步增强游戏的沉浸感和互动感。比如上图中展示的,一个玩家在玩的过程中通过和不同 AI 队友的交互体验,画出了一个关系图。

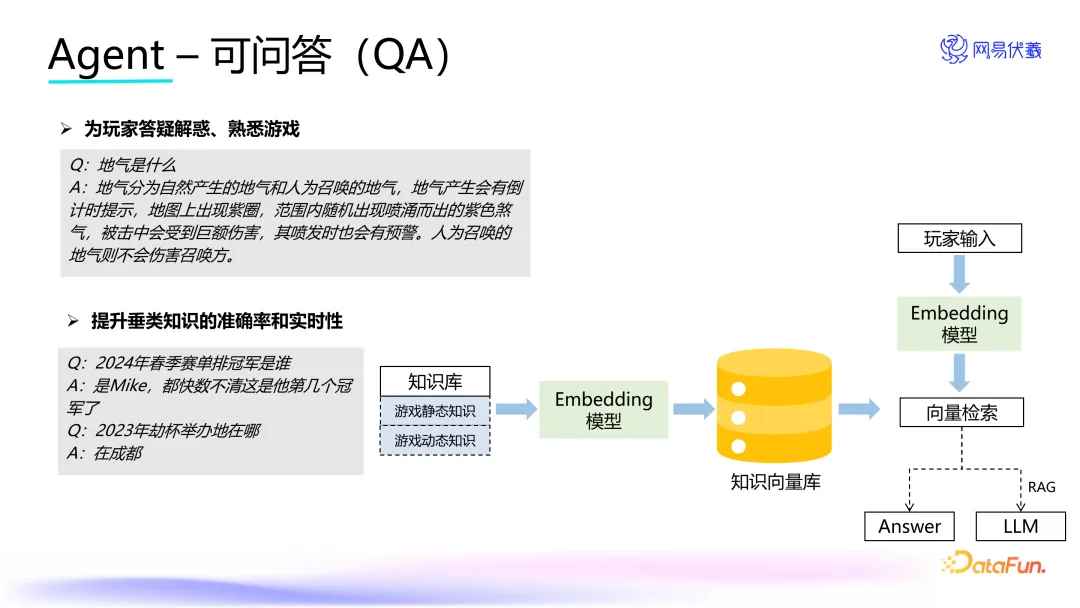

作为游戏的陪玩或队友,对于游戏的理解需要非常到位,对于问到游戏相关内容时,要做出非常好的回答。为了实现 AI 队友的教学问答功能,我们构建了一个强大的知识库系统,该系统包括游戏的静态知识(如规则和机制)和动态知识(如赛事信息)。当玩家提出问题时,AI 会通过 embedding 模型将问题转化为向量,并在向量库中搜索最匹配的答案。如果答案不明确,则会利用 RAG(检索增强生成)和更高级的大语言模型进行进一步的检索和推理,以确保提供准确的回答。

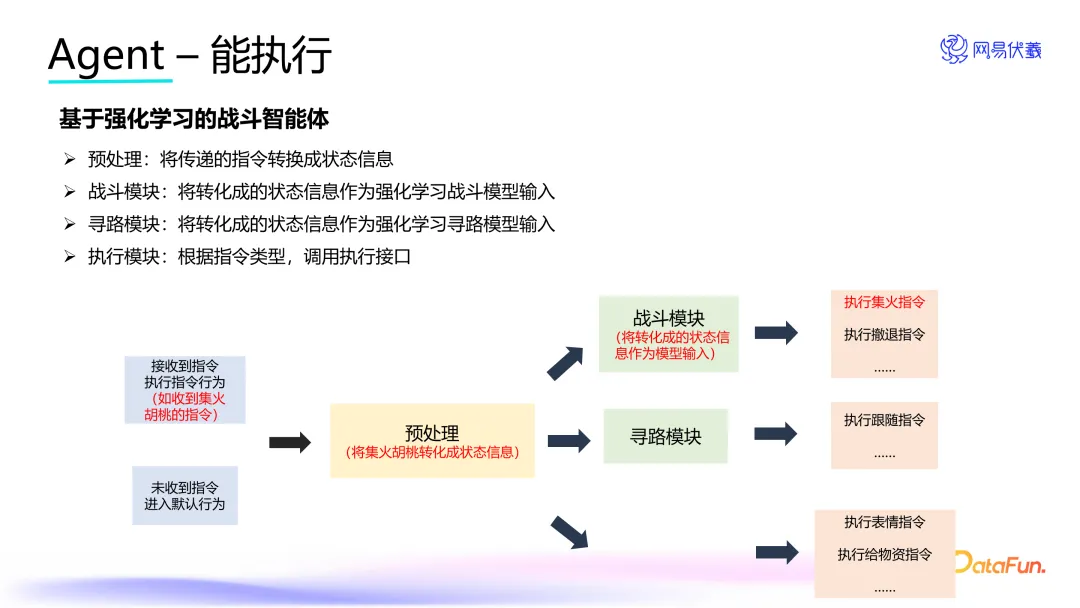

AI 队友还必须拥有基本的游戏执行能力。当玩家发出如“集火胡桃”这样的指令时,系统首先在预处理模块中解析并理解该指令的意图。识别出意图后,系统将“集火”这一行为类型和“胡桃”这一目标转化为状态信息,并将其作为战斗模块的输入。最终,基于强化学习的战斗模型会根据这些输入信息做出相应的行动决策,从而执行玩家的指令,做出集火胡桃的动作在客户端表现出来。

基于上述介绍,可以看到 AI 队友系统具备多种能力,包括理解语音、自然对话、展现个性以及执行任务等,因此它是一个多智能体系统,类似于人类大脑中不同区域分工明确且协同工作的机制。行业中已有一些成熟的多智能体框架,如 MetaGPT 和 AutoGEN 等,支持复杂系统的开发与应用。

在做 Agent 设计和落地时,常会遇到场景适配的问题,比如语音识别,需要适配环境噪音、口音等问题。我们是如何解决这些问题的呢?这就引入了下一部分内容——AOP 框架。

三、Agent 能力迭代- AOP 数据闭环

AOP(Agent-Oriented-Programming,面向智能体编程) 是网易伏羲设计的一套全新的编程范式,其核心价值在于为开发者对接智能体(包括 AI 和人),提供统一范式的接口和服务,并自动构建数据闭环让智能体具备自主进化能力。开发者可通过 AOP 使用伏羲有灵机器人平台预置的公共智能体能力,包括 ChatGPT、Midjourney 等预训练模型,以及数据标注、美术制作、工程机械操控等众包能力,也可针对行业细分场景定制化构建智能体应用。

AOP 的设计思想,是基于马尔可夫决策过程(Markov Decision Processes,MDP)的定义来进行任务建模,即 Agent(智能体,包括人类或机器)在进行某个任务时,首先会和环境进行交互,产生新的状态(State),同时环境会给予相应的奖励(Reward),这一过程循环往复,Agent 与环境之间的交互产生了大量的数据。Agent 利用这些新数据不断调整自身的行为策略,经过多次迭代后,Agent 便能够学习到完成特定任务所需的最佳动作策略。

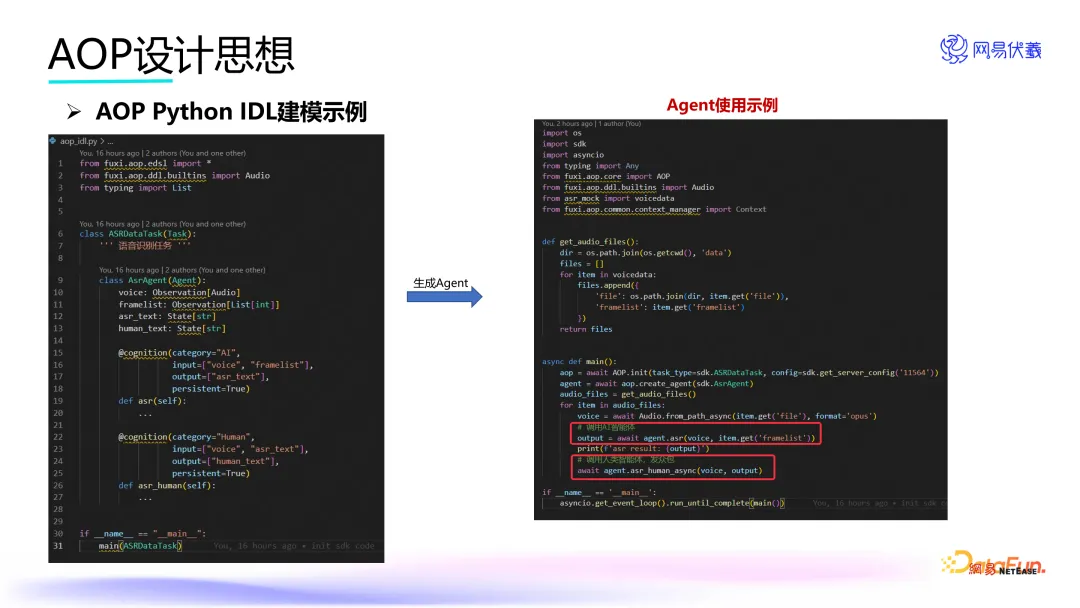

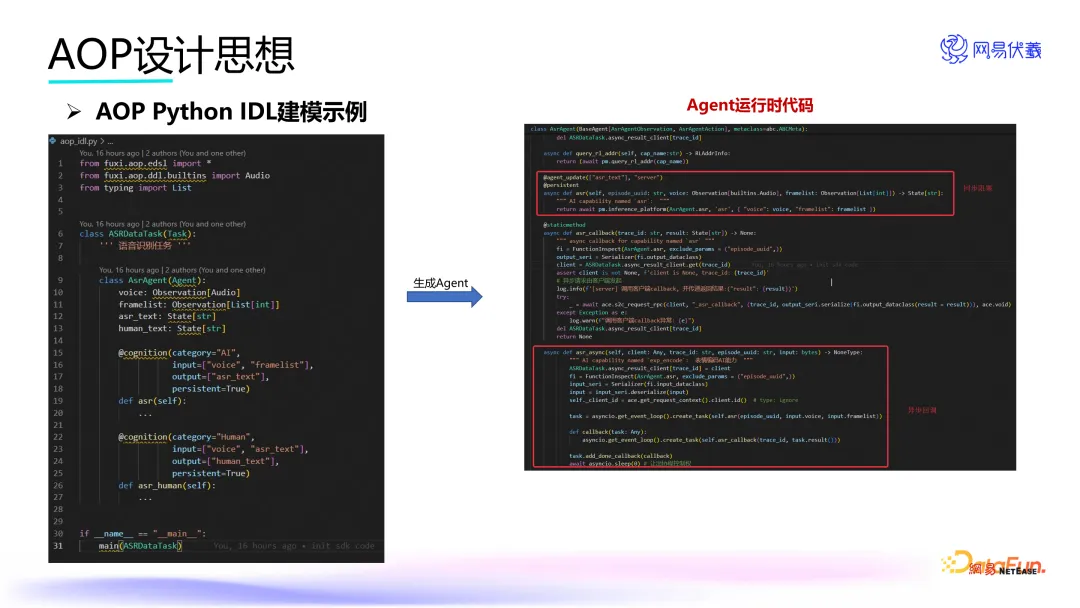

图中展示的是我们所定义的一个用于语音识别的智能体。我们详细规定了该智能体的状态观察机制及其自身的能力,无论是指定使用人工智能还是人工操作。一旦完成接口描述语言(IDL, Interface Description Language)的定义,便能够生成并编译出这一智能体。编译完成后,我们将获得一段运行时代码,这段代码提供了同步与异步调用的接口。接着,利用 AOP 平台的一键发布功能,即可实现智能体的快速部署。部署完毕后,就可以在具体的业务场景中直接调用此智能体。例如,根据图示代码所示,可以选择调用 AI 执行的自动语音识别(ASR)功能或人类执行的语音识别服务。

该 AOP 框架已成功应用于多个案例之中,除了文本提到的 AI 语音队友以外,还在《逆水寒》手游的文字捏脸、《永劫无间》手游的交互式捏脸等应用中落地。

四、语音技术在游戏场景的应用

最后来分享一下语音技术在游戏场景的一些其他应用。

在游戏场景下,除了实时互动的语音 AI 队友,我们在音频内容生产上也做了一定工作。游戏场景下的音频内容,主要包含音乐、音效、语音三个方面。游戏音乐,包括背景音乐、剧情、战斗和关卡中的音乐等等。音效包括各种各样的声音效果,像环境音效、动作音效等等,例如法术释放、技能特效、爆炸声等,完美的音效设计可以给玩家带来更好的沉浸感和互动体验。游戏人物语音是指游戏角色所发出的人声,常见的有对话语音、战斗语音,语音设计师可以根据角色的角色设定、角色性格、场景和情节需求,来创造适合的语音内容和表达方式。在传统的游戏生产链路中,这三部分都是人工完成的,耗费人力和时间很多,随着 AI 生成式技术的兴起,我们尝试用技术去帮助游戏音频设计师更快更好地生产内容。下面,将以人物语音为例,介绍我们在游戏里面的一些落地案例。

《逆水寒》手游自去年上线就获得了很大的关注度,玩家可以在汴京、虹桥等很多地方,和澜儿、高衙内等数十个 NPC 进行互动交流,这种细致入微的互动,为游戏增添了更多的乐趣和丰富性。游戏里大家所听到的这些 NPC 的声音,就是我们语音合成技术所实时合成的。形形色色的会说话的 NPC,增加了《逆水寒》手游街头巷尾的烟火气息,让玩家获得了更好的沉浸式体验。

为了增强游戏的社交性、可玩性,提高游戏丰富度在《逆水寒》手游中,我们首次在游戏里加入了声音的 DIY 玩法——自定义技能喊话,玩家可以设置技能释放时候播放的语音内容,玩家可以输入文本,选择音色进行定制,也可以输入自己的语音进行音色转换来定制。

另外,我们还应用了歌声合成和转换技术,来制作歌声内容。

在游戏场景中,对变声器,即语音转换能力的需求比语音合成更多,我们在这块做了深入的探索,发表的论文有 DualVC、DualVC2、DualVC3、Expressive-VC 等等。比如在直播时可以选择将自己的声音更换为另一种特定的音色。实时变声器可以在很多玩法上做嵌套,但也会遇到法律边界的挑战。

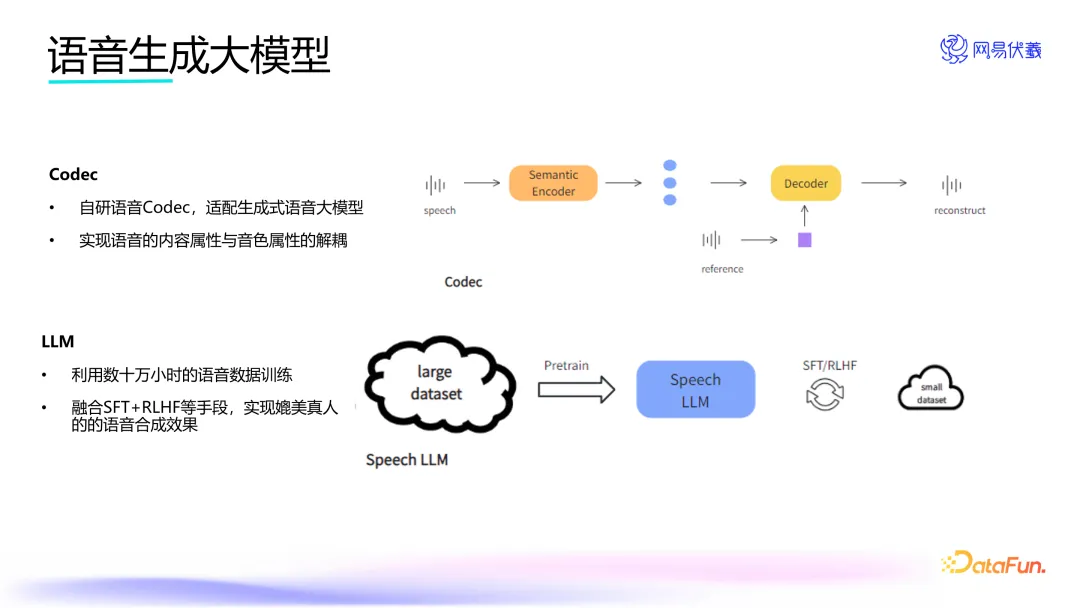

围绕语音生成,网易伏羲在 Codec 和 LLM 两个方面都做了探索。Codec 方面,网易伏羲基于自身技术积累,自研了适配生成式大语言模型的语音 Codec,不仅实现了语音的离散化和高质量重建,而且做到了内容属性与音色属性的解耦。

LLM 方面,在文本生成语音时,使用了 Speech LLM,利用数十万小时的语音数据训练,融合 SFT+RLHF 等手段,实现了媲美真人的语音合成效果。