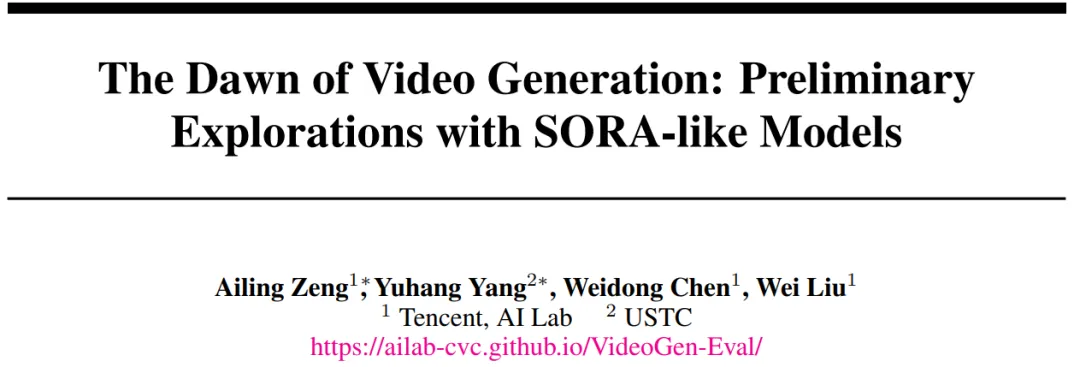

作者团队介绍:本文作者主要来自腾讯 AI Lab,作者分别是曾爱玲,腾讯 AI 资深研究员;来自中科大的杨雨航,主要研究方向是人与物互动的理解与生成;陈卫东,腾讯 AI 资深研究员;刘威,腾讯杰出科学家,IEEE fellow。

最近,腾讯 AI Lab 联合中科大发布了一份针对类 SORA 视频生成模型的测评报告,重点聚焦目前最前沿的类 SORA DiT 架构的高质量视频生成闭源模型,产品以及部分开源模型评估,从技术上,这些模型相较于之前 Stable Diffusion 类的视频模型不仅全面提升了画质,还在动作自然度和多样性、视觉 - 语言对齐以及控制精度上做出了显著进步,测评涵盖了从文生视频(T2V)、图生视频(I2V)以及视频到视频(V2V)生成模型全面能力评估,甚至连前几天刚更新的 pika1.5 特效以及 Meta 公布的 Movie Gen 都加进来了!

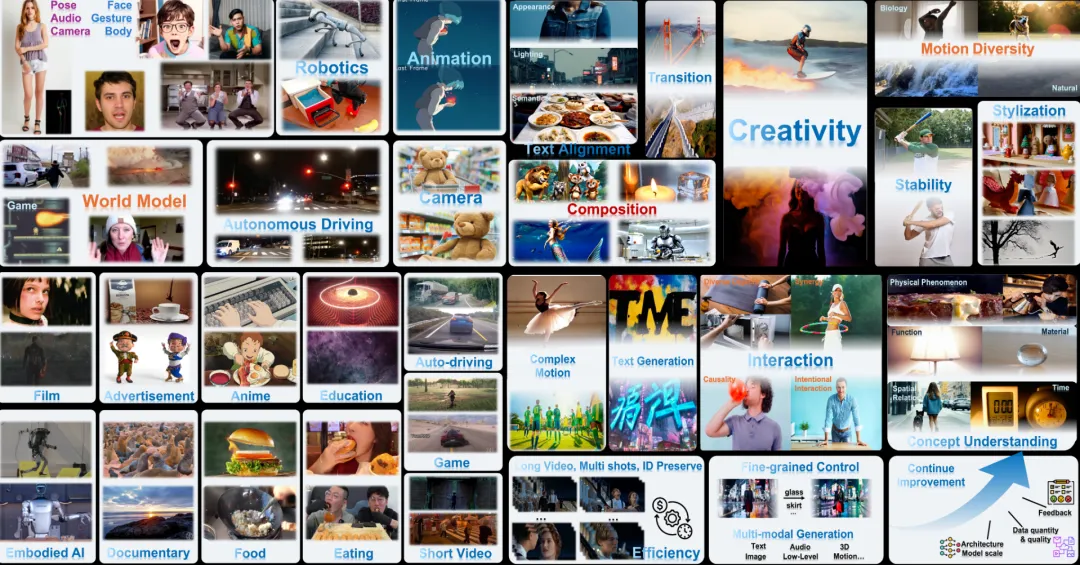

为了更加系统全面地测试,作者团队从多个维度系统地设计了 700 多个生成提示词和图片,分别从 1) 视频垂类场景,2) 多个客观评价角度,3) 十大视频应用场景以及用户需求等角度,从基础能力到应用和落地能力多方面进行了测试设计,评估了 13 个主流模型(包括 10 个闭源和 3 个最新开源模型),生成了超过 8000 个视频案例,以多模型对比可视化地形式直观展示生成效果,帮助大家更好地理解现在模型的能力与不足,作者强调需要关注各个维度的实际例子的比较,而不仅仅是一个数值指标。

图一:视频生成的多维度测评一览

- 论文题目:The Dawn of Video Generation: Preliminary Explorations with SORA-like Models

- 论文链接:https://arxiv.org/pdf/2410.05227

- 网站链接:https://ailab-cvc.github.io/VideoGen-Eval/

这篇文章可以说是现阶段视频生成领域的一次全面梳理和深度评估。之前视频生成测评报告里多用客观数值指标来判断模型的能力,但目前的自动化评估仍然难以完全反映模型的真实表现并且难以对齐人类偏好,同时测评的模型有较大的滞后性,且极少有生成视频的案例梳理,难以体现视频生成研究的前沿性。本文以最直观的测评方式:把测评视频公开,把答案交给读者,强调了人眼观感的重要性,读者可以在网站上直接观看并对比多个模型的生成结果来直观感受。这种 “眼见为实” 的评估方式,也为行业带来了更多的透明性和参考价值,给创作者实实在在带来了更多参考来源。

研究的亮点之一在于对模型在垂直领域中的应用,包括以人为中心的视频生成、机器人、动画插帧、自动驾驶、世界模型、相机可控的视频生成等领域的垂类模型的深入对比。

以下是部分提示词测试结果展示:

文字提示词:这是一个动画视频,中间有一个镜头,显示一个棕色头发的小男孩饿着肚子吃盘子里的鸡蛋和熏肉。那男孩吃得又快又乱,把食物弄到脸上。

文字提示词:三个人谈笑风生,一起向右转,然后右边的两个人蹲了下来,左边的人指着右边的两人。

其次,用数百个提示词测试视频模型在文本对齐、视觉和动作质量、构图美学、组合能力、镜头转场、情感理解、稳定性和创意等客观视频生成能力上的表现。

文字提示词:相机保持静止,男孩挥舞着棒球棍,把棒球打走了。

文字提示词:展示世界上最具标志性的桥梁和高速公路,从金门大桥到中国长城。摄像机跟随车辆穿过这些建筑,突出了它们的建筑辉煌和它们所连接的风景。使用无人机拍摄、路上拍摄和延时拍摄相结合的方式来捕捉这些基础设施的运动和功能。

文字提示词:一个人在网上收到负面反馈,导致他 / 她与焦虑和抑郁作斗争。

文字提示词:超市里的泰迪熊。相机正在逆时针移动。

文字提示词:特写镜头:浓郁的巧克力倾泻而下。流动在倾倒时形成 “TME”。温暖的灯光增强了光泽质感。慢动作捕捉到天鹅绒般的涟漪。随着巧克力令人着迷的下降,相机开始拍摄。

文章的后半部分探讨了使用场景(包括广告电商、动漫、影视、短视频、教育等十大场景)和新任务的探索,这不仅为学术研究提供了重要参考,也为实际视频广泛应用铺平了道路。所有生成结果均公开,并将持续更新,成为新的视频生成基准。

文字提示词:这段视频是一个静态的中镜头,拍摄了一袋浓缩咖啡豆和一个装满咖啡的白色咖啡杯。当咖啡充满杯子时,蒸汽开始上升。

深入比较了开源和闭源模型,目前开源模型的性能还远远不足,强调了差距尤其体现在训练资源、模型规模、数据质量与数量等方面。最后,文章详细列举了视频生成领域面临的挑战和介绍未来的研究方向,包括复杂动作理解与生成、概念理解、交互视频生成、个性化生成、多语种文本生成、多模态视频生成、以及提出持续可改进的视频生成模型等前沿探索性问题。

文字提示词:相机保持静止,该男子用右手拿起桌子上的眼镜。

注:目前图生视频,存在对输入图片的理解不足,以及生成动作困难等问题

文字提示词:一支足球队在赢得比赛后在球场上挤在一起、跳跃和欢呼的动态镜头。相机捕捉到了欢乐和友情。

注:目前视频生成对多人场景生成较差

总的来说,这篇报告不仅系统性地展示了 SORA 类模型的现状,还提供了大量的视频结果分析,特别是在不同场景中的应用表现和未来的研究挑战方面。作者鼓励社区利用这些公开资源进行深入研究,并通过直接观察生成视频,获取更细致的理解,总结共性问题。随着领域的快速发展,报告对未来的突破持乐观态度,并承诺持续更新研究成果,探索更全面的定量评估方法,推动对视频生成领域的更深刻理解。对于视频生成领域的研究人员和开发者来说,这篇文章为理解模型的能力边界、局限性以及未来的研究方向提供了宝贵的参考。

今年初伴随着 Sora 的出现,也是视频生成的元年。从本文的大量视频来看,真的如题目所写 “视频生成的黎明时期”,尚有很多不足但这一年确实进展很快。我们也期待随着技术的迭代进步,以语言交互的方式做视频以及把创作视频内容门槛降低,人人都能释放更多创意和制作高质量视频内容的时代终将到来,到那个时候也许会迎来新一轮 AIGC 生产革命。

回顾近期人工智能的发展,可以看到目前正处于规模化阶段,各公司竞相扩大模型规模,工程执行成为主要任务。未来将进入以研究和创新为主导的第三阶段,数据生产和模型评估将至关重要。单纯出租模型的商业模式可能难以为继,构建模型之上的应用程序和提供模型基础设施将更有前景。

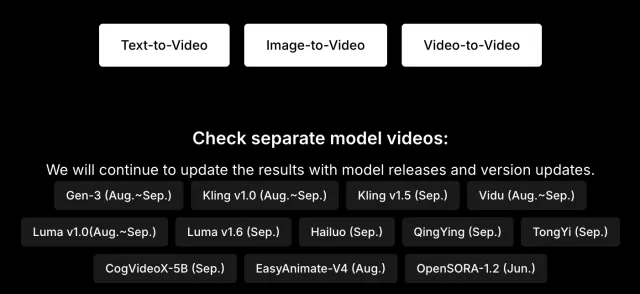

最后划重点:为了方便研究人员和用户更好地查看和对比,作者非常贴心地在网站中分别展示了一个视频对比所有的模型以及单个模型单独查看模式,一次看个够!

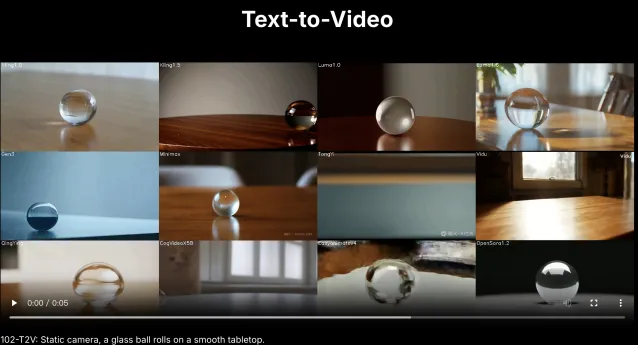

(图二、图三、图四参考原项目查看。)

图二:一个视频对比所有的模型的查看方式

图三:网站贴心地准备了三大任务以及 12 个模型分别的查看入口

图四:点击每个模型的名字,就能单独查看每个模型的视频生成结果了!

针对本文测评的持续更新结果,作者建立了一个专业用户交流群,欢迎感兴趣的读者加入。点击以下链接访问:

https://github.com/AILab-CVC/VideoGen-Eval/blob/main/docs/specifc_model/wechat.md