0. 论文信息

标题:Motion Forecasting in Continuous Driving

作者:Nan Song, Bozhou Zhang, Xiatian Zhu, Li Zhang

机构:Fudan University、University of Surrey

原文链接:https://arxiv.org/abs/2410.06007

代码链接:https://github.com/fudan-zvg/RealMotion

1. 导读

由于每个智能体的下一步行动有许多可能性以及它们在空间和时间上的复杂交互,自动驾驶中智能体的运动预测极具挑战性。在实际应用中,随着自动驾驶汽车的移动,运动预测会重复不断地发生。然而,现有的预测方法通常独立处理一定范围内的每个驾驶场景,完全忽略了连续驾驶场景之间的情境和上下文关系。这极大地简化了预测任务,使得解决方案在实践中不是最佳的和低效的。为了解决这一基本限制,我们提出了一种新的连续驾驶运动预测框架,名为RealMotion。它包括两个完整的场景级流:(1)场景上下文流渐进地累积历史场景信息直到当前时刻,捕捉场景元素之间的时间交互关系。(2)代理轨迹流通过顺序转发过去的预测来优化当前的预测。此外,还引入了数据重组策略,以缩小现有基准和现实应用之间的差距,与我们的网络保持一致。这些方法能够更广泛地利用跨空间和时间的动态运动的情境和渐进的洞察力。在不同设置的Argoverse系列上的大量实验表明,我们的RealMotion实现了最先进的性能,以及高效的真实世界推理的优势。

2. 引言

运动预测是当代自动驾驶系统中的关键要素,它使自动驾驶车辆能够预测周围主体(agent)的运动模式。这一预测对于确保驾驶的安全性和可靠性至关重要。然而,众多复杂因素,包括随机的道路状况和交通参与者多样化的运动模式,使得解决这一任务颇具挑战性。近期的研究聚焦于表征和建模的研究,同时越来越重视精确的轨迹预测。此外,该领域还越来越关注多主体预测这一更具挑战性但更有价值的子任务。这些进展共同推动了近年来运动预测领域的显著进步。推荐课程:面向自动驾驶领域的3D点云目标检测全栈学习路线!(单模态+多模态/数据+代码)。

我们提出了一种用于连续驾驶的高效上下文运动预测框架,名为RealMotion。它包含两个用于场景状态转换的流:(1)场景上下文流,该流逐步累积历史场景上下文,捕捉场景元素之间的时间交互,并应对复杂的驾驶情况。(2)主体轨迹流,该流持续优化车辆等动态主体的预测,考虑时间一致性约束,并捕捉精确的运动意图。每个流都利用专门设计的交叉注意力机制来转换场景状态并实现其功能。

3. 效果展示

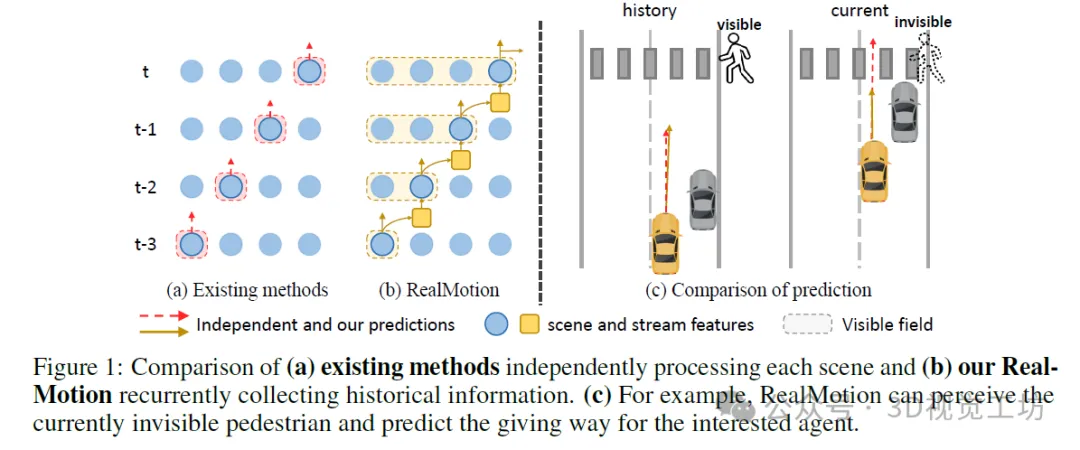

我们意识到现有方法孤立地处理运动预测任务,即它们将有限范围内的每个独立驾驶场景视为互不相关的个体,忽略了在真实情况下,任何自动驾驶车辆在行驶过程中,运动预测本质上都是时间上相互关联的。这意味着先前的方法忽略了连续场景之间的驾驶上下文,以及来自先前驾驶时段的相应潜在有用信息(图1)。

4. 主要贡献

我们的贡献总结如下:(i)我们从实际应用的角度出发解决运动预测问题,这使得能够提取和利用有价值的情境知识和渐进知识。(ii)我们引入了RealMotion,这是一种新颖的运动预测方法,它随时间顺序利用场景上下文和预测的主体运动状态,同时保持较低的现实世界推理延迟。(iii)为了支持在现有基准上的连续驾驶设置,我们实现了一种数据重组策略来生成场景序列,紧密模拟现实世界中的驾驶场景。在Argoverse系列数据集上进行的大量实验表明,在不同设置下,RealMotion均达到了最先进的性能。

5. 方法

鉴于现有基准测试与实际应用之间的差异,我们的首要步骤是对这些数据集进行重新组织,将每个样本场景转换为连续序列,以模拟连续的真实驾驶场景。具体而言,我们通过将智能体轨迹均匀分割为较短的片段并采样局部地图元素(参见图2),来回顾性地检查每个独立场景。具体来说,我们首先沿着历史帧步骤选择几个分割点Ti。然后,从这些点分别向过去和未来延伸,生成等长的轨迹片段。历史和未来步骤的数量分别由最小分割点和真实轨迹的长度决定。此外,在每个分割点,我们为感兴趣的智能体聚合一定范围内的周围智能体和局部地图,形成一系列子场景。这种重新组织方式能够自由利用原始元素,从而在场景层面为模型优化提供有价值的环境信息和渐进见解。因此,现有方法也可以引入这种新型数据结构并从中受益。

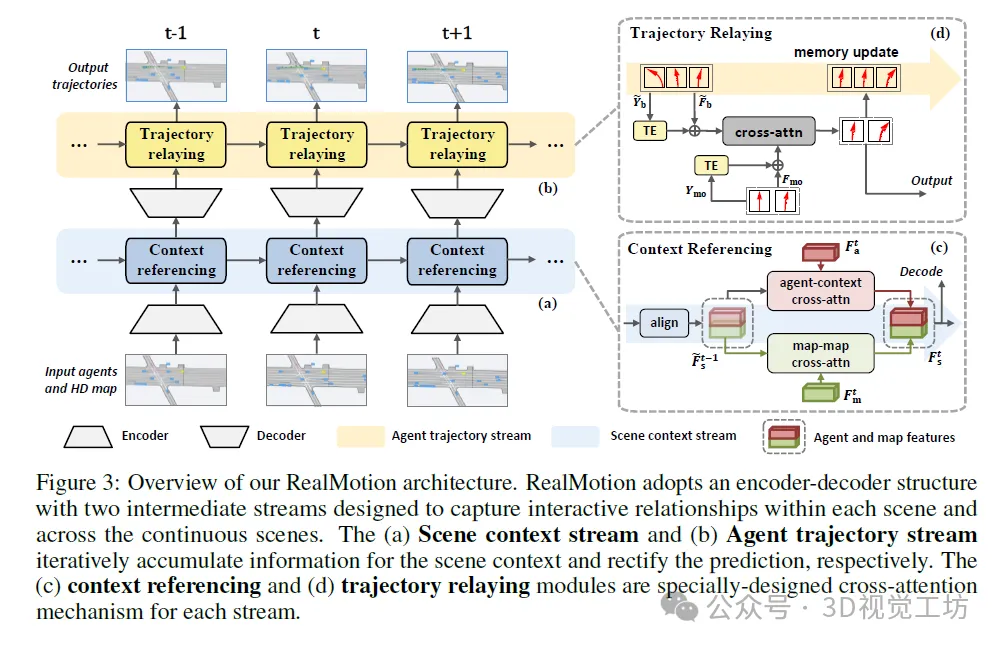

如图3所示,我们的RealMotion方法包括编码器、解码器、场景上下文流和智能体轨迹流。遵循编码器-解码器结构,这两个流被设计为执行时序建模,重点关注时间维度上的上下文信息和轨迹预测。

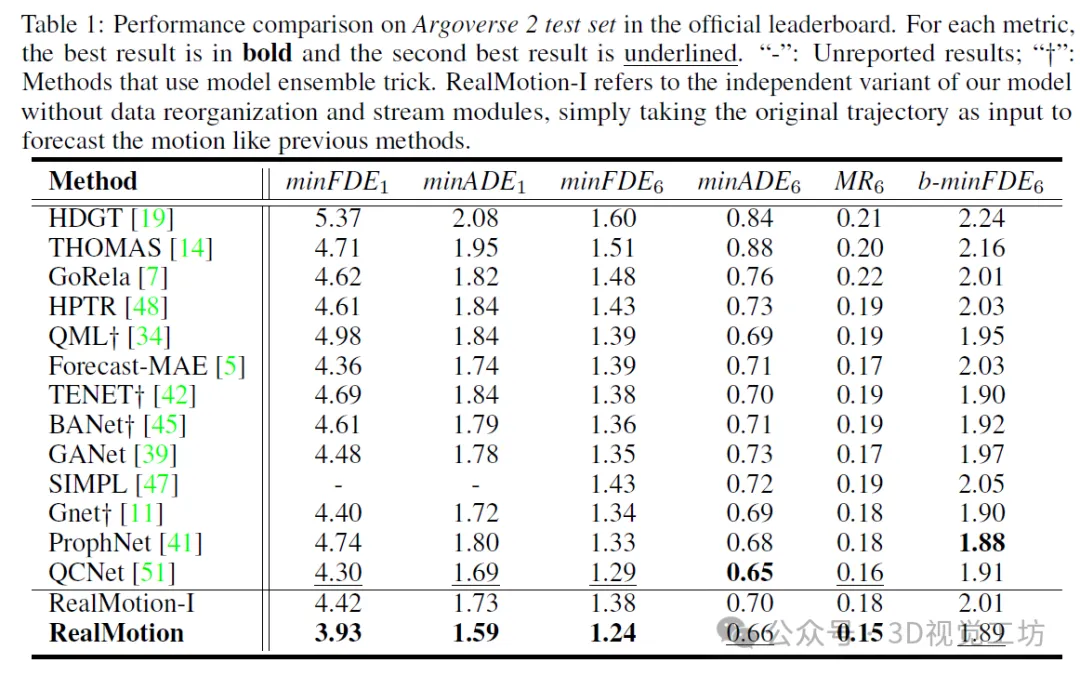

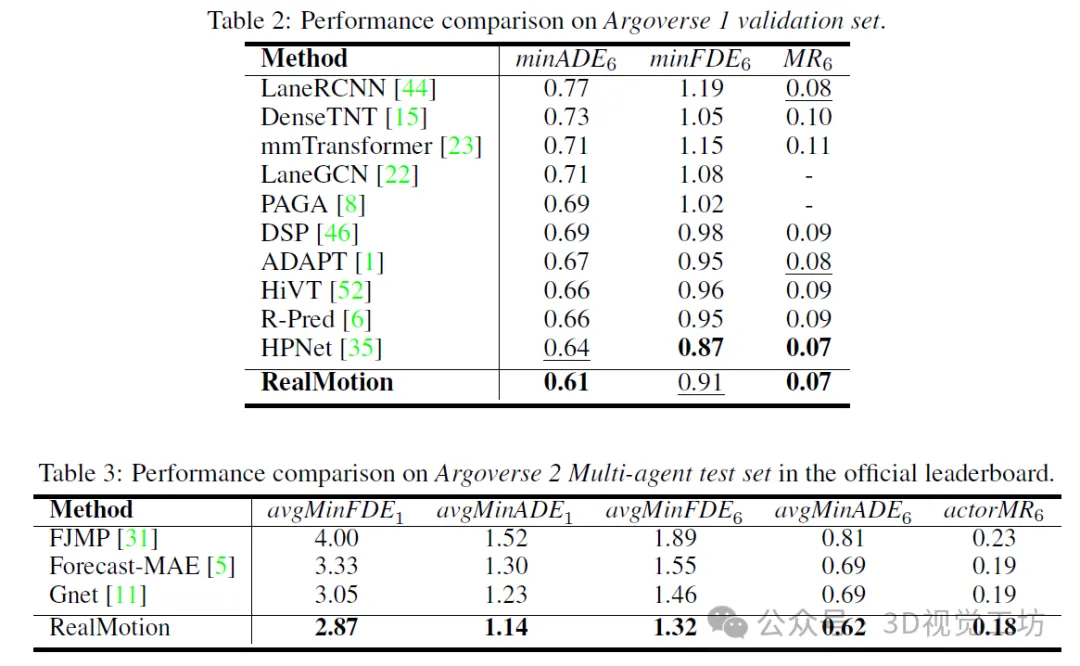

6. 实验结果

7. 总结 & 局限性

在本文中,我们计划从更贴近实际的连续驾驶角度出发来解决运动预测任务。这本质上相较于之前的设定,将运动预测功能置于了一个更广泛的场景背景中。我们进一步提出了RealMotion,这是一个专为支持在时空上连续进行预测动作而设计的通用框架。我们框架的关键组件包括场景上下文流和代理轨迹流,这两者都以序列化的方式工作,并逐步捕捉时间关系。我们在多种设定下进行了广泛的实验,全面证明了RealMotion超越了当前最先进的性能水平,从而为快速发展的自动驾驶领域中的安全可靠运动预测提供了一个有前景的方向。

我们数据处理方法的一个明显限制是需要足够数量的历史帧来进行序列化。因此,它不适用于如Waymo Open Dataset等仅提供10帧历史轨迹的短期基准测试。此外,现有的数据集通常提供的历史信息与真实世界场景差异较大且有限,这阻碍了我们的序列化设计充分发挥其优势。因此,我们期望在未来的工作中将我们的框架集成到序列化的自动驾驶系统中,以最大化流式设计的效益。