如何有效地将真实数据扩展到模拟数据,进行机器人学习?

最近,李飞飞团队提出一种「数字表亲」的新方法,可以同时降低真实到模拟生成的成本,同时提高学习的普遍性。

项目主页:https://digital-cousins.github.io/

论文地址:https://arxiv.org/abs/2410.07408

目前,论文已被CORL2024接收。

你可能会问,什么是「数字表亲」,有啥用呢?

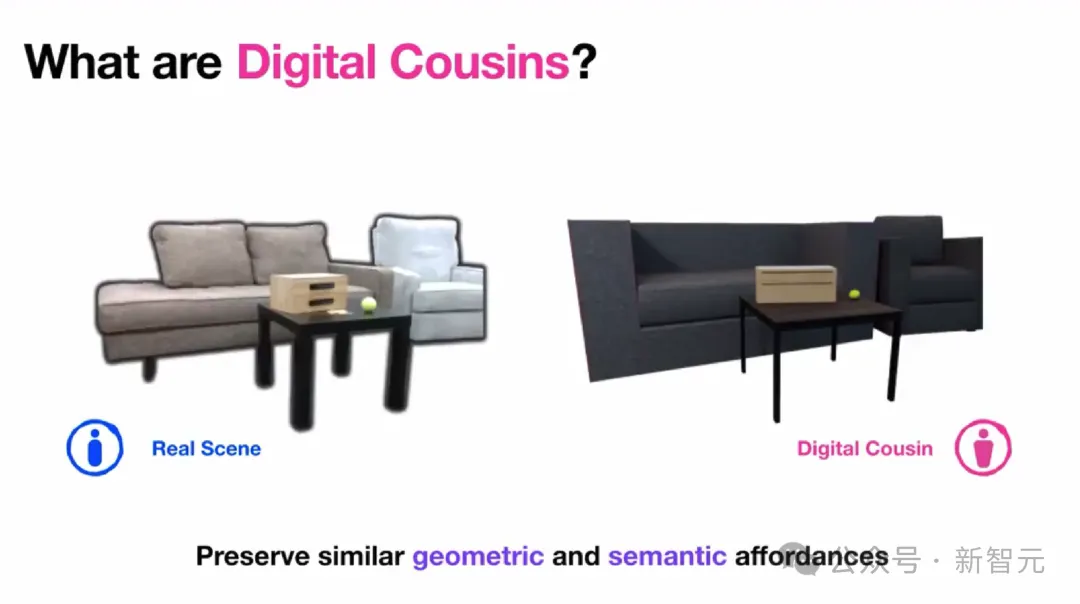

让我们把它跟数字孪生比较一下。

的确,数字孪生可以准确地对场景进行建模,然而它的生成成本实在太昂贵了,而且还无法提供泛化功能。

而另一方面,数字表亲虽然没有直接模拟现实世界的对应物,却仍然能够捕获相似的几何和语义功能。

这样,它就大大降低了生成类似虚拟环境的成本,同时通过提供类似训练场景的分布,提高了从模拟到真实域迁移的鲁棒性。

共同一作Tianyuan Dai表示,既然有免费的「数字表亲」了,何必再去手工设计数字孪生?

亮眼的是,「数字表亲」能同时实现——

- 单幅图像变成交互式场景

- 全自动(无需注释)

- 机器人策略在原始场景中的零样本部署

简单拍一张照片,就能搞定了

模拟数据难题:与现实环境差异过大

在现实世界中训练机器人,存在策略不安全、成本高昂、难以扩展等问题;相比之下,模拟数据是一种廉价且潜在无限的训练数据来源。

然而,模拟数据存在一个难以忽视的问题——与现实环境之间的语义和物理差异。

这些差异可以通过在数字孪生中进行训练来最小化,但数字孪生作为真实场景的虚拟复制品,同样成本高昂且无法跨域泛化。

正是为了解决这些限制,论文提出了「数字表亲」(digital cousion)的概念。

「数字表亲」是一种虚拟资产或场景,与数字孪生不同,它不明确模拟现实世界的对应物,但仍然展现类似的几何和语义功能。

因此,数字表亲既具备了数字孪生的优势,能够补足现实数据的不足,同时降低了生成类似虚拟环境的成本,并能更好地促进跨域泛化。

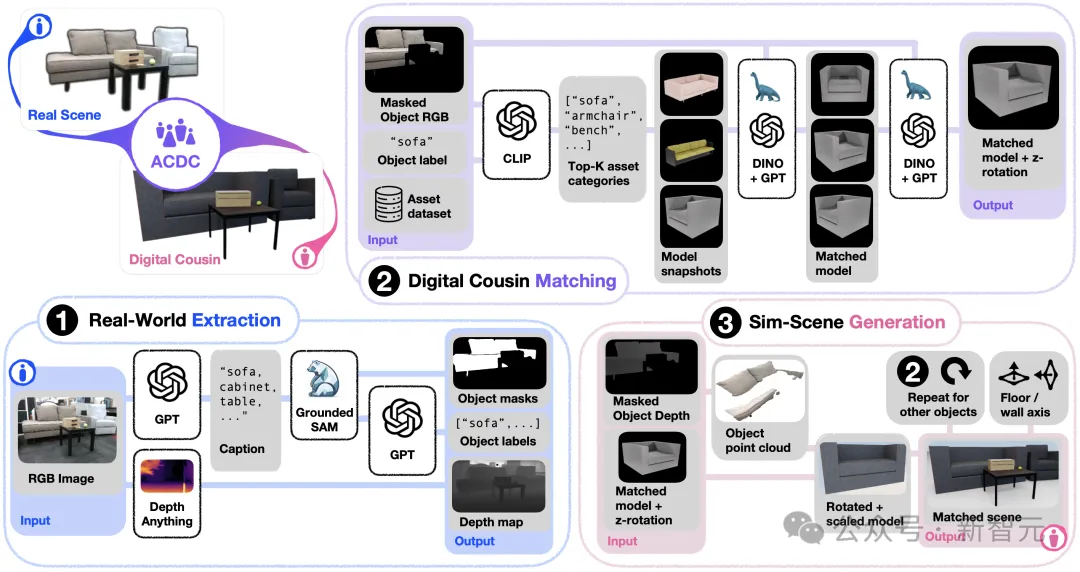

具体而言,论文引入了一种自动创建数字表亲(Automatic Creation of Digital Cousins,ACDC)的新方法,并提出了一个完全自动化的,从真实到模拟再到真实的流程,用于生成交互式场景和训练策略。

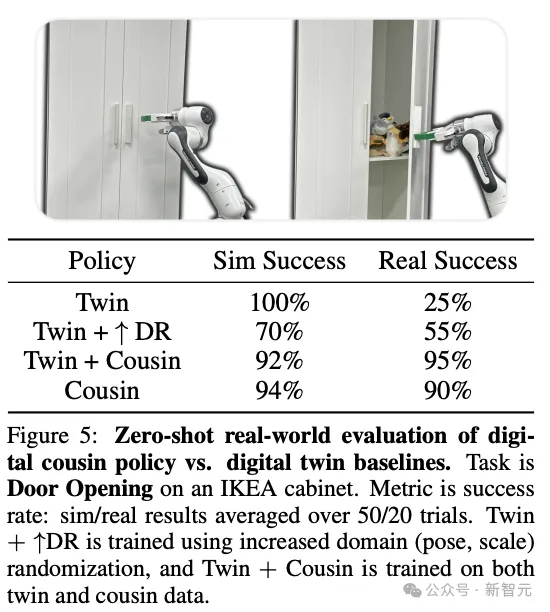

实验结果发现,ACDC生成的数字表亲场景能够保留几何和语义功能,训练出的策略也优于数字孪生(90% vs. 25%),而且可以通过零样本学习直接部署在原始场景中。

方法概述

与数字孪生不同,数字表亲并不苛求在所有微小细节上都要重建给定场景,而是专注于保留更高级别的细节,例如空间关系和语义。

ACDC是一个完全自动化的端到端流程,从单个RGB图像生成完全交互式的模拟场景,由三个连续步骤组成:

- 信息提取:首先,从输入的RGB图像中提取对象信息。

- 数字表亲匹配:利用第一步提取的信息,结合预先准备的3D模型资产数据集,为检测到的每个对象匹配相应的数字表亲。

- 场景生成:对选择的数字表亲进行后处理并编译在一起,生成一个物理上合理且完全交互式的模拟场景。

通过这三个步骤,ACDC能够自动创建与输入图像语义相似但不完全相同的虚拟场景,为机器人策略训练提供多样化的环境。

策略学习

构建了一组数字表亲后,就可以这些环境中训练机器人策略。

虽然这种方法适用于多种训练范式,例如强化学习或模仿学习,但本文选择聚焦于于脚本演示(scripted demonstrations)的模仿学习,因为这种范式不需要人类演示,与完全自主化的ACDC流程更加适配。

为了能在模拟环境中自动实现演示的收集,作者首先实施了一组基于样本的技能,包括Open(开)、 Close(关)、 Pick(拿)和Place(放)四种。

虽然技能的种类数仍然有限,但已经足够收集各种日常任务的演示,例如对象重新排列和家具铰接。

实验

通过实验,团队回答了以下研究问题:

- Q1:ACDC能否生成高质量的数字表亲场景?给定单张RGB图像,ACDC能否捕捉原始场景中固有的高级语义和空间细节?

- Q2:在原始的环境设置上评估时,在数字表亲上训练的策略能否匹配数字孪生的性能?

- Q3:在分布外设置上评估时,在数字表亲上训练的策略是否表现出更强的稳健性?

- Q4:在数字表亲上训练的策略能否实现零样本的sim2real策略迁移?

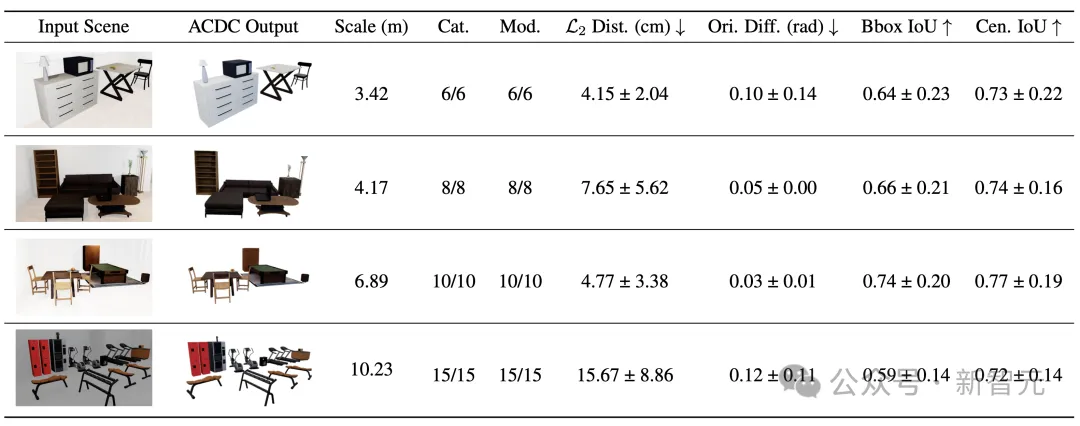

通过ACDC进行场景重建

首先团队需要论证的最重要的问题,就是ACDC能生成高质量的数字表亲场景吗?

从表格中的数据来看,结果十分令人满意。

以下是在sim-to-sim场景中对ABCD场景重建进行的定量和定性评估。

在sim2sim场景中对ACDC进行场景重建的定量和定性评估

评估指标包括:

- 「Scale」:输入场景中两个对象边界框之间的最大距离。

- 「Cat.」:正确分类对象占场景总对象总数的比例。

- 「Mod.」:正确建模对象占场景中对象总数的比例。

- 「L2 Dist.」:输入和重建场景中边界框中心间欧几里得距离的均值和标准差。

- 「Ori. Diff.」:每个中心对称对象方向幅度差异的均值和标准差。

- 「Bbox IoU」:资产3D边界框的交并比(IoU)。

以下是ACDC实景到模拟场景的重建结果。

在给定场景中,会显示多个数字表亲。

ACDC真实到模拟场景重建结果的定性评估,展示了为给定场景生成的多个数字表亲

基于这些结果,研究者可以肯定地回答Q1了——

ACDC确实能够保留输入场景的语义和空间细节,从单张RGB图像生成真实世界对象的数字表亲,并能准确定位和缩放以匹配原始场景。

sim2sim的策略学习

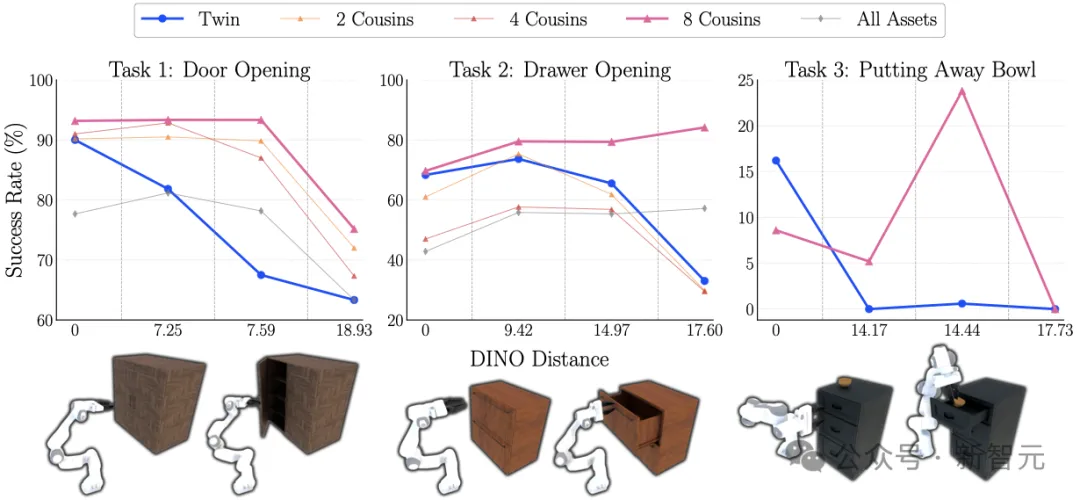

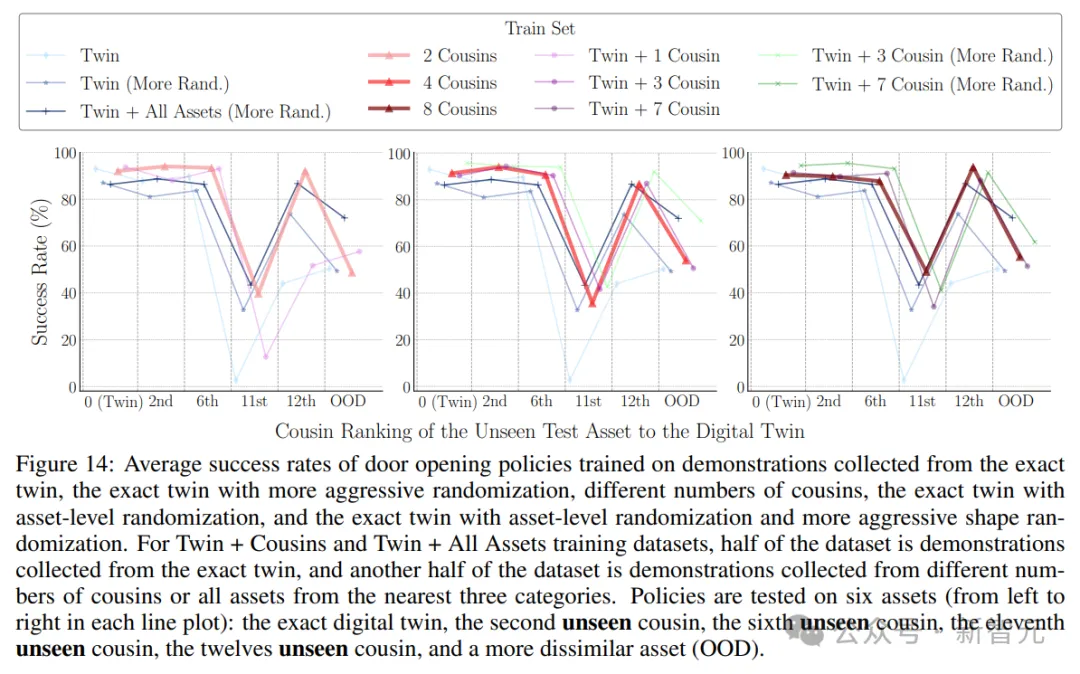

这部分的实验主要是为了回答上述研究中的Q2和Q3,在3个任务上分析ACDC训练策略的能力,包括「开门」、「打开抽屉」和「收起碗」,每项任务都与数字孪生设置进行了对比。

不同设置中的总体成功率如下图所示。

可以发现,在数字表亲上训练的策略通常可以匹配,甚至优于数字孪生的设置。

作者假设,由于数字表亲的策略是在不同环境设置的数据上进行训练的,因此可以覆盖广泛的状态空间,从而很好地推广到原始数字孪生设置。

然而,在另一个极端,针对所有可行资产(All Assets)进行训练场的策略要比数字孪生差得多,这表明朴素的领域随机化并不总是有用的。

此外,随着DINO嵌入距离的增加,即评估设置与原始设置的差异逐渐增大,数字孪生的策略性能通常会出现成比例的显著下降,但数字孪生策略整体表现更加稳定,证明了在分布外设置上的鲁棒性。

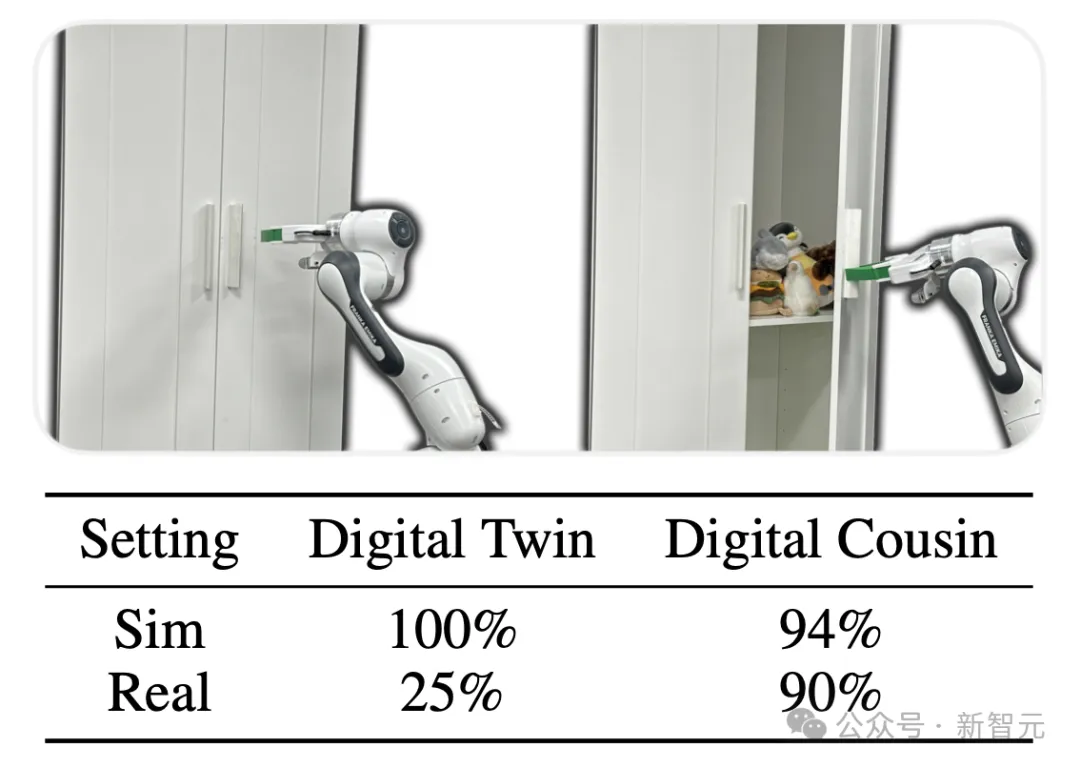

sim2real的策略学习

随后,研究者对数字孪生和数字表亲策略进行了零样本现实世界评估。

任务是给宜家柜子上开门。

评估指标就是成功率。

结果显示,模拟结果平均超过50次试验,真实结果平均超过20次试验。

real2sim2real的场景生成和策略学习

无论是数字孪生还是数字表亲,最终的落脚点还是要在真实环境中对比性能。

因此实验的最后,团队在完全真实(in-the-wild)的厨房场景中端到端地测试了完整的ACDC管道和自动化策略学习框架。

在经过数字表亲的专门模拟训练后,机器人可以成功打开厨房橱柜,证明了ACDC方法迁移到真实环境中的有效性。

以下Demo展示了完全自动化的数字表亲生成过程。

左右滑动查看

零样本的sim2real策略迁移实验表明,仅从上述生成的四个数字表亲训练的模拟策略,可以直接迁移到相应的真实厨房场景。

基于这些结果,研究者可以肯定地回答Q2、Q3和Q4了——

使用数字表亲训练的策略,表现出了与在数字孪生上训练策略相当的分布内性能,以及更强的分布外鲁棒性,并且可以实现零样本从模拟到现实的策略迁移。

失败案例

即使ACDC方法表现出了整体上的优越性能,研究团队也在实验中观察到了几个失败案例,例如:在打开柜子的任务中,机器人未能完全移动到把手所在位置——

或者移动时错过把手——

即使正确找到了把手所在位置,也有可能手滑——

可以观察到,ACDC经常在以下几种情况下陷入困境:

a. 高频深度信息

b. 遮挡

c .语义类别差异

d. 缺乏相应类别的资产

e. 除「位于顶部」之外的对象关系

前三个限制,与ACDC的参数化方式直接相关。

比如对于(a),由于ACDC依赖于相对准确的深度估计,来计算预测的对象3D边界框,因此不准确的深度图可能会导致ACDC对物体模型的估计相应较差。

原生深度传感器在物体边界附近可能难以产生准确的读数,这是因为深度图在这些区域可能出现不连续性。当物体具有许多精细边界时(例如植物和栅栏),这个问题会变得更加复杂。

此外,由于研究者依赖现成的基础模型(DepthAnything-v2)来预测合成深度图,因此也承袭了模型自身的一系列限制,例如对特殊物体或在不利的视觉条件下的预测较差。

结论

最终,研究者得出了以下结论。

ACDC是一个全自动化管线,能够快速生成与单张真实世界RGB图像相对应的完全交互式数字表亲场景。

研究发现:

1. 鲁棒性

在这些数字表亲设置上训练的策略,比在数字孪生上训练的策略表现出更强的鲁棒性。

为了进一步检查数字表亲对朴素域随机化的相对影响,研究者根据其他基线在 DoorOpening任务上重新运行了sim2sim实验

2. 性能对比

- 领域内性能:数字表亲训练的策略与数字孪生训练的策略相当。

- 领域外泛化:数字表亲训练的策略展现出优越的领域外泛化能力。

3. 零样本学习

数字表亲训练的策略能够实现零样本从模拟到现实的策略迁移。

作者介绍

Tianyuan Dai

Tianyuan Dai本科毕业于香港科技大学,获得了计算机科学和数学学士学位,目前在斯坦福攻读硕士学位,隶属于斯坦福SVL实验室(Vision and Learning Lab)和PAIR研究小组(People, AI & Robots Group),由李飞飞指导。

他的长期愿景是将人类对现实世界环境的理解融入到机器人算法中,使用数据驱动的方法帮助人们完成日常任务;最近研究的重点是开发real2sim2real范式,以实现稳健的操控策略学习(manipulation policy learning)。

Josiah Wong

Josiah Wong目前在斯坦福大学攻读机械工程博士学位,导师是李飞飞,同样在SVL和PAIR组工作。

此前,他在斯坦福大学获得硕士学位,在加利福尼亚大学圣迭戈分校获得学士学位。

他致力于利用仿真技术来拓展机器人操作能力,目标是推动日常通用机器人的发展,从而改善我们的日常生活。