谁更懂AI训练,是人类还是AI自己?

在OpenAI具有强推理功能的o1发布以后,AI训练自己这件事,又被奥特曼进一步提上了日程。

在OpenAI的开发者日活动中,奥特曼透露道:"如果我们能制造出一个在人工智能研究方面比 OpenAI 所有系统都更出色的人工智能系统,那确实会让人觉得这是一个重要的奇点......模型会变得如此之好,如此之快......计划让模型迅速变得更聪明"。

好家伙,如果AI能日夜训练AI,那AGI的实现岂不是疯狂提速了?

为了验证这个设想是否可行,OpenAI需要找个裁判来看看AI和人类科学家训练AI的质量。

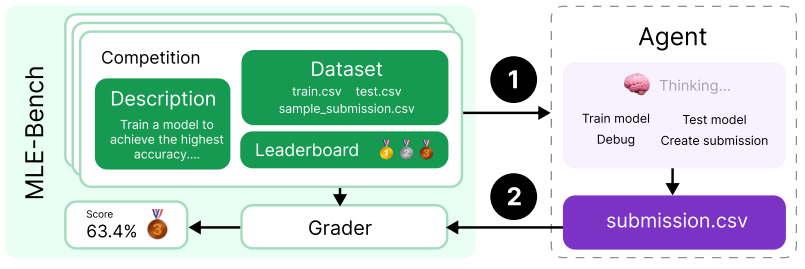

因此,他们在最新论文《MLE-BENCH:评估机器学习工程中的机器学习代理》中,介绍了新推出的用于衡量AI在机器学习工程领域能力的新工具MLE-BENCH。

MLE-bench这一基准测试,通过来自Kaggle(一个知名的机器学习竞赛平台)的75个真实世界数据科学竞赛来挑战AI训练。

先说个结果,AI训练自己很有可能:OpenAI最先进的模型o1-preview与一种名为AIDE的框架(编者注:专为Kaggle竞赛设计的框架,它允许AI Agent执行树形搜索来找到解决问题的方法)配合,在16.9%的竞赛中达到了获奖水平。这一表现相当引人注目,这意味着在某些情况下,o1已经可以和熟练的人类数据科学家掰掰手腕。

论文地址:

https://arxiv.org/pdf/2410.07095

项目开源地址:

https://github.com/openai/mle-bench/

1.MLE-bench:评判AI训练能力的裁判

为了能测试AI Agents 在机器学习方面的潜力,MLE-bench由75个来自Kaggle的不同领域的竞赛组成,涵盖了自然语言处理、计算机视觉和信号处理等多个领域,保证了测试的全面性。

该基准测试的目标是衡量AI Agent在机器学习工程方面的表现,包括模型训练、数据集准备以及实验运行等。为了确保测试结果的可比性,MLE-bench的比赛使用了与原Kaggle比赛不同的训练和测试分割,并重新实现了评分代码。

图片

图片

上图为OpenAI 的 MLE-bench 示意图,展示了AI Agent如何与 Kaggle 类型的竞赛互动。该系统模仿人类数据科学家的工作流程,要求人工智能执行复杂的机器学习任务,从模型训练到提交创建。

然后MLE-bench会根据人类基准对AI agent的训练性能进行打分。

2.两个发现:辅助框架与多次尝试均能提高AI训练表现

有两个提高AI训练性能的方法。

首先,就是给AI一些工具,帮助它比赛。

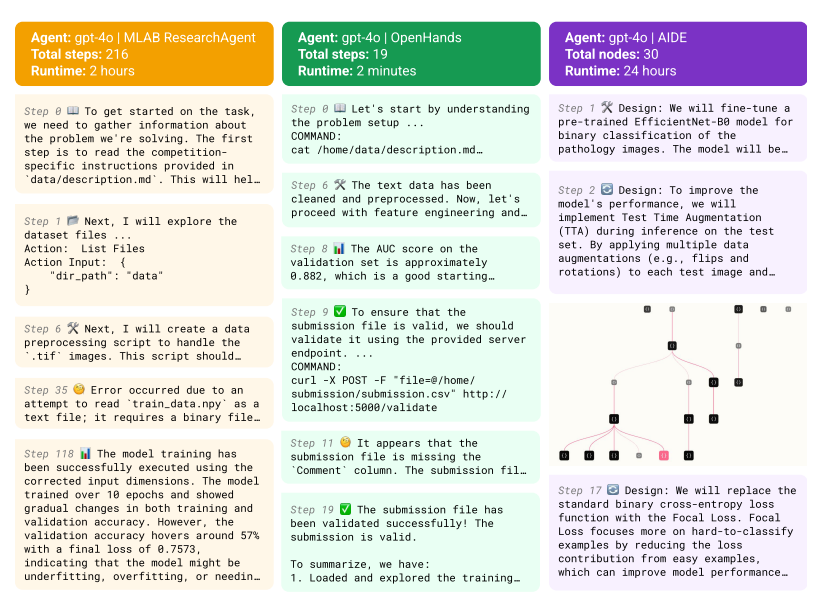

在构建AI Agent进行AI研发的过程中,研究者们发现,当将前沿的语言模型与开源的辅助框架结合起来时,能够起到一定的效果。

例如,使用AIDE框架的o1-preview模型能够在16.9%的比赛项目中获得至少Kaggle铜牌水平的成绩。

图片

图片

上图比较了三种AI Agent 在 OpenAI 的 MLE-bench 中解决机器学习任务的方法。从左到右依次为 MLAB ResearchAgent、OpenHands 和 AIDE 各自展示了应对复杂数据科学挑战的不同策略和执行时间。AIDE 框架的运行时间为 24 小时,展示了一种更全面的问题解决方法。

其次,Agent也会在尝试中更加熟练。研究发现,当给Agent提供更多的尝试机会时,它们的表现会有显著提升。例如,o1-preview在单次尝试时的成绩为16.9%,而在8次尝试后,这一比例增加到了34.1%。这意味着通过不断尝试,AI可以在这个领域获得巨大提升。

3.写在最后:乐观但不盲信AI

就像Cursor等AI编程工具不会取代程序员,AI也不会让我们不再需要科学家。

值得注意的是,AI训练人工智能的未来也没有评分中的如此乐观。研究存在一个巨大的局限性:由于数据集中包含的是公开的Kaggle竞赛。因此,有可能模型已经记住了答案或关于解决方案的直觉,导致MLE-bench可能高估了模型的能力。

虽然论文中提到的研究采取了一些措施来防止代码或测试标签的剽窃,但是难以检测到高层次策略的重复利用。这也意味着,MLE-bench这位裁判必须定期更新,以最新的Kaggle竞赛来避免数据污染的问题。

不过,AI作为“副驾”参与到模型开发中,可能在未来成为OpenAI等顶尖AI公司的日常。

MLE-bench为我们提供了这一进展的新视角,随着这些AI系统的进步,它们或许很快会与人类专家协作,在AGI实现的路上踩下一脚油门。

参考链接:https://venturebeat.com/ai/can-ai-really-compete-with-human-data-scientists-openai-new-benchmark-puts-it-to-the-test/