数据空间研究中心是中国科学技术大学网络空间安全学院布局建设的创新型科研平台。中心于 2021 年 9 月 20 日正式揭牌成立,由吴曼青院士领衔、中青年教师为骨干,聚焦从数据到网络空间(From Data to Cyberspace),以数据重构网络空间为使命,瞄准网络空间、智能感知、大数据等领域的前沿问题,探索打造一支结构合理、优势互补的科技力量,服务国家重大需求。

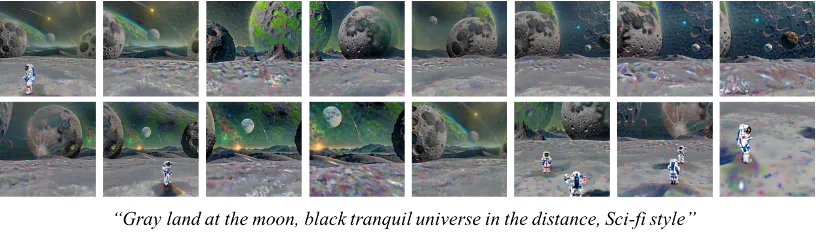

来自中国科学技术大学数据空间研究中心、香港科技大学、香港理工大学以及奥胡斯大学的研究者们提出一种新的场景生成方法 DreamScene,只需要提供场景的文本就可以生成高质量,视角一致和可编辑的 3D 场景。

- 项目主页:https://dreamscene-project.github.io/

- 论文地址:https://arxiv.org/abs/2404.03575

- 代码开源:https://github.com/DreamScene-Project/DreamScene

关键问题

基于蒸馏的文本生成 3D 方法通常采用预训练的 2D 文本到图像模型如 Stable Diffusion 作为先验,通过朝向物体中心的相机渲染优化生成物体的可微分 3D 表示。而文本生成 3D 场景方法需要从预定义的相机位置向外渲染,以生成这些有限视角的场景。

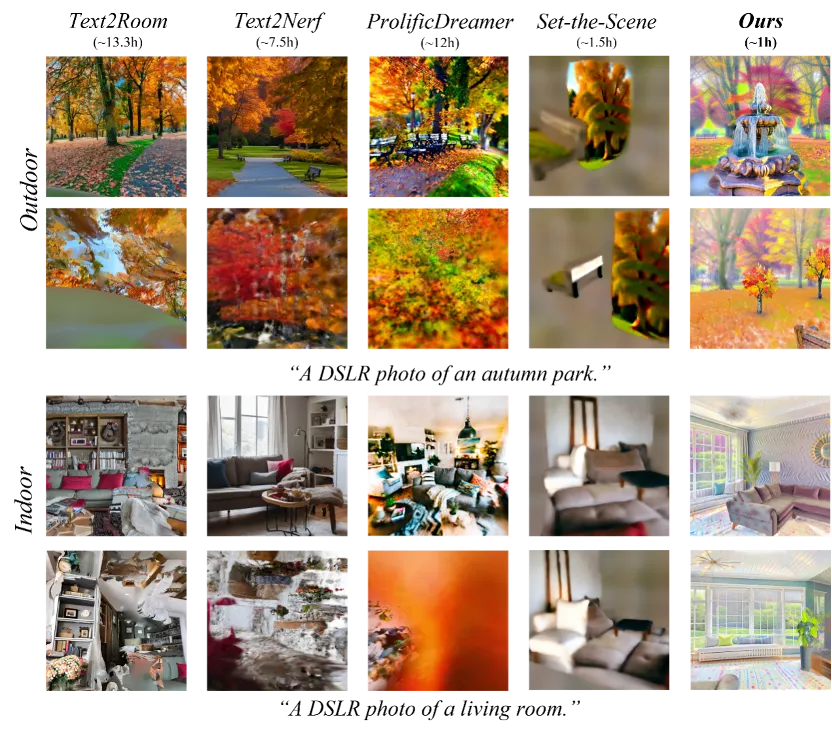

目前的文本生成 3D 场景方法(如下图所示)面临几个关键挑战,包括:

- 低效的生成过程,常导致低质量的生成和较长的生成时间。

- 不一致的 3D 场景视角,仅在有限视角下有着良好的渲染结果。

- 无法将物体与环境分离,无法对单个物体进行灵活编辑。

技术方案

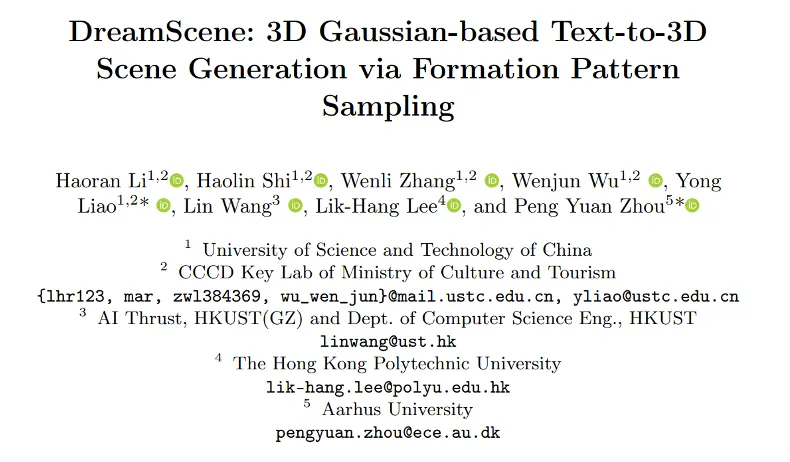

DreamScene 主要由形成模式采样(Formation Pattern Sampling)和相机采样 (Camera Sampling) 两部分组成,其中形成模式采样根据 3D 模型生成的规律由多时间步采样(Multi-timestep Sampling)、3D 高斯过滤(3D Gaussian Filtering)以及重建式生成(Reconstructive Generation)三种操作组成;

相机采样通过三阶段的策略逐步生成 3D 环境,保证场景全局的视角一致性。总体的算法流程如图所示,DreamScene 首先利用大语言模型(LLM)根据文本描述(prompt)分离出场景中的物体描述和环境描述。首先生成场景中的单个物体,DreamScene 利用 Point-E 得到相应的初始化点云,之后使用形成模式采样方法生成对应文本的 3D 表示;再将生成的物体根据布局放置在对应的位置上;最后对四周环境进行生成,DreamScene 将室内场景初始化为长方体,将室外场景初始化为半球体,通过三阶段优化,逐步优化远处环境,近处地面和整体的场景。

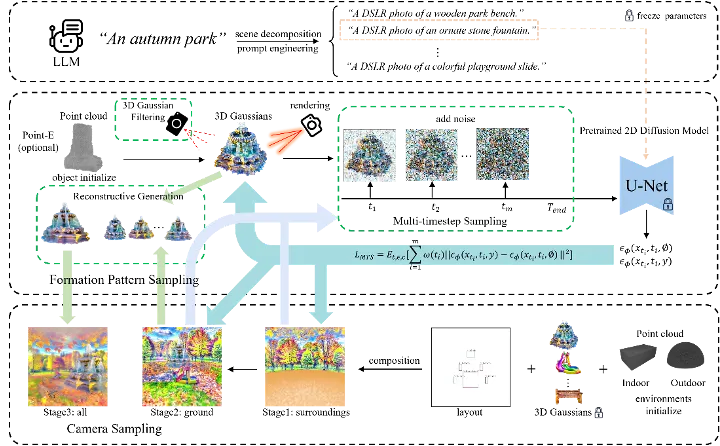

形成模式采样(Formation Pattern Sampling)主要使用多时间步采样(Multi-timestep Sampling),多时间步采样每次迭代过程中混合了多个 2D 扩散模型时间步长提供的指导信息,而这些时间步长通过在一个线性递减的滑动窗口上进行分层抽样得到,这种优化策略不仅保证了在优化过程中对 3D 内容的形状约束,同时可以丰富语义信息。

此外,生成的过量 3D 高斯会阻碍优化过程,因此 DreamScene 使用 3D 高斯过滤(3D Gaussian Filtering)在优化过程中过滤掉冗余的 3D 高斯,保留距离渲染平面较近且体积较大的 3D 高斯。在优化的后期阶段,使用较小步长 t 的信息可以提供一致但是精细纹理的信息,所以 DreamScene 使用重建式生成(Reconstructive Generation)方法来加速生成 3D 内容的合理表面纹理。

对于场景中的环境,DreamScene 使用一个渐进式的三阶段相机采样(Camera Sampling)策略优化环境生成。在相机采样的第一阶段,DreamScene 在场景中心的一定范围内进行相机位姿采样以生成周围环境(室内的墙壁、室外远处环境)的粗略表示(MTS 指导优化);在第二阶段,DreamScene 通过采样一些特定区域的相机位姿来生成粗糙的地面,并且会尽可能保证地面与周围环境接触部分的连贯性;在第三阶段,DreamScene 使用在前两阶段中所有的相机位姿来优化所有的的环境元素(MTS 指导优化),之后使用 3D 重建的方法以获得更合理的纹理和细节。

实验评估

对比试验 下图展示了 DreamScene 场景生成的定性对比实验,上半部分图像采用生成时出现的相机位姿渲染的,下图是在场景中随机选择的相机位姿渲染的。我们可以看到,Text2Room 和 Text2NeRF 只能在生成过程中遇到的相机位姿下生成令人满意的结果,DreamScene 实现了最佳的 3D 一致性,同时有着很高的生成质量。

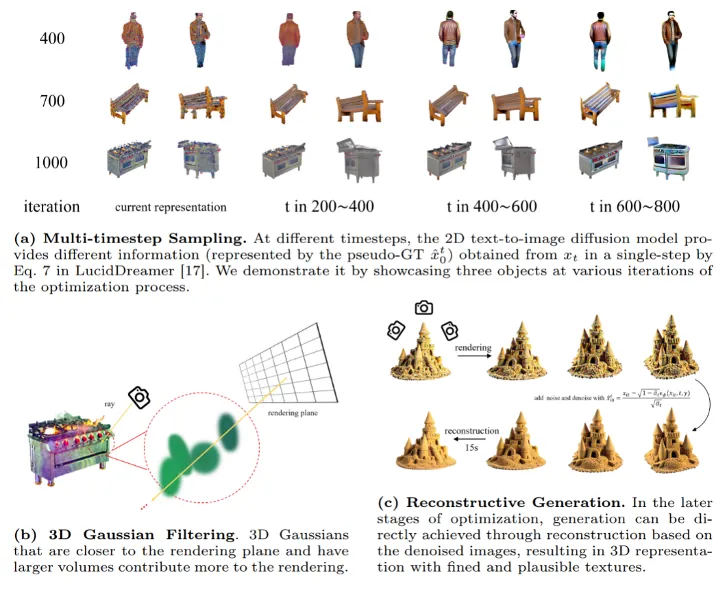

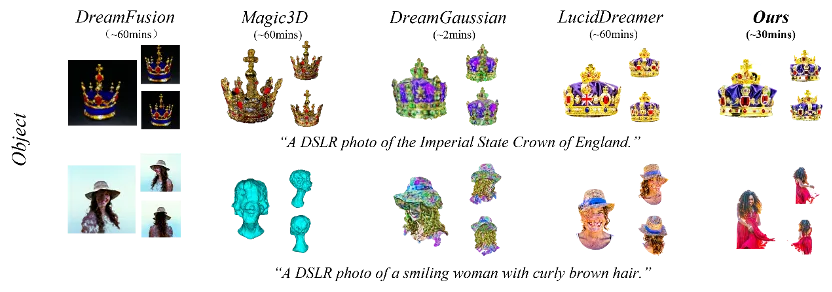

下图展示了形成模式采样可以在短时间内根据文本提示生成高质量的 3D 表示,DreamGaussian 的速度更快但生成质量太低。

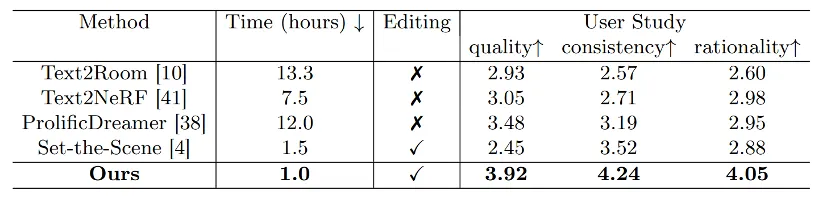

作者计算了环境生成阶段的生成时间。如下表的左侧显示,具有编辑功能的环境生成方法中 DreamScene 的时间最短,右侧显示了用户研究,其中 DreamScene 在一致性和合理性方面明显优于其他 SOTA 方法,生成质量最高。

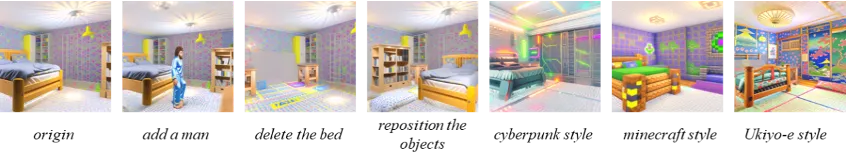

一致性 如下图所示 DreamScene 的生成结果在较高生成质量的同时,保证了较好的 3D 一致性。

编辑性 DreamScene 可以添加或删除对象或者通过调整对象的仿射变量的值来重新设计其在场景中的位置。在进行这些编辑时,用户需要在物体的原始位置和新位置重新采样相机姿势,重新优化地面和周围方向。此外,用户还可以改变文本提示来改变场景中的环境或对象的样式。

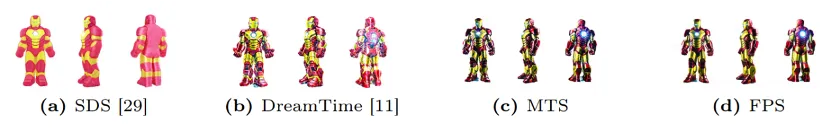

消融实验 在 “A DSLR photo of Iron Man” 提示下,经过 30 分钟优化后的结果。如下图所示,与 DreamTime 和 DreamFusion 中提到的分数蒸馏采样 (SDS) 相比,多时间步采样形成了更好的几何结构和纹理。形成模式采样是在多时间步采样的基础上建立起来的,采用重建式生成的方法来创建更加合理的纹理结构,在指导 3D 内容优化方面十分具有优越性。

总结

本文介绍了一种新颖的文本到 3D 场景生成策略 DreamScene。通过生成模式采样和相机采样策略,将物体和环境整合在一起,解决了目前文本到 3D 场景生成方法中存在的低效、不一致和可编辑性有限等问题。广泛的实验证明,DreamScene 是三维场景生成领域的一项里程碑式成就,在众多领域,如游戏、影视和房屋设计中有着巨大的应用潜力。