经过一年多的发展大模型已融入了我们的日常工作中,但是大模型经常会输出一些不符合约束的结果,本文将给出一份详尽的指南,介绍如何管理和指导大型语言模型(LLM)进行文本生成的各类技术和方法,着重于理论支撑与实践操作。

大模型可控文本生成(CTG)综述

图片

图片

图片

图片

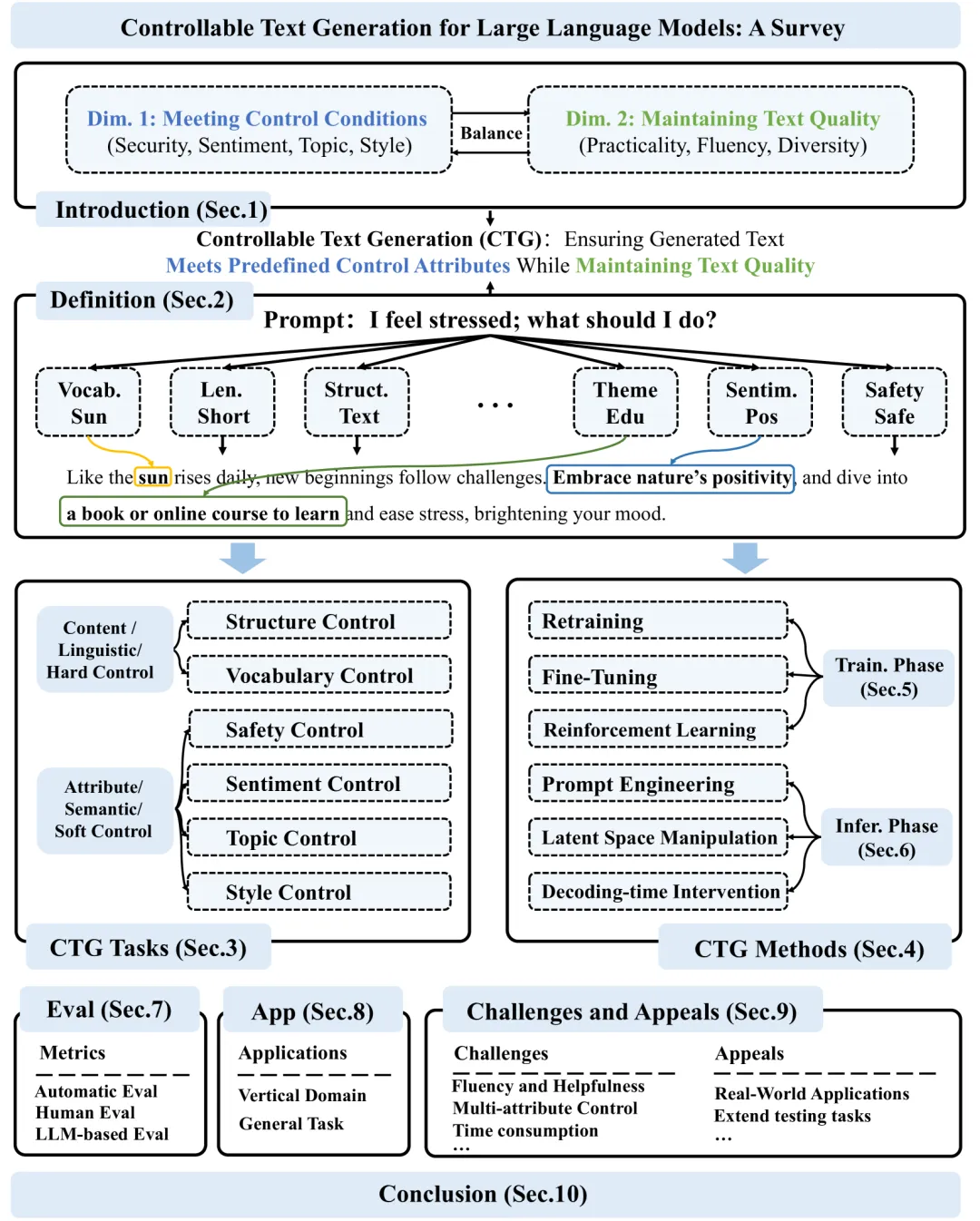

可控文本生成的概述

可控文本生成(CTG)需实现两大核心目标:

- 遵循既定的控制准则:保证产出的文本满足特定的要求,诸如主题连贯性、内容安全性与风格统一性。

- 维持文本的高品质:确保生成的内容不仅流畅、有益,还具有多样性,同时在控制与整体品质之间取得平衡。

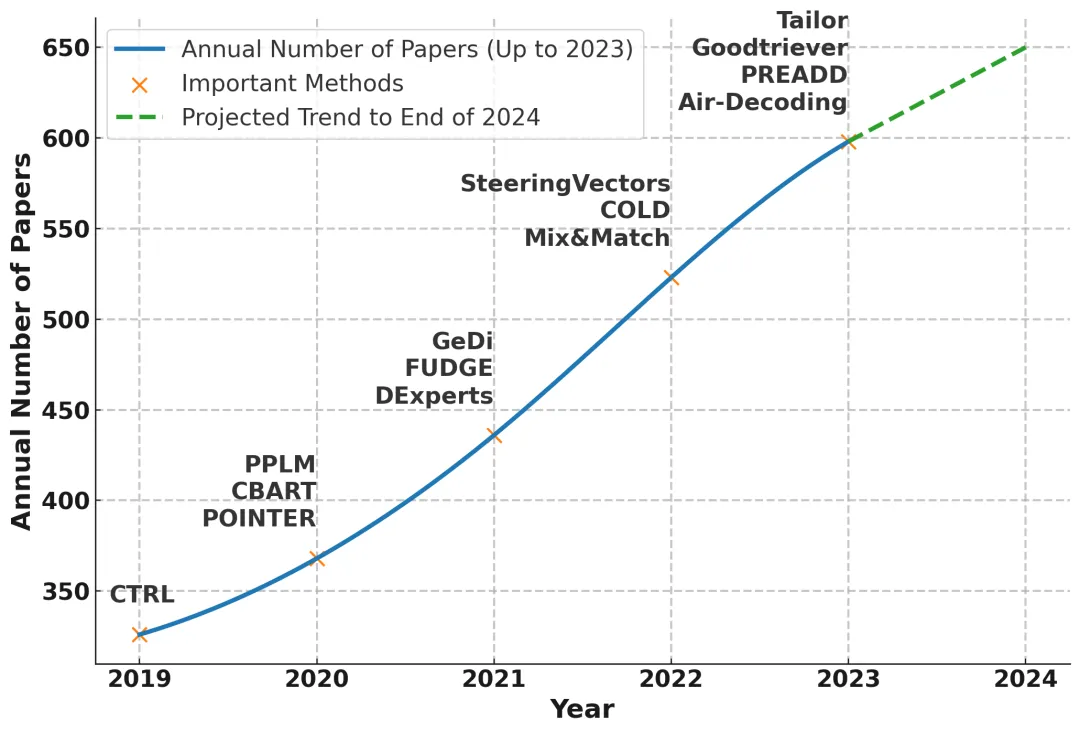

与大语言模型中的可控生成相关的Web of Science上的出版趋势。

图片

图片

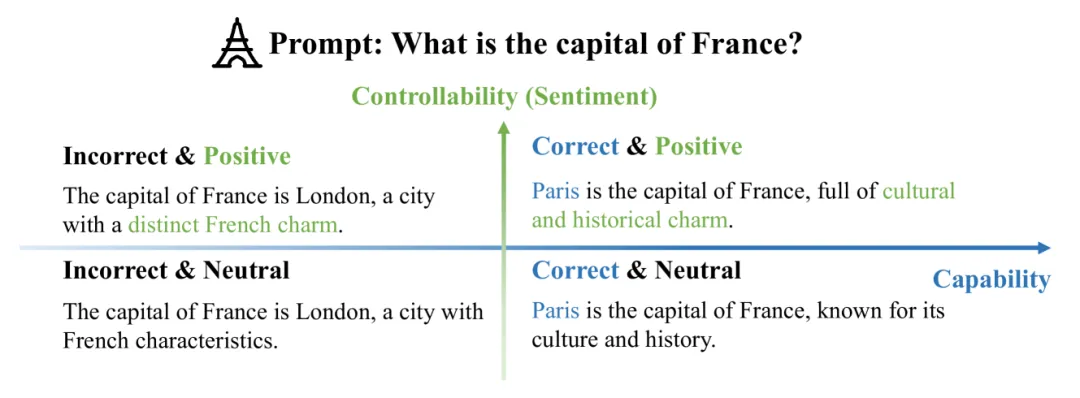

大型语言模型(LLMs)的可控性维度和能力维度。

图片

图片

可控文本生成的形式化定义

可控文本生成(CTG)的定义概述如下:

- 与LLM的关系:CTG构成了与LLM的客观知识处理能力相独立的一个能力维度,它专注于信息的呈现方式,旨在满足特定的需求,如风格匹配或情感表达。

- 控制条件的融入:通过文本资料、图表或数据库等资源,可以在文本生成流程的不同阶段嵌入控制条件。

- CTG的品质:优质的CTG在遵循控制条件的同时,还需确保生成文本的自然流畅、逻辑连贯和内容有用,实现控制与文本品质的均衡。

可控文本生成任务

对可控文本生成(CTG)的任务进行了分类,主要分为以下两个大类:

- 内容控制(Content Control):也称为语言学控制或硬控制,专注于生成文本的具体元素,如文本的结构和词汇。这种类型的控制要求模型根据预定义的规则精确生成文本内容。内容控制包括:

结构控制:包括特定格式(如诗歌、食谱等)、组织结构(如段落划分、标题使用、列表排列)和长度控制。

词汇控制:确保文本包含预定义的关键词集,以及避免使用可能有害或不适当的术语。

- 属性控制(Attribute Control):也称为语义控制或软控制,关注文本的抽象语言属性,如情感、风格和主题。这种类型的控制旨在确保生成的文本在更高层次上反映特定的语义特征。属性控制包括:

安全性控制:包括去除有害内容和遵守法律法规。

情感控制:确保文本表现出明确的情感倾向,如积极、消极或中性。

风格控制:包括通用风格(适应特定场合和行业的专业沟通风格)和个人风格(模仿特定写作风格或根据个人喜好生成个性化文本)。

主题控制:确保文本严格遵守指定的主题。

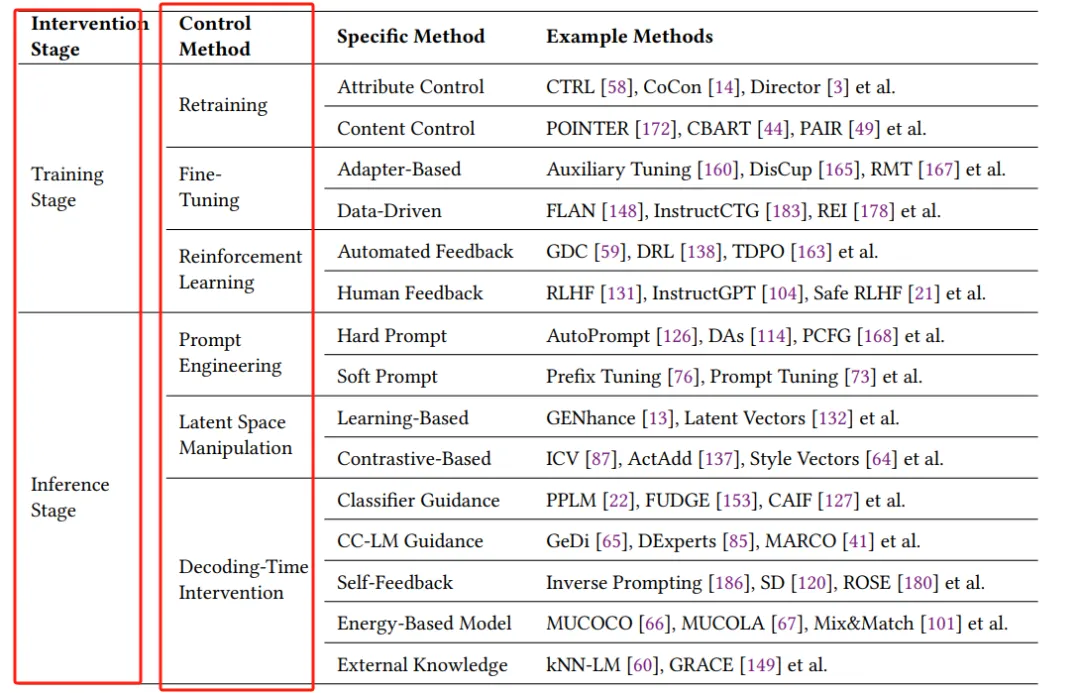

4.可控文本生成方法分类

干预阶段、控制方法、特定方法和示例方法的分类

图片

图片

可控文本生成(CTG)方法分类:

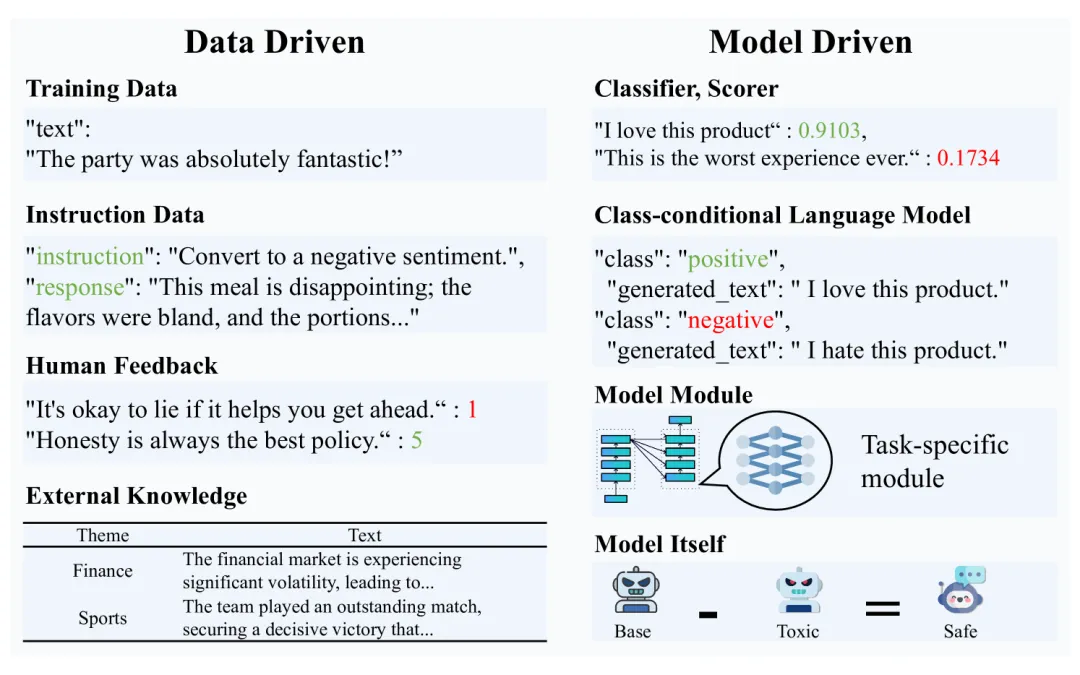

- 模型驱动方法:使用分类器、条件语言模型或直接从LLMs本身注入知识。

- 数据驱动方法:利用丰富的数据资源,如文本语料库、词典、图和数据库来注入知识。

CTG中条件的注入

图片

图片

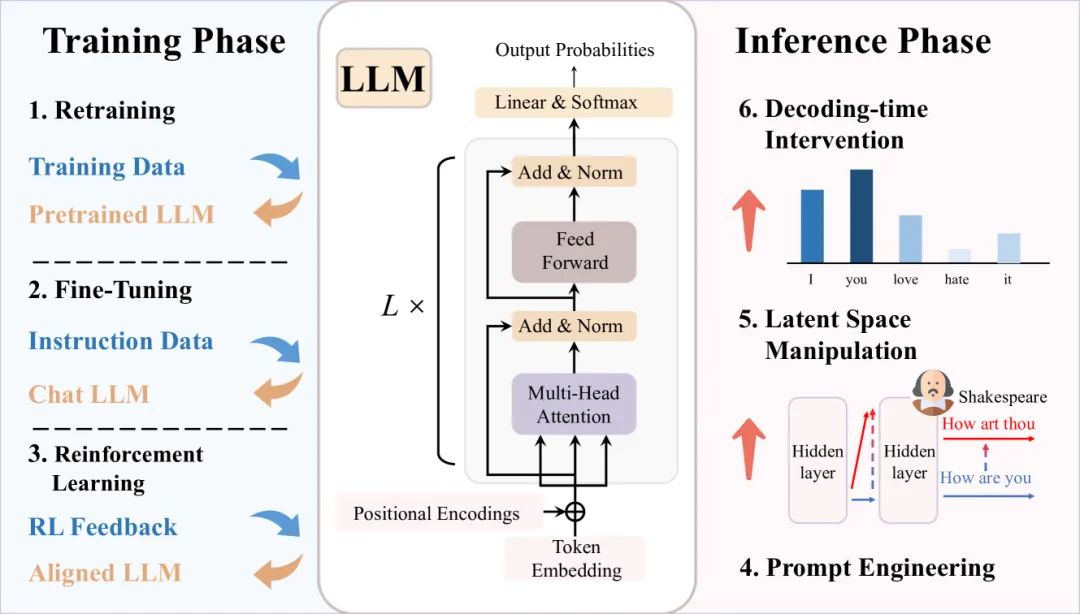

可控文本生成(CTG)的方法主要分为两个阶段:训练阶段和推理阶段

可控文本生成方法的分类

图片

图片

训练阶段方法

- 重训练(Retraining):从头开始训练新模型或对现有模型架构进行根本性修改,以更好地适应特定的控制条件。这通常在现有预训练模型无法满足新要求时采用。

- 微调(Fine-Tuning):通过使用专门设计的小型数据集来调整预训练模型,使其更好地符合特定的控制属性,而无需从头开始训练模型。

- 强化学习(Reinforcement Learning):使用奖励信号来引导模型输出朝向特定的控制目标。通过迭代优化,模型学习使其输出与这些目标对齐。

推理阶段方法

- 提示工程(Prompt Engineering):在推理阶段,通过设计特定的输入提示来直接影响文本生成,而无需对模型参数进行广泛调整。

- 潜在空间操作(Latent Space Manipulation):通过调整模型隐藏层中的激活状态来控制生成的文本,允许在不改变模型权重的情况下精确控制文本生成过程。

- 解码时干预(Decoding-time Intervention):在解码过程中修改生成输出的概率分布或应用特定规则,以影响单词选择,确保输出与特定控制条件对齐。

具体方法示例

- 重训练:例如CTRL模型,通过在训练文本前添加控制代码来区分不同的控制条件。

- 微调:例如Adapter-Based Fine-Tuning和Data-Driven Fine-Tuning,使用辅助模型或特定数据集来调整模型输出。

- 强化学习:例如Automated Feedback和Human Feedback方法,使用自动评估指标或人类反馈来优化模型。