SLM 是一种更具成本效益的方法,它允许公司在安全的环境中将模型适应其专有数据。

译自Use Small Language Models To Deploy AI on a Budget,作者 Emily Freeman。

AI 正在颠覆科技行业。关于通用人工智能(AGI) 及其取代人类的能力的讨论无处不在。无论未来是在十年后还是一年后,许多团队都需要帮助充分利用 AI。

只有少数公司维护我们所知的 LLM——GPT、Claude、Bard、LaMDA、LLaMA 等——因为训练所需的资源极其昂贵。LLM在海量数据集上进行训练。

这些模型仅仅是开始。它们提供了一个令人难以置信的平台来构建更有效、更定制的解决方案:在您的特定数据上训练的小型语言模型 (SLM)。

是什么让 SLM 变小?

简而言之——参数数量。要理解 SLM 对现实世界应用的价值,您必须了解 LLM 的冗长性。OpenAI 的 GPT-3 有 1750 亿个参数,而 Meta 的 Llama 3.1 有一个包含 4050 亿个参数的版本。但这意味着什么?

LLM 使用 Transformer 模型来标记和分析数据,利用参数来消费、解释和生成人类语言。如果您阅读过任何资料,您可能会发现“标记”和“参数”可以互换使用,但它们是不同的。

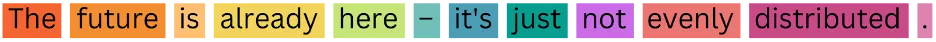

标记是 LLM 的离散数据单元。在下面的示例中,每个词都被 LLM 作为标记摄取。根据模型的不同,标记可以是词语、短语、字符等。标记允许 LLM 将数据分解并有效地评估它。例如,LLM 可能将“cats”一词解释为与“cat”相同,以标准化信息。

图片

图片

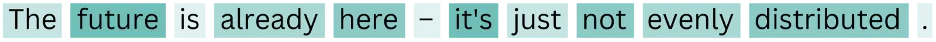

简而言之,参数是 LLM 用于评估数据的规则——权重和偏差。参数允许 LLM 更强调特定词语以建立上下文和含义。参数还将词语链接起来;在下面的示例中,“future”和“it’s”指的是同一件事。

图片

图片

您可能在问自己,“更多的参数更好吗?”好吧,就像科技中的所有事物一样,这取决于情况。如果您需要在墙上挂一幅画,Home Depot 中的每种工具都比锤子和钉子更好吗?

LLM 是令人难以置信的技术壮举,它们计算大量信息的能力越来越好,速度也越来越快。但是,训练和微调 LLM 所需的成本和时间对于大多数公司来说是不可取的。它们太大了。大多数企业不需要一个万能工具,而需要一个针对特定任务的特定工具。

这就是 SLM 闪耀的地方。

在您的数据上训练模型

虽然 LLM 必须使用大量的云资源进行训练,但训练 SLM 使用专有数据,并且计算效率高且成本效益高。

假设您是一家政府承包商,负责响应招标书 (RFP) 以获得合同。通常,您将有一个团队审查这些 RFP,手动收集响应所需的相关信息,回答有关您的公司如何满足合同需求的详细问题,并编写完整的提案,包括所需的工作角色以及这些工作的相应政府代码。

RFP 从未公开发布,这意味着 LLM 无法在它们上进行训练,而您的公司编写的数百甚至数千份提案都是专有的。

想象一下,如果您可以在所有专有数据上训练一个 SLM,并让 SLM 代表您生成详细的提案。您能想象您的团队将节省多少时间吗?您可以通过从基础模型(如Llama 3.1)开始,并在之前的 RFP 和相应的提案上微调 SLM 来做到这一点。您还可以使用Arcee.AI等工具。

无论哪种情况,为了充分利用您的 SLM,您需要完成四个关键步骤:1/ 持续预训练,2/ 对齐,3/ 模型合并,4/ 检索增强生成 (RAG) 以及 5/ 持续适应。

了解训练 SLM 的步骤

想象一下,我们的小型语言模型是 Dominique,一个高中二年级的学生。预训练是 Dominique 在所有先前年份中学到的所有东西——数学、科学、语言艺术、体育、艺术——所有东西。模型合并是我将擅长数学的 Dominique 与擅长科学的 Asma 配对,让他们在余下的学年里一起学习和测试。尽管他们在某个特定主题上特别出色,但他们将在两个主题上都非常出色。

关于对齐和微调,指令调优(对齐的第一部分)可以被描述为 Dominique 在大二时所接受的课程。批评阶段(对齐的第二部分)是对 Dominique 作业的反馈。RAG 就像给 Dominique 一场开卷考试;她可以查找相关信息来帮助她取得更好的成绩。最后,持续适应会更新 Dominique 的知识,因为信息会发生变化(例如,冥王星不再是行星),所以她拥有最新、最及时信息。

实施您的模型

在政府承包商的例子中,他们想要构建一个 SLM 来撰写提案。开发人员将使用一个较小的开源模型,例如 Llama 的较小版本之一(70B 或 8B 参数),并使用其先前提案、先前 RFP 和任何其他相关文本数据的专有数据对其进行训练。

然后可以使用开源工具将该模型合并 - 可能是专门用于语言或其他特定领域的更通用的模型。例如,如果他们有一个专门为军队创建提案(使用特定术语和词汇)的模型,以及另一个专门为建造火箭撰写提案的模型,则可以将它们合并以撰写高度专业和准确的建造军队火箭的提案。请记住,只有当模型具有相同的架构和大小时,才能将它们合并。

从那里,他们将希望对齐这个新合并的模型,以确保它提供所需的结果。这包括提供预期结果的示例,并与模型交互以测试它是否生成所需类型的內容。

虽然像 Arcee.AI 这样的工具可以在没有 RAG 的情况下获得相同的结果,但如果您是从头开始构建,则可以使用 RAG 层来允许它准确地检索特定信息并生成更准确的文本或进行实时数据检索。例如,政府职位代码将是保存在 RAG 层中的绝佳数据。

最后,就像人类一样,SLM 始终在不断发展和学习。部署后,模型可以随着业务数据和需求的变化而更新。根据新数据的频率,计划每六到十二个月重新训练您的模型。

充分利用 AI

LLM 只能带您走这么远,并且没有真正的市场差异化。毕竟,您使用的是与其他人相同的数据 - 从(通常是开源)数据收集的通用信息。

SLM 是一种更具成本效益的方法,允许公司在安全的环境中将模型适应其专有数据。更不用说 SLM 对地球更友好,因为它们使用的计算资源明显更少,并且在能源方面更环保。SLM 提供的响应能力和适应能力水平是当前生成式 AI 技术无法比拟的。它提供了使用生成式 AI 来改善您的业务的最终途径。