编辑 | 言征

作者 | 智能交互引擎

出品 | 51CTO技术栈(微信号:blog51cto)

如何监测AI生成的内容?一篇文章中AI生成的篇幅占比究竟有多少?

今年4月,一篇题为“Monitoring AI-Modified Content at Scale:A Case Study on the Impact of ChatGPT on AI Conference Peer Reviews”的论文引起了广泛关注。

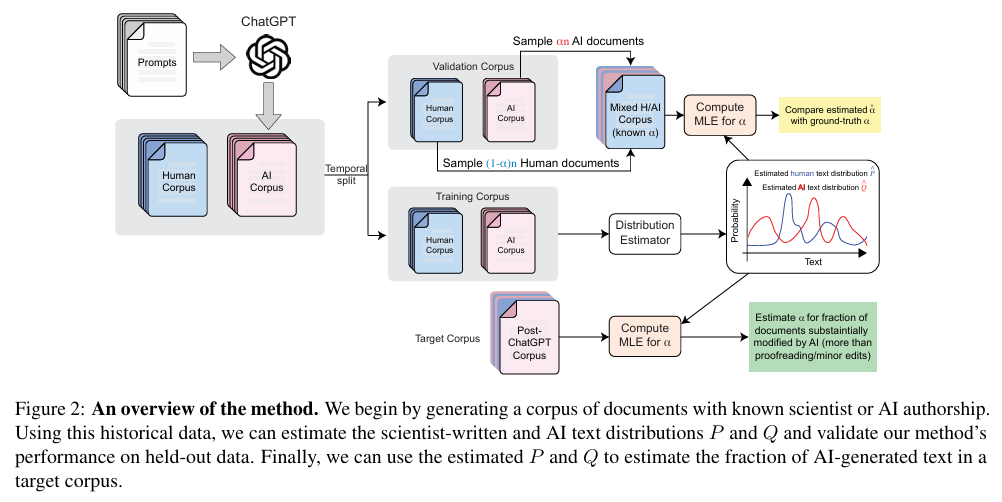

该论文探讨了ChatGPT对AI会议同行评审的影响,并提出了一种估计大型语料库中被AI大幅修改或生成的文本比例的方法。

一、研究背景

随着大型语言模型(LLM)的广泛应用,如在教育、科学和全球媒体等领域,准确测量其使用规模以及评估生成文本对信息生态系统的影响变得愈发重要。然而,目前很难区分LLM生成的文本和人类撰写的内容,这给科学研究带来了挑战,例如ChatGPT生成的医学摘要可能绕过AI检测器和专家,以及媒体中出现的不可靠AI生成的新闻网站可能误导消费者。

二、相关工作

1、Zero-shotLLM检测:许多LLM检测方法旨在检测单个文档中AI生成的文本,如利用语言模型的熵、对数概率分数、困惑度和不常见n-gram频率等指标来区分人类和机器文本。但这些方法在实际应用中效果有限,且当许多商业LLM不开放源代码时,这些方法往往依赖于假设与闭源LLM机制相似的代理LLM,这引入了一定的局限性。

2、Training-basedLLM检测:通过微调预训练模型来区分人类和AI生成的文本,但这种方法存在过拟合训练数据和语言模型的倾向,且许多分类器在对抗侵入面前表现脆弱,对非主导语言变体的作者存在偏见。

3、LLM水印:通过在文本中嵌入独特的、可算法检测的信号(水印)来检测AI生成的文本,但水印的嵌入需要模型或服务所有者的参与,且可能会降低文本生成质量和连贯性。

三、研究方法

1、记号与问题陈述:用表示文档或句子,表示令牌,表示语料库,表示词汇表。假设目标语料库中的文档是从科学家编写的文档分布和AI生成的文档分布的混合分布中生成的,目标是估计AI生成的文档的比例。

2、统计估计方法概述:采用最大似然估计(MLE)方法,包括训练数据生成、文档概率分布估计和计算AI生成或修改的文本的最终估计比例。具体步骤为收集原始语料库的写作指令,用LLM生成AI文档,估计参考令牌使用分布和,在合成目标语料库上验证方法性能,最后基于估计的和,使用MLE估计目标语料库中AI生成或修改的文档的比例。

3、MLE框架:给定从混合分布中独立抽取的文档集合,通过对数似然函数来估计。

4、生成训练数据:需要访问历史数据来估计和,具体为已知的仅包含人类撰写文本的评论集合以及相关的评论问题和被评审的论文。将评审指令提示和与人类语料库中评论相关的论文输入AI语言工具(如ChatGPT),生成AI语料库。

5、估计和从数据:将每个文档表示为令牌出现的列表(即一个集合),而不是令牌计数的列表。通过计算令牌在文档中出现的文档数量占总文档数量的比例来估计人类文档分布的出现概率,类似地估计,然后通过和类似的公式估计和。

6、验证方法:将人类和AI语料库划分为两个不相交的部分,80%用于训练,20%用于验证。选择一系列可行的值,从AI验证语料库和人类验证语料库中抽样生成目标语料库,计算目标语料库的MLE估计,如果,则说明系统工作正常。

图片

图片

四、实验结果

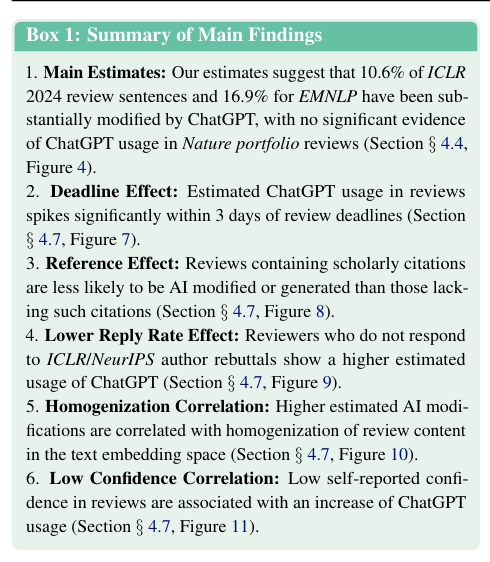

1、在合成数据上的验证:算法在识别混合验证集中LLM生成的文本比例方面具有较高的准确性,预测误差在人口水平上小于1.8%。

2、与基于实例的检测方法比较:与BERT分类器基线和其他两个最近发布的先进AI文本检测方法相比,该方法减少了内部分布估计误差3.4倍,外部分布估计误差4.6倍,并且在推理时间上计算效率更高,超过1000万倍(即7个数量级)。

3、对真实评论的估计:ML会议的评论中,在ChatGPT发布后,AI生成的句子显著增加,但Nature期刊的评论中没有明显证据表明使用了AI。例如,ICLR会议中,估计的从1.6%增加到10.6%,NeurIPS从1.9%增加到9.1%,CoRL从2.4%增加到6.5%,而EMNLP会议的估计约为16.9%。

4、对校对的鲁棒性:将方法应用于仅由ChatGPT进行校对(非实质性编辑)的同行评审,发现估计的虽有增加,但幅度远小于在真实评审语料库中的效果。

5、使用LLM大幅扩展评论大纲:通过模拟评审者先创建简要大纲,然后使用LLM扩展大纲的过程,发现算法能够检测到这种LLM的使用情况,估计的与实际情况相符。

6、与估计LLM使用相关的因素:

(1)截止日期效应:在截止日期前3天或更少时间提交的评论中,估计的有小幅但一致的增加,表明评审者可能会在临近截止日期时依赖LLM来节省时间。

(2)参考效应:包含学术引用的评论中估计的较低,这表明LLM往往难以准确生成包含引用的内容,同时也说明使用ChatGPT的人可能不太倾向于引用来源。

(3)低回复率效应:作者回复较少的评论中,估计的ChatGPT使用量较高,这可能是因为评审者使用LLM作为快速解决方案来避免额外的参与,或者是因为评审工作量增加导致学者依赖工具。

(4)同质化效应:“趋同”(与其他评论相似)的评论往往具有更高的估计,这表明LLM生成的文本可能导致反馈的同质化,减少了语言和认知的多样性,可能会使学者失去接受来自多个独立专家的多样化反馈的机会。

(5)低信心效应:评审者信心低的评论与ChatGPT使用量的增加相关,这可能是因为LLM的融入使评审者对生成内容的个人投入感或准确性信心降低。

图片

图片

五、讨论与结论

该研究提出了一种估计大型语料库中被AI修改或生成的文本比例的有效方法,并通过对AI会议和期刊评论的研究,揭示了ChatGPT对科学出版的潜在影响。尽管研究存在一定局限性,但为社会分析提供了有价值的视角,希望能促进关于LLM在信息生态系统中使用程度和影响的建设性讨论和政策决策。

以上就是对这篇论文的主要解读,希望能对大家了解该研究有所帮助。如有不足之处,欢迎大家批评指正。

论文链接:https://arxiv.org/abs/2403.07183v1