大家好,我是小寒

今天给大家分享一个强大的算法模型,卷积神经网络算法

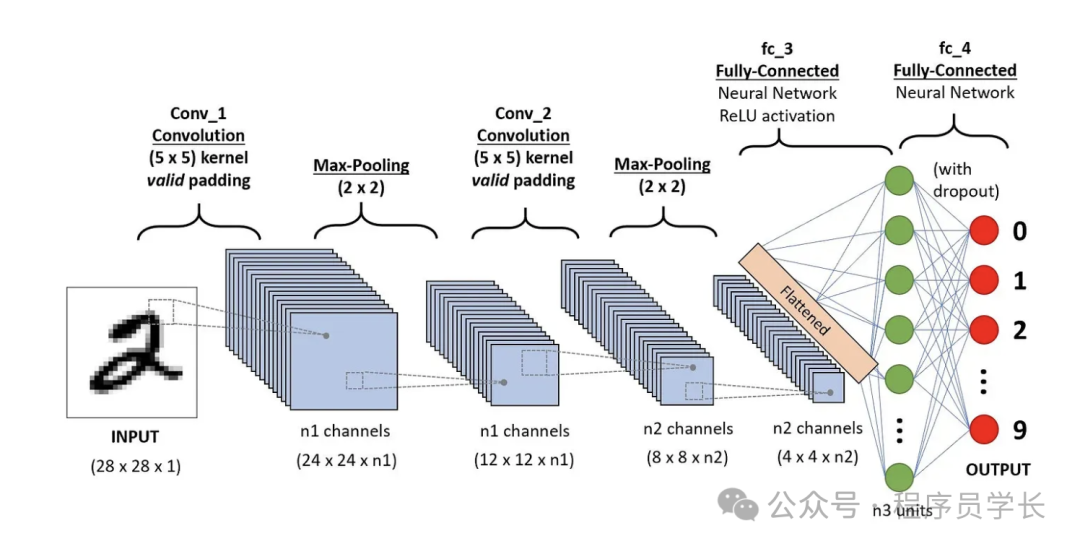

卷积神经网络(CNN)是一种专门用于处理具有网格结构数据(如图像)的深度学习模型。

CNN 的核心是通过卷积操作来提取图像中的局部特征,并通过池化操作降低数据的维度。

卷积神经网络在很多计算机视觉任务中都表现出色,比如图像分类、目标检测和图像生成等。

图片

图片

相关原理

卷积神经网络由若干层堆叠而成,通常包括卷积层、池化层以及全连接层。

卷积层

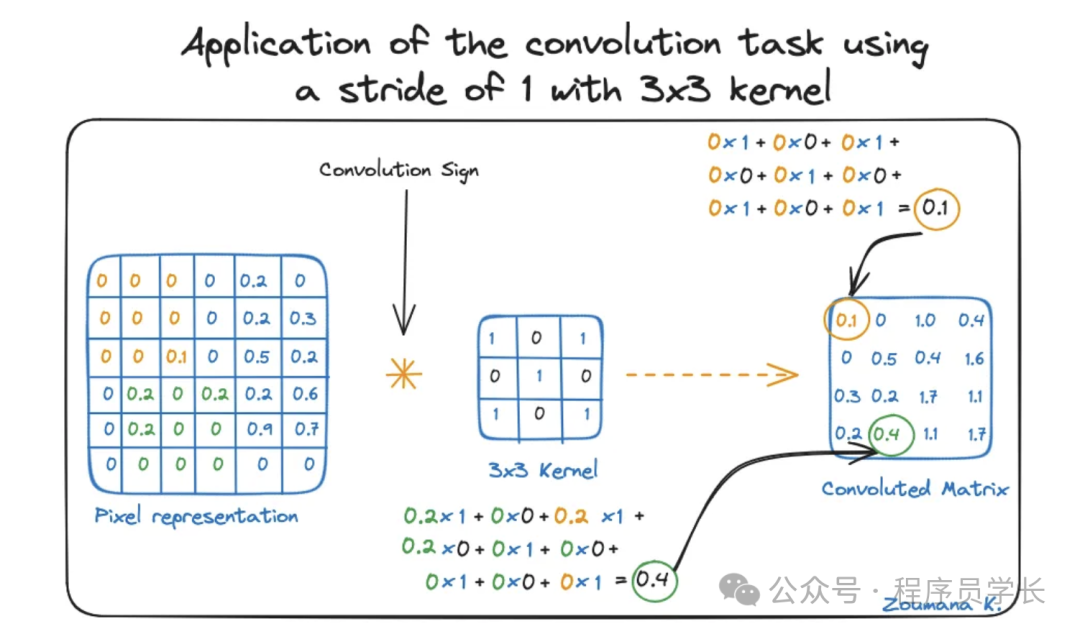

卷积层是 CNN 的核心,它使用卷积核(或称过滤器)对输入进行卷积操作,以提取输入数据的局部特征。

图片

图片

- 卷积操作

卷积层使用卷积核(或过滤器)在输入数据上进行局部滑动,计算加权和来生成特征图。

这个过程使卷积层能够识别输入数据中的局部模式,如边缘、角点等。 - 共享权重

卷积核的参数是共享的,也就是说,在整个输入数据中,所有位置使用相同的卷积核。

这种权重共享机制大大减少了模型的参数数量,避免过拟合,并提高了模型的训练效率。 - 参数

卷积层通常有三个重要参数:

- 卷积核大小(filter size):通常为 3x3 或 5x5,用来定义卷积核的尺寸。

- 步长(stride),表示卷积核在输入上移动的步幅。步长为 1 时,卷积核每次移动一个像素;步长为 2 时,卷积核每次移动两个像素。

- 填充(padding),为了控制输出的大小,填充会在输入数据的边缘补充零,从而保持输出尺寸不变。

下图显示了使用 3x3 的卷积核和步长为1 进行卷积操作。

图片

图片

卷积层的作用

- 提取局部特征

- 通过共享权重减少参数数量

池化层

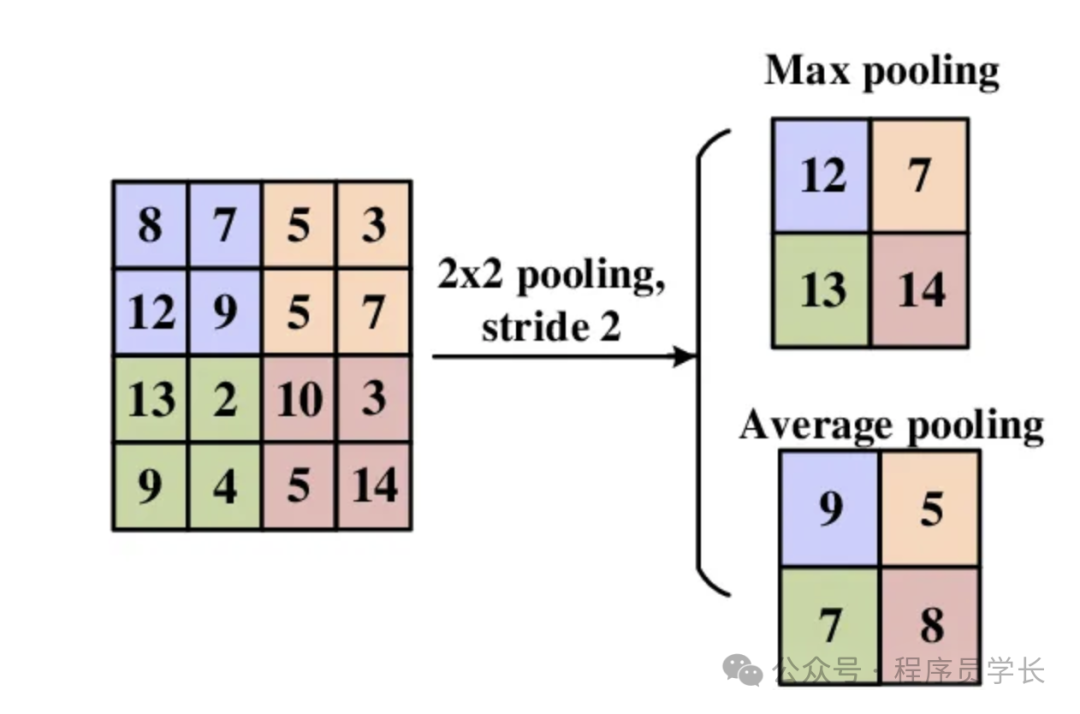

池化层用于对卷积层生成的特征图进行下采样,减少数据的空间维度和计算量,同时保留重要的特征。

常见的池化方法有最大池化和平均池化。

- 最大池化(Max Pooling)

最常用的池化方法。在局部区域内取最大值作为该区域的输出。

例如,对于一个 2x2 的局部区域,最大池化会输出这四个值中的最大值。 - 平均池化(Average Pooling)

在局部区域内取平均值作为输出。

图片

图片

全连接层

全连接层通常位于卷积神经网络的最后几层,用于将卷积和池化层提取的特征进行整合,并输出预测结果。

全连接层与传统的神经网络层类似,每一个节点与上一层的所有节点都有连接。通过这些连接,全连接层可以将前面提取的特征整合起来,并通过权重和偏置项计算出最终的输出。

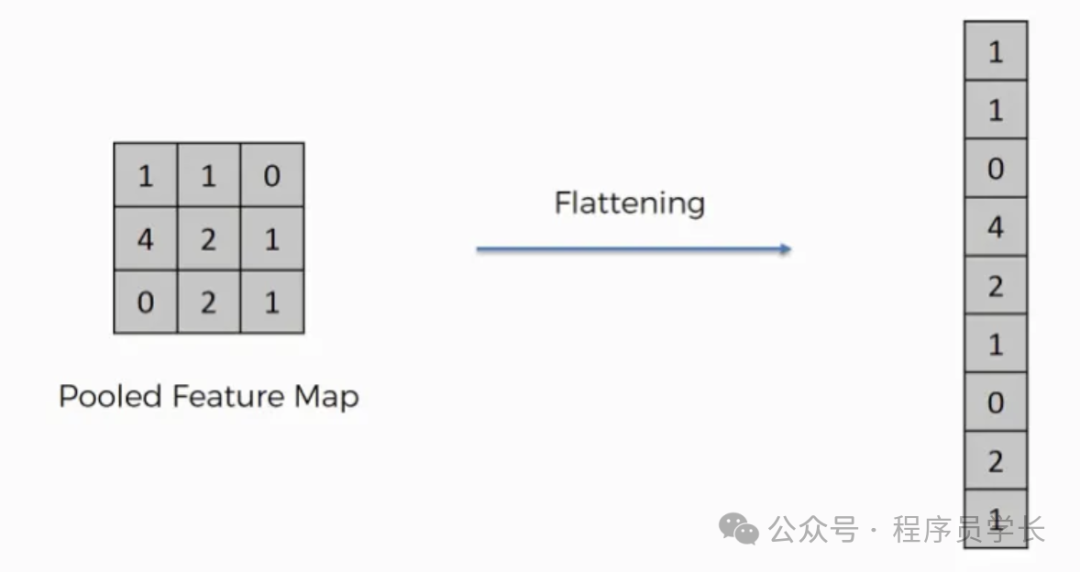

扁平化

扁平化将二维或三维特征图转换为一维向量,从而可以将卷积层和池化层连接到全连接层。

图片

图片

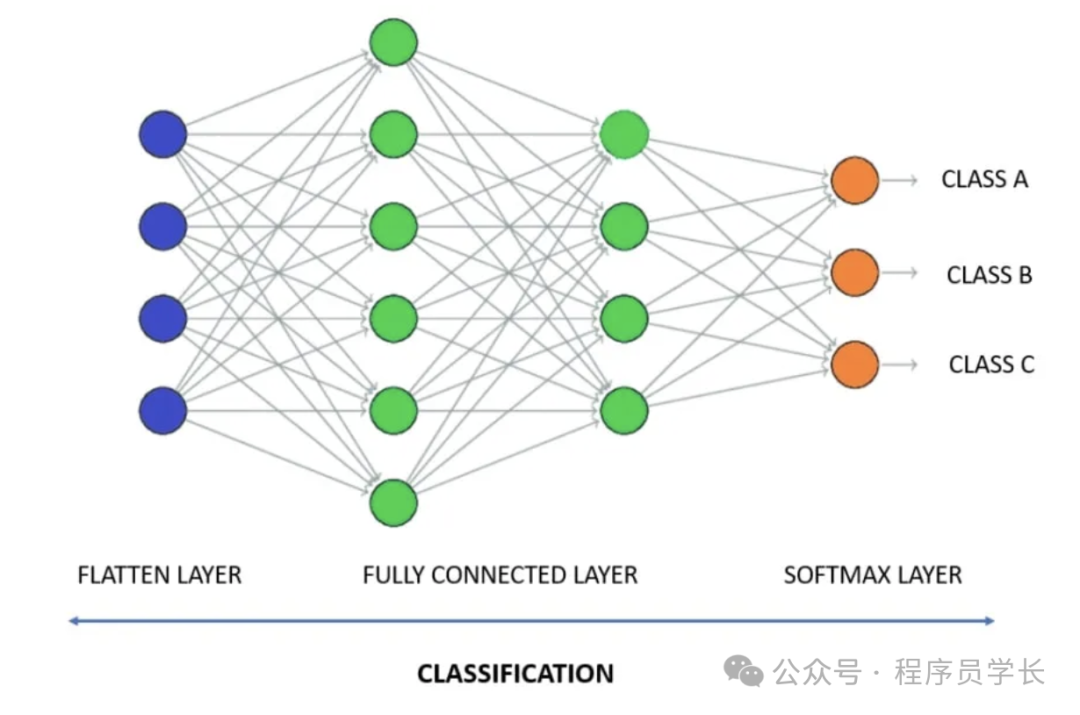

全连接层

全连接层通过处理卷积层和池化层提取的特征来执行最终的分类或回归任务。

图片

图片

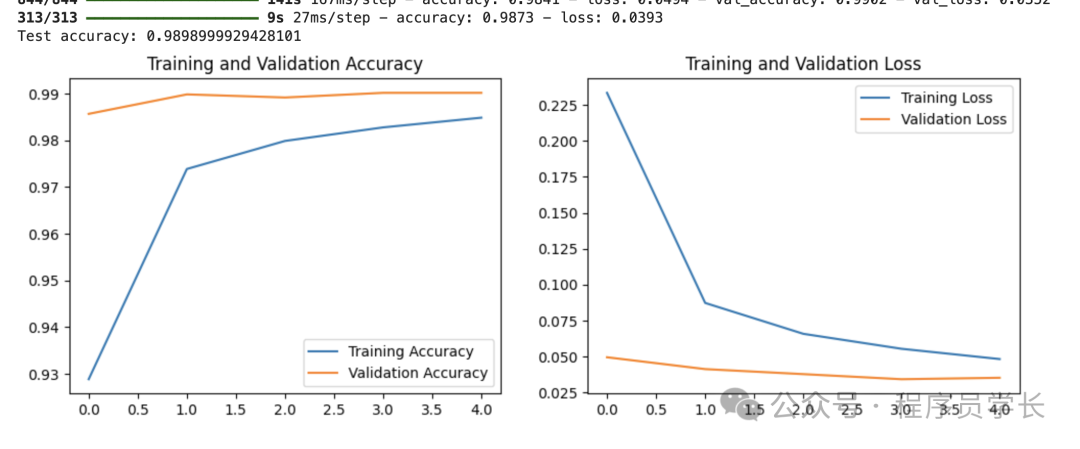

案例分享

下面是一个使用卷积神经网络(CNN)进行手写数字识别的示例代码。

图片

图片