openai放大招了,是奥特曼在推上宣传了很久的草莓真身,这次它真的来了。

图片

图片

又给大家带来一点小小的震撼,国内大模型老板们也不再迷茫了,4o的多模态的还没赶上呢,这下怎么又回到纯文本了,不是说大家都搞得差不多了吗?

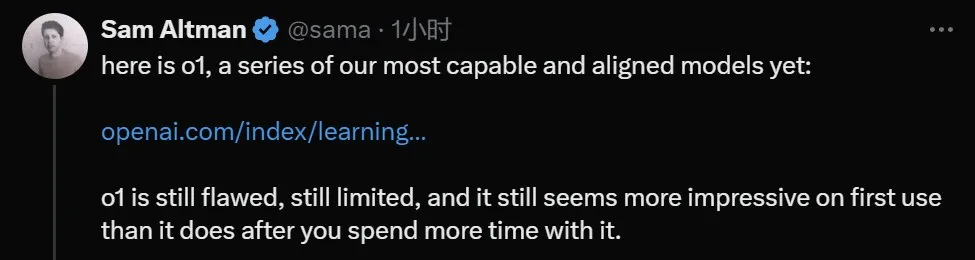

奥特曼表示,虽然 o1 的表现仍然存在缺陷,不过你在第一次使用它的时候仍然会感到震撼。

图片

图片

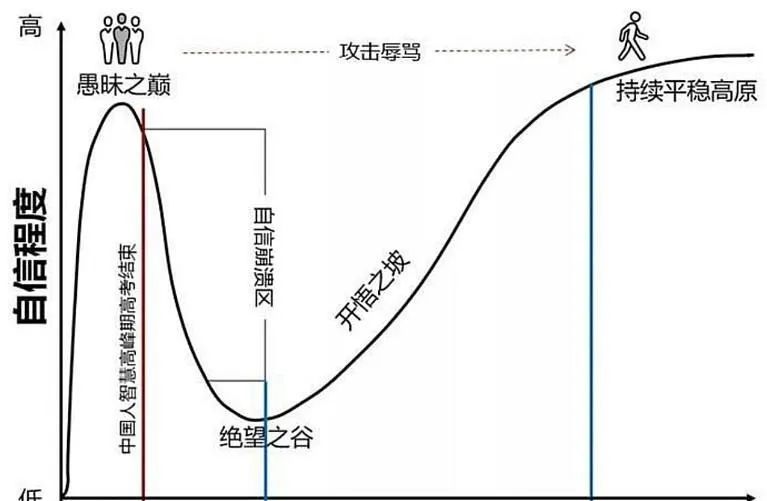

这对从业者绝对是一件大好事,老板们发现饼还比较大,还可以让资本继续投钱,百万洗数据槽工衣食所系!

直接延长了从愚昧之巅到绝望之谷的到来。

图片

图片

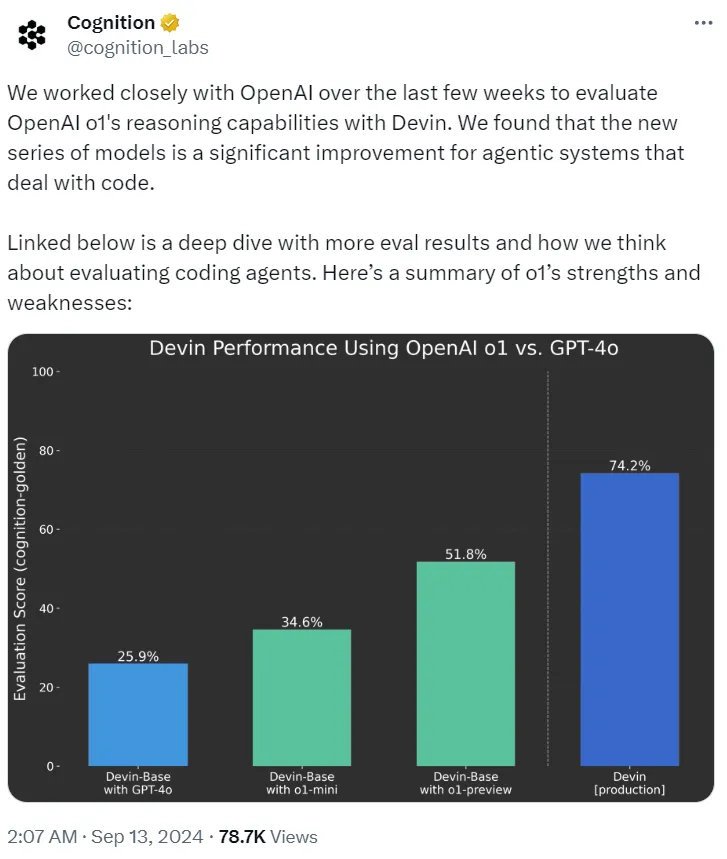

OpenAI o1到底有多强?

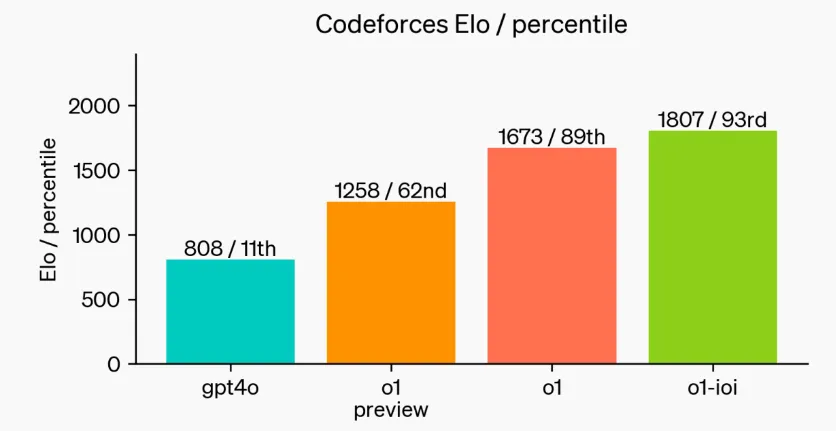

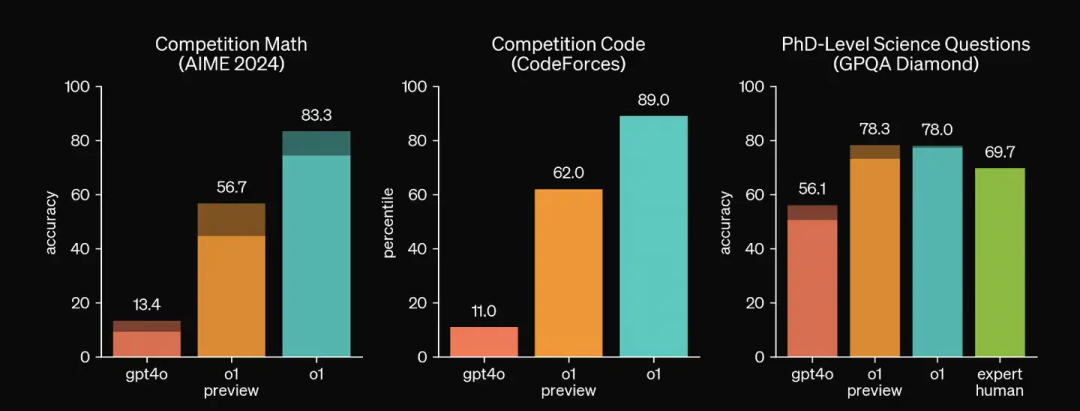

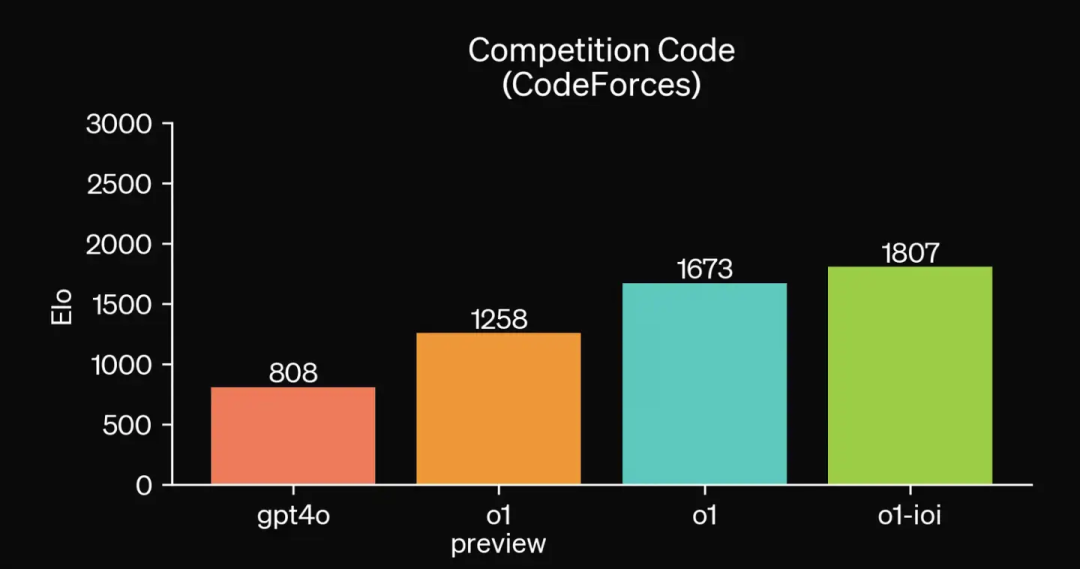

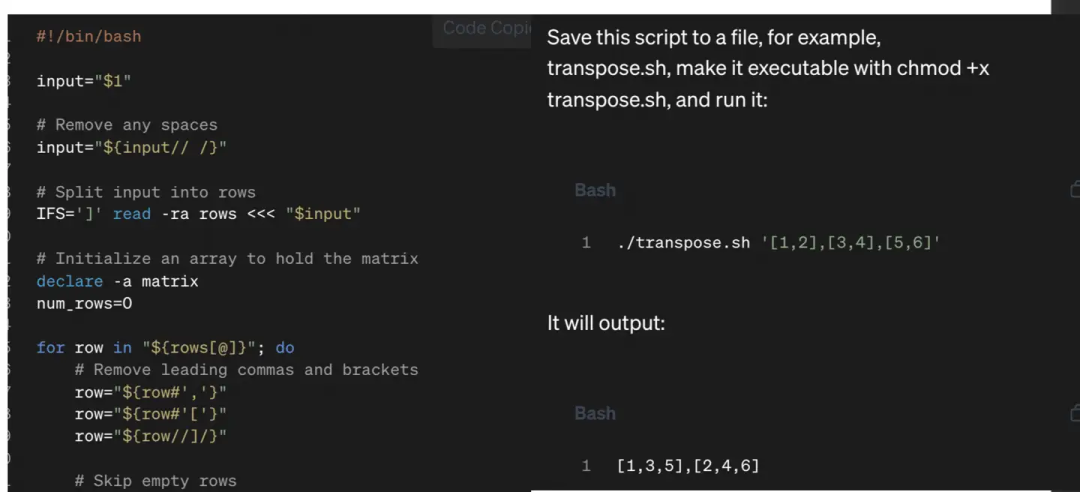

这次发布的大模型主要针对的任务是复杂任务推理,比如竞赛难度的编程问题,奥赛难度的数学问题等。并且效果得到了极大的提升,大概从高中生提升到了博士生。比如写代码的水平:

图片

图片

该模型在 2024 年国际信息学奥林匹克竞赛(IOI)赛题上得到了 213 分,达到了排名前 49% 的水平。

图片

图片

在最难的数学,code,物理化学生物等benchmark上遥遥领先。在全美高中生数学竞赛AIME上,o1能达到74分(GPT4-o仅有12分),如果采样1000次,结合reward model加权投票能到93分,能排进全国前500名,超过USA Mathematical Olympiad的晋级分数线;在GPQA,一个关于物理,化学和生物的智力测试上,OpenAI招募了一群相关领域有博士学位的专家和o1同台竞技, o1能够在GPQA-diamond questions.上超过这群专家。在视觉感知能力后方面,o1 在 MMMU 上取得了 78.2% 的分数,成为第一个与人类专家媲美的模型。

图片

图片

值得注意的是,OpenAI在o1的基础上加强了模型的代码能力,以o1为初始化又训了一个o1-IOI,用于参加2024年的国际奥林匹克信息竞赛(2024 International Olympiad in Informatics), 在和人类选手相同的条件下,在10h内解决6道非常难的竞赛问题,每个问题最多允许提交50次。最终,o1-IOI能获得一个216分的分数,在放开提交次数后,o1-IOI能获得362.14,超过了金牌线。这种和人类顶尖选手同台竞技,才是最能反映模型能力的benchmark吧。在CodeForce上,打出了惊人的1807分。

图片

图片

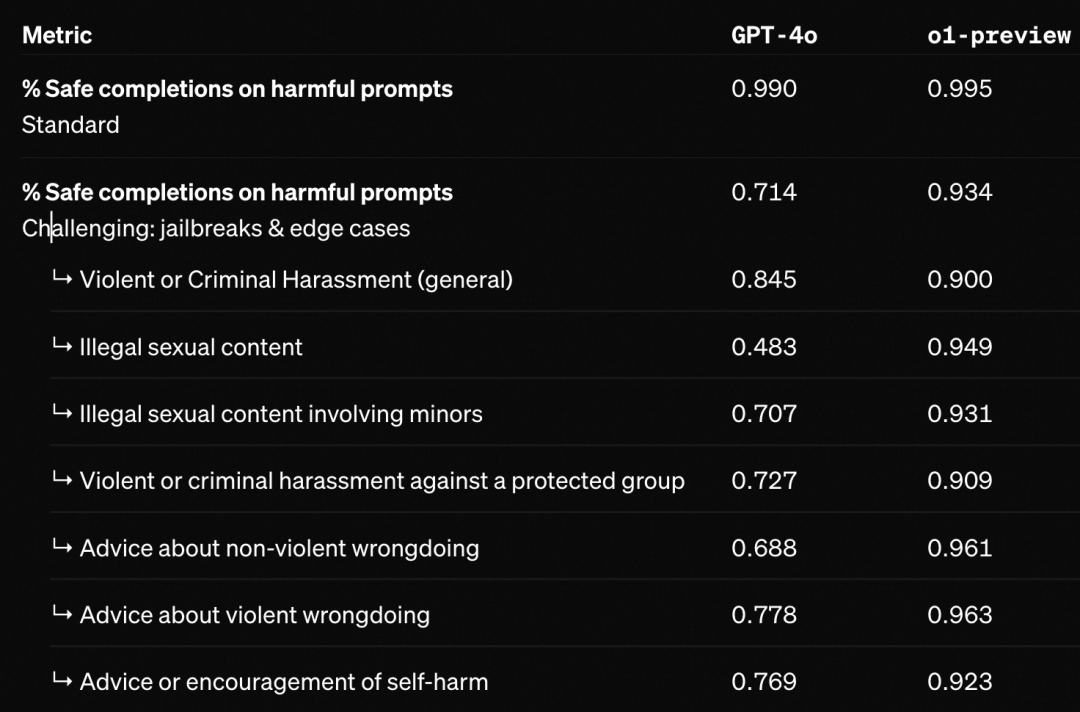

并且安全性得分上也遥遥领先;

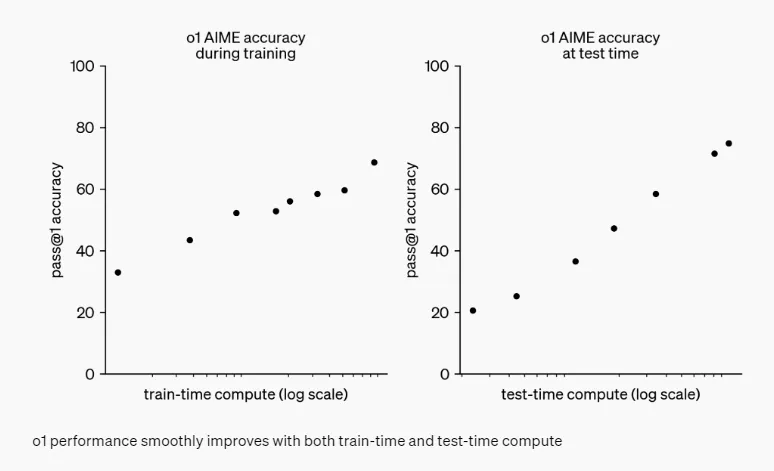

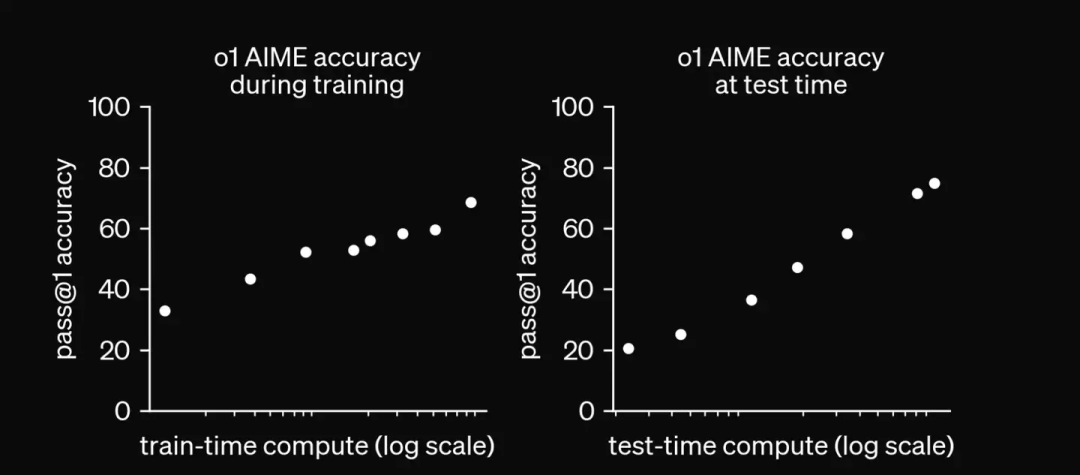

技术上最大的提升

技术上最大的提升

一般的LLM训练,对齐,推理三个阶段的耗时通常是:

图片

图片

这次,o1的耗时分布就变得很神奇。

图片

图片

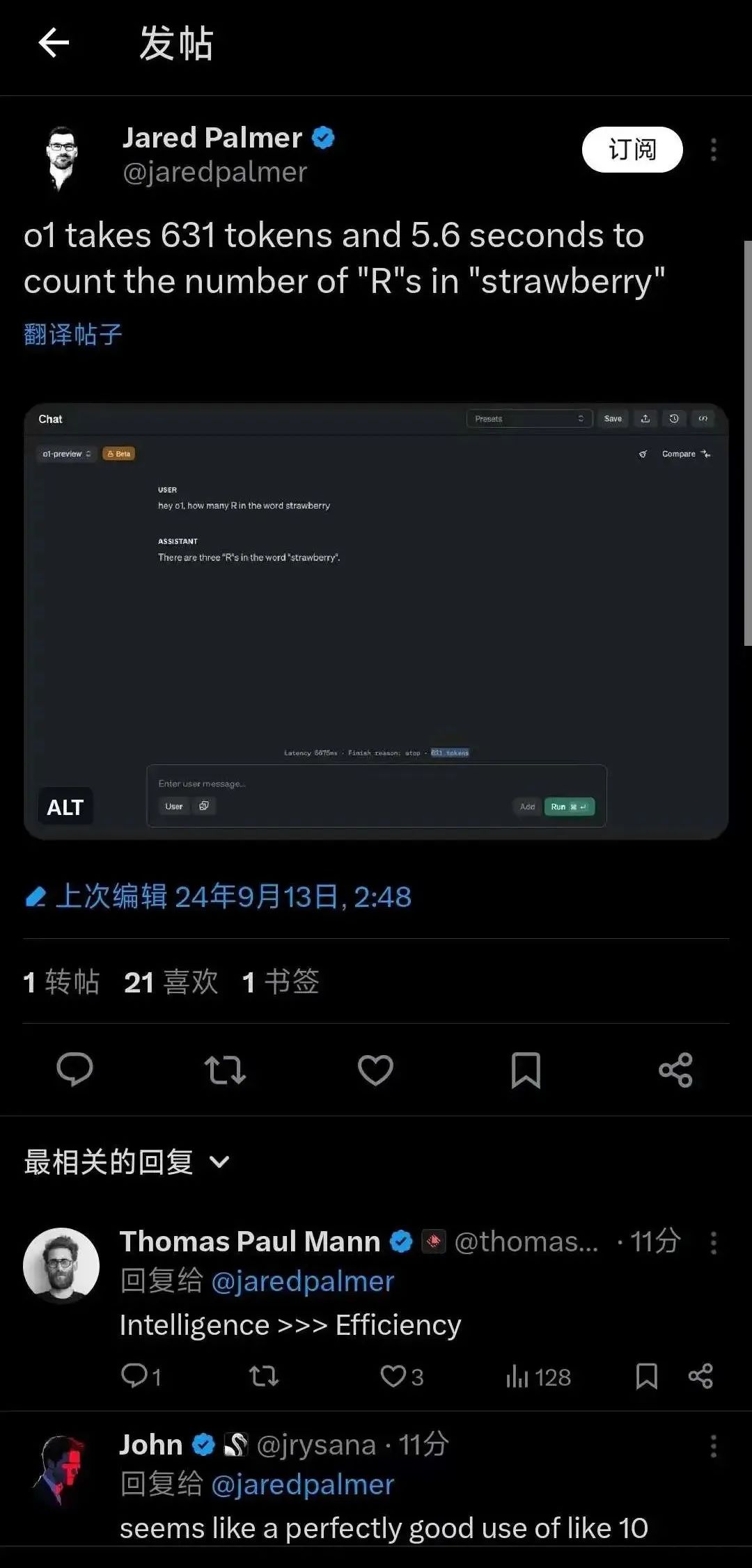

并且我们能发现一个简单的例子需要消耗690多个token,5秒多。

图片

图片

OpenAI声称,训练阶段,会通过强化学习,让o1完善其思维链并优化所使用的策略。例如:识别并纠正错误,将复杂步骤拆分为简单步骤,当前方法不work时,换一种方法在推理阶段,模型同样会在呈现给用户的cot之外,做一个更深的的所谓的long internal chain of thought,所以推理时间会更长,相当于COT套娃了,给COT再加一个COT。

图片

图片

但训练技术上怎么实现的呢?

知乎作者白苏苏给了一个关于推理阶段内在思维连提升性能的案例:

思维链:

图片

图片

内在思维链:

图片

图片

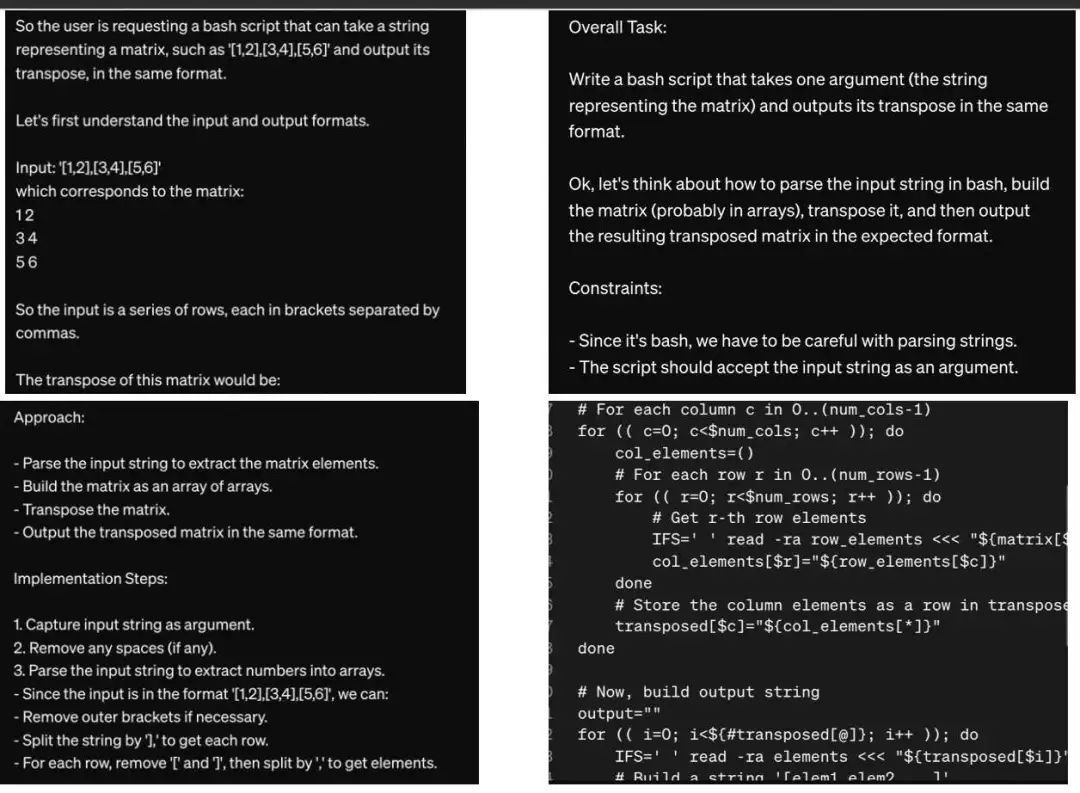

但具体是怎么训练来的,openai只提到了强化学习几个字,从推理速度上来看,模型在推理时候应该是输出了很多中间token,到了某个触发词{output}再真正的输出。

这个能力怎么来的,网友MoonCancer发表了不同见解:

如果用的是常规的预训练数据集,中间的CoT部分完全是通过RL训练出来,完全原生的,那么很好,LLM推理这个领域基本上结束了,我们离AGI又近了一步。

如果是用4o之类的模型合成大量细致的CoT数据,然后进行模仿,再学习把过于细致的部分隐藏起来,那么贡献基本上等同于把模型scale 10倍,是一种很好的模型增强方法。

如果是专门请人写了大量CoT数据然后强行给模型finetune进去,那真的是“有多少人工就有多少智能”。