在人工智能领域的不断演进中,新的模型和架构不断涌现,为各种应用场景带来了更强大的能力和可能性。其中,Falcon Mamba 7B 作为全球首个通用大型 Mamba 架构模型,备受关注。本文将深入探讨 Falcon Mamba 7B 的相关特性、技术架构、性能表现以及其在实际应用中的潜力。

一、Falcon Mamba 7B 简介

Falcon Mamba 7B 是由阿布扎比支持的技术创新研究所(TI I)开源的模型。它是继 Falcon 180B、Falcon 40B 和 Falcon 2 之后 TII 的第四个开放模型。与 Falcon 系列之前的型号不同,Falcon Mamba 7B 完全采用 SSLM(State Space Language Model)架构,而非传统的 Transformer 架构,这一架构的转变为其带来了独特的优势和性能特点。

二、Mamba 架构的特点

Mamba 架构,即状态空间模型(SSM,State Space Model),具有以下显著特点:

- 高效处理长序列:结合了 RNN 和 CNN 的特点,通过引入选择机制,允许模型根据当前输入有选择地传播或忘记信息,从而提高了处理文本信息的效率。与 Transformer 架构中自注意力机制需要关注输入序列中的所有位置不同,Mamba 架构在处理长序列时无需过多的计算能力和内存来处理不断增长的上下文窗口,能够更好地应对长距离依赖关系,并且在处理较长文本时不会遇到像 Transformer 那样的困难。

- 硬件感知的并行算法:以递归模式运行,避免了 GPU 内存层级之间 I/O 访问,极大地提高了计算效率,使其能够在有限的硬件资源下实现更高效的计算。

- 简化的架构设计:将 SSM 架构和 Transformer 中的 MLP 块结合为单一的块,进一步优化了模型的结构,减少了计算复杂度,同时也为模型的训练和推理带来了更高的效率。

三、Falcon Mamba 7B 的性能优势

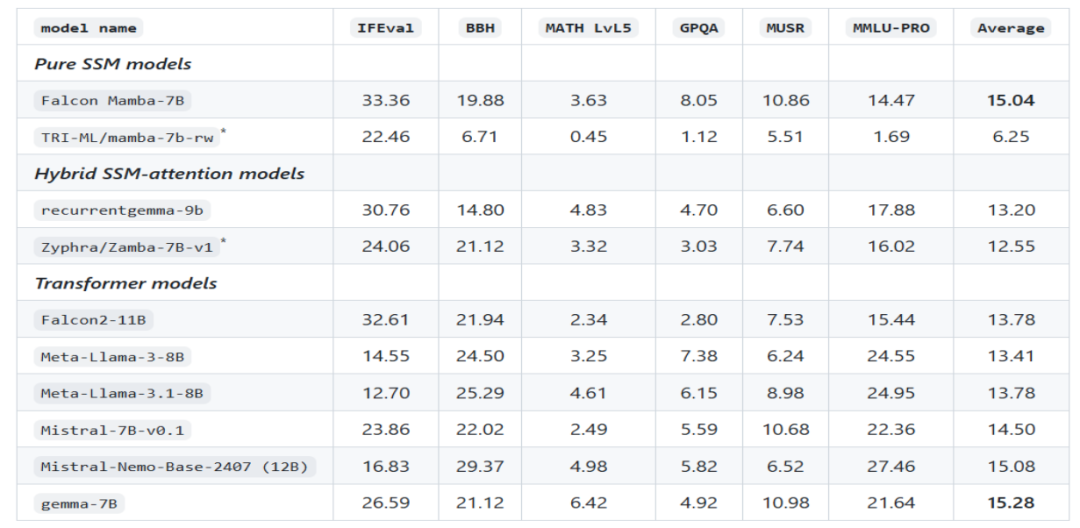

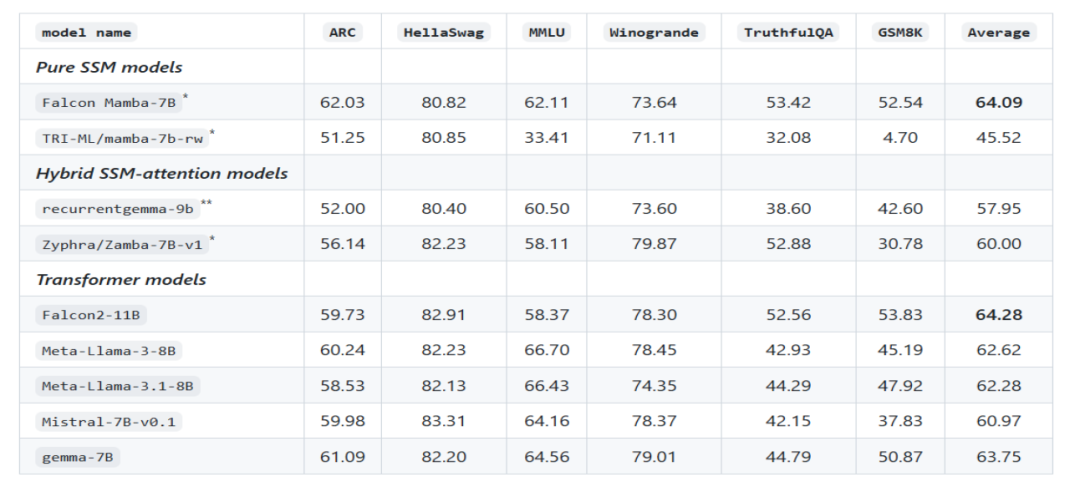

在多个基准测试中,Falcon Mamba 7B 的均分超过了如 Llama 3.1 8B 和 Mistral 7B 等同尺寸级别的领先模型。例如,在使用 lm-evaluation-harness 包进行的模型评估中,Falcon Mamba 7B 获得了较高的均分,展示出了其在各种文本生成任务上的出色表现。

图片

图片

官方根据 LLM 排行榜第一版的基准评估我们Falcon Mamba 7B模型

图片

图片

四、模型训练与数据

Falcon Mamba 7B 使用了约 5500GT(相当于 5.5B token)的数据进行训练。这些数据主要由 RefinedWeb 数据组成,并添加了公共来源的高质量技术数据和代码数据。在训练过程中,大部分时间使用了恒定的学习率,随后进行了一个较短的学习率衰减阶段。在最后阶段,还加入了一小部分高质量的精选数据,以进一步提升模型性能。这种精心设计的训练策略和多样化的数据来源,使得 Falcon Mamba 7B 能够充分学习到不同领域和类型的知识,从而具备更广泛的知识覆盖和更强的泛化能力。

五、实际应用场景与潜力

由于 Falcon Mamba 7B 具备处理任意长度序列、高效的计算能力和出色的内存效率等优势,它在众多实际应用场景中具有巨大的潜力。

- 企业级机器翻译:能够准确地处理大规模的文本翻译任务,无论是长篇文档还是实时的多语言交互翻译,都可以提供高质量的翻译结果,提高翻译效率和准确性。

- 文本摘要生成:可以快速地从大量文本中提取关键信息,生成简洁而准确的摘要,帮助用户快速了解文本的核心内容,节省阅读时间和精力。

- 算机视觉任务中的文本处理:例如在图像描述生成、视频字幕生成等方面,能够根据图像或视频内容生成准确的文本描述,为计算机视觉与自然语言处理的结合提供有力支持。

- 音频处理:对于音频文件中的语音内容进行识别和理解,实现语音转文本、语音指令处理等功能,为音频相关的应用场景提供智能解决方案。

- 估计和预测任务:凭借其对数据的深入理解和强大的计算能力,可以在金融、气象、物流等领域进行数据的分析和预测,为决策提供参考依据。

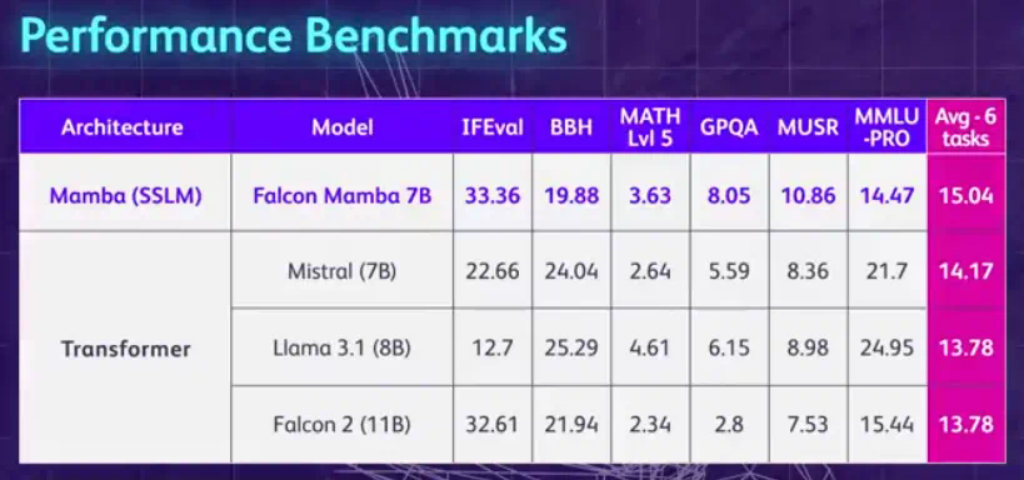

六、与其他模型的比较

与传统的 Transformer 架构模型相比,Falcon Mamba 7B 在处理长序列和内存使用方面具有明显优势。而与其他采用 Mamba 架构的模型,如 Mistral 发布的首个基于 Mamba 架构的开源大模型 CodeStral 7B 相比,Falcon Mamba 7B 在性能和通用性上表现更为突出,能够处理各种文本生成任务,而不仅仅局限于特定领域。

图片

图片

七、模型本地部署推理

Falcon Mamba 架构将在 Hugging Face transformers 库的新版本 (>4.45.0) 中提供。要使用该模型,请确保安装最新版本的 Hugging Face transformers 或从源安装库。

pip install transformers >4.45.0模型下载,要下载模型到本地进行推理,可参考下面指令:

git clone https://huggingface.co/tiiuae/falcon-mamba-7bFalcon Mamba 与您熟悉的 Hugging Face 提供的大多数 API 兼容,例如 或 :AutoModelForCausalLMpipeline

from transformers import AutoModelForCausalLM, AutoTokenizer

model_id = "tiiuae/falcon-mamba-7b"

tokenizer = AutoTokenizer.from_pretrained(model_id)

model = AutoModelForCausalLM.from_pretrained(model_id, torch_dtype="auto", device_map="auto")

inputs = tokenizer("Hello world, today", return_tensors="pt").to(0)

output = model.generate(**inputs, max_new_tokens=100, do_sample=True)

print(tokenizer.decode(Output[0], skip_special_tokens=True))由于模型很大,它还支持量化等功能,以便在较小的 GPU 内存约束上运行模型,例如:bitsandbytes

from transformers import AutoModelForCausalLM, AutoTokenizer, BitsAndBytesConfig

model_id = "tiiuae/falcon-mamba-7b"

tokenizer = AutoTokenizer.from_pretrained(model_id)

quantization_config = BitsAndBytesConfig(load_in_4bit=True)

model = AutoModelForCausalLM.from_pretrained(model_id, quantization_cnotallow=quantization_config)

inputs = tokenizer("Hello world, today", return_tensors="pt").to(0)

output = model.generate(**inputs, max_new_tokens=100, do_sample=True)

print(tokenizer.decode(output[0], skip_special_tokens=True))结语

尽管 Falcon Mamba 7B 取得了显著的成绩,但在实际应用中仍然面临一些挑战。例如,在处理某些复杂语言结构或特定领域的专业知识时,可能需要进一步优化和改进。此外,随着人工智能技术的不断发展,如何进一步提高模型的性能、拓展其应用领域、增强其可解释性以及应对数据隐私和安全等问题,都是未来需要探索和解决的方向。

总之,Falcon Mamba 7B 作为全球首个通用大型 Mamba 架构模型,以其独特的架构、出色的性能和广泛的应用潜力,为人工智能领域带来了新的活力和机遇。随着对其研究和应用的不断深入,相信它将在未来的各种场景中发挥更加重要的作用,为推动人工智能技术的发展和应用做出更大的贡献。我们也期待着在未来看到更多基于 Falcon Mamba 7B 进行改进和创新的模型和应用,共同推动人工智能领域迈向新的高度。

相关资料

Hugging Face 地址:https://huggingface.co/tiiuae/falcon-mamba-7b

博文介绍:https://huggingface.co/blog/falconmamba

github地址:https://github.com/huggingface/blog/blob/main/falconmamba.md