继上周出现2000亿大跌后,本周三,英伟达又迎来了8%的股价飙升。

截至收盘时,股价已回升至116.91美元,部分扭转了前段时间大跌的损失。

老黄再次表示,自家芯片正面临「惊人的」需求,甚至由于客户争相购买,已经到了「全部售罄」的程度。

老黄:大家都在指望我们

老黄最大的担忧是什么?

在高盛的「Communacopia+」技术大会上,高盛CEO David Solomon向老黄发问,而他的回答出乎意料:

「我们肩负着很多人的期望,大家都指望着我们。」

何以如此?

老黄补充了其中的原因——「需求如此之大,以至于组件、技术、基础设施和软件的交付很容易让人情绪化,因为这直接影响到收入,直接影响到竞争力。」

甚至,彭博社的报道指出,对有限供应的芯片的争夺让人沮丧,加剧了客户之间的紧张局势。

追捧英伟达的也绝不止需要GPU的客户。

在高盛的会议开始前一个多小时,投资者和记者们就在门外排起了长队,只为能一睹老黄的风采。

对于老黄来说,股价暴跌、反垄断风波相继袭来,这次主题演讲也是绝佳的安抚投资人情绪的机会。

老黄表示,尽管GenAI仍处于早期阶段,但即将扩展到数据中心之外。

「现在令人惊叹的是,投在数据中心上的第一笔万亿美元资金心将加速这种新型软件的发明——生成式AI。它不仅仅是一种工具,更是一种技能。」

「我们将首次创造出增强人类的技能。」

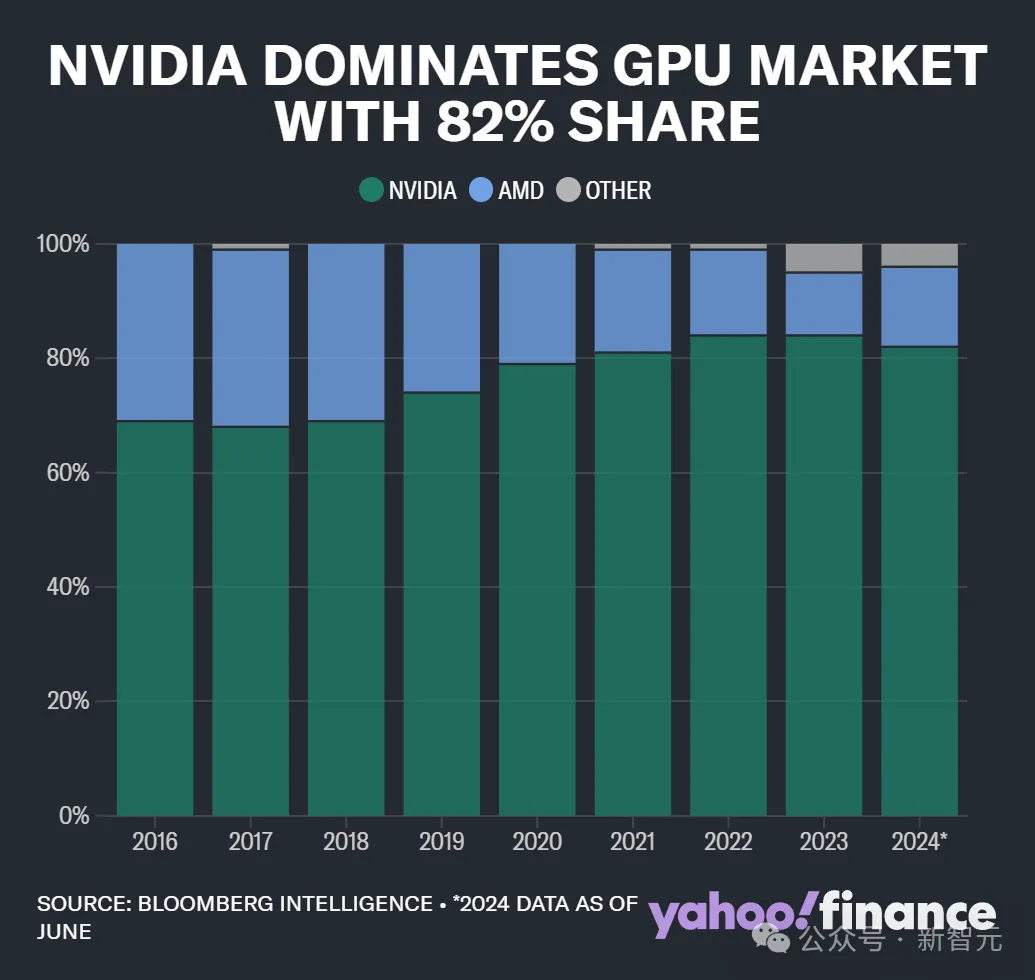

英伟达在GPU市场的份额

在这场GenAI热潮中,很多人都没有想到,最先赚得盆满钵满的,是「卖铲子」的英伟达。

但GenAI能否持续给AI企业带来盈利?英伟达收获「惊人回报」之后又如何?

前段时间被问到这些问题时,老黄并没有给出让人信服的答案。

而这次会议上,他着重阐述了作为基础设施提供商的英伟达,如何参与并推动GenAI变革。

比如,「the more you buy, the more you save」,到底是个什么逻辑?

根据老黄所说,云服务提供商在英伟达这里花的每一分钱,都能从租金上赚回5倍。

英伟达的服务器虽然看起来很昂贵,每个机架动辄数百万美元,但实际上可以替代数千个节点。

划重点:购买云服务的客户际上是在租用GPU的计算时间。

如果云平台将将传统的数据处理工作转变为加速计算方法,增量成本可能会翻倍,但工作速度将提高20倍,相当于节省了10倍的费用。

老黄表示,「这种投资回报率并不罕见。」

「更令人惊讶的是,连接旧的通用计算系统的电缆成本,不如全部换掉并集中到一个机架中密集部署,来得更省钱。」

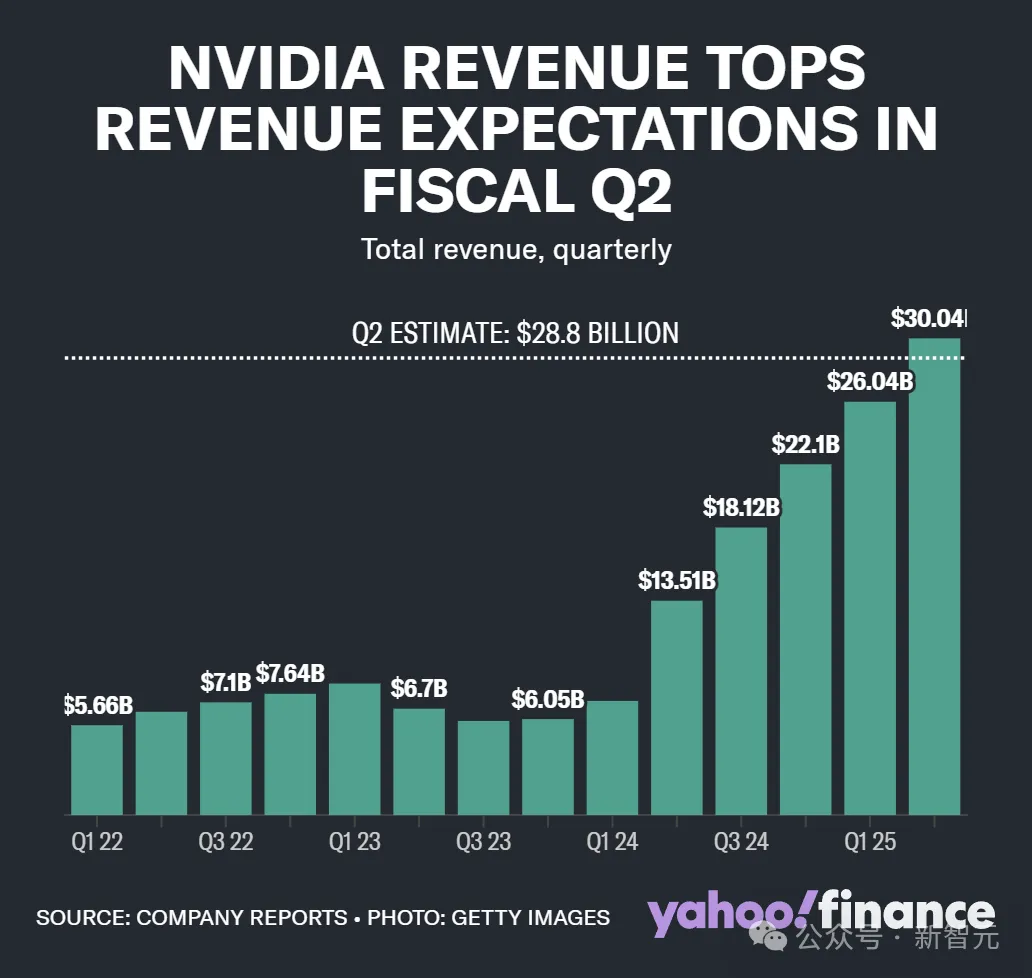

英伟达历年收入,2024年预计达到创下新高的300.4亿美元

加速一切

即使云平台能赚到钱,但对AI公司来说,训练GenAI要花这么多钱「买铲子」,值得吗?

老黄认为,虽然训练AI模型需要密集的资源投入,但从长远来看是值得的。

「其中一个要点是,AI当然不仅仅是关于训练模型,这只是第一步,关键在于使用模型,这可以帮我们节省大量时间——处理时间。」

比如,仅仅是观赏芯片设计公司如何利用AI,就是一件令人惊叹的事。

「每一行代码都由软件工程师编写的时代已经彻底结束了,每一个工程师基本上都会有24/7全天候工作的数字工程师伙伴——这就是未来。」

除了加速计算,老黄自己的生物钟也在「狂飙」。

由于产品交付的责任过于重大,压力重重的老黄甚至表示「少睡一点没关系,睡足三个小时就可以了。」

他还放出话来,英伟达目前有3.2万名员工,不久的将来他们就会有「数量增加100倍的数字工程师」来补充。

对于AI的投资回报率何时显现的问题,老黄的答案是敦促公司「加速一切」——任何大规模的数据处理,都必须加速。

他表示,将现有数据中心升级为「加速计算」,即由英伟达GPU和其他AI芯片支持的并行计算,是不可避免的。

配备液冷的、更小更密集的数据中心是未来的发展方向,密集化的数据中心将更具能源和成本效益,「这就是未来十年」。

有趣的是,老黄的这场演讲似乎收获了他理想中的效果。对话开始后不到一小时,英伟达的股价开启飙升。

然而,即便英伟达宣称的AI计算更节能是属实的,AI热潮对电网造成的压力仍是巨大的。

就连老黄本身也指出,参与热潮的各方都面临着巨大的挑战。

Blackwell迟迟不发,大客户情绪激动

会议上,老黄亲口承认,芯片的需求紧张,让客户们逐渐坐不住了

「我们的组件、技术、基础设施和软件的交付让人们情绪波动很大,因为直接影响到他们的收入和竞争力」。

「所以我们今天可能有更多情绪激动的客户……这是理所当然的」。

为此,老黄还「贴心」地安抚了大客户们的不满情绪,他称英伟达非常理解大客户们(亚马逊、微软和谷歌)对于GPU供不应求的焦虑。

他也同样大方承认,是英伟达的技术援引拖了Blackwell量产计划的后腿,导致客户们不得不购买可能不需要的网络设备或服务器机架。

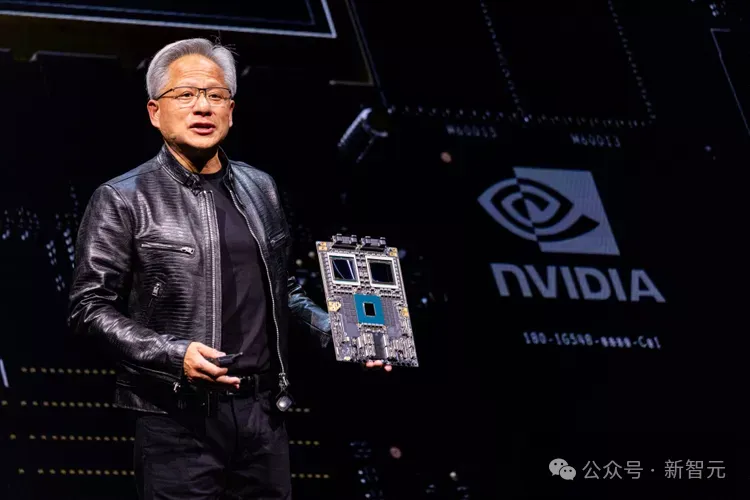

超级芯片GB200或将在年底量产

早前,迫于延迟交付的压力,英伟达的Blackwell更改了其6层GPU掩膜,使其可在不重新流片的情况下继续生产。

据报道称,更新版的GB200也将在10月底完成,并预计将于12月量产,在明年第一季度大规模交付。

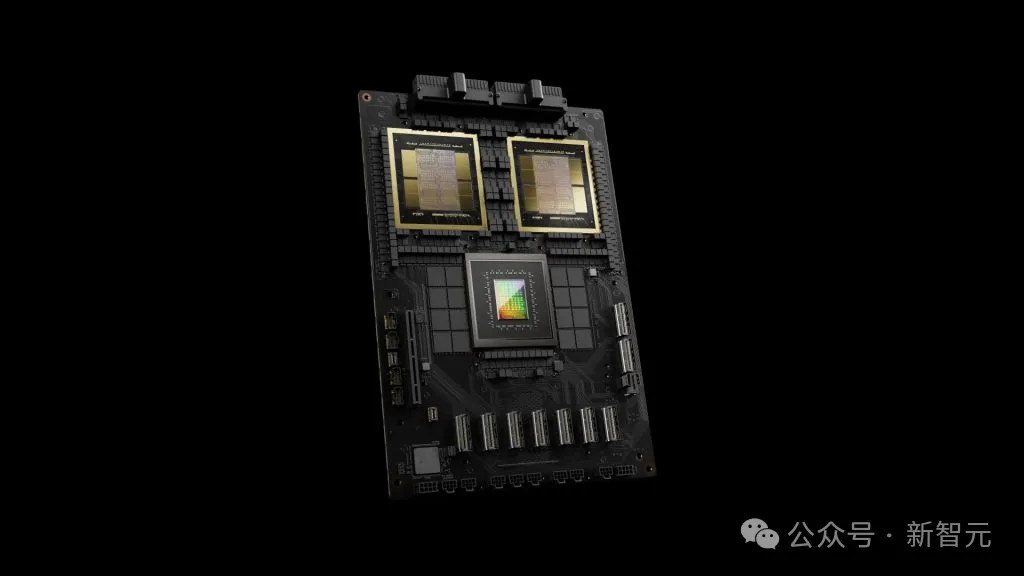

GB200由2个Blackwell B200 GPU和一个Arm架构的Grace CPU组成,号称在参数为1750亿的GPT-3 LLM基准测试中,性能达H100的7倍,速度达H100的4倍。

此前,GB200的大规模出货也曾被报道将延迟一个季度,曾有报告暗示,其中的封装工艺可能存在bug。

甚至有知情人士称,Blackwell芯片曾在HV工艺中面临金属层不稳定的问题,直到7月问题才解决。

虽然该问题发生在较为靠后的工序中,不需要新的流片,但受限于台积电CoWoS-L技术的产能,今年GB200的先进封装预计仍将采用CoWoS-S。