本文经自动驾驶之心公众号授权转载,转载请联系出处。

原标题:DiVE: DiT-based Video Generation with Enhanced Control

论文链接:https://arxiv.org/pdf/2409.01595

项目链接:https://liautoad.github.io/DIVE/

代码链接:https://github.com/LiAutoAD/DIVE

作者单位:哈尔滨工业大学(深圳) 理想汽车 清华大学 Westlake University 新加坡国立大学

论文思路:

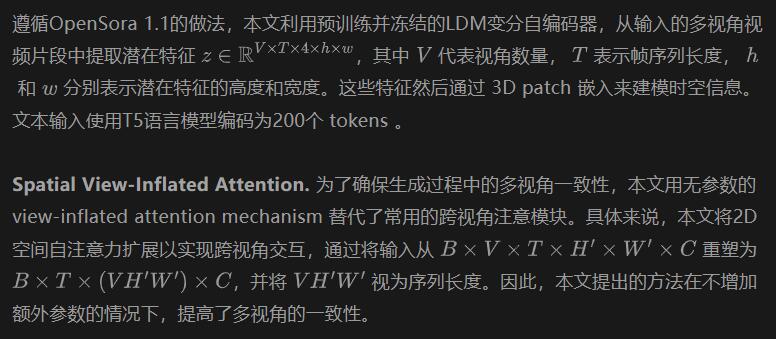

在自动驾驶场景中生成高保真、时间一致性的视频面临着显著的挑战,例如在极端情况(corner cases)下的问题操作(problematic maneuvers)。尽管最近提出了一些视频生成工作来解决上述问题,例如基于 Diffusion Transformers(DiT)的模型,但仍然缺乏专门探索多视角视频生成潜力的研究。值得注意的是,本文提出了首个基于DiT的框架,专门设计用于生成与给定鸟瞰图布局控制精确匹配的时间和多视角一致性视频。具体而言,所提出的框架利用无参数的 spatial view-inflated attention 来保证跨视角一致性,其中集成了 joint cross-attention modules 和ControlNet-Transformer 以进一步提高控制的精度。为了展示本文的优势,本文在nuScenes数据集上进行了广泛的定性比较,特别是在一些最具挑战性的极端情况下。总的来说,本文提出的方法在困难条件下生成长时间、可控且高度一致性视频方面被证明是有效的。

论文设计:

鸟瞰视角(Bird’s-Eye-View, BEV)感知在自动驾驶中引起了极大的关注,突显了其在3D目标检测等任务中的巨大潜力。最近的方法如StreamPETR 利用多视角视频进行训练,强调了广泛且良好标注的数据集的必要性。然而,在各种条件下收集和标注此类数据具有挑战性且成本高昂。为了解决上述挑战,生成模型的最新进展表明,合成数据可以有效地提高目标检测和语义分割等各种任务的性能。

由于时序数据在视频中的参与在相关感知任务中起着至关重要的作用,本文的重点转向生成高质量的真实感视频。实现现实世界的逼真度需要高视觉质量、跨视角和时间一致性以及精确的可控性。值得注意的是,最近方法的潜力受到限制,原因包括低分辨率、固定纵横比以及物体形状和颜色的不一致性。受Sora在生成高质量、时间一致性视频任务中成功表现的启发,本文在工作中采用 Diffusion Transformer (DiT) 进行可控的多视角视频生成。

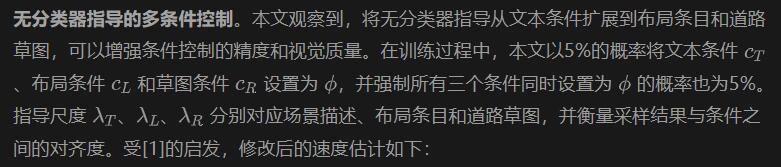

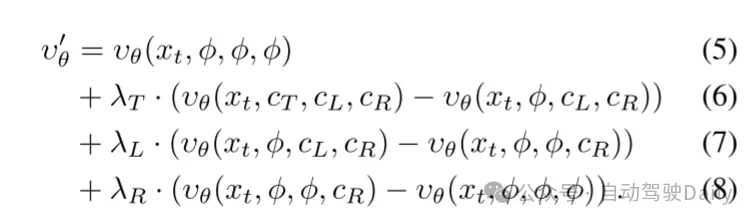

本文提出的框架是首批在驾驶场景中使用 DiT 进行视频生成的工作之一,通过整合 BEV 布局和场景文本,实现了精确的内容控制。基于OpenSora架构,本文的方法嵌入了 joint cross-attention modules ,以管理来自鸟瞰视角的场景文本和实例布局。扩展ControlNet-Transformer方法以适应道路草图,本文通过无参数的 spatial view-inflated attention 确保多视角一致性。为了支持多分辨率生成、更快的推理以及不同的视频长度,本文采用了OpenSora的训练策略,并引入了一种新颖的无分类器指导技术,以增强控制和视频质量。

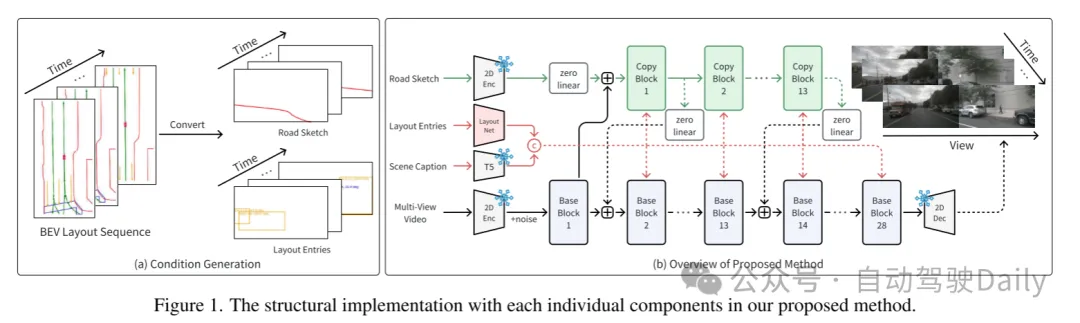

图1. 本文提出的方法中每个独立组件的结构实现。

图1. 本文提出的方法中每个独立组件的结构实现。

本文的模型总体架构如图1所示。采用OpenSora 1.1提出的参数模型作为基线模型。为了实现对前景和背景信息的精确控制,本文将通过投影从3D几何数据中提取的布局条目和道路草图整合到布局条件视频生成过程中。本文提出的新模块和训练策略将在接下来的部分中分别介绍。

多条件时空DiT

Caption-Layout Joint Cross-Atttention. 按照MagicDrive的方法,本文使用交叉注意力机制来整合场景描述(scene captions)和布局条目(layout entries)。布局条目(即实例的详细信息,如2D坐标、朝向和ID)经过傅里叶编码后合并为一个统一的嵌入。实例标题则使用预训练的CLIP模型进行编码。这些嵌入被连接并通过一个多层感知器(MLP)处理,生成最终的布局嵌入,该嵌入与场景描述嵌入一起作为交叉注意力机制的条件。

ControlNet-Transformer。深入细节,本文引入了ControlNet-Transformer,以确保对道路草图控制的精确性,灵感来自PixArt-δ。实际上,一个预训练的变分自编码器(VAE)从道路草图中提取潜在特征,这些特征然后通过 3D patch embedder 处理,以确保与本文主网络的一致性。为了参数化本文提到的设计,本文将13个重复块(duplicated block)与DiT架构的前13个基础块集成。每个重复块结合了道路草图特征和基础块输出,使用空间自注意力来减少计算开销。

训练

可变分辨率和帧长度。遵循OpenSora的做法,本文采用了Bucket策略,以确保每个批次中的视频具有一致的分辨率和帧长度。

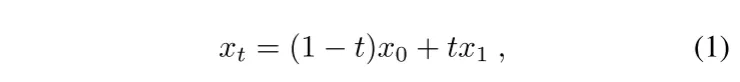

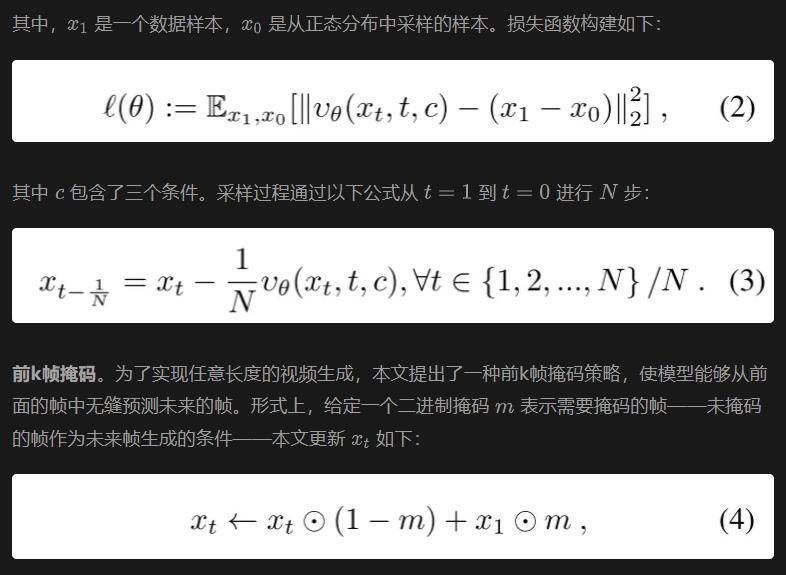

Rectified Flow。受OpenSora 1.2的启发,本文在后期训练阶段用校正流替代了IDDPM,以提高稳定性并减少推理步骤。校正流是一种基于 ODE 的生成模型,其定义了数据和正态分布之间的前向过程如下:

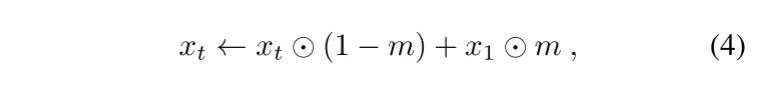

损失仅在未掩码的帧上计算。在推理过程中,视频以自回归方式生成,前一个片段的最后k帧作为下一个片段的条件。

实验结果:

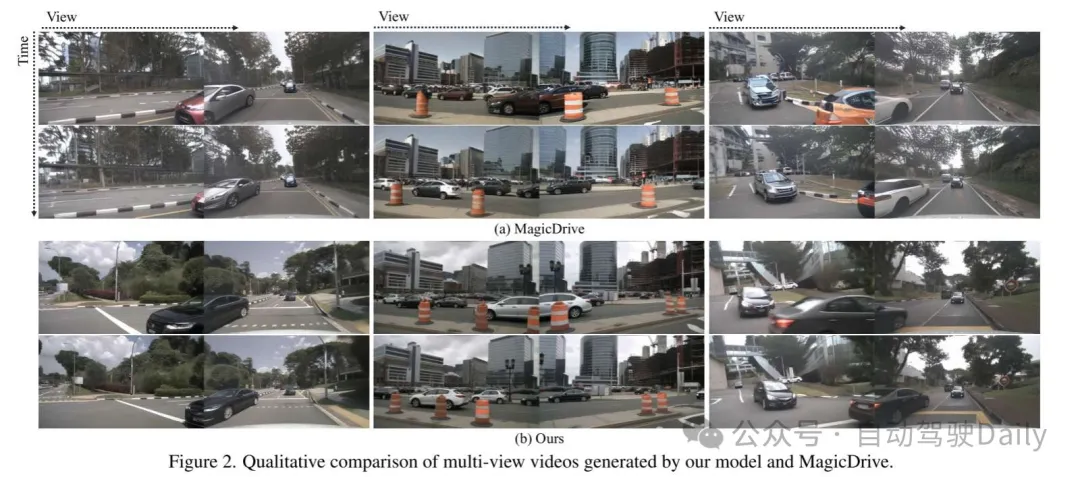

图2. 本文的模型与MagicDrive生成的多视角视频的定性比较。

图2. 本文的模型与MagicDrive生成的多视角视频的定性比较。

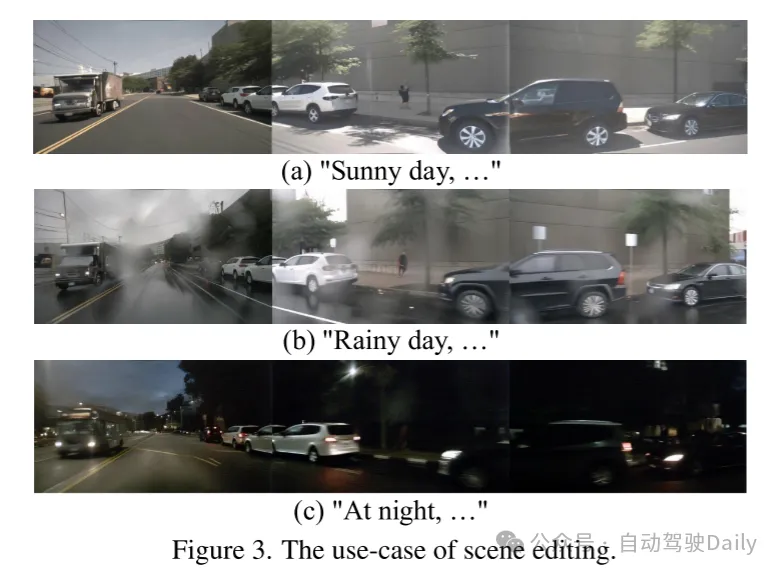

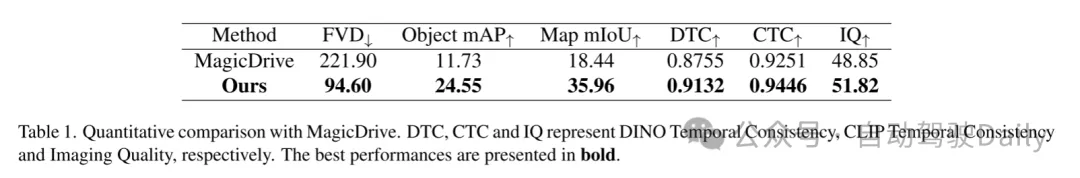

图3. 场景编辑的使用案例。 表1. 与MagicDrive的定量比较。DTC、CTC和IQ分别代表DINO时间一致性、CLIP时间一致性和图像质量。最佳表现以粗体显示。

表1. 与MagicDrive的定量比较。DTC、CTC和IQ分别代表DINO时间一致性、CLIP时间一致性和图像质量。最佳表现以粗体显示。

总结:

本文提出了首个针对驾驶场景的基于DiT的可控多视角视频生成模型。通过整合 ControlNet-Transformer 和 joint cross-attention ,实现对 BEV 布局的精确控制。Spatial view-inflated attention 结合全面的训练和推理策略,确保了高质量和一致性的视频生成。与MagicDrive的比较和各种可视化进一步展示了该模型在生成视频中的卓越控制和一致性。