本文经自动驾驶之心公众号授权转载,转载请联系出处。

- 论文链接:https://arxiv.org/pdf/2408.13742

- 代码链接:https://github.com/HKUST-Aerial-Robotics/MIND

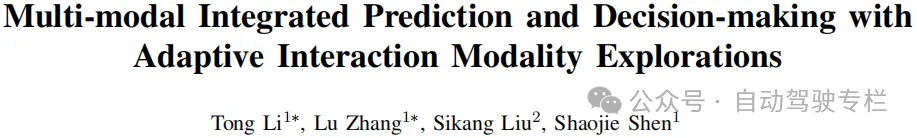

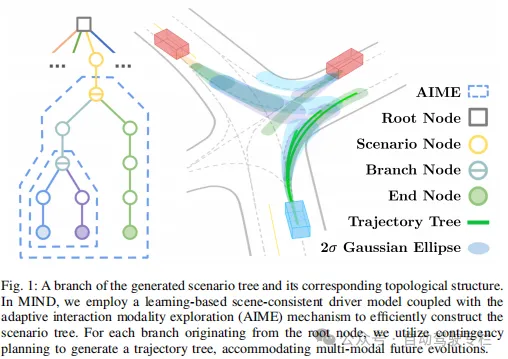

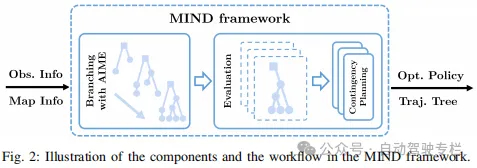

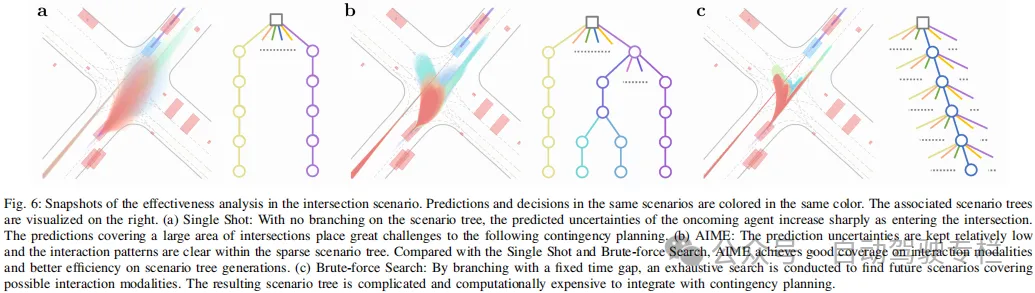

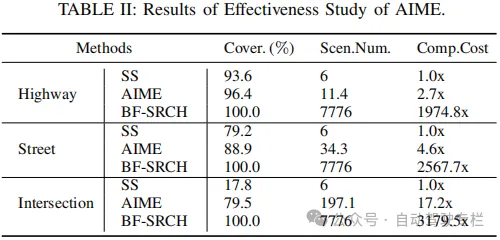

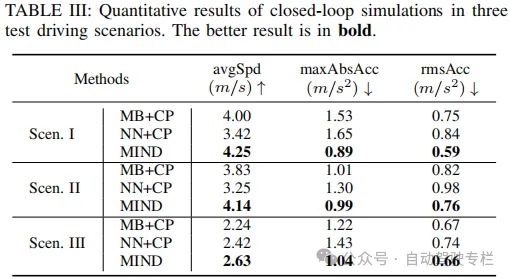

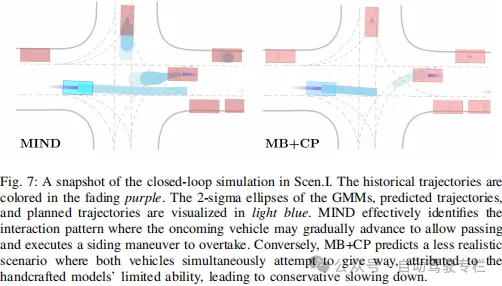

本文介绍了基于自适应交互模态探索的多模态集成的预测与决策。由于多模态交互的复杂性,在拥堵且动态的环境中导航给自动驾驶系统带来了重大挑战,其中各种交通参与者和自动驾驶车辆的行为是复杂的,并且是隐式耦合的。本文提出了一种新的框架,即多模态集成的预测与决策(MIND),其通过高效地生成涵盖多种不同交互模态的联合预测和决策来解决这些挑战。具体而言,MIND利用基于学习的场景预测来获得具有社会一致性交互模态的集成预测和决策,并且利用模态感知动态分支机制来生成场景树,该场景树高效地捕获不同交互模态的演变,其在规划范围内交互不确定性的变化较小。交互不确定性下的应急规划无缝地利用场景树来获得明确且考虑多模态演变的行为。基于现实世界驾驶数据集的闭环仿真中的综合实验结果表明,本文方法在各种驾驶环境下的性能优于其它强大的基线。

主要贡献

本文的贡献总结如下:

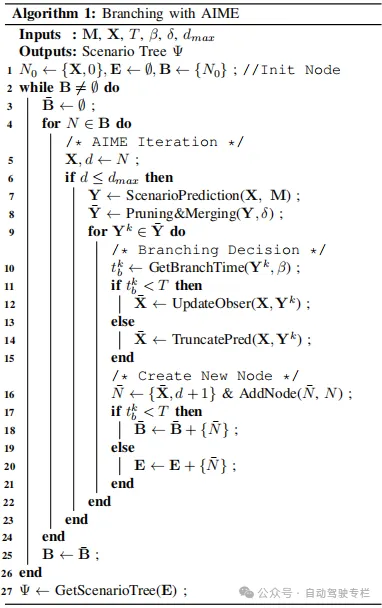

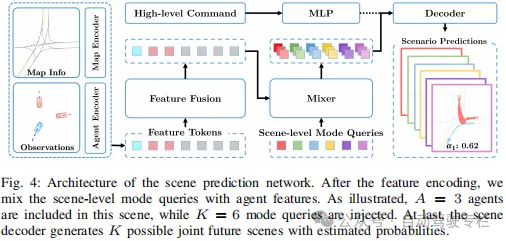

1)本文设计了一种场景预测网络,并且将其与具有动态分支机制的树搜索技术相结合,从而获得覆盖范围更广的场景树,用于探索世界的演变;

2)对于场景树中的多种潜在未来变化,本文利用应急规划来自然地生成针对从根开始的每个分支的最优轨迹树,从而确定最佳决策;

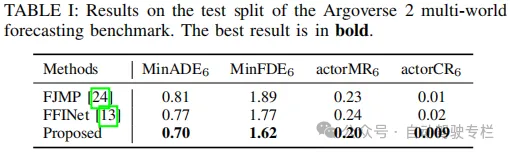

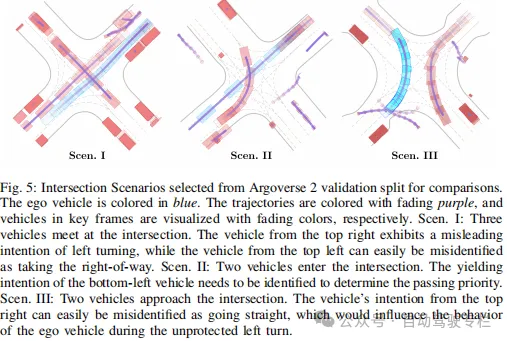

3)本文通过各种实验评估MIND,结果表明,在不同的驾驶场景中优于其它基线,展现了其在复杂情况下的有效性。

论文图片和表格

总结

本文引入了MIND框架,其作为动态交互环境中实现自动驾驶同时预测与决策的综合方法。该框架系统性地结合了场景预测网络、自适应交互模态探索机制和应急规划,以在处理多模态未来演变的同时,在复杂交互场景中生成合理的行为。与最新技术的广泛定量比较以及定性实验证明了本文方法的优越性。展望未来,本文旨在将所提出的框架扩展到现实世界应用中。