一、从工程化视角看数据建设

在当前大模型技术快速发展的背景下,数据对模型效果的影响力日益增强。对于希望从零开始训练一个具有千亿参数规模的大型模型的团队来说,整个任务流程的规划和执行成为了一个重要议题。接下来详细探讨从工程化视角下的数据建设过程,包括数据准备、预训练、后训练以及数据版本的动态调整。

1. 数据准备与训练流程

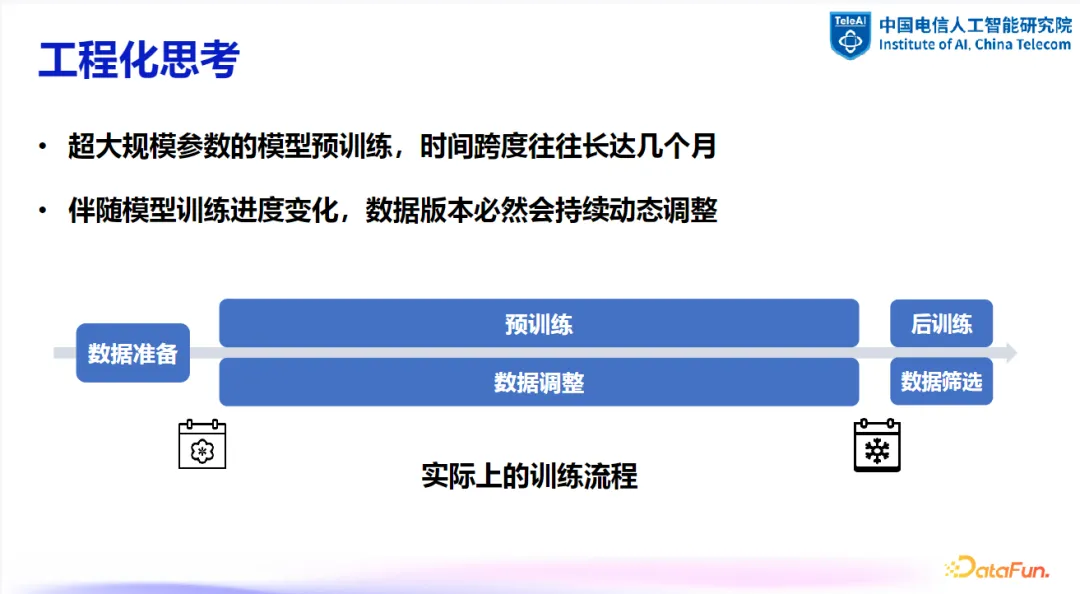

理想情况下,大模型的训练流程可以分为三个阶段:数据准备、预训练与后训练。然而,实际情况远比这一理想化的模型复杂。可以将其比喻为“把大象放进冰箱”的问题,即分为三个步骤:数据收集、预训练及后训练。实际操作中,这一过程的复杂性主要体现在两个方面:

- 预训练周期长:预训练阶段不仅时间跨度长,而且涉及大量的数据和资源协调。一个模型从开始训练到结束,可能会经历季节的更迭。

- 数据版本动态调整:伴随模型训练进展,数据版本需要持续动态调整。初始的数据准备可能无法完全满足模型训练的需求,因此在整个训练过程中需要不断地进行微调。此外,在后训练阶段,还需要对数据进行筛选,以适应模型训练的前进方向。

2. 影响数据版本更新的因素

影响数据版本更新的主要因素包括:

- 数据来源变更:数据来源的变化直接影响数据的构成与质量。

- 新数据引入:随着数据市场的不断发展,引入新数据成为一种可能。通过分析不同数据来源和通用语料长度,可以得出实际的需求量与市场库存量之间的差异。这一差异表明,尽管数据市场在繁荣发展,但要通过采购方式获取足量的训练数据仍具有挑战性。

- 数据配比差异:在训练过程中,数据的自然配比与理想的配比可能存在差异,需要根据训练情况适时调整。

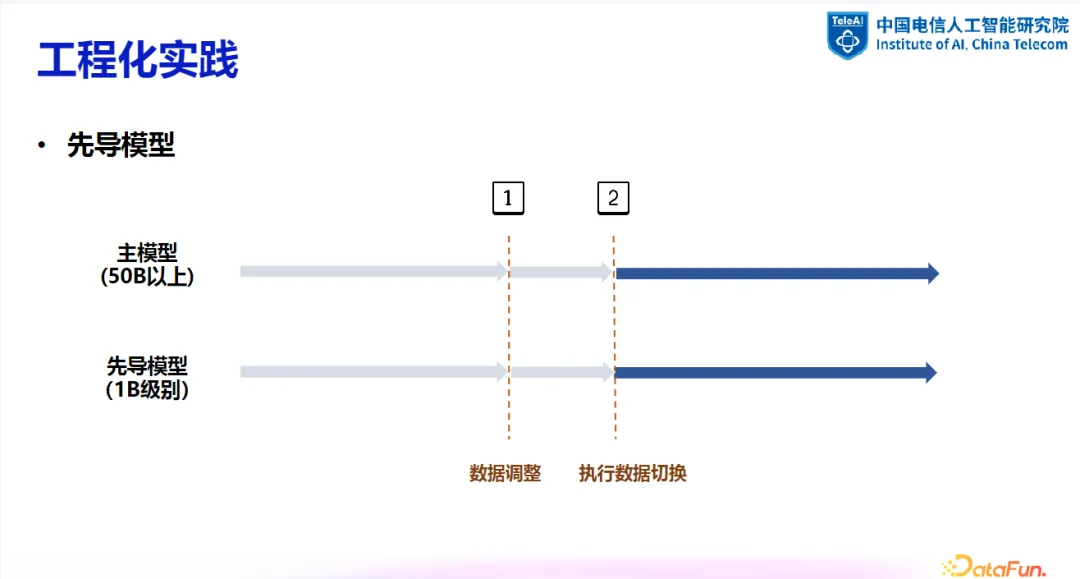

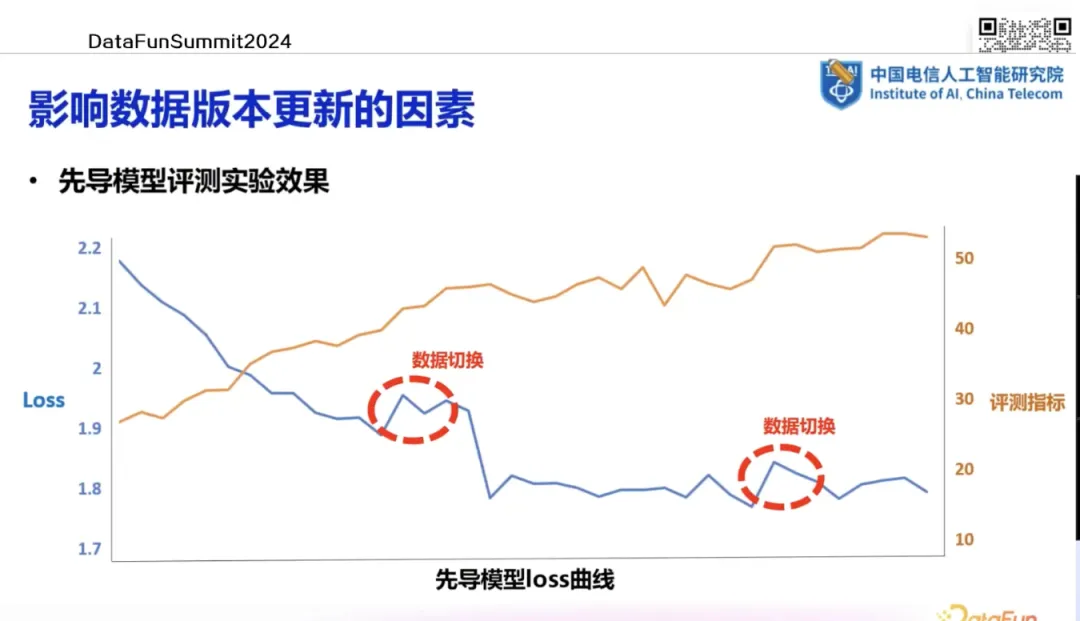

3. 先导模型在工程实践中的应用

在工程实践中,常用的方法是训练一个先导模型来监控数据变化并及时作出调整。先导模型的规模通常较小,如 1B 参数级别。当需要调整数据时,可通过先导模型进行一系列实验,包括数据去重、清洗及配比调整等,并对效果进行评估。一旦确定可行方案,即可同步应用于主模型。

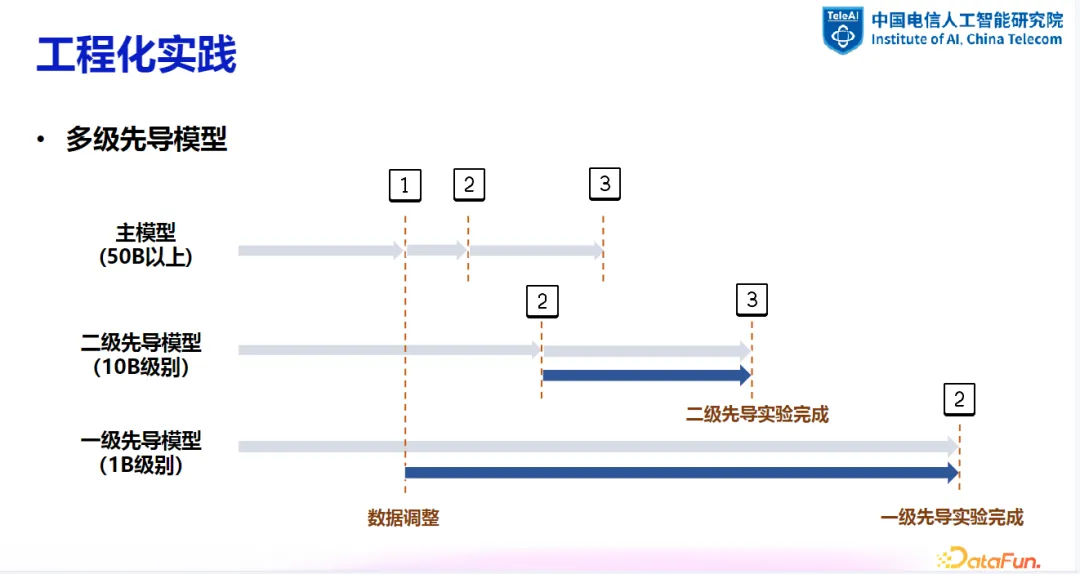

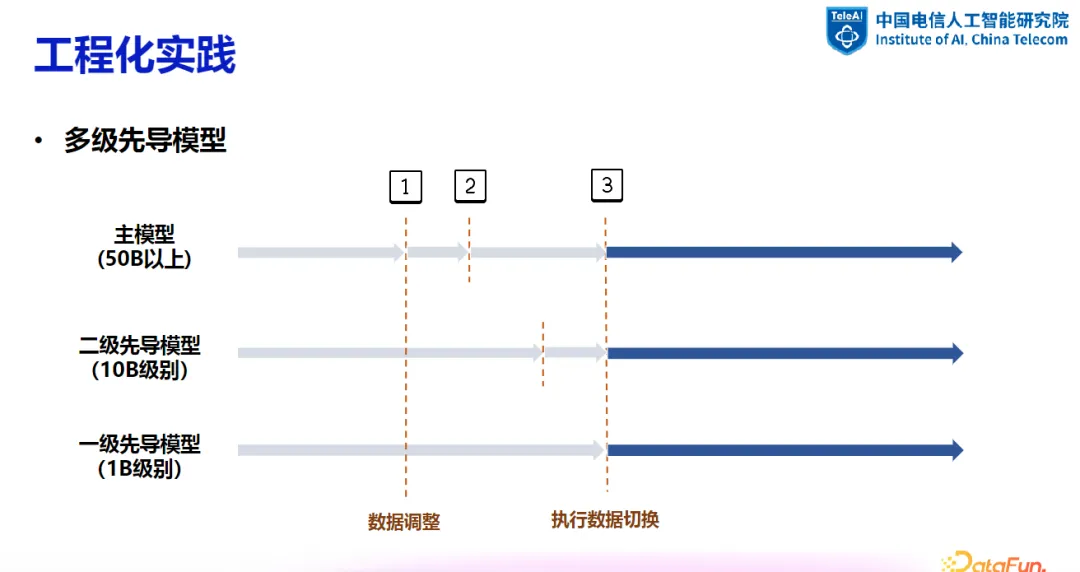

在某些情况下,一级先导模型可能无法完全满足数据调整的需求,这时可能需要二级甚至多级先导模型来进行更细致的追随训练。在多级先导模型的设置中,可能需要进行二次甚至多次的先导实验,以确保决策的准确性。这种多级实验虽然增加了时间和算力成本,但在减少 token 消耗的同时,提高了实验结果的可靠性。

4. 评测指标与数据版本更新

在训练过程中,通过对先导模型进行评测,可以发现特定领域的不足之处(如数学或编程能力)。基于评测结果,可以针对性地调整数据配置,从而改善模型性能。

5. 数据处理流程

不同的数据版本更新方式会触发不同的数据处理流程。如果数据更新是由数据变化触发的,则可能需要从头到尾进行数据处理的各个步骤;如果是通过评测引导的方法来触发,则只需调整数据配比和领域选择。

二、预训练数据配比策略

在大模型的预训练过程中,数据配比对于模型性能有着至关重要的影响。通过采用 DoReMi 方法、双层优化算法以及在线领域采样权重调整等策略,可以有效提高模型的训练效率与性能。在实际应用中,还需考虑特定领域数据的重要性以及数据处理与解析的技术挑战。

1. 数据配比策略概述

我们平常提到的“数据配比”, 是指在预训练阶段对不同来源的数据配置不同权重,以期达到最优训练效果的过程。论文中通常采用的对应术语是 “数据混合”(Data Mixing)。

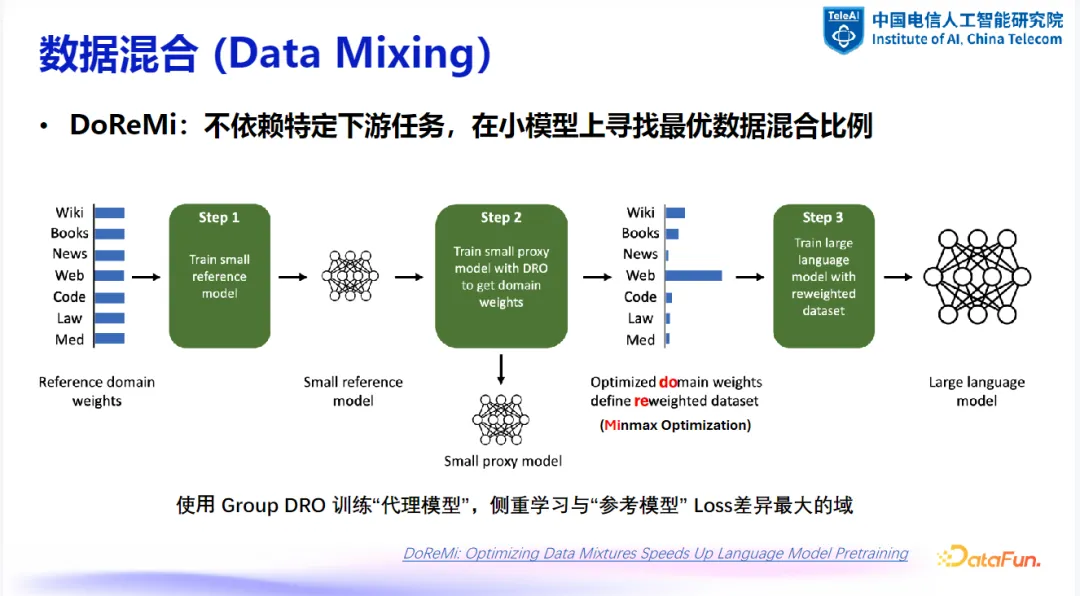

(1)DoReMi:一种经典的配比方法

DoReMi 方法是一种不依赖于特定任务的、在小模型上寻找最优数据混合比例的方法。该方法的基本流程如下:

- 训练参考模型:在数据的不同领域(domains)中设定一个归一化的初始权重,在上述权重下训练一个小的参考模型。

- 训练代理模型:利用 Group DRO 算法训练一个代理模型。在此过程中,代理模型与参考模型之间的损失(loss)在不同领域上存在差异。使用 Mini Max Optimization 算法来优化在代理模型与参考模型间差异最大的领域的权重。代理模型持续训练,而参考模型保持不变。通过代理模型与参考模型的交互过程,不断调整不同领域的权重。

- 大模型训练:获得优化后的权重后,用于训练最终的大模型。

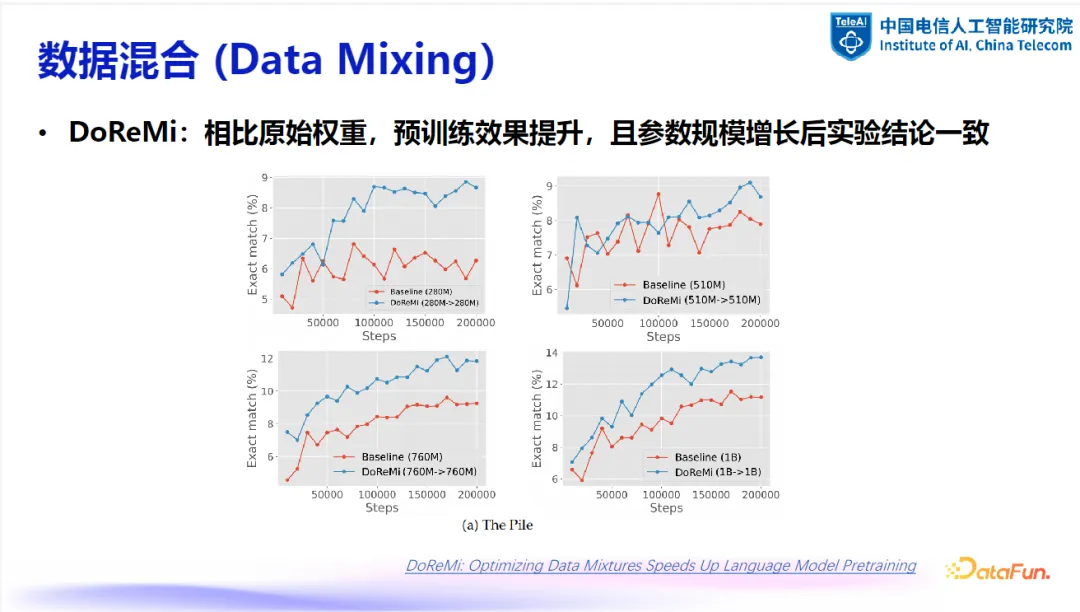

DoReMi 方法相较于原始权重,在预训练效果上有明显提升。例如,下图展示了采用 DoReMi 方法找到的最优化权重与使用经验配比所得到的最终模型训练效果对比。蓝线表示采用 DoReMi 方法的结果,红线表示基线结果,可以看出,DoReMi 方法在下游任务上取得了显著的提升,且随着模型参数量的增加,依然稳定提升。

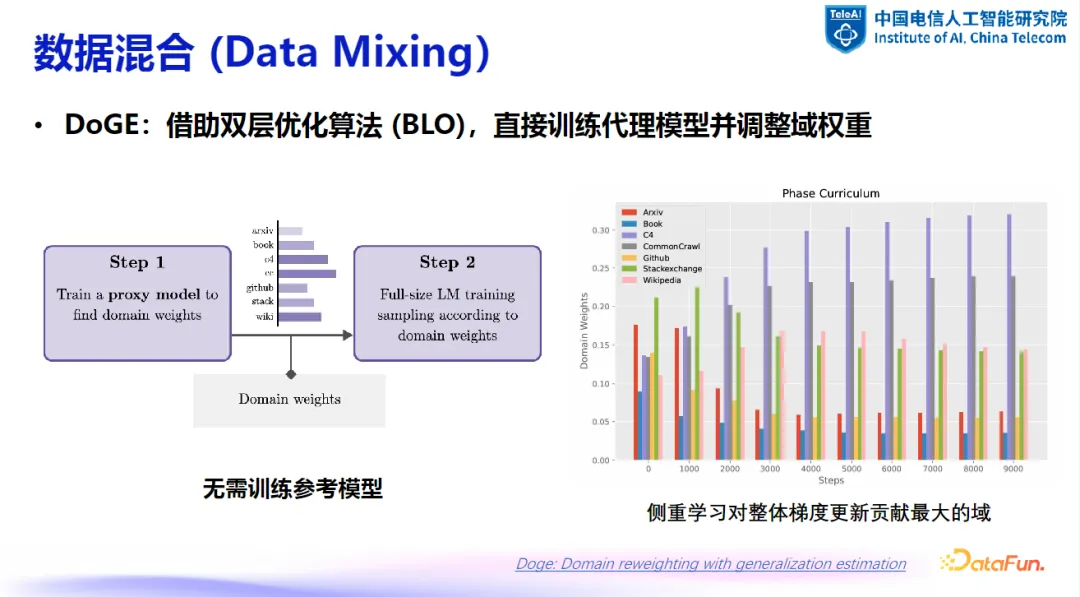

(2)DoGE:双层优化算法

另一种方法是通过双层优化算法直接训练代理模型来调整预训练数据的权重。这种方法的核心在于通过两步更新:第一步更新权重,第二步更新代理模型本身的权重。该算法更侧重于学习对整体梯度贡献较大的领域,即找出哪些领域的样本对代理模型的影响最大。这种方法不需要单独的参考模型,简化了训练流程。

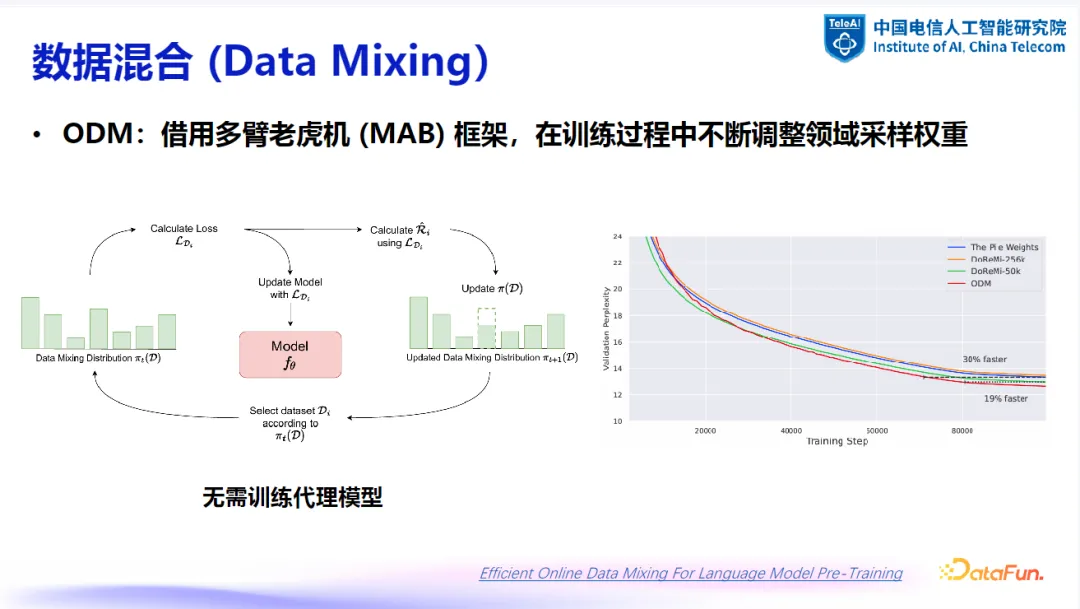

(3)ODM:在线领域采样权重调整

更进一步的方法是利用多臂老虎机(Multi-Armed Bandit)算法在线调整领域采样权重。该算法在强化学习中较为常见,通过模拟拉取老虎机的不同手臂来获得奖励。在预训练模型场景中,大模型可以被视为老虎机,不同的数据集对应不同的手臂。训练过程中,根据获得的奖励(即单个样本的损失)来调整采样权重,以优化整体训练效果。

2. 现有方法特点与局限

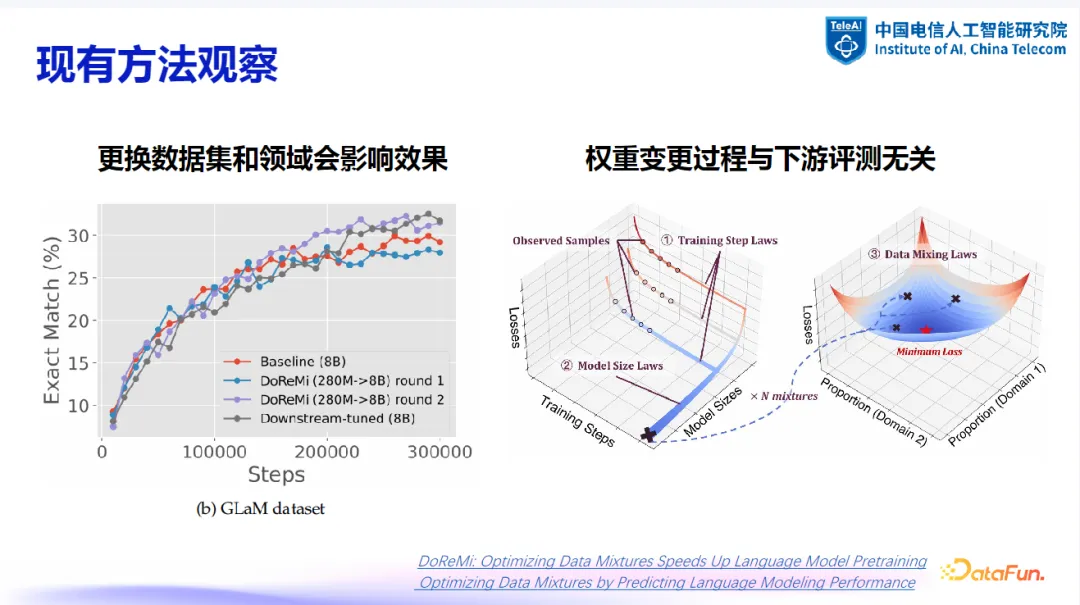

通过分析现有方法,可以总结出以下两点特征:

- 更换数据集和领域会影响效果:不同的数据集和领域会对参数更新效果产生显著影响。例如,DoReMi 方法在不同数据集上的效果差异较大,这表明数据集的多样性对训练效果至关重要。

- 权重变更过程与下游评测无关:权重变更过程通常不考虑下游任务的评测结果,而是侧重于寻找最优化的训练过程。这可能导致模型在某些特定任务上的表现不如预期。

3. 工程化实践中的数据配比调整

在工程化实践中,数据配比的调整是一个主动触发的过程,主要思路如下:

- 主动触发配比调整:在模型训练初期和中期,根据评测指标主动触发配比调整。

- 先导模型辅助:使用先导模型(如 DoReMi 方法)来优化数据配比。

- 避免直接应用算法:随着模型训练进展,避免直接应用高成本的算法。

4. 经验总结

在实际应用中,需要考虑以下几点:

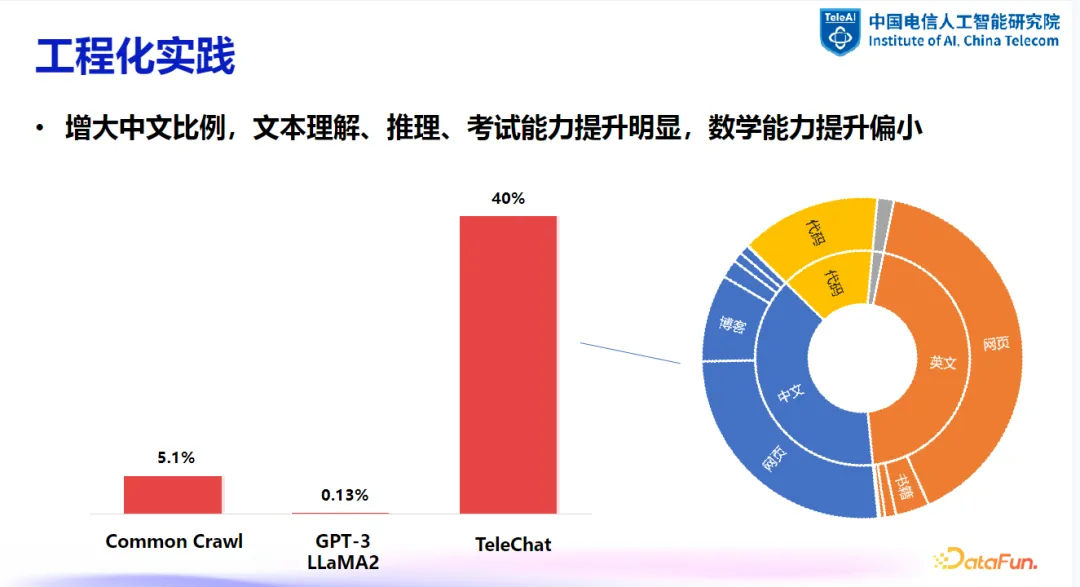

- 中文数据的重要性:增加中文数据比例可以显著提高模型在文本理解、推理等方面的性能。例如,一些主流开源数据集中,中文数据比例较低,但在国内应用中,增加中文数据比例至 40% 左右,可以使模型在英文评测集上取得优于纯英文数据配比的效果。

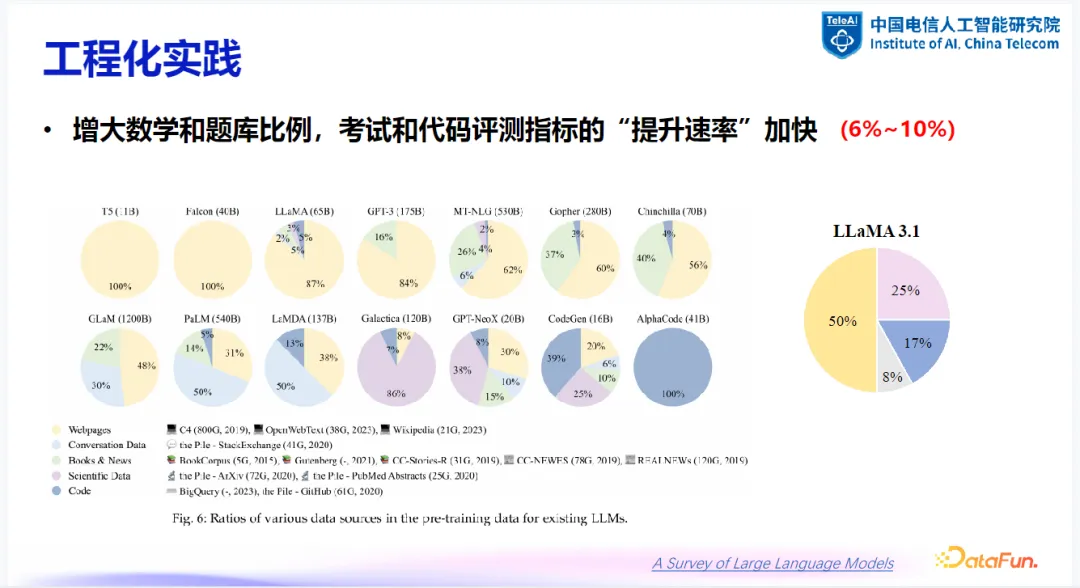

- 数学与题库数据的重要性:增大数学与题库数据的比例有助于提高考试与代码评测指标的提升速率。例如,最新的 LLaMA3 模型中,数学占比达到 25%,代码占比达到 17%,这表明在训练数据中加入更多数学和编程内容有助于提高模型在这些领域的表现。

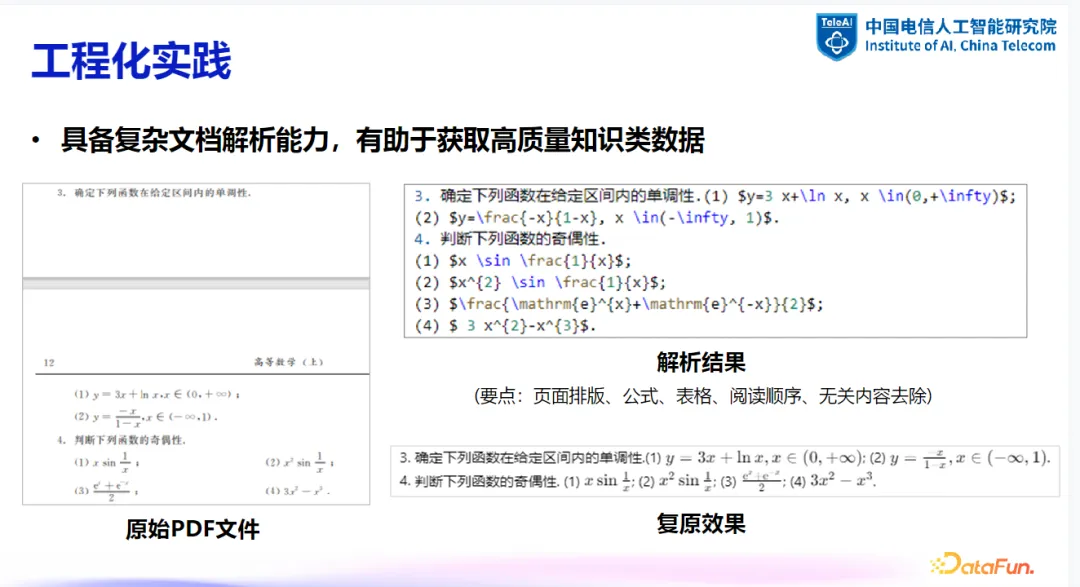

- 数据处理与解析:在公众化实验中,处理特定类型的数据(如数学题目)时,需要专门的文档解析技术或多模态大模型来提取文本内容。例如,从 PDF 文件中提取公式和表格,需要使用能够处理这些元素的解析器。

三、后训练数据的质量筛选

在大模型的训练过程中,后训练数据的选择和筛选对于模型性能的提升至关重要。随着训练数据从单纯追求数量转向重视质量,如何高效筛选出高质量的数据成为了一个关键议题。

1. 发展趋势

后训练数据筛选的发展趋势表现为从追求数据量的增加转向关注数据质量的提升。这意味着不仅要保证数据的多样性,还要确保数据的质量,使模型能够在有限的数据集上达到最佳训练效果。

2. 数据筛选方法

为了实现这一目标,研究者们提出了多种数据筛选方法,旨在从海量数据中挑选出最具价值的部分。

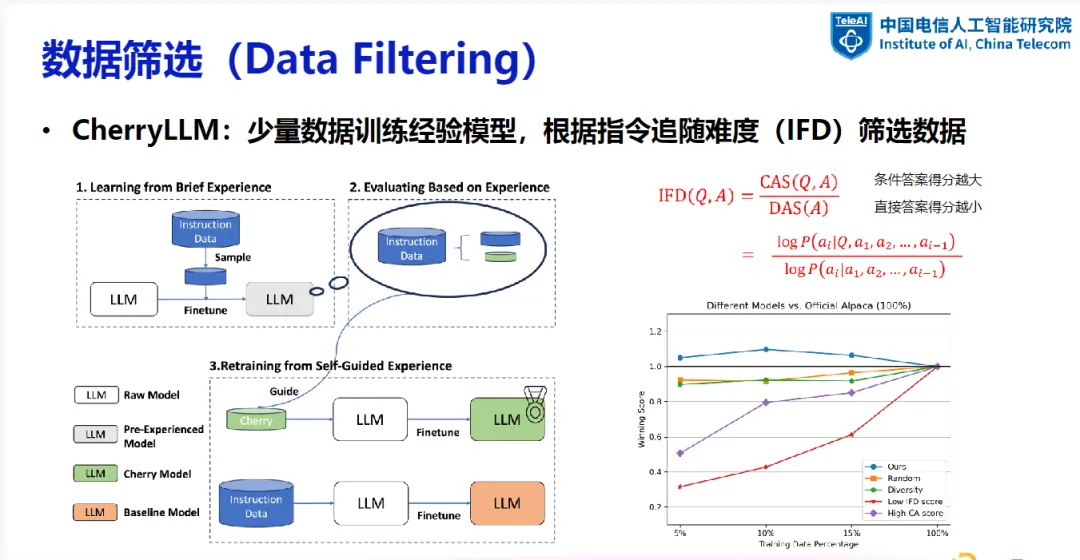

(1)CherryLLM

- 基本思想:通过少量数据训练出一个初步模型,利用该模型评估数据的指令追随难度,以此作为筛选依据。(指令追随难度用于衡量答案与指令的匹配程度,包括直接答案得分和条件答案得分)

- 筛选流程:从全量数据中选取样例训练经验模型;利用该模型筛选出指令追随难度高的数据进行后续训练。

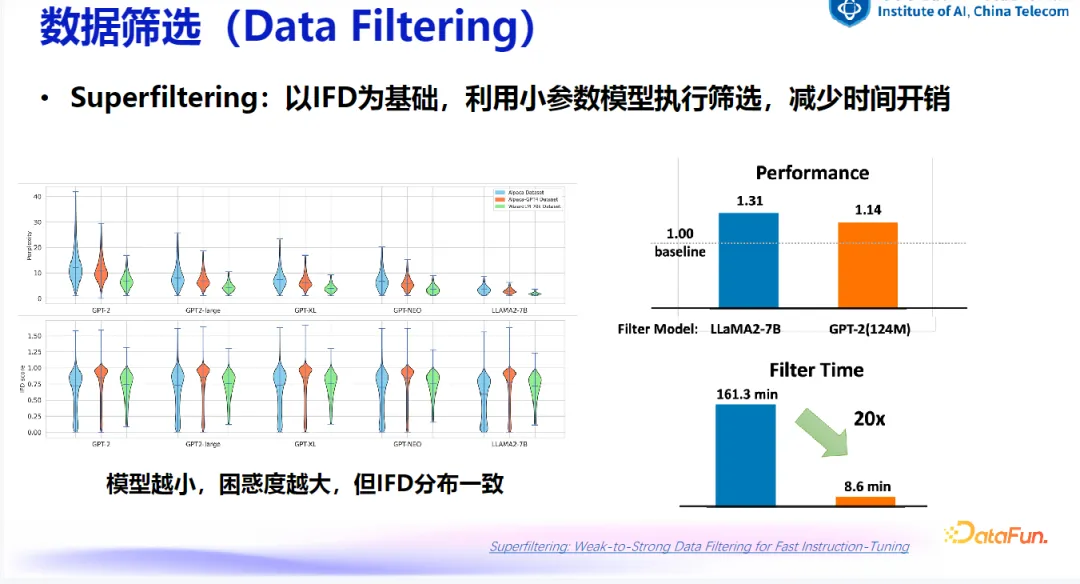

(2)Superfiltering

- 基本思想:利用较小的模型进行筛选减少时间开销,尽管其困惑度较高,但指令追随难度分布与大参数量模型结果类似,因此仍具有参考价值。

(3)MoDS

- 基本思想:利用奖励模型对数据进行评分,通过多层次筛选进一步提升数据质量。

- 流程:从高质量数据中选取种子样本训练初始模型,使用模型推理结果再次筛选并增强数据集。

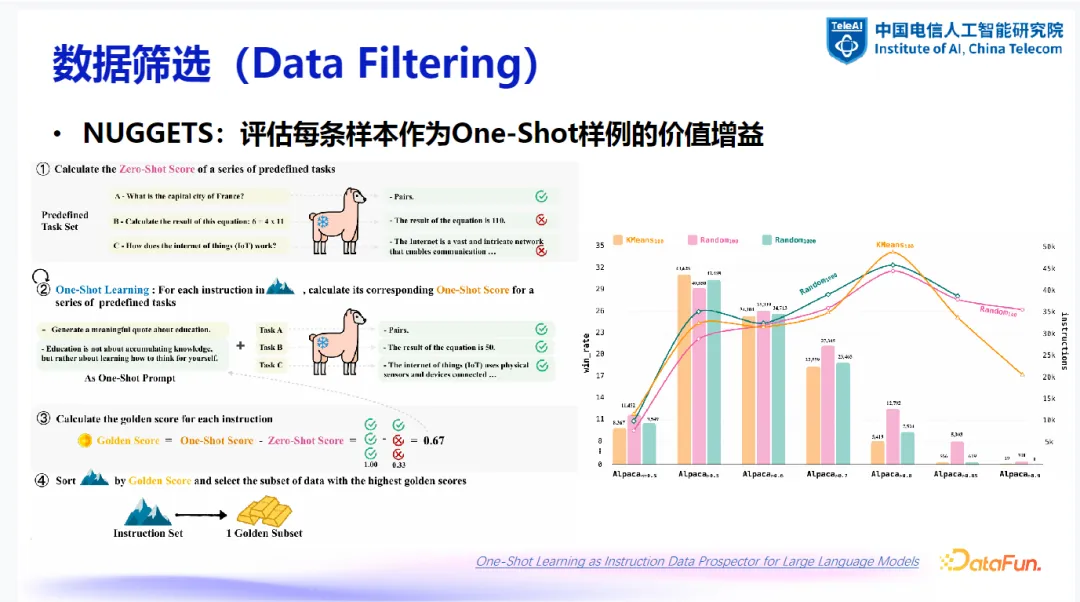

(4)NUGGETS

- 基本思想:评估每条样本作为 One-Shot 示例的价值增益。

- 优点:能够量化样本对训练过程的价值,并可通过聚类等手段进一步优化。

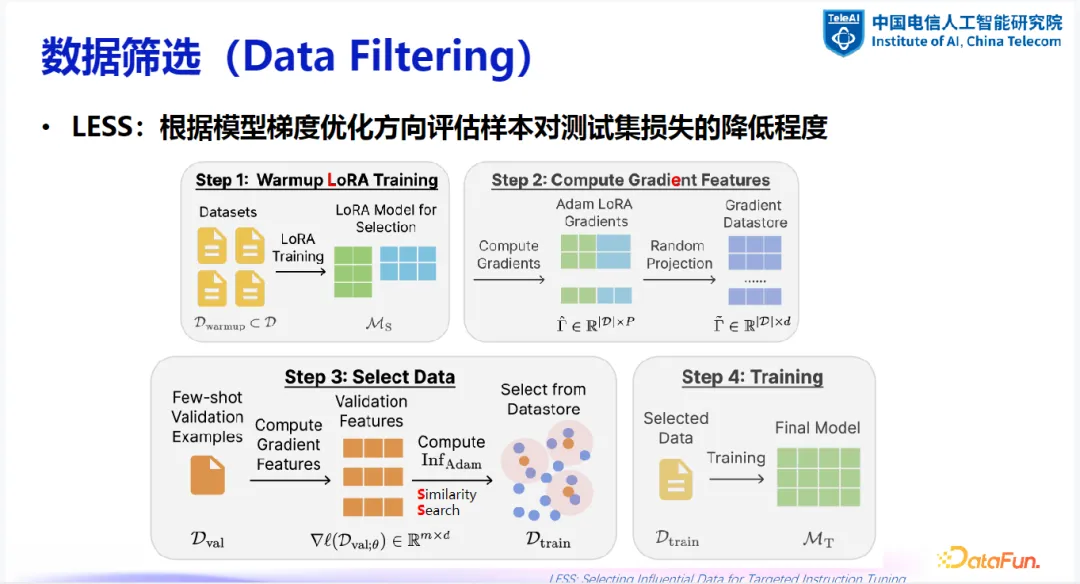

(5)LESS

- 基本思想:利用模型梯度评估样本对测试集损失降低的程度,从而筛选出最有价值的数据。

- 方法:

- 使用 LoRA 训练并保存样本梯度。

- 从训练数据中挑选出与示例数据集样本梯度相似度最高的部分。

3. 现有方法分类与特点

在后训练数据筛选的过程中,可以将方法大致分为两大类:模型类方法与指标类方法。

- 模型类方法:依赖外部模型能力,计算开销大。

- 指标类方法:计算效率高,潜在误差大。

4. 理想指标的探索

在现有筛选方法的基础上,探索更为理想的筛选指标。理想指标应当具备以下特性:

- 精确性与确定性:既能准确匹配答案,又能反映模型对生成内容的不确定程度。

- 动态变化:随着模型训练的深入,符合条件的数据量逐渐减少。

5. 工程化实践

在实际应用中,后训练数据筛选涉及多个层面的考量:

- 数据分类:将数据按逻辑、认知、理解等多个层次分类。

- 能力提升:针对单项能力进行优化,随后进行跨类别的综合优化,以实现能力融合。

- 迭代优化:通过多轮迭代优化数据配比,逐步提升模型的整体性能。

6. 数学数据的重要性

使用少量数学相关的微调数据,可以促进模型在多项通用任务上获得全面的能力提升。

四、问答环节

Q1:是否存在数据量维度的 scaling law,即数据量越大,模型效果越好?

A1:在数据量和模型效果之间存在类似于模型参数量维度的 scaling law。但关键在于数据质量,高质量的数据是提升模型效果的基础。对于不同级别的模型,所需的高质量数据量可能存在底线,这一底线需要通过实验来探索。特别是对于大型模型,由于训练成本高昂,难以重复多次实验,因此在实际操作中需通过追随训练等方法逐步优化。

Q2:数学数据的来源主要是什么?

A2:数学数据主要来源于各类题库。市面上这类数据库存有限,建议可通过小模型从网页数据中提取数学知识相关内容进行扩充。

Q3:不同领域的数据进入模型训练的顺序是否影响模型效果?

A3:数据进入模型训练的顺序确实有影响,但实际操作中难以全面评估所有可能的顺序。可以通过领域细分和实验来探究这一影响,但需要大量算力支持。

Q4:先导模型与主模型在结构上需要怎样的关联?

A4:先导模型与主模型在结构上可以有所差异,但需要先导模型能够有效地反映数据质量。目前尚无明确理论指导先导模型的选择,但通常会选择在较小参数量下训练效果较好的模型作为先导模型。

Q5:PDF 文件处理有哪些难点?在选择或开发 PDF 处理工具时应注意什么?

A5:PDF 文件处理的难点在于需要同时处理公式、表格和不同版面等复杂元素。有效的 PDF 处理工具应具备多种专用模型,如版面解析、表格处理和公式识别模型。特别需要注意的是,工具应擅长处理公式与文本混排的情况。