集成学习算法(Ensemble Methods)是一类通过组合多个单一模型(弱模型)来构建一个更强模型的机器学习方法。

其核心思想是,单个模型的预测可能存在偏差或方差,难以表现出最佳效果,但通过集成多个模型,能够综合各自的优点,减少预测误差,提升模型的鲁棒性和准确性。

集成学习算法在分类、回归等任务中表现出色,特别是在复杂问题中能够提供更高的准确性和稳健性。

集成学习算法的原理基于以下几点:

- 减少偏差:通过组合多个模型的预测结果,可以减小单个模型的偏差。

- 减少方差:通过集成模型,可以减少由于数据波动引起的预测不稳定性。

- 避免过拟合:多个模型的组合可以降低单一模型过拟合的风险。

集成学习算法的主要类型

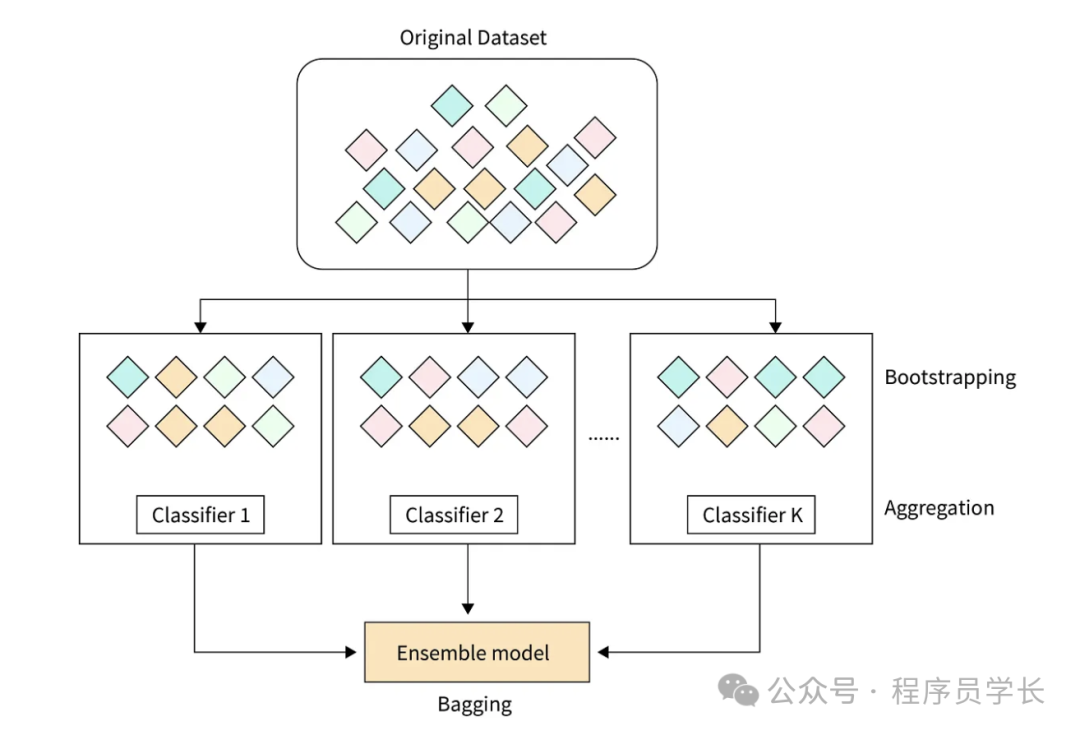

1.Bagging(Bootstrap Aggregating)

Bagging 是一种通过在数据集上进行采样来构建多个不同的模型的方法。

具体步骤为:

- 从原始数据集中进行有放回采样,生成多个不同的数据子集。

- 在每个子集上训练一个独立的模型(通常是同一类型的模型,如决策树)。

- 对每个模型的预测结果进行平均(回归任务)或投票表决(分类任务)。

优点

Bagging 减少了模型的方差,尤其在高方差模型(如决策树)中表现非常好。

典型代表算法

随机森林(Random Forest)。

图片

图片

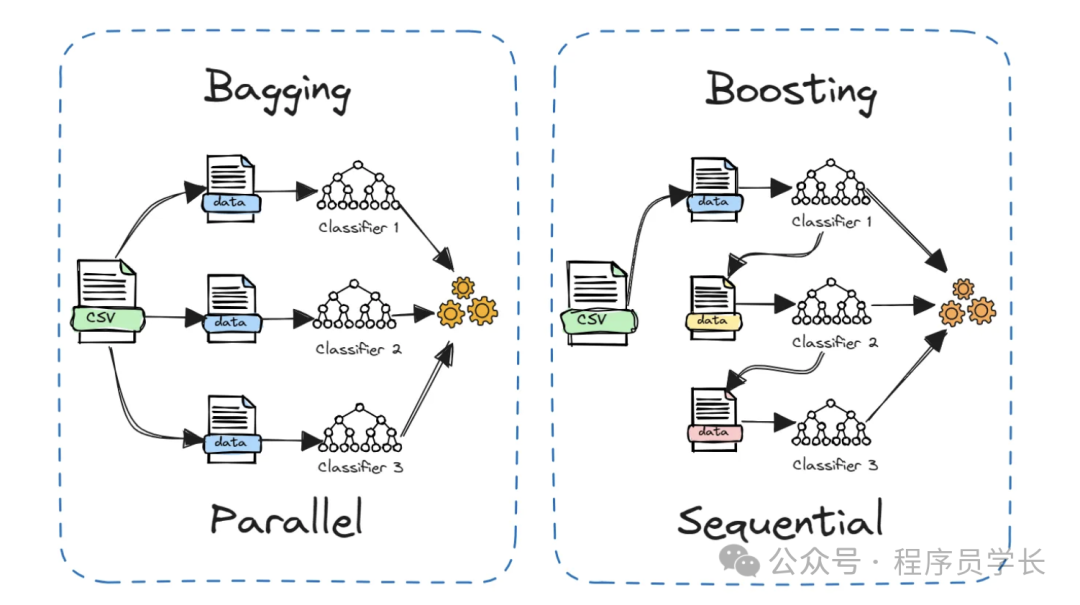

2.Boosting

Boosting 是一种通过逐步修正模型误差来构建强模型的技术。

与 Bagging 不同,Boosting 的每个模型是逐步训练的,每个新模型都试图修正前一个模型的错误。

常见的 Boosting 算法包括:

- AdaBoost,逐步增加弱分类器的权重,强调那些之前分类错误的样本。每个模型在样本上的错误越大,样本的权重越高。

- Gradient Boosting,使用梯度下降算法逐步优化损失函数,每个新模型试图修正前一个模型的残差。

优点

Boosting 通过迭代训练来逐步减少偏差,通常在低偏差模型(如线性模型)上表现优秀。

典型代表算法

AdaBoost、XGBoost、LightGBM

图片

图片

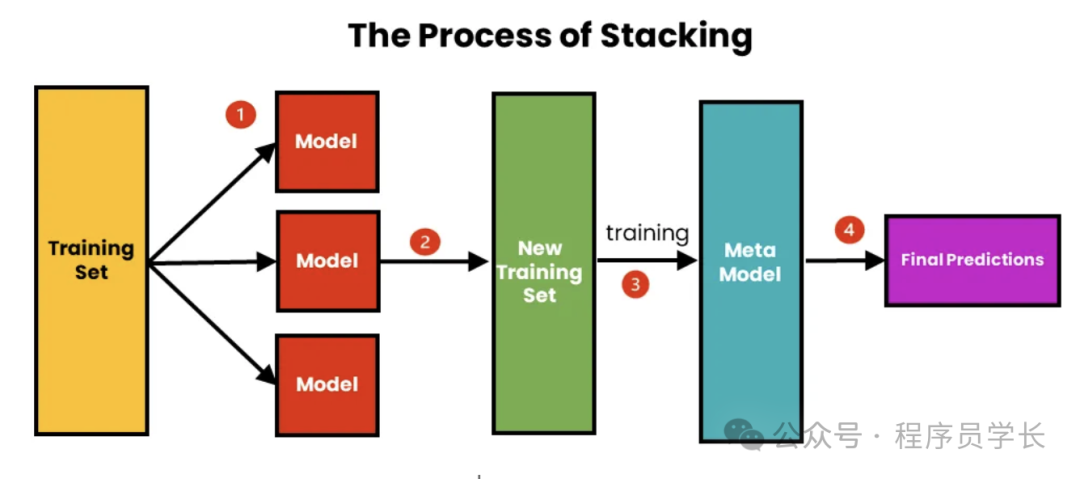

3.Stacking

Stacking 是一种更为复杂的集成方法,它通过组合多个模型的输出作为输入来训练一个更高层次的模型。

具体步骤如下:

- 不同类型的模型(基模型)首先对同一数据集进行训练。

- 将所有基模型的预测结果组合起来,作为第二层模型(元学习器)的输入。

- 元学习器根据基模型的输出进行预测,从而进一步提升整体的性能。

优点

Stacking 能够综合利用不同类型模型的优点,通常表现比单一集成方法更好。

示例代码

以下是一个使用随机森林、AdaBoost 和 Stacking 的 Python 示例代码。

# 导入必要的库

from sklearn.datasets import load_breast_cancer

from sklearn.model_selection import train_test_split

from sklearn.ensemble import RandomForestClassifier, AdaBoostClassifier, StackingClassifier

from sklearn.linear_model import LogisticRegression

from sklearn.svm import SVC

from sklearn.metrics import accuracy_score

# 加载数据集

data = load_breast_cancer()

X, y = data.data, data.target

# 将数据集划分为训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

# 随机森林模型

rf_model = RandomForestClassifier(n_estimators=100, random_state=42)

# AdaBoost模型

ada_model = AdaBoostClassifier(n_estimators=100, random_state=42)

# 定义Stacking分类器

stacking_model = StackingClassifier(

estimators=[('rf', rf_model), ('ada', ada_model)],

final_estimator=LogisticRegression()

)

# 训练Stacking模型

stacking_model.fit(X_train, y_train)

# 预测并计算测试集上的准确率

y_pred = stacking_model.predict(X_test)

accuracy = accuracy_score(y_test, y_pred)

print(f'Stacking模型的准确率: {accuracy:.4f}')