近年来,大模型在人工智能领域掀起了一场革命,各种文本、图像、多模态大模型层出不穷,已经深深地改变了人们的工作和生活方式。另一方面,在国际半导体大会上,英伟达创始人黄仁勋表示,人工智能下一个浪潮将是 “具身智能”,即能理解、推理、并与物理世界互动的智能系统。近年来,国内外商业巨头也纷纷推出自己的具身机器人发展计划。大模型和具身智能,无疑是当前人工智能领域最闪耀的双子星。在光电感知技术、机器人技术、大模型技术的快速发展下,大模型驱动的具身智能,不仅有望极大提升机器人的智能水平,更将推动人工智能技术迈向物理世界,从而产生更加广泛的应用。

在此背景下,中国电信 CTO、首席科学家李学龙教授牵头组建中国电信人工智能研究院 (TeleAI), 并将大模型和具身智能作为重要的研究方向。近期,由 TeleAI 研究科学家白辰甲、清华大学助理教授许华哲、TeleAI 院长李学龙教授共同撰写的中文综述《大模型驱动的具身智能:发展与挑战》一文在《中国科学:信息科学》发表,综述通过对 300 篇相关文献的分类和解读,深度剖析大模型驱动的具身智能的基本概念、技术框架、现有挑战和未来展望,梳理这一热点问题背后的研究脉络和技术体系,进一步推动具身智能领域的发展,助力国家人工智能发展战略。

- 论文地址:https://www.sciengine.com/SSI/doi/10.1360/SSI-2024-0076

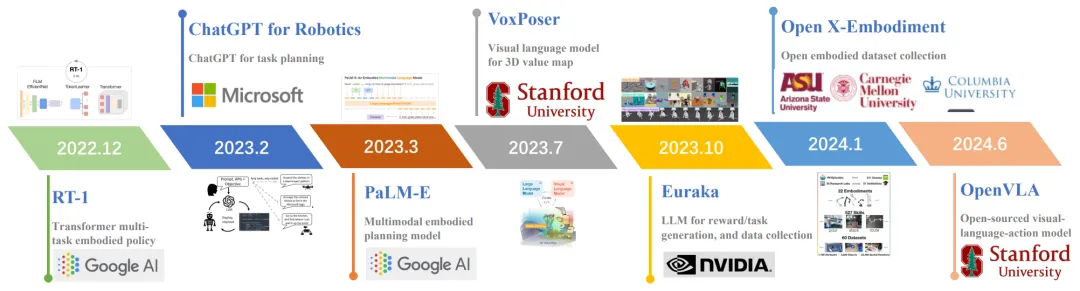

具身智能是人工智能、机器人学、认知科学的交叉领域,主要研究如何使机器人具备类似人类的感知、规划、决策和行为能力。具身智能强调感知 - 运动回路,使用物理实体来感知环境,根据任务目标进行规划和决策,使用运动操作能力来完成任务。大模型具有对物理世界的丰富知识,能够为智能体提供自然语言交互、环境感知和任务规划的能力,同时能够和具身智能的传统框架相结合,提升智能体策略学习的泛化性。图 1 展示了该领域的典型进展。

图 1 领域典型进展

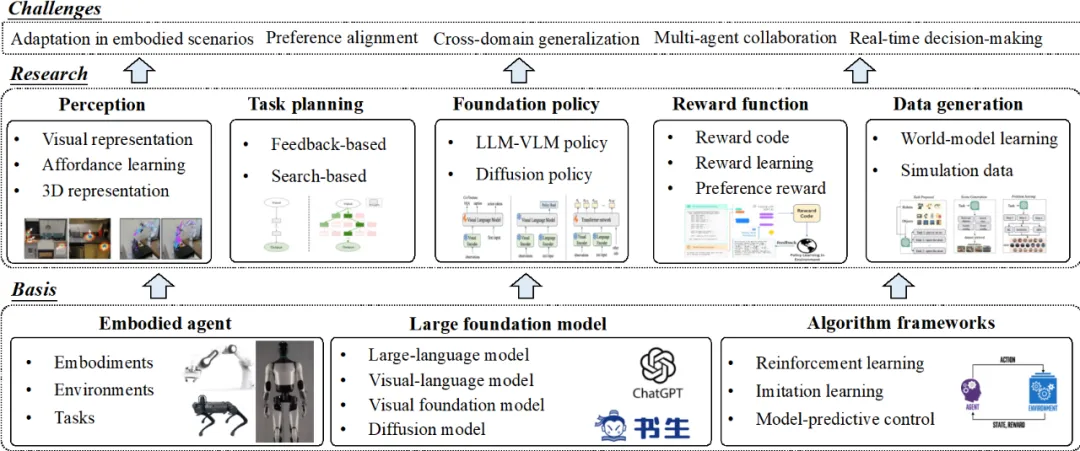

综述首先介绍相关技术背景,包括具身智能的基本概念,大模型相关技术,以及强化学习、模仿学习、模型预测控制等策略学习框架。随后,从学习范式的角度将大模型驱动的具身智能算法概括了五大类并依次进行了详细阐述,分别是大模型驱动的环境感知、大模型驱动的任务规划、大模型驱动的基础策略、大模型驱动的奖励函数、大模型驱动的数据生成。图 2 展示了综述的整体框架。

图 2 综述整体框架

大模型驱动的具身环境感知

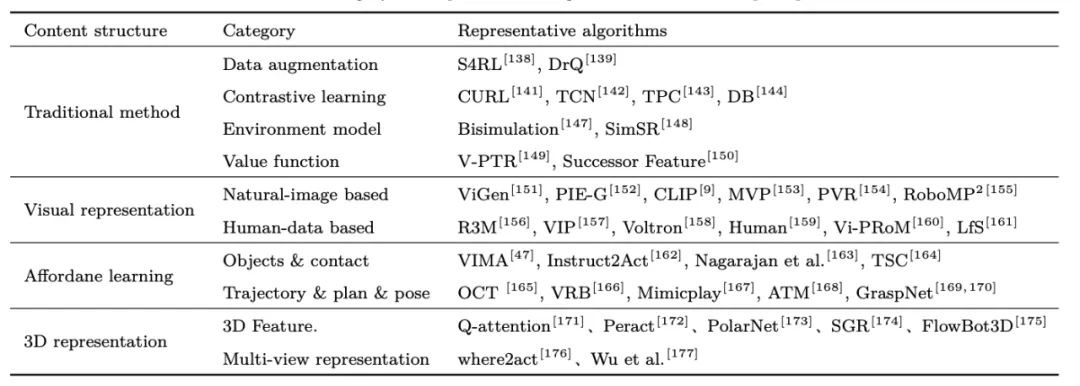

在具身智能任务中,智能光电设备可以为具身智能体提供周围环境的视觉信号,随后大模型感知技术为具身决策提供基础。1)相比于传统的特征提取方法,视觉大模型具有较好的泛化性,许多研究通过引入视觉预训练模型来提高策略的视觉泛化能力和鲁棒性。2)机器人 Affordance 是一种对操作任务更具有解释性的通用特性,通过预训练 Affordance 模型能够为具身操作提供更详细的指导,例如物体的交互位置 (如门把手,茶壶手柄等),物体的交互轨迹 (如向内推、向上提等),如图 3 所示。3)复杂任务需要获取操作物体的 3D 场景特征,许多方法设计从点云和多视角图像中提取目标位置、方向、遮挡、物体之间的堆叠关系等。该领域典型方法如表 1 所示。

图 3 典型的 Affordance 提取方式

表 1 大模型驱动的具身感知算法总结

大模型驱动的具身任务规划

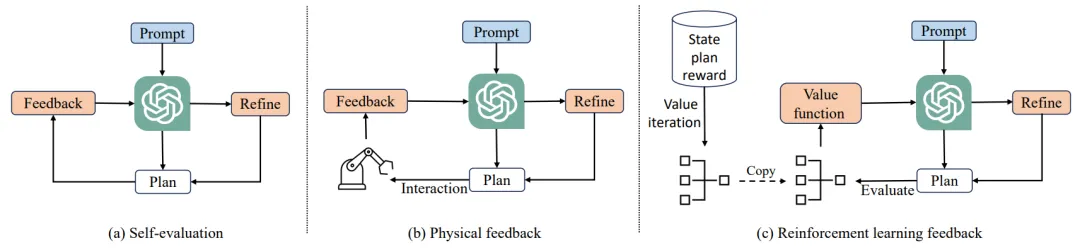

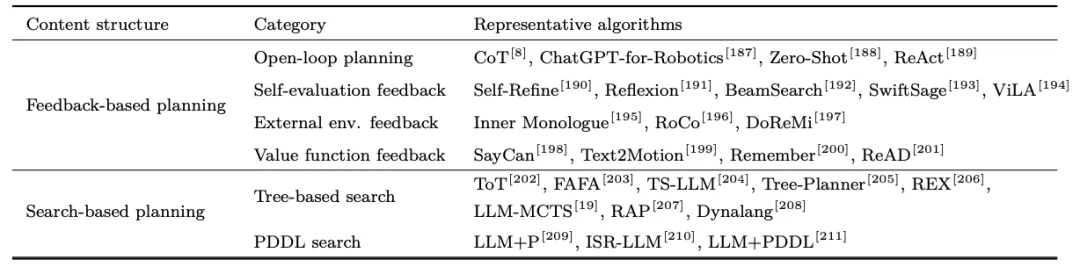

在大规模语言数据中训练得到的大模型对现实世界有着丰富的先验知识,可以用来作为具身智能任务的规划器。然而,大模型的知识与具身环境存在不匹配的现象,可能会导致大模型的规划无法执行。1)现有研究通过构建闭环反馈的方法来解决开环规划中存在的问题,包括大模型自我反馈、外部环境反馈、强化学习反馈等,对大模型等规划进行纠错,如图 4 所示。2)通过规划搜索算法能够提升大模型在长周期任务规划中的最优性,这一领域包含蒙特卡洛树搜索、世界模型、规划领域定义语言搜索等。该领域典型方法如表 2 所示。

图 4 大模型规划等闭环反馈方法

表 2 大模型驱动的具身规划算法总结

大模型驱动的具身基础策略

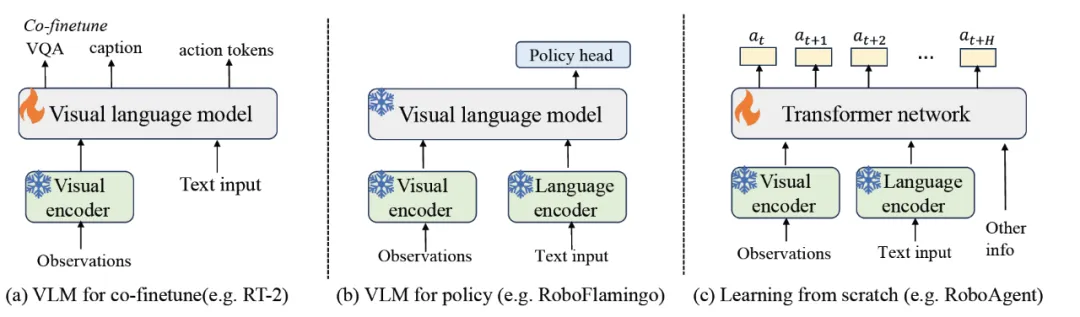

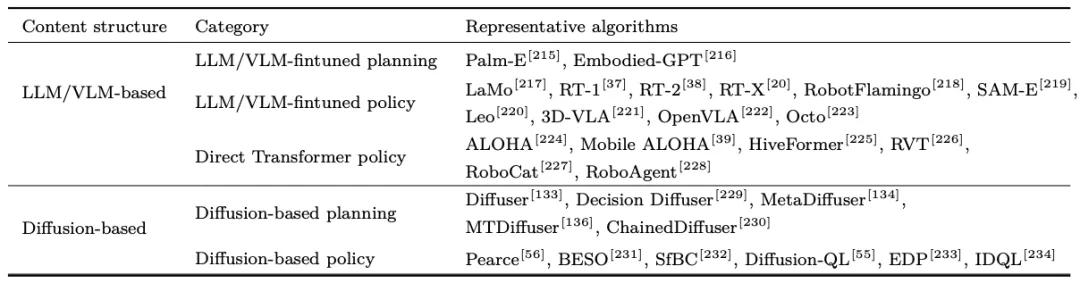

大模型任务规划依赖于能够执行规划对底层技能库。为了减轻底层技能库定义的依赖,提升决策效率,1)许多研究考虑将大模型参数作为具身基础策略,并利用具身数据对大模型参数进行微调,使大模型能够更加适应于具身决策场景。基础策略可以输出更具体的任务规划,也可以直接输出机器人需要执行的动作,如图 5 所示。2)扩散模型由于对长序列数据建模中的强大能力,许多研究将其用于建模专家轨迹的多样化数据分布,从而用于长序列任务的轨迹规划或动作规划,或作为具身策略结合强化学习算法进行策略优化。

图 5 大模型驱动的具身策略微调

表 3 大模型具身基础策略算法总结

大模型驱动的具身奖励函数

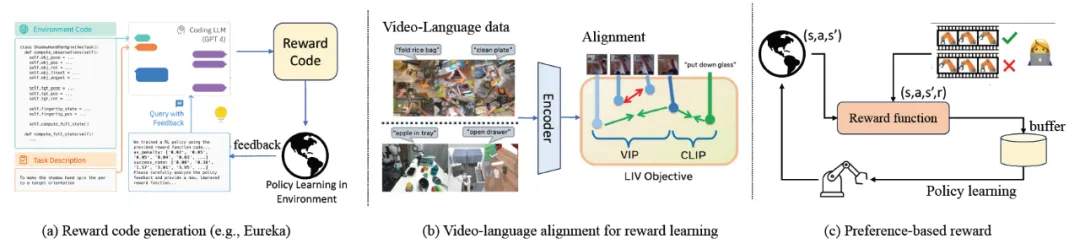

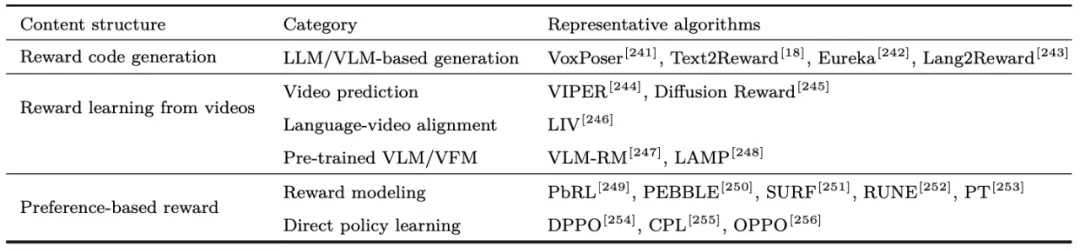

在基于强化学习和模型规划控制的具身算法中,最优策略通过优化奖励函数产生。传统方法中奖励函数由机器人领域专家设计,具有一定的设计难度。1)大模型对机器人和任务具有丰富的先验知识,许多研究提出使用大语言模型 / 视觉语言模型进行奖励图或奖励函数的生成,随后通过策略优化和环境反馈进行优化。2)其他研究学习通过从状态视频预测、描述 - 轨迹匹配程度、轨迹相似性等方面学习参数化的奖励模型。3)受大模型偏好学习等启发,许多研究通过人类反馈对轨迹偏好进行打分,使用人类反馈强化学习(RLHF)算法进行奖励模型等训练。典型框架如图 6 和表 4 所示。

图 6 大模型驱动的奖励函数框架

表 4 大模型驱动的具身奖励函数算法总结

大模型驱动的具身数据生成

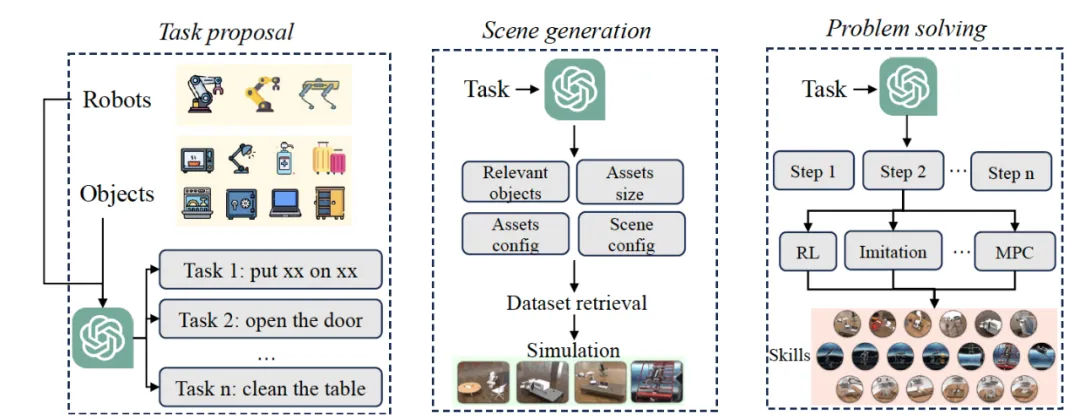

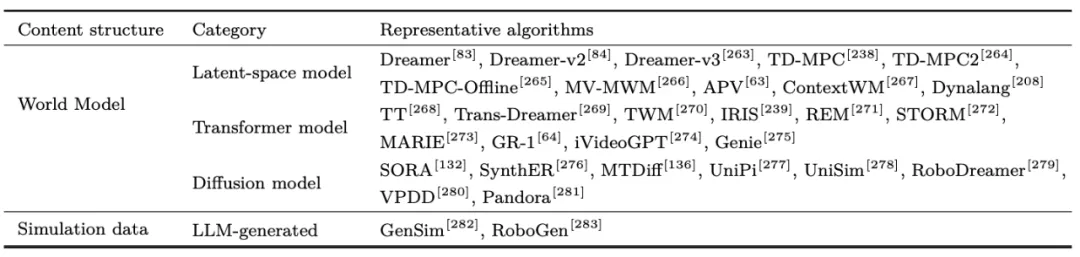

大模型进行具身数据生成有望解决机器人数据稀缺的难题。1)世界模型(World Model)揭示了物理世界的运行规律,包括未来视觉观测如何改变,状态如何根据环境动力学进行转移,以及智能体最终达到的状态等。构建世界模型能够快速产生大量轨迹来丰富强化学习或模仿学习的数据,基本框架包含隐空间世界模型、Transformer 世界模型、扩散世界模型等。2)大模型能够借助仿真环境进行自动化的环境生成和数据采集,主要流程包括大模型自动任务提出、自动环境构造、自动任务解决、自动数据采集、自动技能学习等,快速产生针对特定任务的仿真数据,进行机器人技能和策略的学习,如图 7 所示。该领域典型方法如表 5 所示。

图 7 大模型驱动的仿真环境和数据生成框架

表 5 大模型驱动的具身数据生成算法总结

大模型驱动的具身智能已具备了研究和技术体系的雏形,有望使 “数字” 大模型在 “实体” 机器人中生根发芽。综述随后分析了现有研究之间存在的联系,并总结了目前大模型驱动的具身智能领域面临的挑战,包括大模型在特定具身场景中的适应问题、大模型策略和人类偏好的对齐问题、具身策略的跨域泛化问题、大模型驱动多智能体协作问题、具身智能在真实环境中所面临的挑战和大模型具身策略的决策实时性问题等。

虽然目前关于采取何种路线能够达到通用具身智能仍很难定论,但大模型的成功切实的推动了具身智能的发展。综述对该领域的未来研究进行了展望,包括统一具身数据平台、通用具身数据表征、鲁棒具身控制策略、可控具身策略生成、人机合作具身智能、异构智能体协同、轻量化具身策略和人形机器人等方面。