- 论文链接:https://arxiv.org/pdf/2408.13454

- 代码链接:https://github.com/ai4ce/Bosch-NYU-OccupancyNet/

摘要

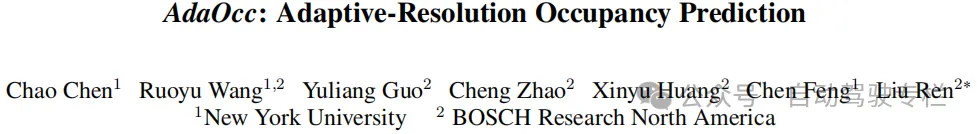

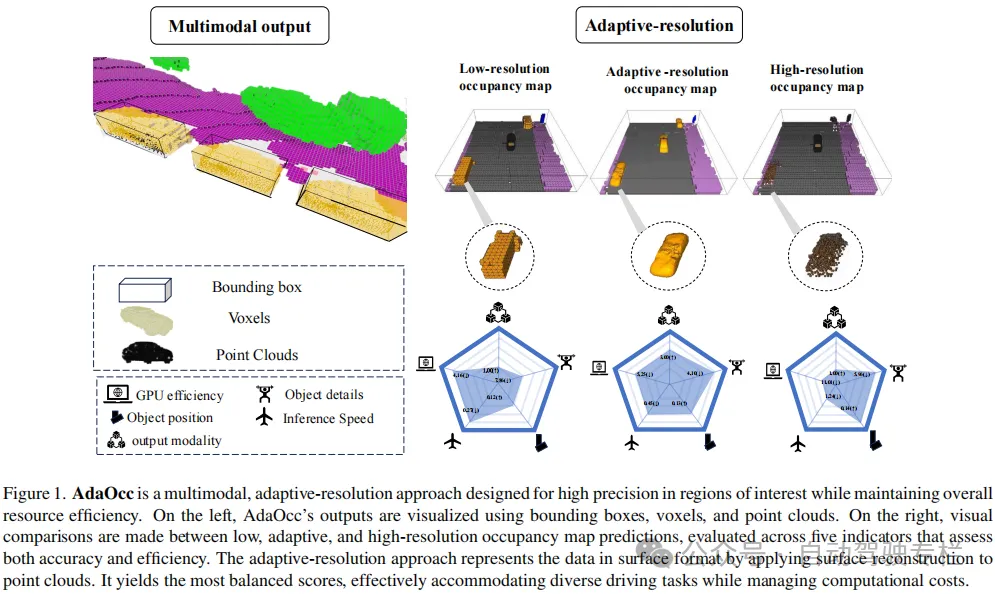

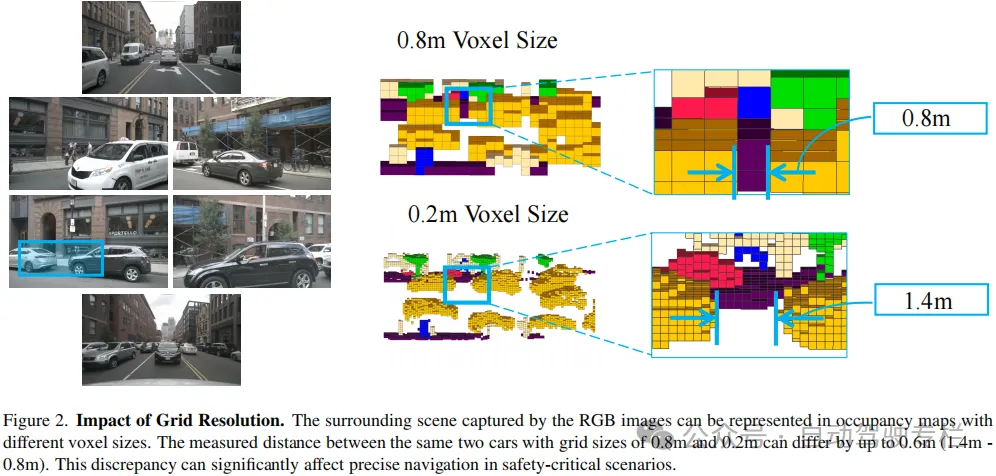

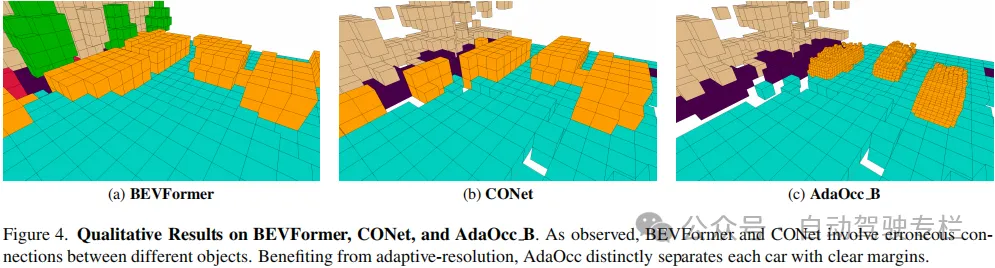

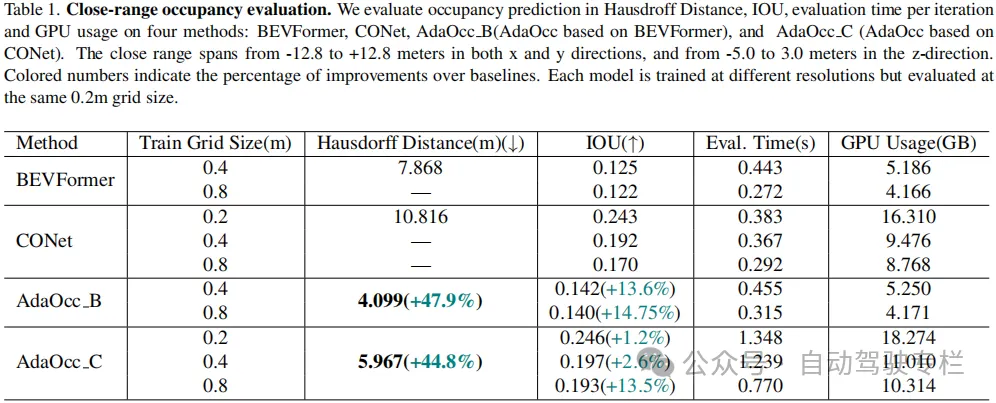

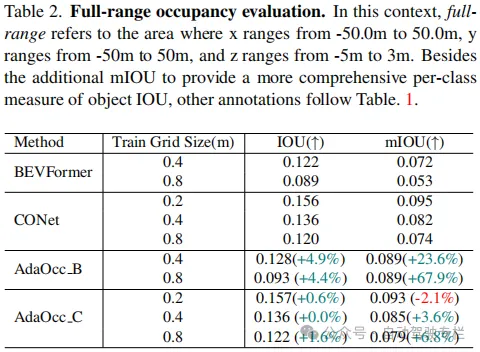

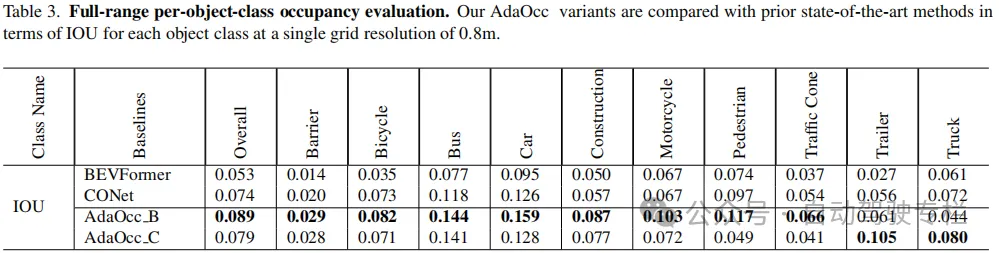

本文介绍了AdaOcc:自适应分辨率占用预测。在复杂的城市场景中实现自动驾驶需要3D感知既全面又精确。传统的3D感知方法着重于目标检测,导致缺乏环境细节信息的稀疏表示。最近的方法估计车辆周围的3D占用,以获得更全面的场景表示。然而,稠密的3D占用预测提高了计算需求,给效率和分辨率之间的平衡带来挑战。高分辨率占用栅格提供了准确性,但是需要大量的计算资源,而低分辨率栅格效率高,但是缺乏细节信息。为了解决这一难题,本文引入了AdaOcc,这是一种新的自适应分辨率、多模态的预测方法。本文方法将以目标为中心的3D重建和整体占用预测集成到一个框架内,仅在感兴趣区域(ROIs)内进行高度精细且精确的3D重建。这些高度精细的3D表面以点云表示,因此其精度不受占用地图的预定义栅格分辨率所限制。本文在nuScenes数据集上进行全面实验,证明了相比于现有方法具有显著改进。在近距离场景中,本文方法在IOU上超过先前的基线13%,在Hausdorff距离上超过了40%。总之,AdaOcc提供了更通用、更有效的框架,能够在各种驾驶场景中提供准确的3D语义占用预测。

主要贡献

本文的贡献总结如下:

1)本文提出了一种多模态自适应分辨率方法,在关键区域中提供了三种高精度的输出表示,同时维持实时应用的效率;

2)本文开发了一种有效的联合训练范式,可以增强占用预测和目标折叠分支之间的协同作用;

3)本文方法在nuScenes数据集上展现出卓越的精度,特别是在需要精确行为的近距离场景中表现出色。

论文图片和表格

总结

总之,本文所提出的方法提供了一种多模态自适应分辨率方法,在关键区域中提供了三种具有高精度表面的输出表示,同时确保了实时应用的效率。此外,本文还开发了一种有效的联合训练范式,以增强占用和折叠网络之间的协同作用,从而提高近距离占用预测的性能。本文方法在nuScenes数据集上展现出卓越的精度,突出了对精细表面重建的注重。

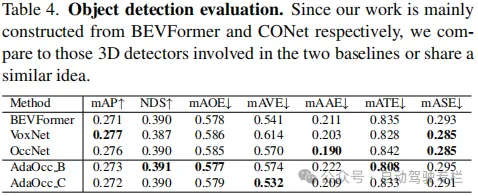

局限性:本文发现,联合训练方法没有显著提高目标检测任务的质量。需要进一步研究粗略占用预测和目标表面重建之间的相互作用,以提高不同表示之间的一致性。此外,通过更高级的并行化设计,能够进一步优化统一框架的效率。