本文转载自旺知识,作者旺知识

对大型语言模型(LLMs)的兴趣正在上升,特别是在2022年11月ChatGPT发布之后(见图1)。近年来,LLMs已经转变了各个行业,生成类似人类的文本并解决广泛的应用。然而,它们的效果受到偏见、不准确和毒性问题的阻碍,这限制了它们更广泛的采用并引发了道德担忧。

图1. 过去一年大型语言模型的谷歌搜索趋势。来源:谷歌趋势

图1. 过去一年大型语言模型的谷歌搜索趋势。来源:谷歌趋势

本文通过深入探讨有前景的方法,如自我训练、事实检查和稀疏专业知识,来解决这些问题并释放这些模型的全部潜力,从而探索大型语言模型的未来。

1 - 大语言模型简介

大型语言模型是一种旨在通过分析大量数据生成和理解类似人类文本的人工智能模型。这些基础模型基于深度学习技术,通常涉及许多层和大量参数的神经网络,使它们能够捕捉到它们训练的数据中的复杂模式。

大型语言模型的主要目标是理解自然语言的结构、语法、语义和上下文,以便它能够生成连贯且上下文适当的响应或用相关信息完成给定的文本输入。

这些模型在包括书籍、文章、网站和其他文本内容在内的多样化文本数据源上进行训练,这使它们能够对广泛的主题生成响应。

2 - 大语言模型当前发展进展和问题

大型语言模型的当前阶段以其在理解和生成广泛主题和应用的类似人类文本方面的令人印象深刻的能力为标志。这些模型使用先进的深度学习技术构建,并在大量数据上进行训练,例如OpenAI的GPT-3和谷歌的BERT,已显著影响自然语言处理领域。

当前的LLMs在各种任务上实现了最先进的性能,如:

- 情感分析

- 文本摘要

- 翻译

- 问答

- 代码生成

尽管取得了这些成就,语言模型仍然存在各种需要在未来模型中解决和修复的限制。

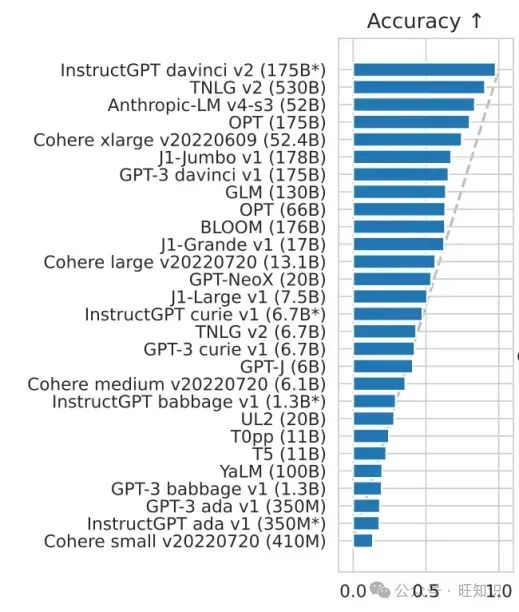

2.1 - 准确性

大型语言模型使用机器学习来推断信息,这引发了关于潜在不准确性的担忧。此外,预训练的大型语言模型难以动态适应新信息,导致可能的错误响应,这需要在未来的发展中进一步审查和改进。图3显示了一些LLMs在准确性方面的比较。

图片

图片

图3. 在5次HELM基准测试中各种语言模型的结果,用于准确性。来源:“BLOOM: A 176B-Parameter Open-Access Multilingual Language Model”

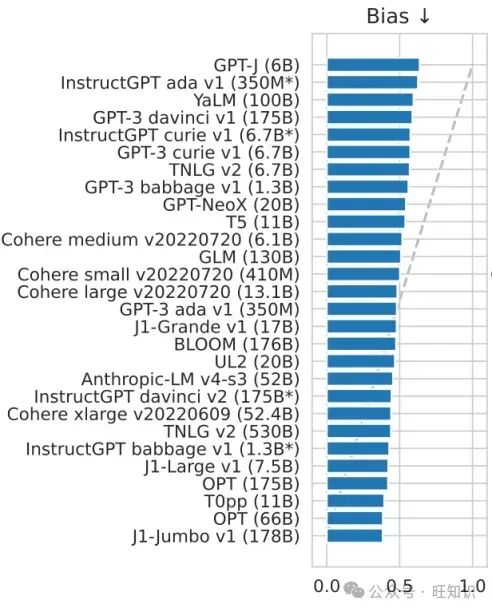

2.2 - 偏见

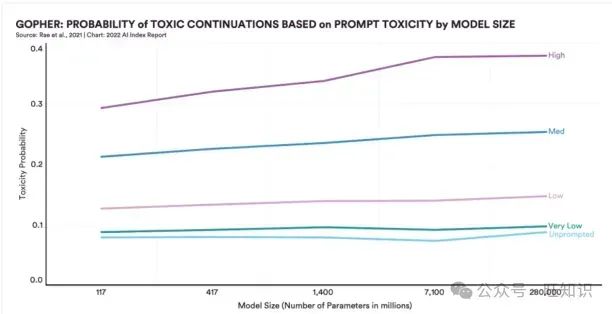

大型语言模型通过语音和文本促进类似人类的交流。然而,最近的发现表明,更先进和庞大的系统倾向于吸收其训练数据中存在的社会偏见,导致在线社区中出现性别歧视、种族歧视或能力歧视的倾向(图4)。

图4. 大型语言模型的毒性指数。来源:斯坦福大学人工智能指数报告2022

图4. 大型语言模型的毒性指数。来源:斯坦福大学人工智能指数报告2022

例如,最近的一个2800亿参数模型与2018年的1.17亿参数模型相比,毒性水平显著增加了29%。随着这些系统的不断发展,成为AI研究和开发的更强大的工具,偏见风险的潜在增加也在增长。图5比较了一些LLMs的偏见潜力。

图片

图片

图5. 在5次HELM基准测试中各种语言模型的结果,用于偏见。来源:“BLOOM: A 176B-Parameter Open-Access Multilingual Language Model”

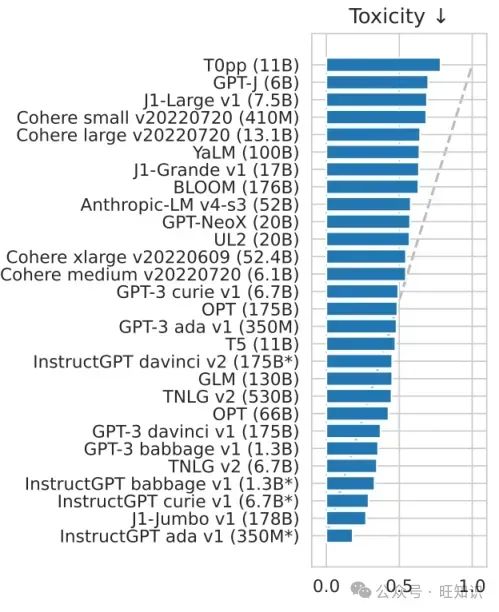

2.3 - 毒性

大型语言模型的毒性问题指的是这些模型在响应中无意中生成有害、冒犯性或不适当的内容的问题。这个问题的出现是因为这些模型是在包含偏见、冒犯性语言或有争议观点的大量文本数据上训练的。

图片

图片

图6. 在5次HELM基准测试中各种语言模型的结果,用于毒性.来源:“BLOOM: A 176B-Parameter Open-Access Multilingual Language Model”

解决未来大型语言模型中的毒性问题需要多方面的方法,包括研究、合作和持续改进。一些可能的策略来减轻未来模型中的毒性可以包括:

- 策划和改进训练数据

- 开发更好的微调技术

- 纳入用户反馈

- 内容审核策略

2.4 - 容量限制

每个大型语言模型都有一个特定的内存容量,这限制了它作为输入可以处理的令牌数量。例如,ChatGPT有一个2048令牌限制(大约1500个单词),阻止它理解和为超过这个令牌阈值的输入生成输出。

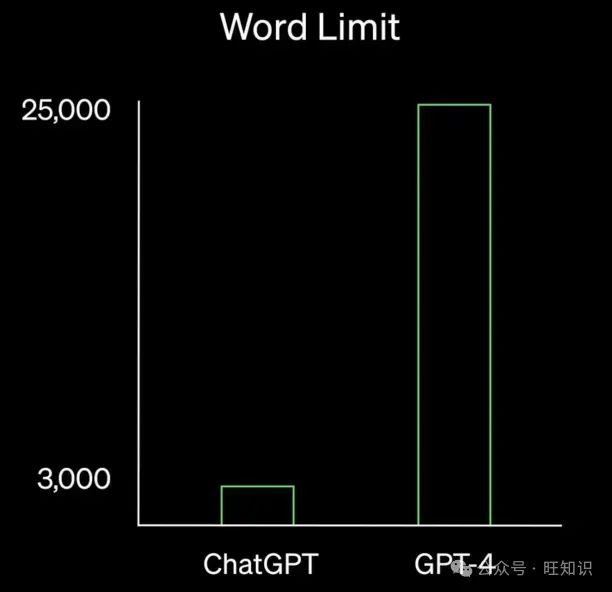

GPT-4将容量扩展到25000字,远远超过了依赖GPT-3.5的ChatGPT模型(图7)。

图7. ChatGPT和GPT-4之间的字数限制比较.来源:OpenAI

图7. ChatGPT和GPT-4之间的字数限制比较.来源:OpenAI

2.5 - 预训练知识集

语言模型是在固定数据集上训练的,这些数据集代表了某个时间点的知识快照。一旦训练完成,模型的知识就被冻结,无法访问最新的信息。这意味着在训练数据收集后发生的任何信息或变化都不会反映在大型语言模型的响应中。

这导致了几个问题,例如:

- 过时或错误的信息

- 无法处理最近的事件

- 在技术、金融或医学等动态领域中的相关性较低

3 - 大语言模型的未来发展趋势

不可能预见未来的语言模型将如何演变。然而,有关LLMs的有前景的研究,专注于我们上面解释的共同问题。我们为未来的语言模型指出几个重要的变化趋势。

3.1 - 多模态LLM

具有整合多种类型输入的能力,包括文本、照片和视频,多模态LLM是人工智能的重大进步。这些模型非常适合各种应用,因为它们能够理解和生成跨多种模态的材料。通过在各种数据集上进行大规模训练,多模态LLM被构建来执行更复杂和细致的任务,例如回答关于图像的问题或根据文本描述制作深入的视频材料。

例子 –

- OpenAI的Sora – 在人工智能方面,OpenAI的Sora在文本到视频生成方面取得了显著进展。该模型使用各种视频和图像数据,如不同的时长、分辨率和宽高比,来训练文本条件扩散模型。Sora通过处理视频和图像潜在代码的空间时间补丁,并使用先进的变换器架构,生成高达一分钟的高保真电影。

- Gemini – Google的Gemini多模态模型系列非常擅长理解和生成基于文本、音频、视频和图像的材料。Gemini有Ultra、Pro和Nano版本,可以处理从内存受限的设备使用案例到复杂的推理活动的各种应用。评估结果显示,Gemini Ultra模型在所有20个多模态基准测试中提高了最先进的水平,并在32个基准测试中的30个中达到了人类专家在MMLU测试基准上的表现,等等。

- LLaVA – LLaVA是一个先进的AI模型,它通过提高多模态学习能力,弥合了语言和视觉理解之间的差距。它非常适合需要对这两种格式都有深刻理解的应用,因为它可以通过将视觉数据整合到语言模型中,分析和生成结合文本和图像的内容。

3.2 - 开源LLM

作为开源软件提供的LLM已经通过使全球社区能够访问复杂的模型及其背后的训练过程,民主化了AI研究。此外,这种透明度确保了AI研究中的可复制性,除了促进合作和加速发现之外,还提供了对模型设计、训练数据和代码实现的透明访问。

例子

- LLM360 – LLM360旨在通过促进模型创建的完全透明度来改变LLM领域。该项目公开了AMBER和CRYSTALCODER等模型的训练数据、代码和中间结果以及最终权重。LLM360通过使整个训练过程开源,鼓励可复制性和合作研究,为道德AI开发树立了新的基准。

- LLaMA – 拥有从7B到65B参数的模型,LLaMA在开源LLM方面取得了重大进步。仅在公开可访问的数据集上训练的LLaMA-13B在一系列基准测试中的表现超过了更大的专有模型。该项目展示了对开放性和社区驱动的AI研究的承诺。

- OLMo – AI2的OLMo(Open Language Model)为7B规模的模型提供了训练代码、数据和模型权重的完全访问。OLMo通过强调开放性和可复制性,鼓励语言模型研究的进步,使研究人员和学者能够共同创造。

- Llama-3 – Meta Llama,以其8B和70B参数模型针对各种应用进行了优化,在Llama-3中被引入。这些模型以其在推理和其他任务中的最新性能,在不同领域的开源AI开发中树立了标准。

3.3 - 特定领域LLM

特定领域LLM旨在通过利用特定领域的数据和微调策略来更好地执行专业任务,例如编程和生物医学。这些模型不仅提高了工作性能,还展示了AI如何被用来解决各种专业领域中的复杂问题。

例子

- BioGPT – BioGPT具有针对生物医学领域的特殊架构,改进了生物医学信息提取和文本合成等活动。在许多生物医学自然语言处理任务中,它的表现优于以前的模型,证明了其理解和生成生物医学文本的能力。

- StarCoder – StarCoder专注于理解编程语言和生成代码。由于在大型代码数据集上进行了深入训练,它在软件开发活动中非常熟练。它具有很强的理解复杂编程逻辑和创建代码片段的能力。

- MathVista – MathVista解决了视觉理解和数学思维的交汇点。它在AI研究中处理数学和视觉数据方面显示出改进,并为评估LLM在数学任务上的表现提供了标准。

3.4 - LLM智能体

大型语言模型驱动的LLM智能体是复杂的AI系统。它们利用强大的语言能力在内容开发和客户服务等工作中脱颖而出。这些智能体处理自然语言查询并执行各种领域的任务,如提出建议或制作艺术作品。当它们被集成到聊天机器人和虚拟助手等应用程序中时,LLM智能体简化了交互。这展示了它们的多功能性以及它们如何改善各种行业的用户体验。

例子

- ChemCrow – ChemCrow将18个专业工具整合到一个平台中,改变了计算化学。这个基于LLM的智能体能独立合成驱虫剂、有机催化剂和新的色团。它在化学合成、药物发现和材料设计方面也表现出色。与标准LLM不同,ChemCrow使用外部知识源,提高了其在具有挑战性的化学工作中的表现。

- ToolLLM – ToolLLM通过强调工具的可用性,改进了开源LLM。它使用ChatGPT进行API收集、指令生成和解决方案路线注释,以及ToolBench,一个指令调整数据集。与ChatGPT等闭源模型相当,ToolLLaMA在执行复杂指令和推广到未知数据源方面表现出色。

- OS-Copilot – 通过与操作系统交互,OS-Copilot扩展了LLM的能力,并创建了FRIDAY,这是一个能够很好地执行各种工作的自治智能体。在GAIA基准测试中,FRIDAY的表现优于以前的方法,展示了在PowerPoint和Excel等任务中灵活使用的能力,需要的监督更少。OS-Copilot的框架扩展了AI在通用计算中的潜力,表明在自治智能体开发和更广泛的AI研究中取得了实质性进展。

3.5 - 较小的LLM(包括量化LLM)

较小的LLM,如量化版本,适用于资源受限的设备部署,因为它们服务于需要较少精度或较少参数的应用。这些模型通过在有限的计算资源环境中提供更广泛的可访问性和应用大规模语言处理能力,促进了边缘计算、移动设备和其他需要有效AI解决方案的场景中的部署。

例子

- BitNet – BitNet是首个作为BitNet b1.58引入研究的1位LLM。每个参数具有三元权重{-1, 0, 1},该模型在成本效率方面大大提高,同时在困惑度和任务性能方面与全精度模型相当。BitNet在能源消耗、吞吐量、延迟和内存利用率方面优于其他模型。它还提出了一种新的处理范式,并为训练高性能、低成本LLM创建了一个新的缩放定律。

- Gemma 1B – 基于与Gemini系列相同的技术,现代轻量级开放变体称为Gemma 1B。这些模型在语言解释、推理和安全基准测试中表现出色,参数大小为20亿和70亿。Gemma在18个基于文本的任务中的11个上的表现优于同样大小的开放模型。发布强调了AI使用中的安全性和责任性,包括预训练和细化检查。

- Lit-LLaMA – Lit-LLaMA基于nanoGPT,旨在提供一个纯净、完全开放和安全的LLaMA源代码实现。该项目优先考虑社区驱动的开发和简单性。因此,没有样板代码,实现简单。Lit-LLaMA支持参数高效的微调方法,如LLaMA-Adapter和LoRA,使得在消费设备上的有效使用成为可能。利用PyTorch Lightning和Lightning Fabric等库,Lit-LLaMA专注于模型实现和训练的关键方面,坚持单一文件方法,以生产最优质的LLaMA实现,完全开放源代码,为快速进步和探索做好准备。

3.6 - 非Transformer架构LLM

被称为非变换器LLM的语言模型经常引入如循环神经网络(RNN)等组件,从而脱离了传统的变换器架构。这些方法通过研究替代设计来解决变换器的一些主要缺点和问题,如昂贵的计算成本和对序列数据处理不当。非变换器LLM通过探索替代设计来提供独特的方法来提高模型性能和效率,这扩大了高级语言处理工作的应用范围,并增加了AI开发的工具数量。

例子

- Mamba – 由于Mamba解决了变换器架构的计算效率问题,特别是处理扩展序列时,它在基础模型中提供了重大发展。与传统模型不同,Mamba不受次二次时间架构的限制,这些架构在基于内容的推理方面存在困难。这些设计的例子包括线性注意力和循环模型。Mamba通过允许结构化状态空间模型(SSM)参数根据输入工作来增强离散模态处理。这一突破和硬件感知并行算法导致了一种简化的神经网络架构,摒弃了MLP块和注意力。Mamba在包括语言、音乐和基因组学在内的多个模态中的表现超过了相同甚至更大尺寸的变换器,

3.7 - LLM自我事实检查

旨在缓解大型语言模型的事实不可靠和静态知识库限制的一系列有前景的进展。这些新颖的技术对于准备LLMs进行广泛的现实世界实施至关重要。这样做需要两种能力:

- 访问外部资源的能力

- 为答案提供引用和参考资料的能力

在这个领域的重大初步研究包括谷歌的REALM和Facebook的RAG,两者都在2020年推出。

2022年6月,OpenAI推出了一个名为WebGPT的经过微调的GPT模型版本,它利用微软Bing浏览互联网并生成更精确和全面的答案。WebGPT的运作类似于人类用户:

- 向Bing提交搜索查询

- 点击链接

- 滚动网页

- 使用像Ctrl+F这样的功能来定位术语

当模型将互联网上的相关信息纳入其输出时,它会包括引用,允许用户验证信息的来源。研究结果表明,所有WebGPT模型在准确响应的比例和提供真实和有信息量的答案的百分比方面都超过了每个GPT-3模型。

图8. 比较GPT-3和WebGPT模型的TruthfulQA结果

来源:“WebGPT: Browser-assisted question-answering with human feedback”

DeepMind正在积极探索类似的研究途径。几个月前,他们推出了一个名为Sparrow的新模型。像ChatGPT一样,Sparrow以对话为基础运作,像WebGPT一样,它可以搜索互联网以获取新信息并提供支持其主张的引用。

图9. Sparrow提供最新答案和事实声明的证据

来源:“Improving alignment of dialogue agents via targeted human judgements”

尽管现在下结论说准确性、事实检查和静态知识库问题可以在未来的模型中被克服还为时过早,但当前的研究成果对未来是充满希望的。这可能会减少使用提示工程来交叉检查模型输出的需求,因为模型已经交叉检查了其结果。

3.8 - 合成训练数据LLM

为了解决我们上面提到的一些限制,例如那些由训练数据引起的限制,研究人员正在研究能够生成自己的训练数据集(即生成合成训练数据集)的大型语言模型。

在最近的一项研究中,谷歌研究人员开发了一个大型语言模型,能够创建问题、生成全面答案、筛选其响应以获得最高质量的输出,并使用策划的答案对自己进行微调。令人印象深刻的是,这在多个语言任务中实现了新的最先进的性能。

例如,该模型的性能从74.2%提高到82.1%在GSM8K上,从78.2%提高到83.0%在DROP上,这是两个广泛用于评估LLM性能的基准。

最近的一项研究专注于增强一个关键的LLM技术,称为“指令微调”,它构成了像ChatGPT这样的产品的基础。虽然ChatGPT和类似的指令微调模型依赖于人工制作的指令,但研究团队开发了一个能够生成自己的自然语言指令并随后使用这些指令对自己进行微调的模型。

性能提升是显著的,因为这种方法将基础GPT-3模型的性能提高了33%,几乎等同于OpenAI自己的指令调整模型(图11)。

图11. 由人类专家评估的GPT3模型及其指令调整变体的性能

来源:“Self-Instruct: Aligning Language Model with Self Generated Instructions”

有了这样的未来模型,有可能减少模型输出的偏见和毒性,并提高微调所需数据集的效率,这意味着模型学会自我优化。

3.9 - 稀疏专家LLM模型

尽管每个模型的参数、训练数据、算法等导致性能差异,但所有今天公认的语言模型——如OpenAI的GPT-3、Nvidia/Microsoft的Megatron-Turing、谷歌的BERT——在最终设计上都共享一个基本特征。它们是:

- 自回归

- 自监督

- 预训练

- 使用密集激活的基于变换器的架构

密集语言模型意味着所有这些模型都使用它们所有的参数来创建对提示的响应。正如你可能猜到的,这不是很有效,也很麻烦。

稀疏专家模型的想法是,模型能够激活只有一组相关的参数来回答给定的提示。目前开发的超过1万亿参数的LLMs被认为是稀疏模型。2 这些模型的一个例子是谷歌的GLam,拥有1.2万亿参数。

据《福布斯》报道,谷歌的GLaM比GPT-3大七倍,但训练能耗少了三分之二。它只需要一半的计算资源进行推理,并在许多自然语言任务上超过了GPT-3的性能。

稀疏专家模型意味着以这种方式开发未来的语言模型更有效,能耗更低。

参考资料

Cem Dilmegani, The Future of Large Language Models in 2024.

Tanya Malhotra, The Next Big Trends in Large Language Model (LLM) Research.