最近,斯坦福和NYU的一项研究发现,GPT-4能够很好地模拟人类,高精度地复制社会科学实验了!

论文地址:https://docsend.com/view/qeeccuggec56k9hd

论文地址:https://docsend.com/view/qeeccuggec56k9hd

通过提示,AI可以以随机人口统计特征的形式回答调查问题,调查了数千名「AI人」后,一份社会科学实验报告就顺利出炉了。

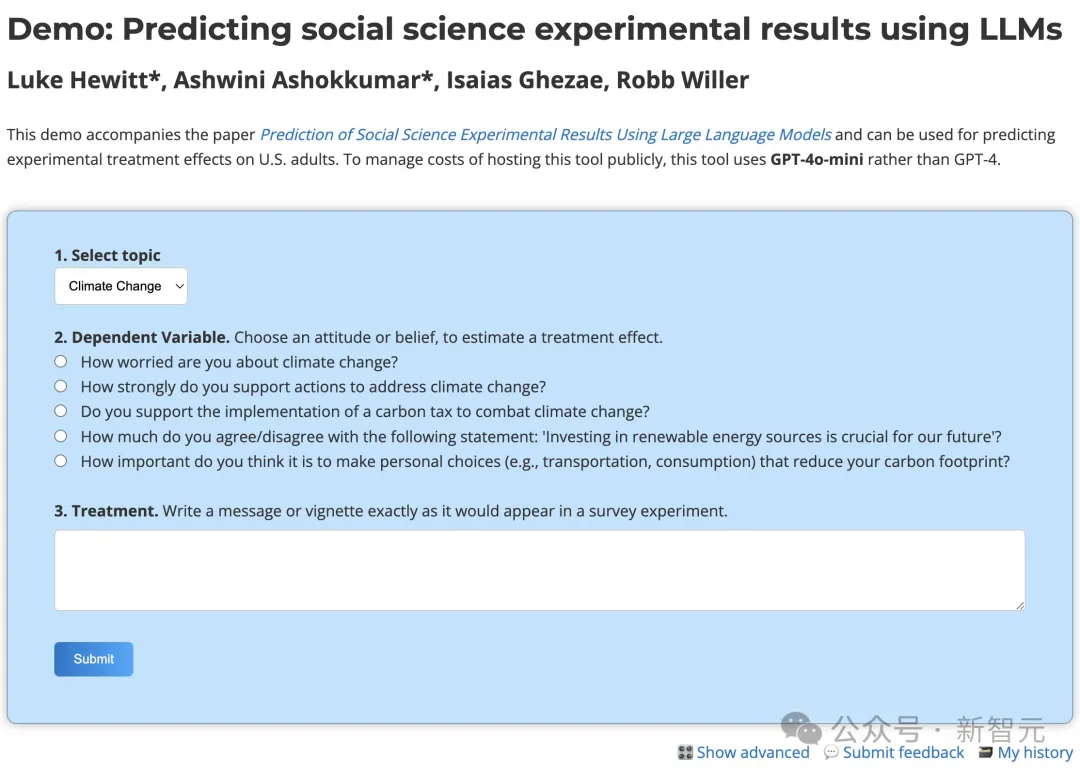

点进这个页面,就可以使用这个演示,模拟被试生成预测的实验效果了

点进这个页面,就可以使用这个演示,模拟被试生成预测的实验效果了

社会科学实验中最困难的过程之一,就是田野调查了。

而现在,可以采用LLM预测社会科学实验的结果了?

不过有个问题:用LLM模拟真实的人类,结果能准吗?

研究者发现,在70项研究中,模拟效果和观察到的效果,存在惊人的一致性。

准确性超越人类专家

用LLM进行社会科学实验,预测的准确性有多高?

研究者使用GPT-4,从70个实验中预测了465种效应。

其中包括

-通过NSF资助的TESS计划进行的50项调查实验

-20项额外的重复研究

给模型的提示词,是(a)从美国人的代表性数据集中提取的人口统计资料和(b)实验刺激。

通过汇总模型响应估计的效果,可以看出它们与实际的实验效果密切相关!

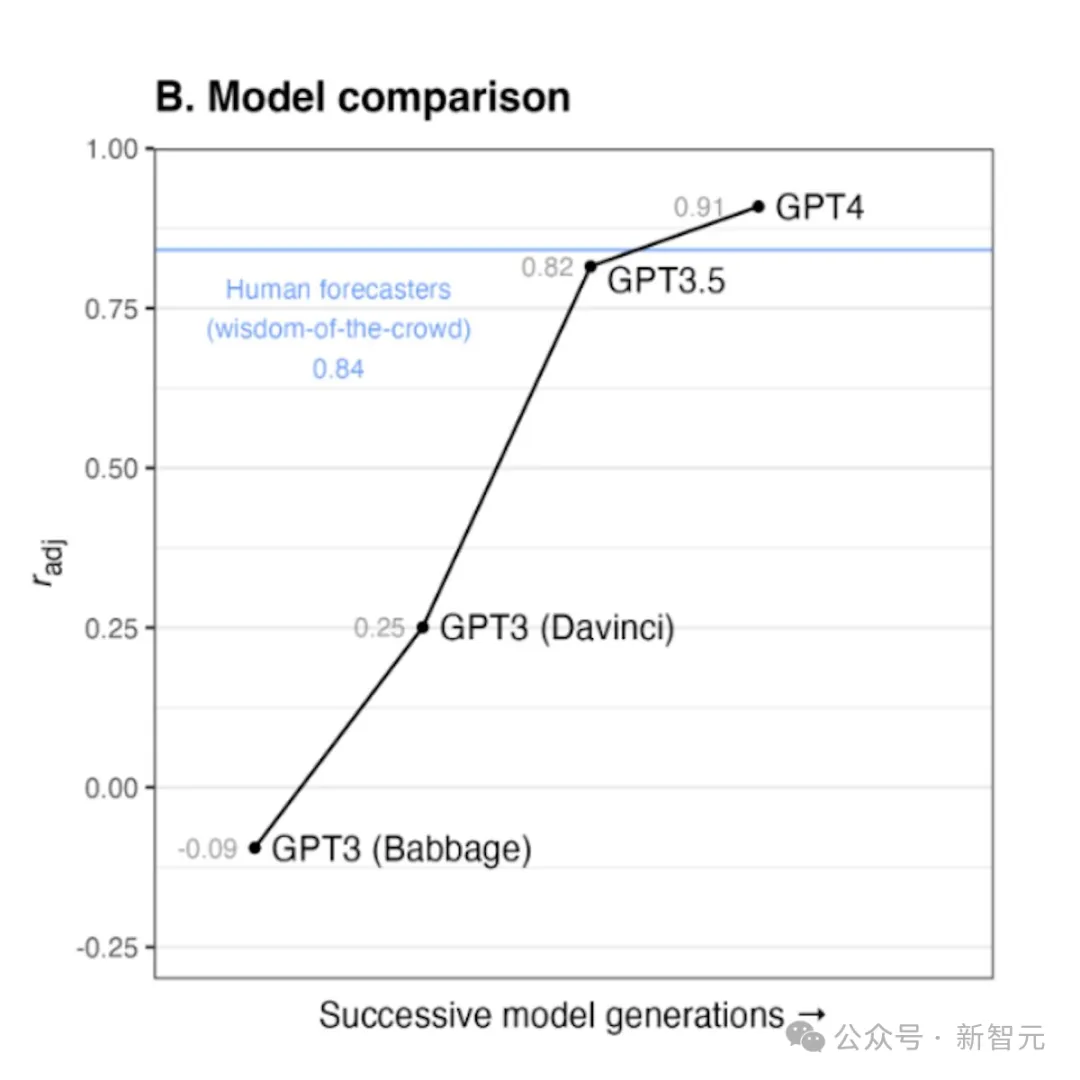

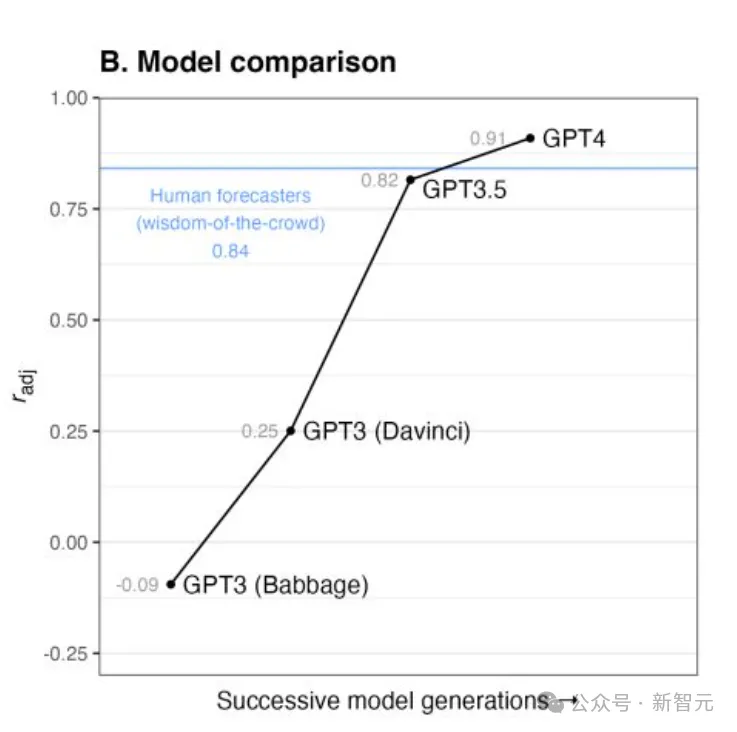

另外研究者们还发现,随着模型的演进,它们的预测准确性越来越高。

到了GPT-4时,已经超越了美国人在线样本(N=2,659)的预测。

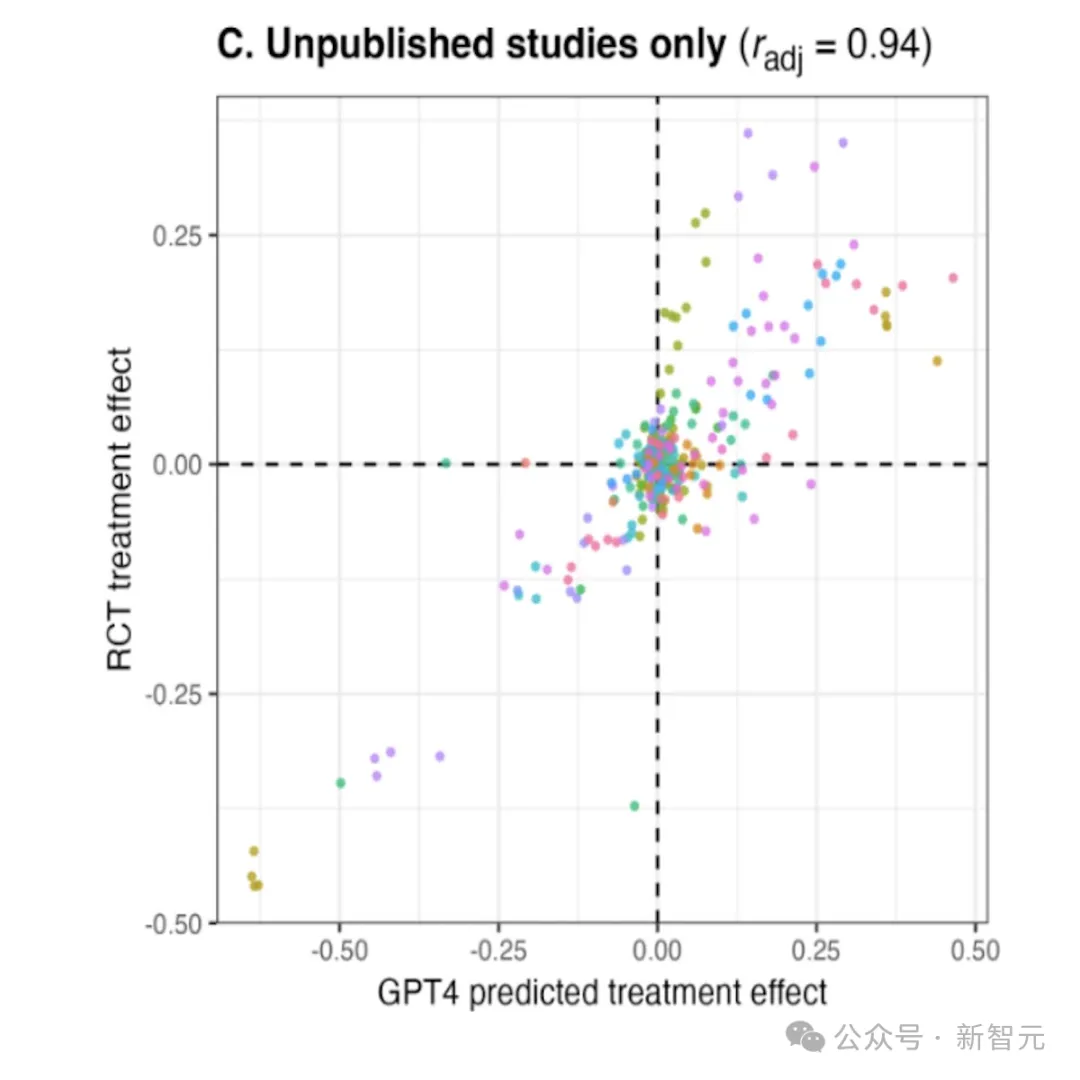

这里就有人要问了:有没有可能,LLM只是从训练数据中检索和重现已知的实验结果呢?

研究者找到了证据,证明并非如此。

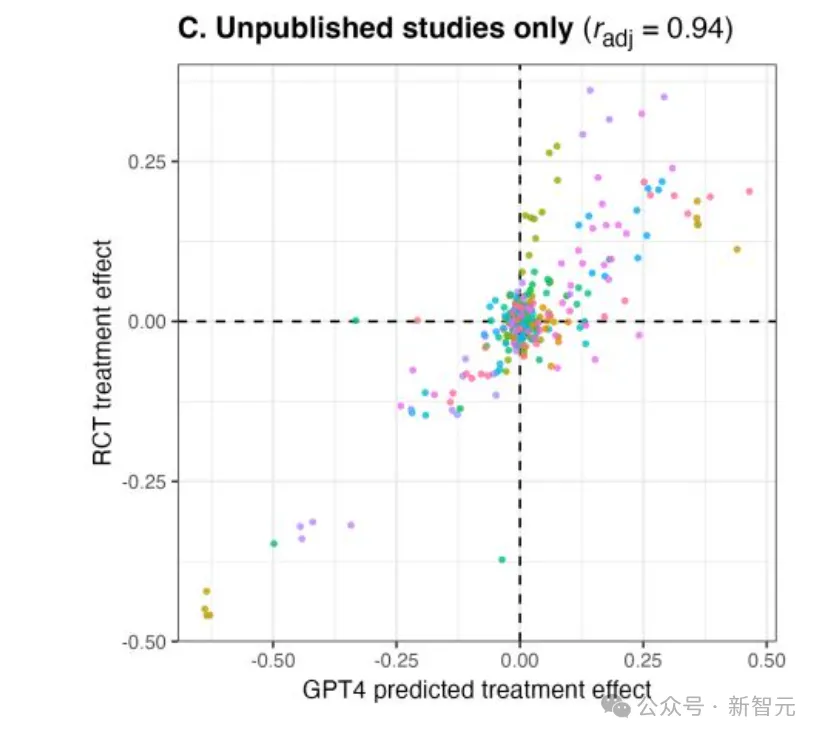

他们特意找到了GPT-4训练数据截止时未发表的研究,发现预测的准确性仍然很高。

我们找到了反对这一点的证据:仅分析 GPT4 训练数据截止时「未发表」的研究,我们发现预测准确性很高。

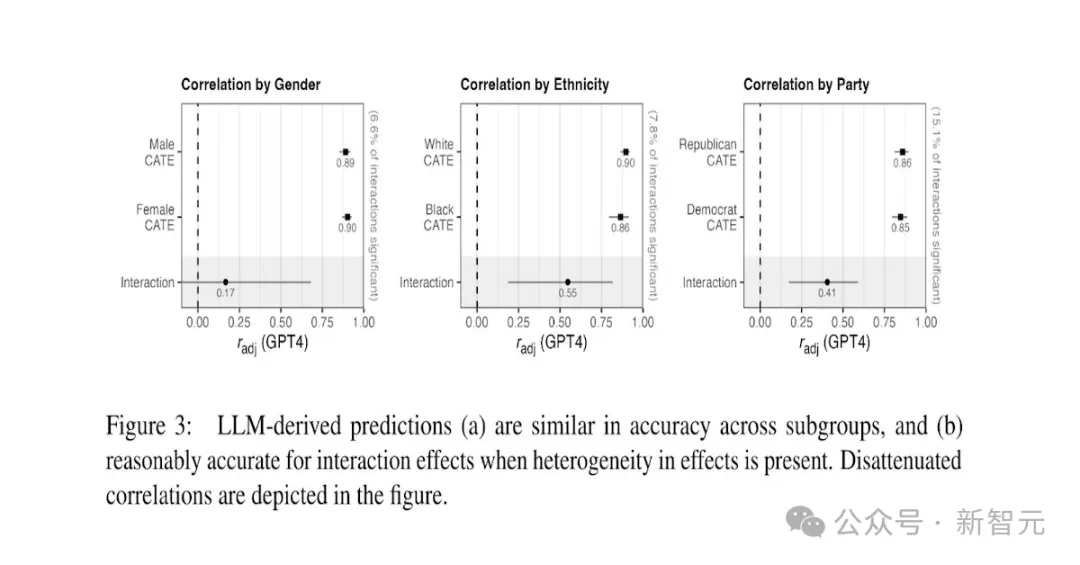

不过还有一个问题,此前人们曾发现,训练数据中的歧视,会引发LLM的偏见。

这些偏差是否会影响实验结果预测的准确性呢?

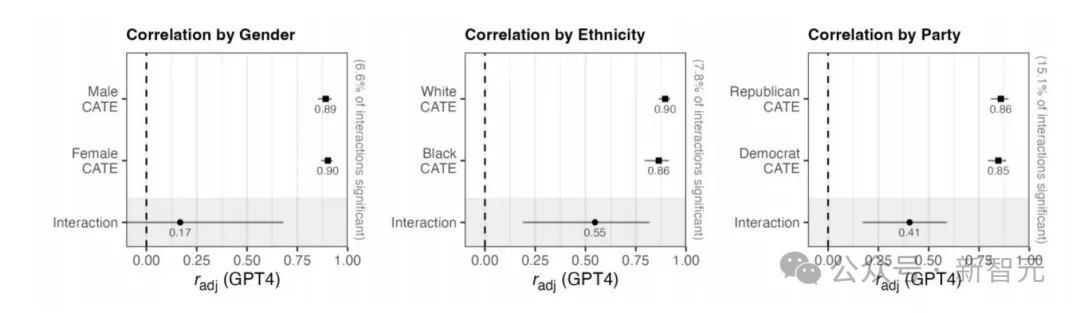

为此,研究者从以下三方面,对结果进行了比较:

- 女性和男性

- 黑人和白人

- 民主党和共和党

结果显示,尽管已知训练数据不平等,但LLM得出的预测准确性,在各个亚组之间仍然具有可比性。

然而,研究的实验效果几乎没有异质性,因此,还需要更多的研究,来评估LLM实验结果的预测是否存在偏差,以及是怎样的偏差。

此外,研究者还评估了大型研究的预测准确性,比较了大量干预措施的影响。

通过9项调查和实地大型研究可以发现,LLM得出的预测相当准确。

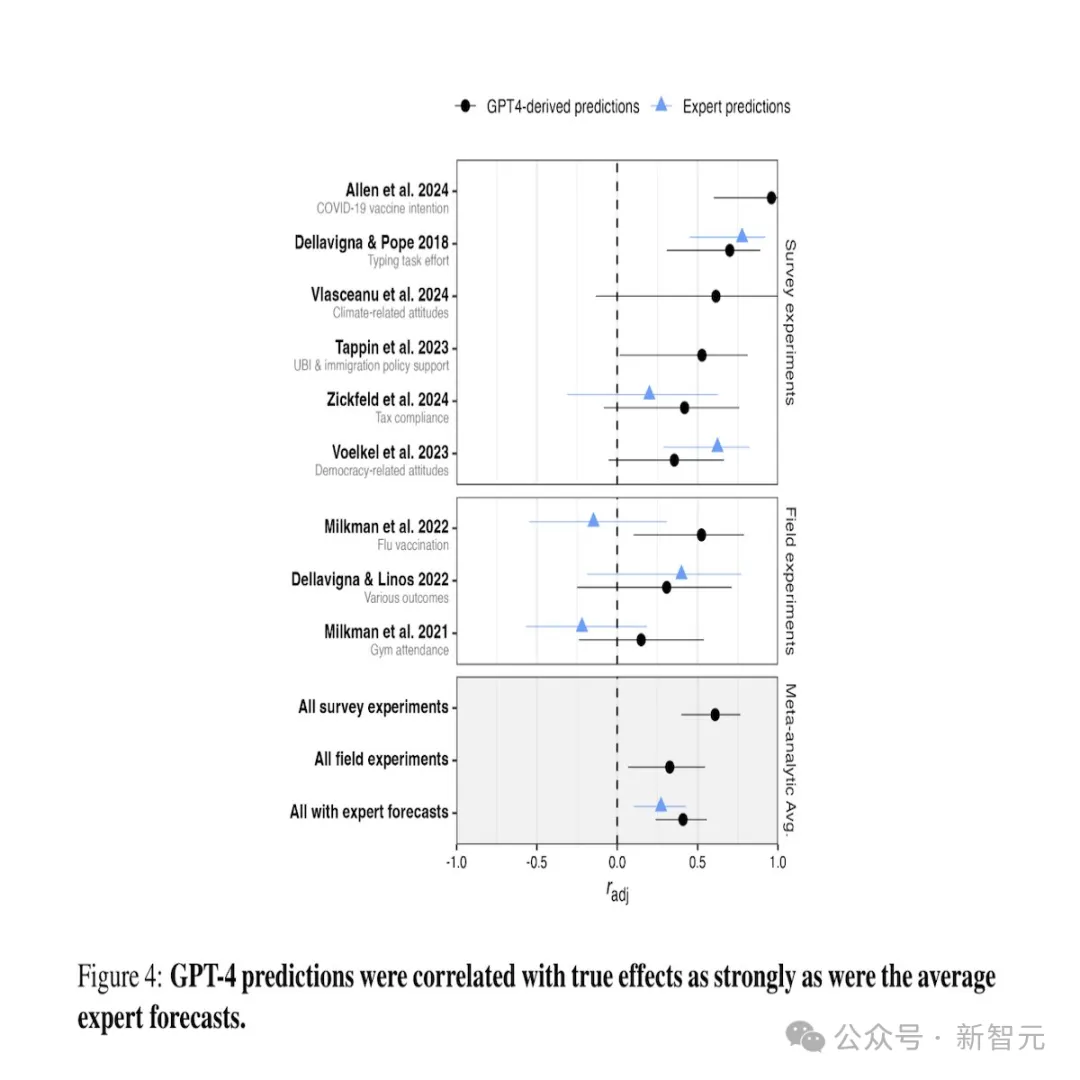

尤其值得注意的是,它们的准确性已经等同或超过了人类预测专家。

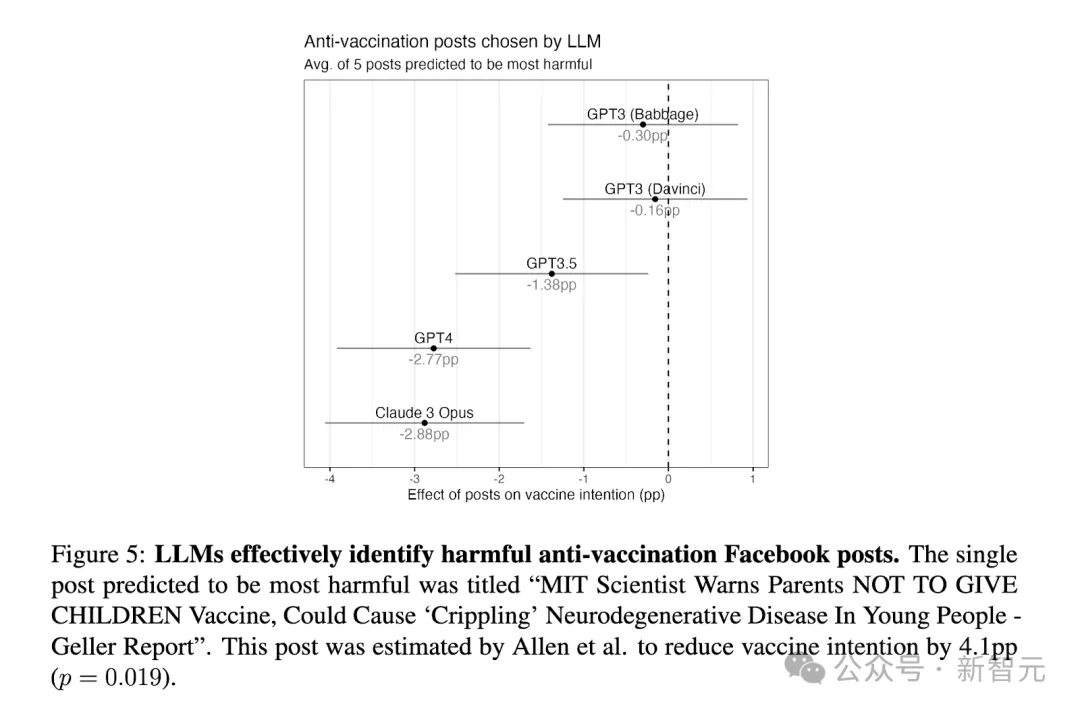

最后,研究者发现LLM可以准确预测对社会有害结果的影响,例如FB上antivax的帖子对vax意图的影响。

这种能力,可能产生积极的用途,比如帮助内容审核,不过也同时凸显了滥用的风险。

总的来说,这项研究发现,LLM在实验中给出的预测,要比外行和人类专家的样本都更准确。

这种能力,在科学和实践方面有多种应用。

比如,运行低成本的试点,来确定有希望的干预措施,或模拟可能对参与者有害的实验。

不过也存在局限性和风险,包括偏见、过度使用和误用。

用LLM复制社会科学实验,可行吗?

LLM是一种最新的机器学习模型,经过大量人类语言语料库的训练后,它们具有惊人的能力来模拟人类如何思考、交流和行为。

因此,它们能够模仿广泛的人类高级能力,例如社会互动和协调、道德判断、谈判、情感支持和说服。

随着LLM越来越能够模拟人类语言的使用,那它们能否被用于社会和行为科学的研究呢?

在这项研究中,研究者探讨了LLM是否可以用于准确预测行为的结果实验。如果有效,这种能力就能为建立科学理论和行为干预带来无数好处。

他们检查了先进的公开LLM——GPT-4,是否可用于预测在大量有力的、预先注册的、具有全国代表性的实验中观察到的原始实验效果(a)NSF 资助的多学科社会科学分时实验(TESS)计划和(b)最近复制研究的档案,它们共同代表了广泛的不同领域(例如社会心理学、政治学、社会学、公共政策、公共卫生)。

研究者让GPT-4模拟了大量不同人口的美国人样本对实验刺激的反应。

然后,他们比较了不同实验条件下的平均响应,以生成LLM预测的实验效应大小,然后将其与原始实验效应相关联。

研究者评估了LLM得出的预测对一般美国人和具有独特学术兴趣的几个亚群体的准确性,系统地对LLM用于预测调查实验中观察到的干预效应的能力进行了基准测试。

最后,他们超越了这个初步的测试档案,收集并分析多种大型多处理实验,包括涉及行为测量的研究、干预措施的现场测试和政策影响评估,以更好地评估LLM预测实验结果的价值和当前局限。」

结果显示,LLM虽然不会取代人类被试,但廉价、快速且可能大量开展基于LLM的试点研究的能力,可以帮助研究人员确定更有前途的研究想法,促进理论和假设的建立,更好地估计未知的效应大小,以确定所需的效果样本大小,并优先考虑需要复现的已发表研究。

这种能力也可能具有应用价值。例如,政策制定者可以利用LLM来有效评估许多公共信息传递方法,以鼓励理想的行为(例如公共卫生行为、福利计划注册)。

目前,预测实验结果的最佳可用工具是从专家或非专业预测者那里收集预测。

然而,虽然有时具有预测性,但系统地收集预测既耗时又昂贵,而基于LLM的低成本工具,可以使预测性预测广泛可用。

研究者研究了LLM在代表性样本调查实验中准确模拟人类反应的能力。

他们使用LLM,来模拟了人类对各种主题(包括人格特质、道德判断和政治态度)的调查问题的反应,并取得了不同程度的成功。

研究概述

他们研究了是否可以利用当前一代的LLM,来准确预测在美国进行的社会科学实验效果的方向和程度。

他们首先建立了一个大型的多学科测试档案,其中包含通过美国国家科学基金会资助的50个调查实验——2016年至2022年社会科学共享实验(TESS)项目,全部在全国代表性概率样本上进行。

我们通过最近的复制项目中的另外20项实验对此进行了补充,这些实验也是在全国代表性样本上进行的。

对于每个实验,他们都重新分析了原始的、公开的数据集,使用一致的分析方法估计所有实验对比。

这个测试档案有几个优点。

首先,实验质量高:它们都是高度统计、预先注册、同行评审、针对全国代表性样本进行,并且材料是开放获取的。

使用具有全国代表性的美国人样本特别有价值,使他们能够评估LLM对人口亚组的预测的准确性。

其次,档案内容广泛且多样化。

这些实验由来自不同领域(例如政治学、心理学、社会学、社会政策、公共卫生、传播学)的77名社会和行为科学家设计,并测试了许多不同类型的实验治疗的效果(例如框架效应、显着性)主题、启动社会身份对一系列结果(如政治、文化和宗教态度、对少数群体的偏见、幸福)的影响。

第三,研究者不依赖他人的分析,而是采用致的分析方法来估计实验治疗效果。这样做可以让他们避免研究人员的偏见,还可以估计所有可能的实验对比,包括原始研究人员没有假设的那些影响,因为它们不太可能在已发表或公开发表的论文中出现。

第四,在GPT-4训练数据窗口结束时,大量实验的结果尚未发表或公开发布,这样研究者就能专门测试LLM在GPT-4无法接触过的实验中的预测能力。

当然,测试档案也有重要的局限性。最关键的是,它只包含代表美国人口的研究,无法在该范围之外进行评估。

此外,虽然它包括来自多个学科的研究,但许多学科并未包括在内(例如认知心理学、行为经济学、发展经济学、营销学)。

最后,档案完全由基于文本的刺激和自我报告的相关测量的调查实验组成,不包括现场实验、行为因变量或图像或视频刺激。

为了开始解决主要测试档案的一些局限性,研究者对下面的补充数据集进行了额外的分析。

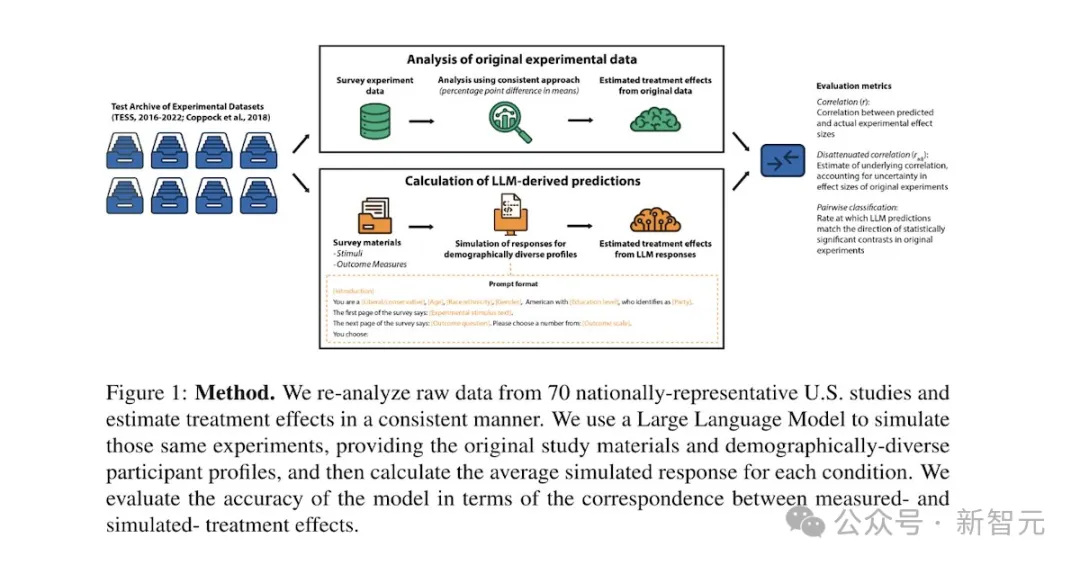

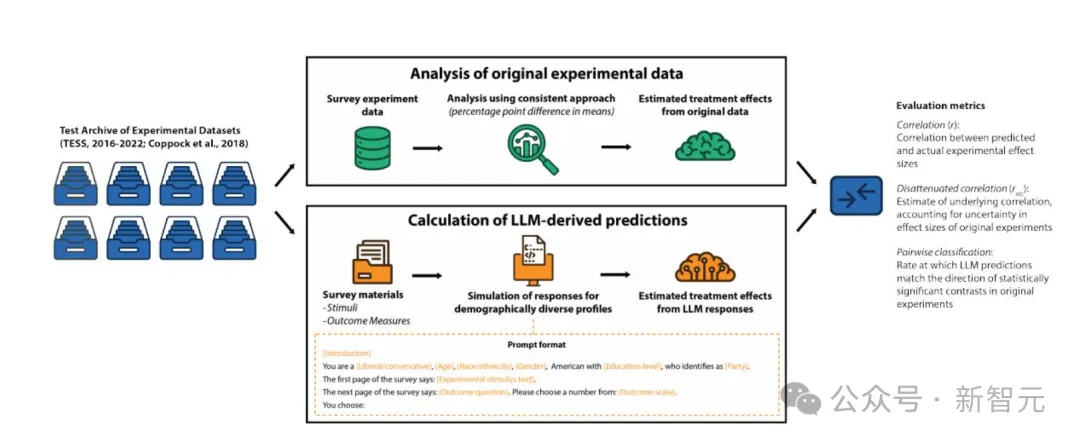

他们的研究设计如下图所示。为了对测试档案中的实验结果生成基于LLM的预测,他们获得了原始研究材料,包括所有实验条件、结果变量和反应量表的刺激文本。

从广义上讲,LLM可以被提示(a)直接预测实验结果,或(b)模拟个体参与者对实验刺激的反应。

这里,研究者采用了后一种策略。

他们向LLM提出了:

(a)介绍性信息(如「您将被要求预测人们对各种信息的反应」),包括对研究背景的简要描述;

(b)研究参与者的具体人口统计概况模仿——包括有关性别、年龄、种族、教育、意识形态和党派偏见的信息,从具有全国代表性的大型样本中随机抽取;

(c)实验刺激的文本;

(d)用于评估结果的问题文本变量,以及结果啦应量表和标签。

然后,他们提示LLM估计参与者在受到实验刺激后将如何回应结果问题。

他们使用了集成方法来减少对任何单一提示格式的特殊响应。

对于每个实验条件和结果测量,研究者都对所有LLM的响应进行了平均。

结果

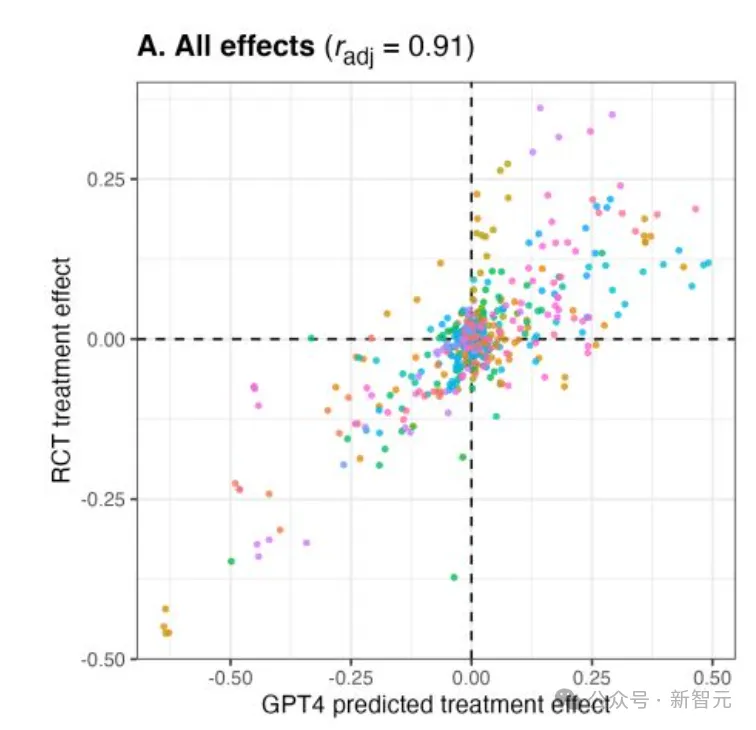

为了评估当前一代的LLM是否可以用来预测实验中的干预效应,研究者首先检查了GPT-4预测的干预效应与实际估计的干预效应之间的相关性。

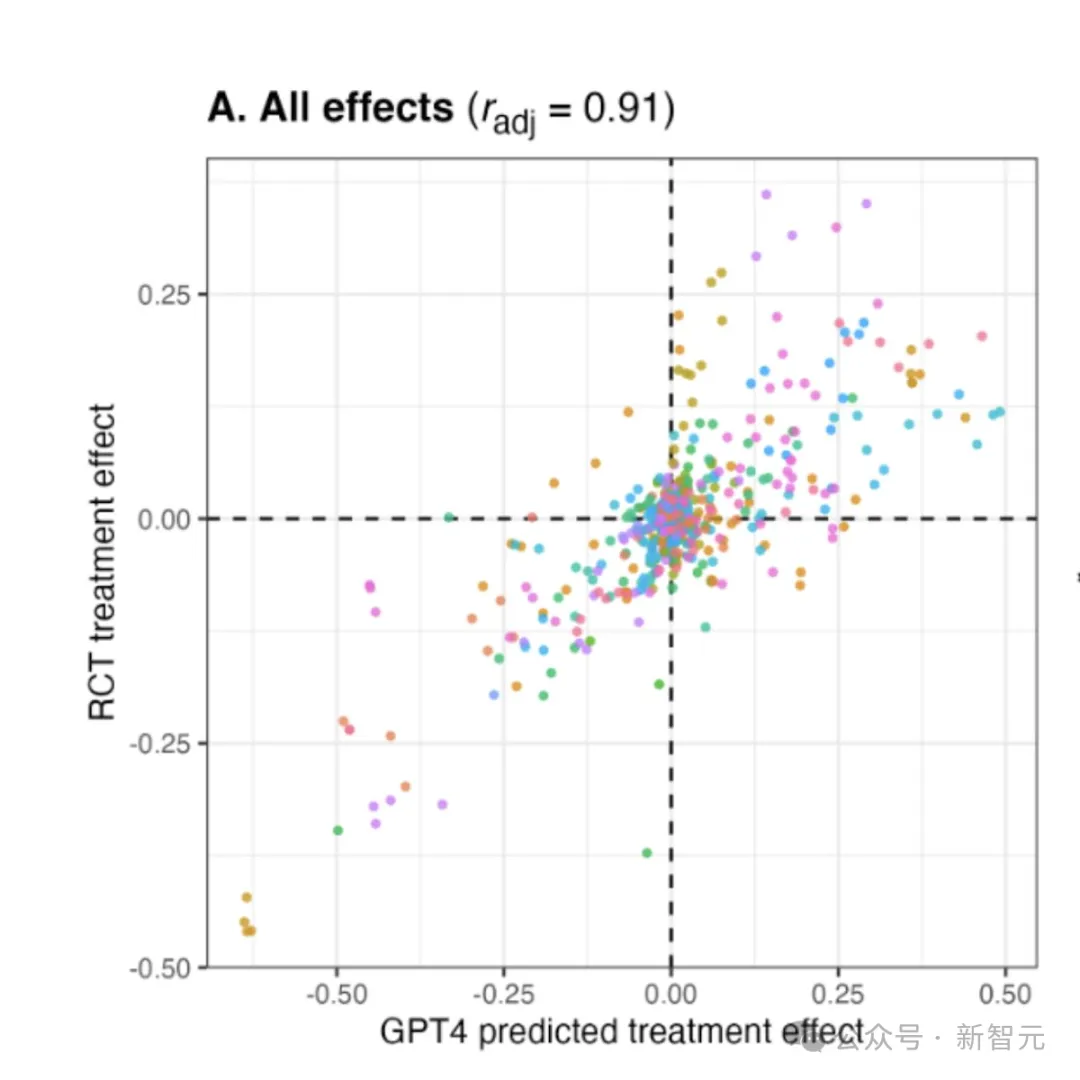

在对从存档中的70个实验计算出的476个实验效果进行分析时,可以发现GPT-4得出的预测与原始效果大小密切相关。

仅检査在原始实验中具有统计显著效果的成对对比,可以发现对于90%的对比,GPT-4得出的预测方向是正确的。

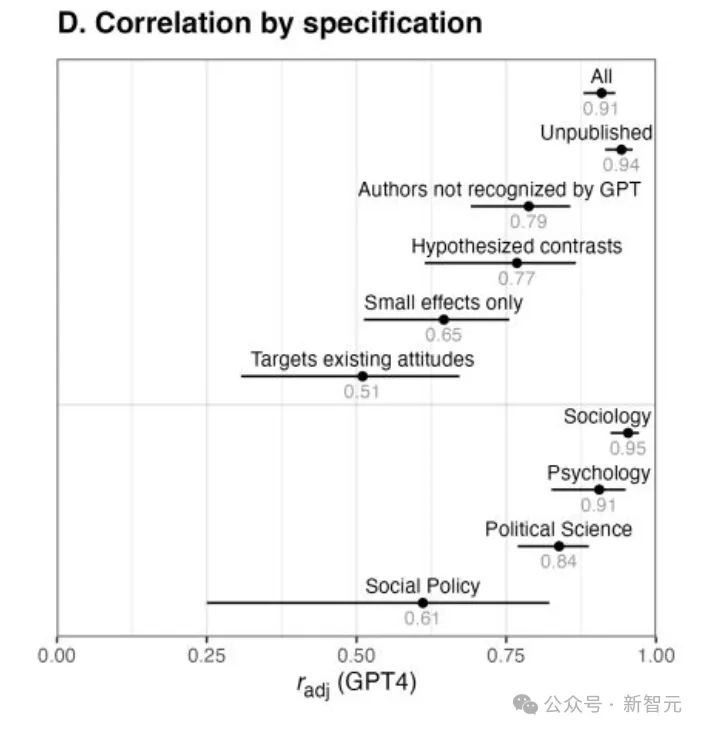

以下几个图,显示了LLM在美国进行的基于文本的社会科学实验中,得到了准确的预测效果。

(a)在包含70个基于文本的实验(具有476个效果)的数据集中,LLM得出的对许多提示的干预效应的估计,与原始干预效应密切相关。

(b)LLM得出的预测的准确性,在几代LLM中得到了提高,其准确性超过了从一般人群中收集的预测。

(c)对于那些不可能出现在LLM训练数据中的研究,LLM得出的预测仍然高度准确,因为这些研究没有在LLM训练数据截止日期之前发布。

(d)在各个实验子集的稳健性检査分析中,LLM得出的预测的准确性仍然很高。在面板A和中,不同的颜色代表不同的研究。

LLM得出的预测(a)在各个亚组中的准确性相似,并且(b)当存在效应异质性时,交互效应相当准确。图中描绘了减弱的相关性。