原标题:Photorealistic Object Insertion with Diffusion-Guided Inverse Rendering

论文链接:https://arxiv.org/pdf/2408.09702

项目主页:https://research.nvidia.com/labs/toronto-ai/DiPIR/

作者单位:NVIDIA 多伦多大学 Vector Institute

论文思路:

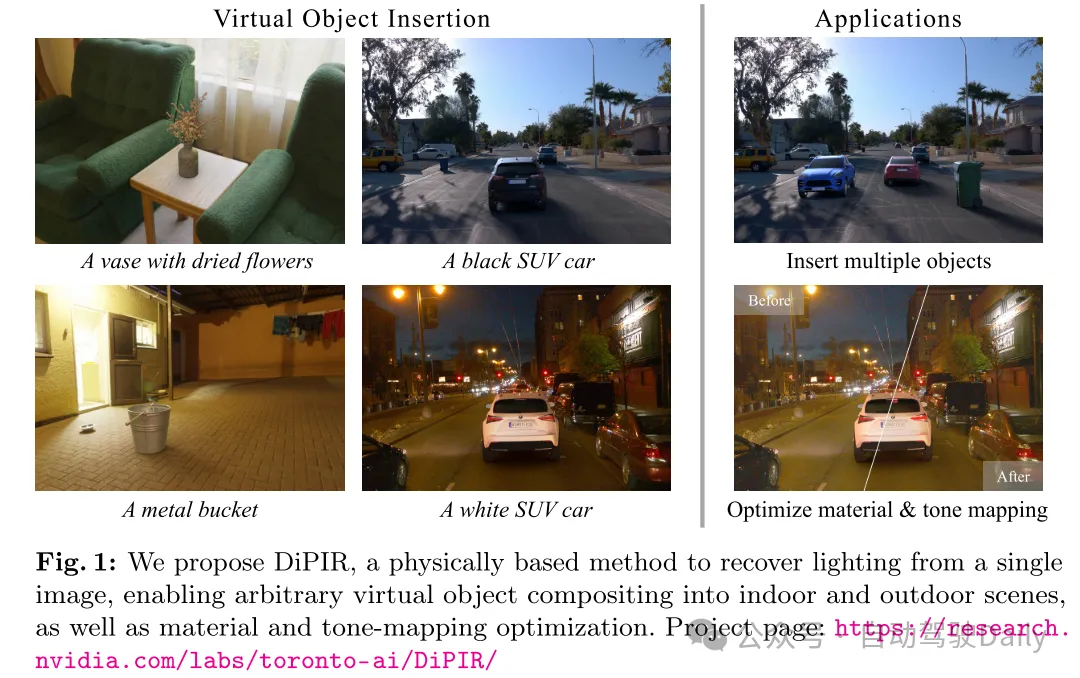

将虚拟物体正确插入到真实场景的图像中,需要对场景的光照、几何形状和材质,以及图像形成过程有深入的理解。尽管最近的大规模扩散模型在生成和修复图像方面表现出了强大的能力,但本文发现当前的模型还不足以“理解”单张图片中的场景,从而无法在保持合成物体的身份和细节的同时生成一致的光照效果(阴影、明亮的反射等)。本文提出使用个性化的大型扩散模型作为物理基础逆向渲染过程的指导(guidance)。本文的方法恢复了场景光照和色调映射参数,从而允许在单帧图像或室内外场景的视频中进行真实感的任意虚拟物体合成。本文的物理基础流程(physically based pipeline)进一步支持自动材质和色调映射的优化。

论文设计:

虚拟物体插入能够实现从虚拟制作到互动游戏和合成数据生成的一系列应用。为了生成真实感的插入效果,必须忠实地模拟虚拟物体与环境之间的相互作用,例如准确的镜面高光和阴影。

标准的虚拟物体插入流程通常包括三个关键步骤:i) 从输入图像中估计光照,ii) 创建3D代理几何模型,iii) 在渲染引擎中进行合成图像渲染。然而,第一个也是最重要的一步仍然是一个开放的研究问题。光照估计在处理有限输入(如使用低动态范围的消费设备拍摄的单张图像)时尤为具有挑战性。实际上,逆向渲染本质上是一个病态问题(ill-posed problem)。

为了限制其解空间,以往的研究要么试图定义手工设计的先验知识 [9,18,31,78],要么从数据中学习这些先验知识 [15–17,22,23,32,36,58,64,65,80]。然而,前者在应用于真实场景时往往效果不佳,而后者则由于缺乏真实数据而受到限制。因此,这些算法通常高度针对特定领域进行优化,例如室内场景 [15–17,52,65] 或室外场景 [22, 23, 58, 64, 80]。

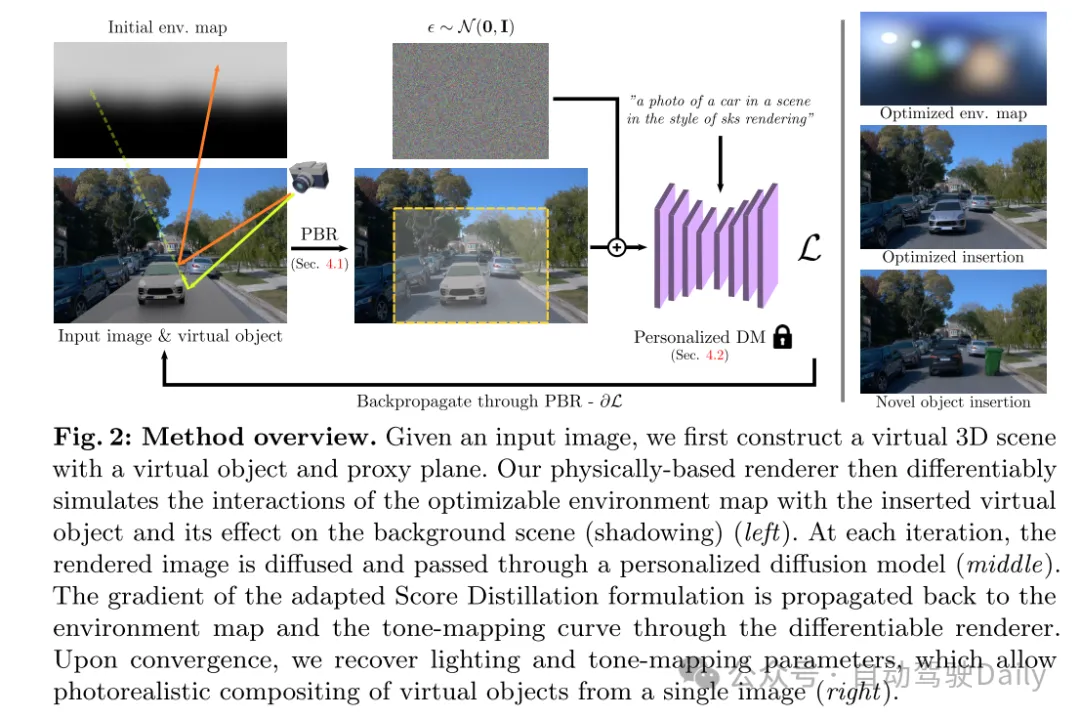

为了解决这些挑战,本文提出利用大型扩散模型(DMs) [48] 学习到的强大图像生成先验知识来指导逆向渲染。与通常特定于某个领域的手工设计或监督数据驱动先验不同,DMs 是在大规模数据集上训练的,并展示出对世界及其背后物理概念的显著“理解”(“understanding”)。虽然 DMs 在生成过程中仍然常常无法产生准确的光照效果(如阴影和反射) [51],但本文观察到,当它们与基于物理的渲染器结合并适应场景时,可以提供有价值的指导。

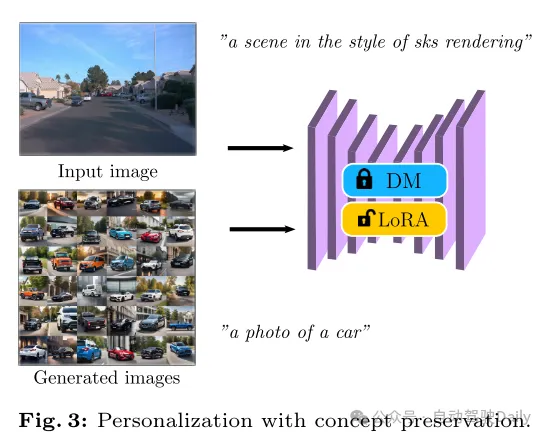

具体来说,本文提出了用于逆向渲染的扩散先验(Diffusion Prior for Inverse Rendering)(DiPIR),基于以下三大主要贡献。首先,本文使用基于物理的渲染器来准确模拟光线与3D资产之间的相互作用,以生成最终的合成图像。本文还考虑了未知的色调映射曲线,以模仿相机传感器的响应。其次,本文提出了一种基于输入图像和插入资产类型的预训练DM的轻量化个性化方案。第三,本文设计了一种SDS损失 [46] 的变体,利用这种个性化并提高训练的稳定性。

在 DiPIR 中,DM 类似于人类评估者。它将编辑后的图像作为输入,并通过可微渲染将反馈信号传播到基于物理的场景属性,从而实现端到端优化。本文的实验表明,DiPIR 在室内和室外数据集上用于物体插入的光照估计方面优于现有的最先进方法。

图1:本文提出了DiPIR,这是一种基于物理的方法,用于从单张图像中恢复光照,能够将任意虚拟物体合成到室内和室外场景中,同时进行材质和色调映射优化。

图2:方法概述。给定输入图像,本文首先构建一个包含虚拟物体和代理平面的虚拟3D场景。本文的基于物理的渲染器随后可微地模拟可优化环境贴图与插入虚拟物体的相互作用及其对背景场景(阴影)的影响(左)。在每次迭代中,渲染图像会被扩散并通过个性化的扩散模型(中)。适应后的Score Distillation公式的梯度通过可微渲染器传播回环境贴图和色调映射曲线。在收敛时,本文恢复光照和色调映射参数,从而实现从单张图像中对虚拟物体的真实感合成(右)。

图3:带有概念保留的个性化。

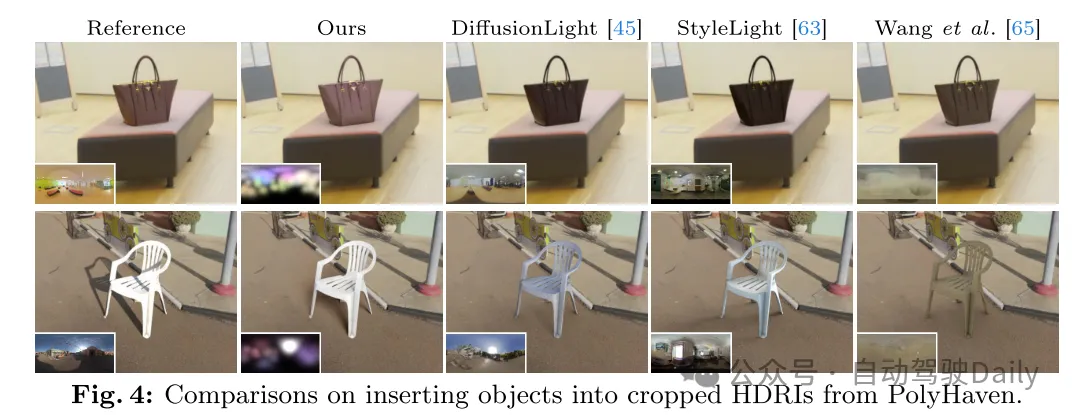

图4:在 PolyHaven 裁剪的HDRIs中插入物体的对比。

图5:在 Waymo 驾驶场景中插入汽车资产。请注意插入汽车的阴影方向和清晰度,以及整体亮度、颜色和高光反射。

实验结果:

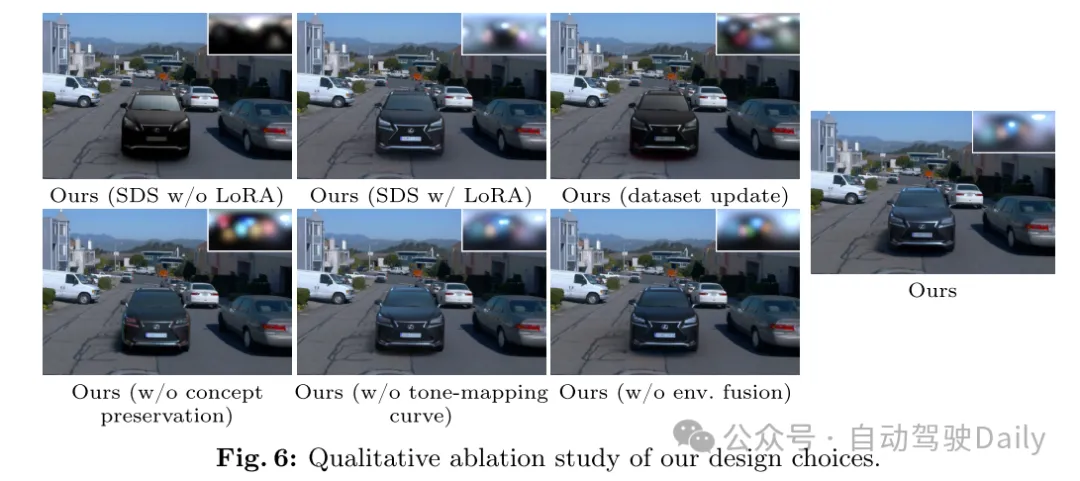

图6:本文设计选择的定性消融研究。

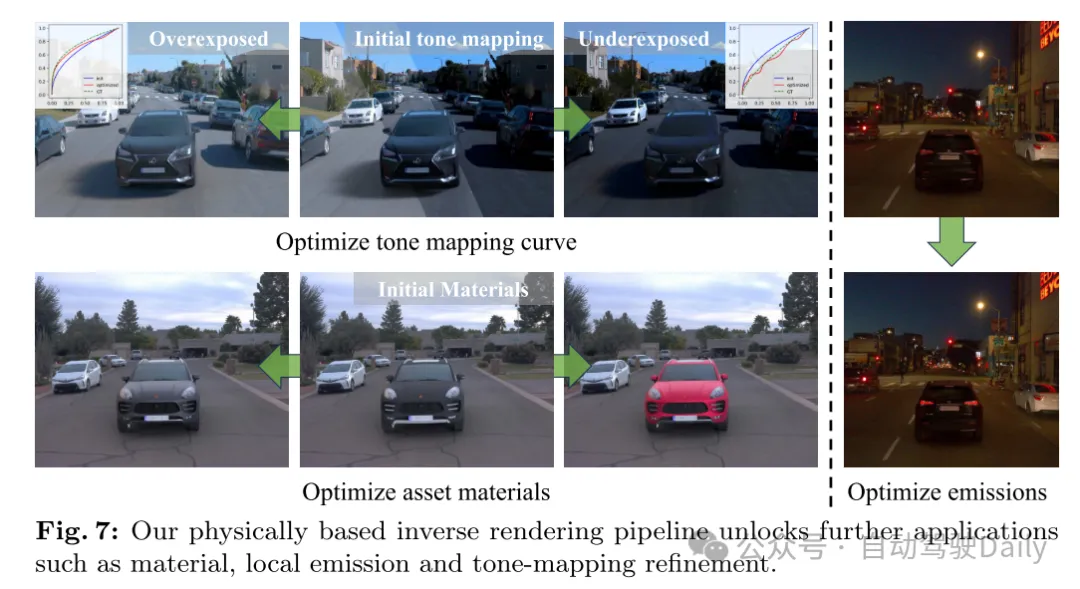

图7:本文的基于物理的逆向渲染流程解锁了更多应用,如材质优化、局部发光和色调映射优化。

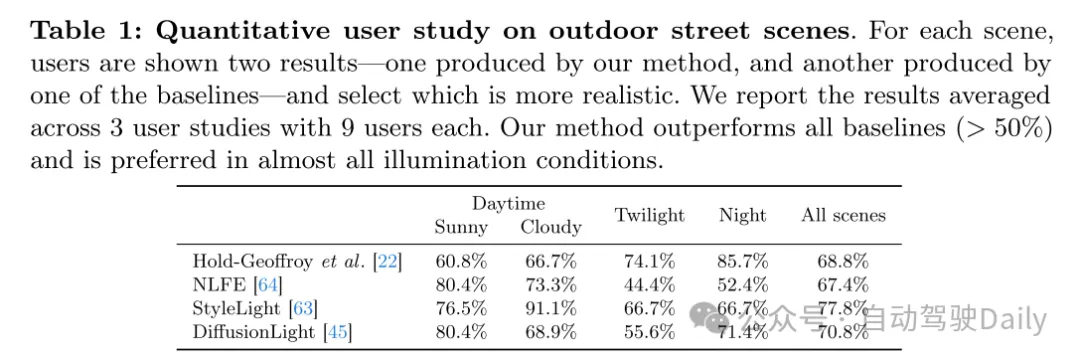

表1:户外街景的定量用户研究。对于每个场景,用户会看到两个结果——一个是由本文的方法生成的,另一个是由基线方法生成的——并选择哪个更逼真。本文报告了在3组用户研究中,每组9名用户的平均结果。本文的方法在所有基线方法中表现更好(> 50%),并且在几乎所有光照条件下都更受欢迎。

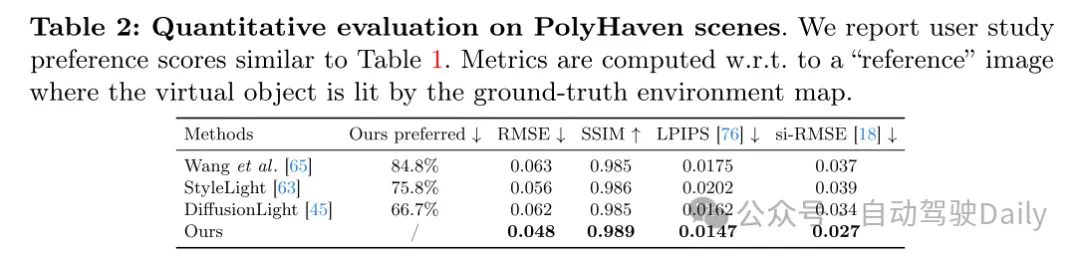

表2:PolyHaven场景的定量评估。本文报告了类似于表1的用户研究偏好评分。度量值是相对于“参考”图像计算的,其中虚拟物体由真实环境贴图照亮。

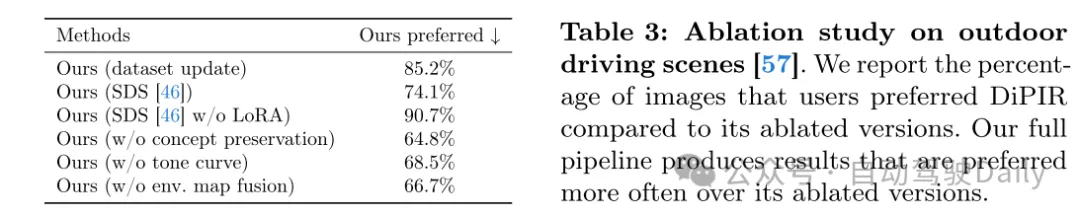

表3:户外驾驶场景的消融研究 [57]。本文报告了用户更喜欢DiPIR相对于其消融版本的图像百分比。本文的完整流程生成的结果比其消融版本更受用户青睐。

应用:

由于本文的方法恢复了基于物理的光照信息,因此在优化后可以插入任意新的虚拟物体,如图2所示。DiPIR还可以优化其他场景属性,如材质和局部光照。本文在这一方向进行了初步实验。

材质优化。结合可微渲染,DMs(扩散模型)可以为材质属性提供引导信号,如图7所示。给定一个纯漫反射的汽车,并将金属度和粗糙度属性设为可优化参数,扩散引导可以优化并使汽车看起来更加闪亮。通过将文本提示更改为“一辆胭脂红的汽车”,并将汽车的基色设为可优化参数,本文展示了DM可以将文本条件传播到PBR(基于物理渲染)属性并将汽车颜色更改为红色。当将局部发光设为可优化参数时,扩散模型还可以在夜间场景中打开汽车的大灯。

色调映射调整。本文通过一个控制实验进一步评估DMs(扩散模型)对色调映射的理解能力。如图7所示,本文固定估算的环境贴图,并对背景图像应用手动色调调整。通过扩散引导来优化色调曲线,使插入的物体在最终合成结果中与周围背景相匹配。

总结:

本文的方法利用了大型扩散模型固有的场景理解能力,作为物理基础逆向渲染流程的指导。本文设计了一种具有场景特定个性化的扩散引导信号,并结合可微的逆向渲染流程来恢复光照和色调映射参数。本文的方法不仅能够将虚拟物体插入场景中,还可以优化其他场景参数,例如插入物体的材质或解决相机之间的色调映射不匹配问题。本文相信,这种将可微渲染过程与数据驱动的先验知识相结合的方法,可以成功应用于许多其他内容创作领域,如重新照明和动画制作。

局限性和未来工作。本文的基于球面高斯函数的光照表示对于一般物体是足够的[35],但对于高度镜面反射的材料可能不够真实。对于更复杂的光照表示,添加环境贴图上的生成先验[41]是一个值得探索的方向。渲染公式可以扩展,以考虑场景本身对插入物体的反射效果(例如颜色渗透),但这可能会引入更多的不确定性,并需要了解代理几何体的材料(参见补充材料C.4中的失败案例)。最后,虽然DM个性化显著提高了结果的质量,但它增加了流程的开销和复杂性。最近的一些个性化方法不需要测试时微调[54],可以用来减轻这一负担。