编辑 | 言征

出品 | 51CTO技术栈(微信号:blog51cto)

OpenAI终于又Open了一把!开发者可以免费定制自己的GPT-4o了!

当地时间8月20日,OpenAI 推出了GPT-4o微调功能,截至9月23日,所有开发者都可以使用自定义的数据集对GPT-4o进行微调,满足特定用例的需求。

具体而言,这项微调功能可以通过一个小型数据集(小到几十个示例),就能使模型能够自定义响应的结构和语气,或遵循复杂的特定领域指令,

1.首批尝鲜的定制者们

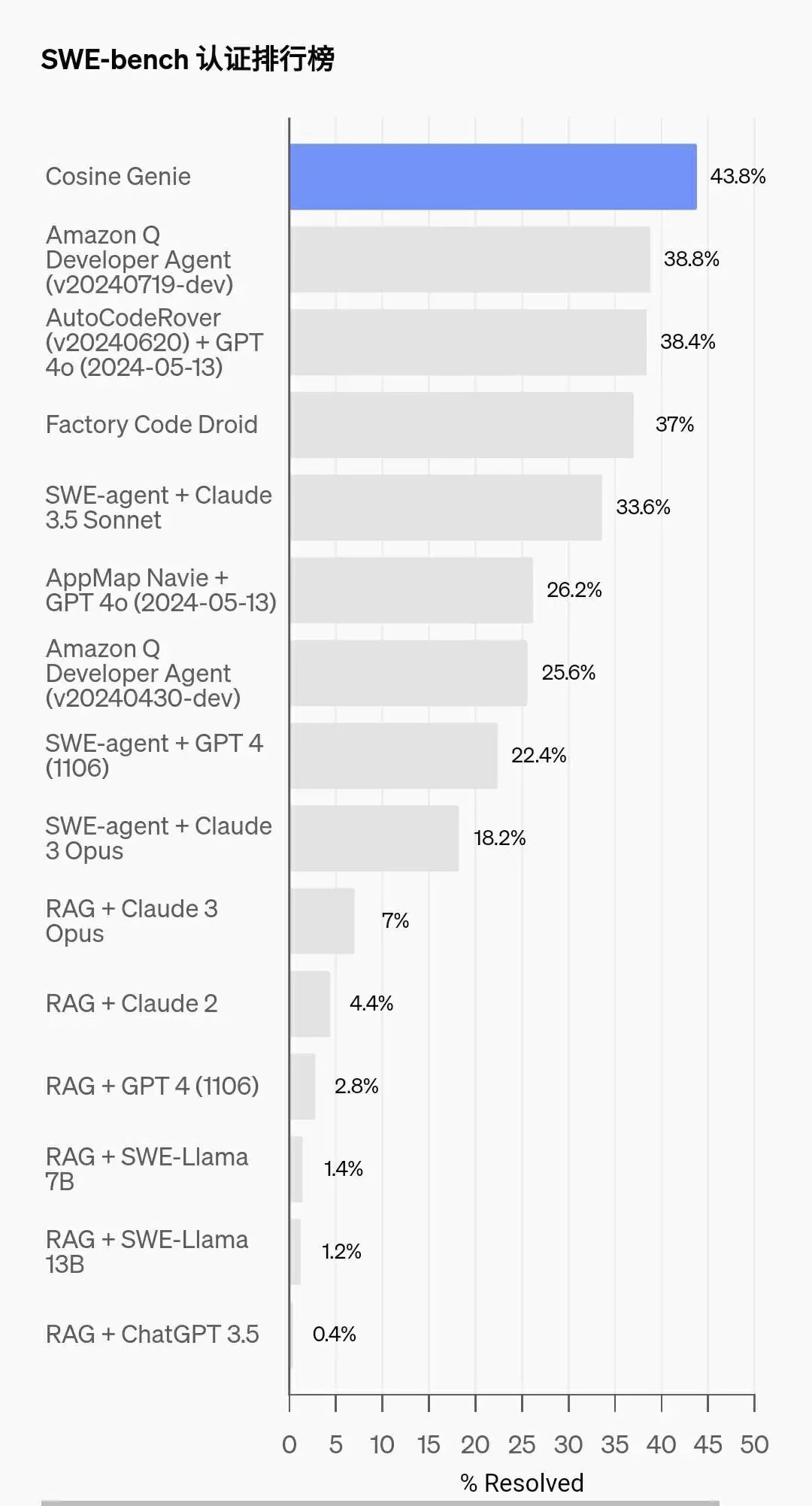

OpenAI的合作伙伴Cosine推出了AI软件工程助手Genie,可以帮自主识别和解决错误,构建和重构代码。它可以推理复杂的技术问题,并以更高的准确度和更少的token更改代码。

这里的Genie就是借助了微调后的GPT-4o的模型,并且Genie在SWE-bench测评榜上获得了SOTA的水平,位列第一。

图片

图片

text to SQL 也是业内一个很热的例子,Distyl也是通过微调GPT-4o的微调夺得了该领域BIRD-SQL的基准测试的第一名,执行准确率高达71.83%,除了在SQL生成方面一骑绝尘,同时在查询重构、意图分类、思维链和自我修正等任务重表现出色。

2.如何操作?

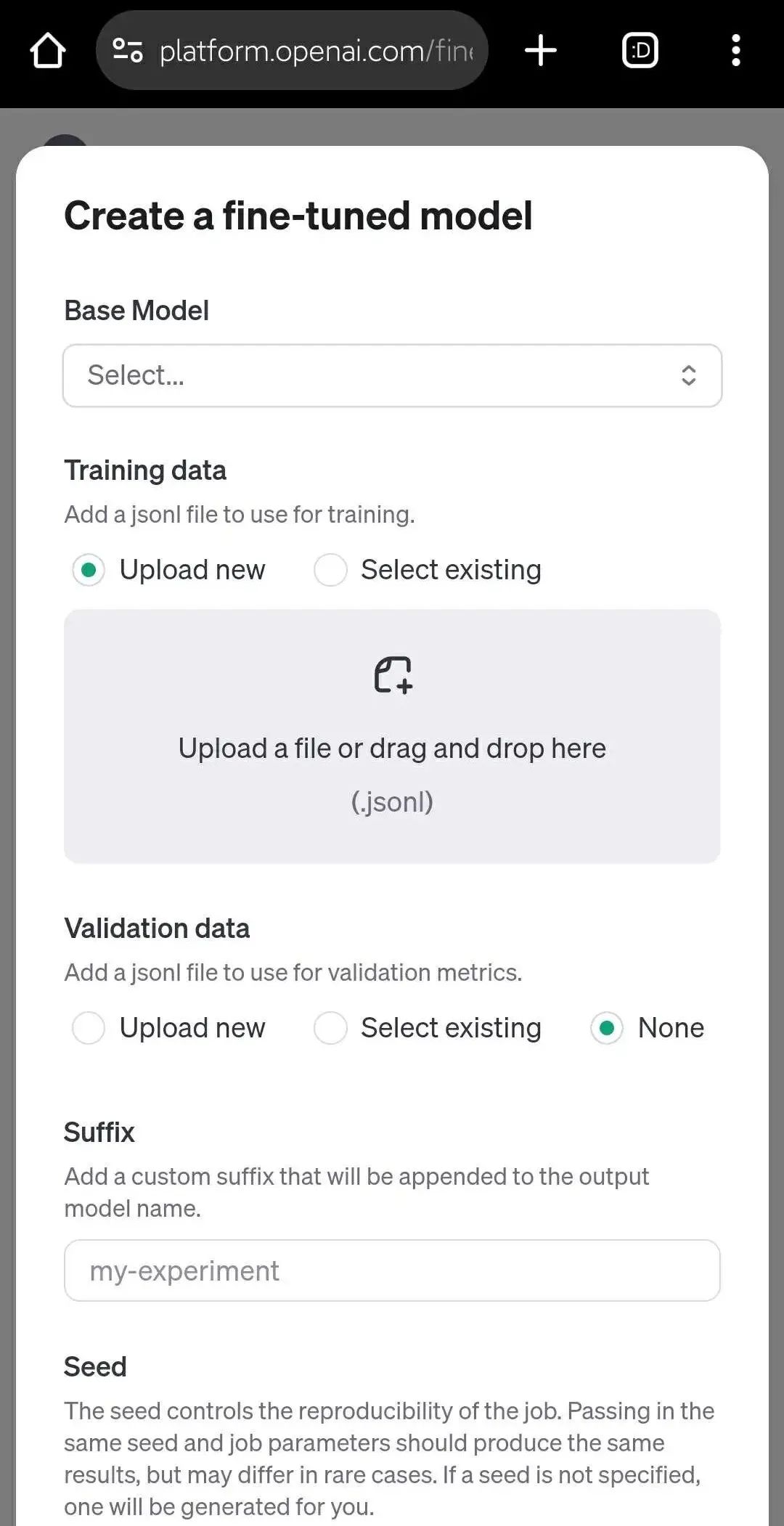

对新功能感兴趣的开发人员可以访问 OpenAI 的微调仪表板,单击“创建”,然后 gpt-4o-2024-08-06 从基础模型下拉菜单中进行选择。

图片

图片

不到一个月前,该公司允许开发人员对该模型的更小、更快、更便宜的版本 GPT-4o mini 进行微调,但它的功能不如完整版 GPT-4o。

OpenAI 技术人员 John Allard 和 Steven Heidel 在公司官方网站的博客文章中表示:“从编码到创意写作,微调可以对各个领域的模型性能产生巨大影响。”

3.即日起至 9 月 23 日提供免费tokens

OpenAI指出,开发人员仅使用训练数据中的几十个示例就能取得很好的效果。

为了启动这项新功能,OpenAI 将每天免费提供最多 100 万个tokens,供任何第三方组织(客户)用于微调 GPT-4o,截至 2024 年 9 月 23 日。

众所周知,tokens实际上就像 AI 模型的“母语”一样发挥作用,并且是 OpenAI 和其他模型提供商用来确定模型摄取(输入)或提供(输出)信息量的测量方法。

开发人员/客户对 LLM 或 LMM(例如 GPT-4o)进行微调前,需要将与组织、团队或个人用例相关的数据转换为它可以理解的tokens,即对其进行标记化,OpenAI 的微调工具提供这些功能。

然而,这是有代价的:通常对 GPT-4o 进行微调每 100 万个令牌的成本为 25 美元,而运行微调版本的推理/生产模型的成本为每百万个输入tokens3.75 美元,每百万个输出tokens 15 美元。

对于使用较小的 GPT-4o mini模型的用户,截至 9 月 23 日,每天有 200 万个免费训练tokens可用。

此项服务扩展到所有付费使用层的开发人员,确保广泛使用微调功能。

有媒体分析,OpenAI此举也是日益激烈的竞争环境中做出的决策,毕竟谷歌、Anthropic等其他闭源供应商,Nous Research 推出的Meta Llama3.1的新变体Hermes3等都纷纷打起了价格战。

不过,OpenAI有着自己独特的优势,开发人员可以不必再费心思去托管推理、也不必去他们的自己搭建的服务器上进行训练。开发者如果有需要,甚至可以将他们喜欢的服务器链接到OpenAI的API上。

4.微调是否会带来新的数据安全问题

OpenAI 强调,即使为开发人员扩展了定制选项,安全性和数据隐私仍然是首要任务。经过微调的模型可以完全控制业务数据,并且不存在输入或输出被用于训练其他模型的风险。

此外,该公司还实施了分层安全缓解措施,包括自动评估和使用情况监控,以确保应用程序遵守 OpenAI 的使用政策。

然而,研究表明,微调模型可能会导致它们偏离护栏和保障措施,并降低其整体性能。组织是否认为值得冒险取决于他们自己——然而,OpenAI 显然认为值得,并鼓励他们将微调视为一个不错的选择。

5.这只是一个开始

事实上,早在 4 月份,OpenAI 宣布为开发人员提供新的微调工具(例如基于 epoch 的检查点创建)时就表示,“我们相信,未来绝大多数组织将开发针对其行业、业务或用例个性化的定制模型。”

今天发布的全新 GPT-4o 微调功能凸显了 OpenAI 对这一愿景的持续承诺:每个组织都有自己的定制 AI 模型的世界。

正如OpenAI 官方博客中所说的:“这只是一个开始——我们将继续投资扩大 开发人员的模型定制 选项。”