爆火神经网络架构KAN,上新了!

KAN2.0。

此次与科学问题更深入地融合,可以轻松解出经典物理学研究。

比如发现拉格朗日量(用来描述整个物理系统动力状态的函数)

图片

图片

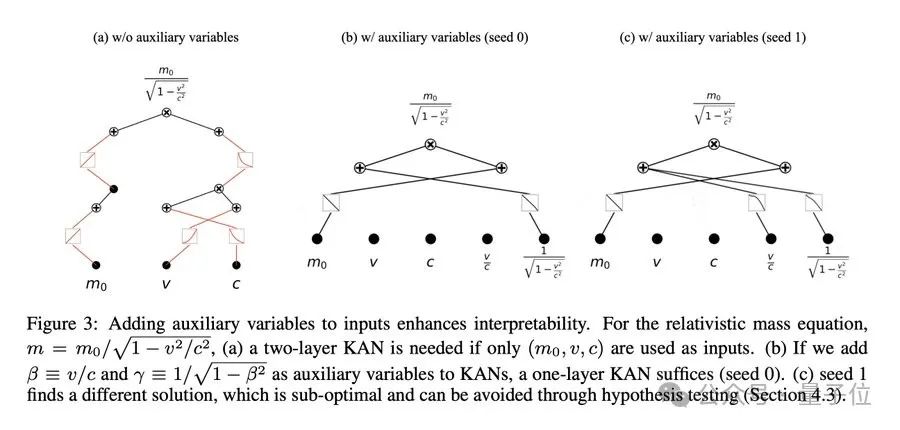

除此之外,研究者还可以量身定制属于自己的KAN2.0,将专业知识作为辅助变量添加到输入当中去。

此前,KAN横空出世,一夜引爆科技圈。它以200万参数模型架构,直接复现DeepMind用30万参数的MLPs发现数学定理的研究。要知道,后者可是登上Nature封面的研究。

由于KAN性能太好,一度引来关于「能否替代掉Transformer的MLP层」的探讨,大家直呼:Yes We KAN!

MIT博士生刘子鸣再次为论文一作。

图片

图片

业内学者们,纷纷赶来祝贺。

图片

图片

图片

图片

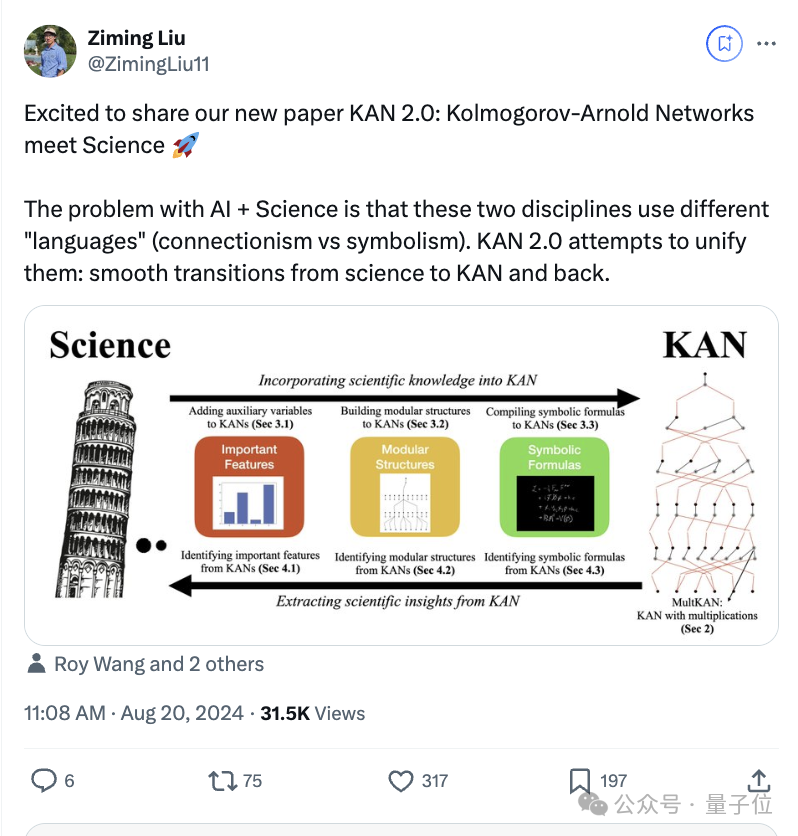

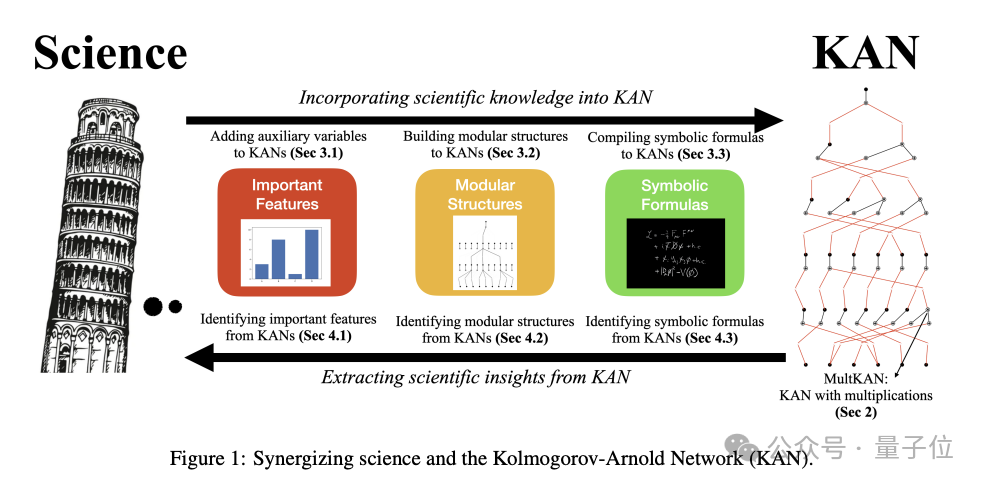

KAN2.0将AI与科学统一起来

AI+科学的一大挑战在于他们之间固有的不兼容性:当前AI主要基于连接主义,科学则依赖于符号主义。

此次新框架KAN2.0就主打将KANs同科学无缝协同,这种协同作用是双向的:科学到 KAN(将科学知识融入 KAN),KAN到科学(从KAN中提取科学见解)。

图片

图片

更具体来说,KAN2.0对科学发现主要有三个方面的作用,从简单粗略到逐渐精细复杂:

识别重要特征、揭示模块结构、发现符号公式。

在原始KAN基础上主要引入了这三个新功能。

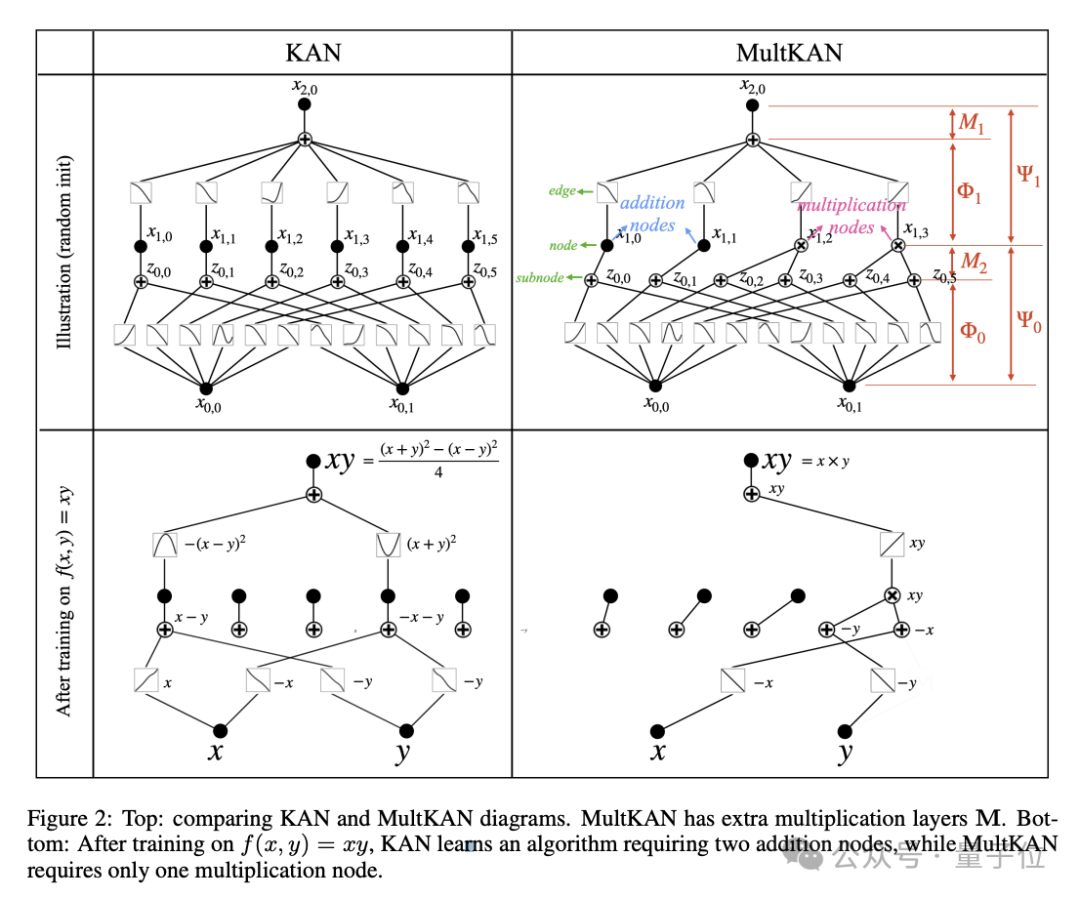

1、MultKAN:带有乘法节点的 KAN。

图片

图片

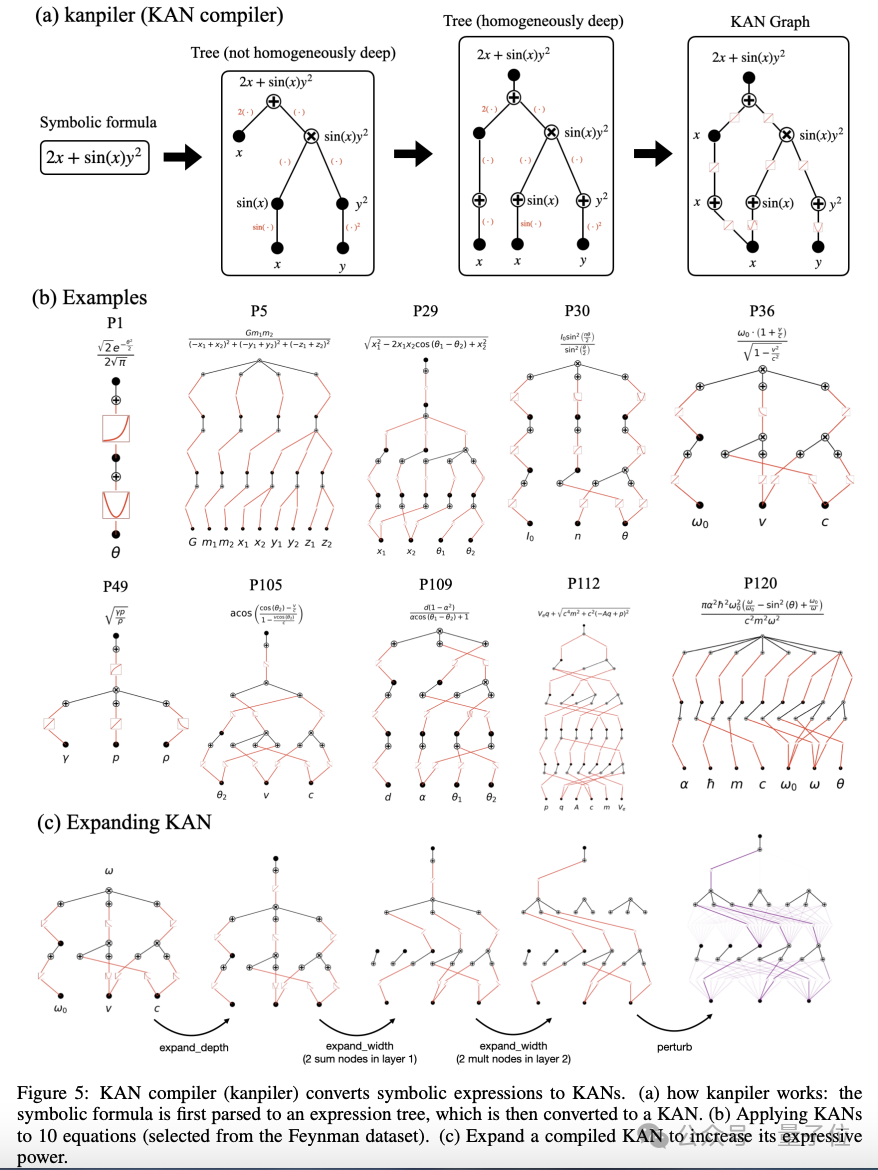

2、kanpiler:将符号公式编译成 KAN的编译器。

图片

图片

3、树转化器,将 KAN2.0架构(或任何神经网络)转换为树状图。

图片

图片

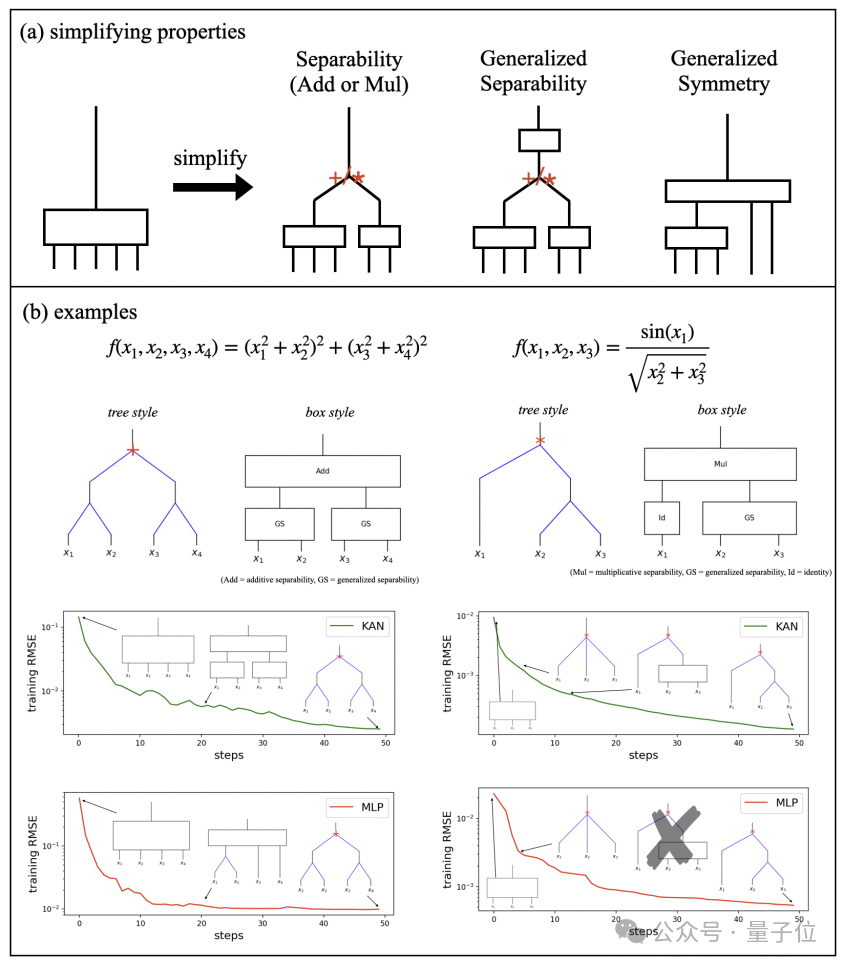

跟上一版本相比,KAN2.0的解释性更通用,比如像化学、生物学等这种很难用符号方程表示的,模块化结构和关键特征能够来描述。

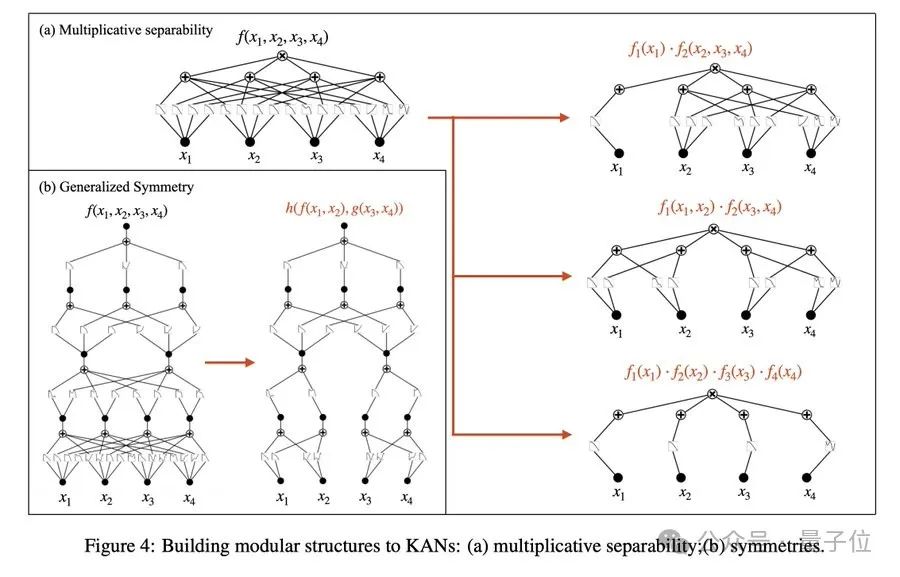

比如,用户可以将模块化结构构建到KAN2.0中。

图片

图片

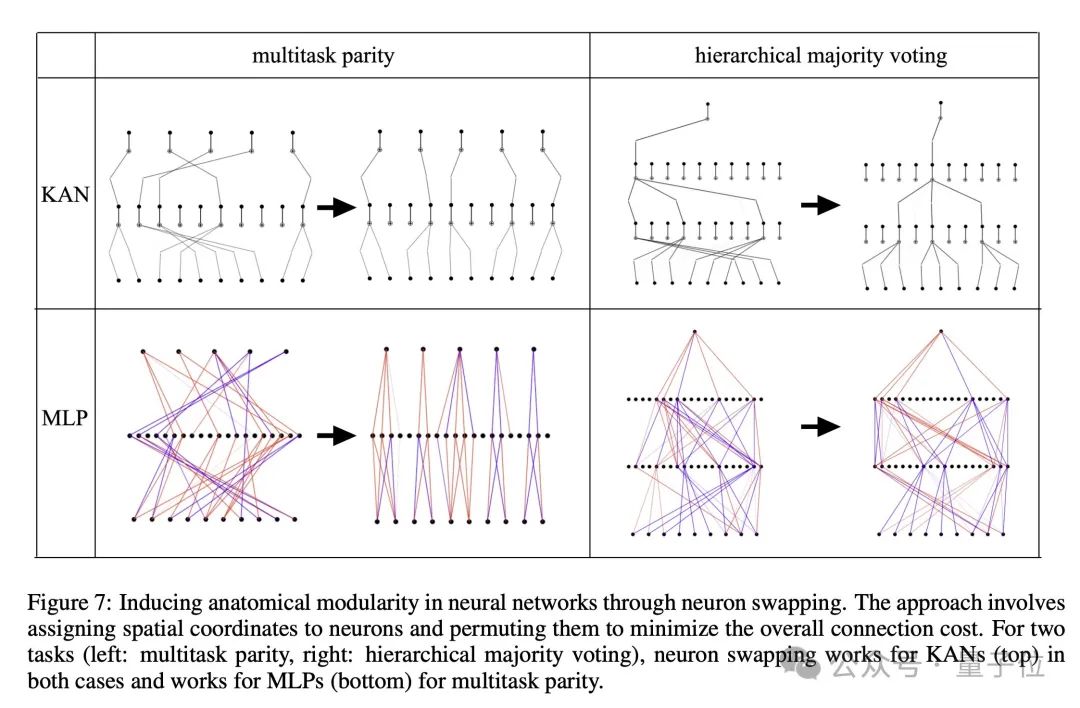

再通过KAN2.0同MLP神经元交换,就可以直接看到模块化结构。

图片

图片

此外,团队探究了如何将先验知识融入KAN2.0。

图片

图片

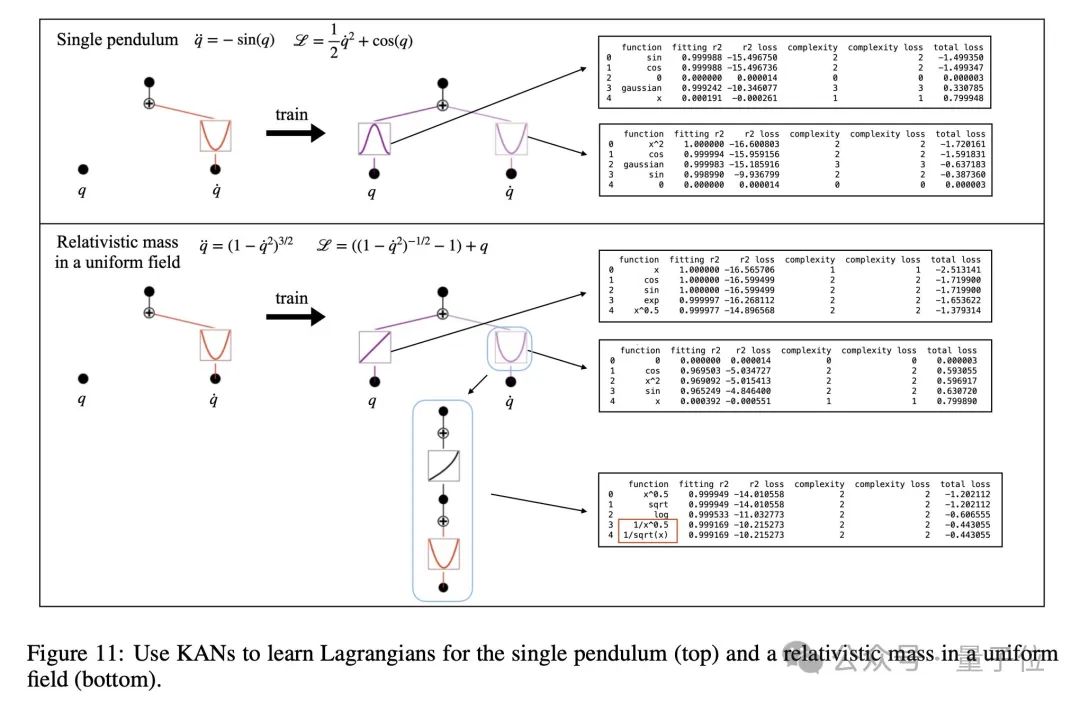

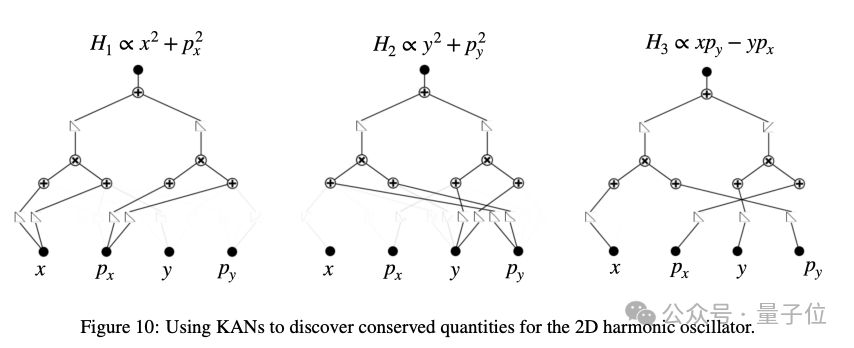

基于这些更新,团队展示了KAN2.0发现各种经典物理定律的能力。

比如发现二维谐振子的守恒量。

图片

图片

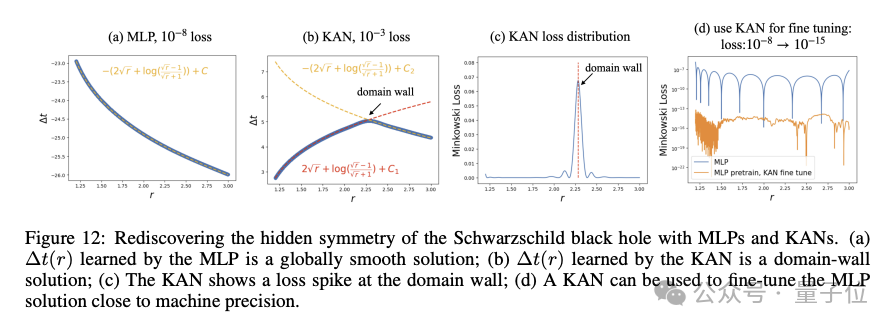

利用MLP和KAN2.0重新发现史瓦西黑洞的隐藏对称性。

图片

图片

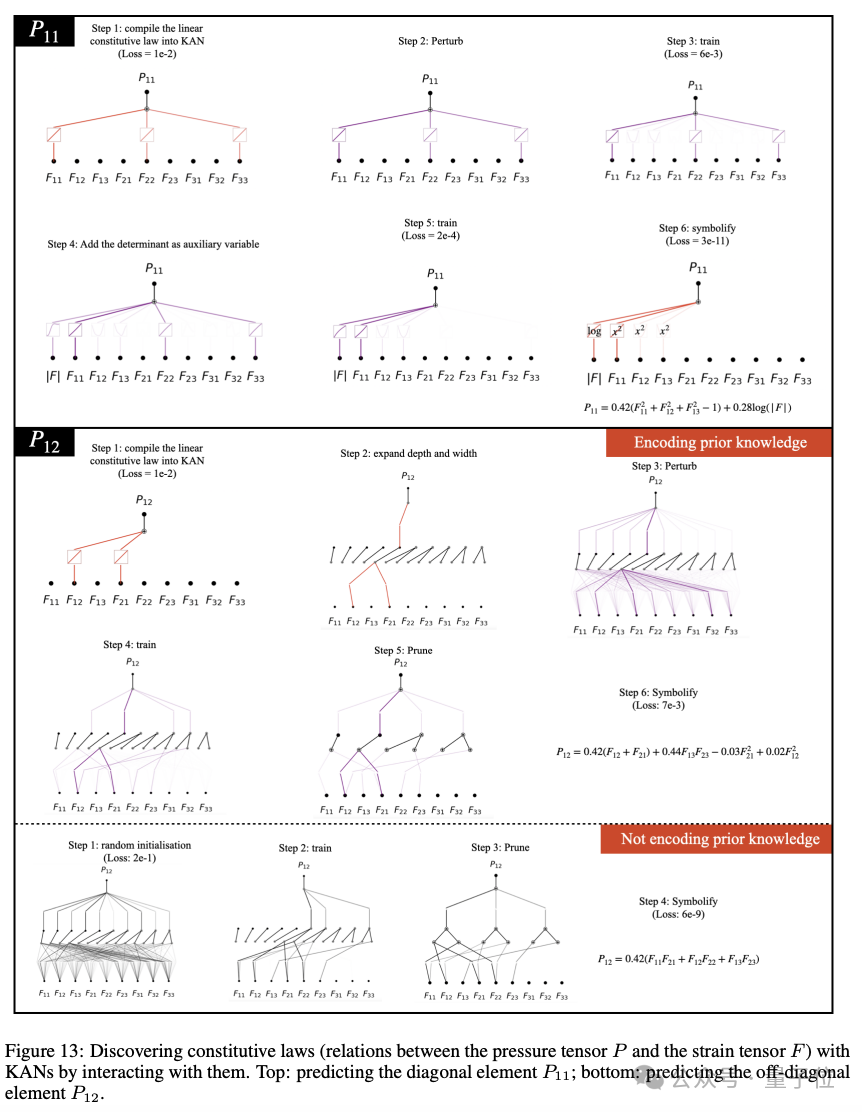

还有像通过与KAN2.0交互,发现构造定律。

图片

图片

接下来,团队有两个方向:一是将该框架应用于更大规模的问题;二是将其扩展到物理学以外的其他科学学科。

MIT华人一作

此次研究来自MIT、加州理工学院、MIT CSAIL等机构的五位研究者,共有三位华人。

图片

图片

相比于KAN初始版本,还有不少原班人马,其中MIT刘子鸣依然为一作。

图片

图片

刘子鸣目前是MIT四年级博士生,Max Tegmark是他的导师,其研究兴趣在于人工智能与物理学的交叉领域,具体像AI科学家、物理学启发的深度学习、深度学习科学、机械可解释性等。

由于KAN受到广泛的关注,作为核心作者,他在GitHub页面上特意注明,在设计KAN并编写代码的时候,考虑的是数学和物理示例(规模相当小!)因此没有考虑到效率而可重用性方面的优化。

对于专注机器学习的用户,他坦言,KAN可能还不是个可以开箱即用的简单插件(目前还不是)。

KAN和MLP不能互相取代,他们在某些情况下各有优势,在其他情况下也有局限性。

图片

图片