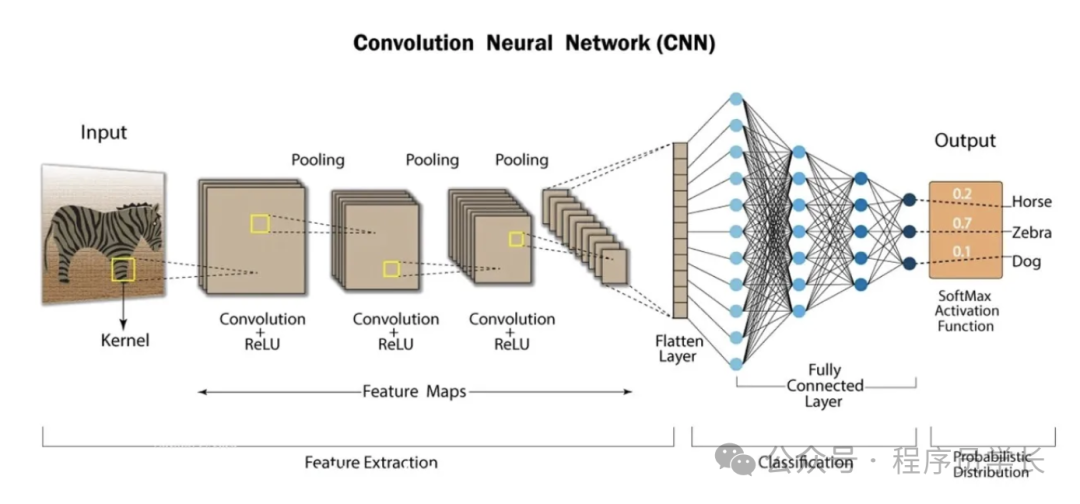

卷积神经网络(Convolutional Neural Network, CNN)是一类特别适合处理图像数据的深度学习模型。它们通过模拟生物视觉系统的处理方式,能够自动学习和提取图像中的特征。

大家好,我是小寒

今天给大家介绍一个强大的算法模型,CNN

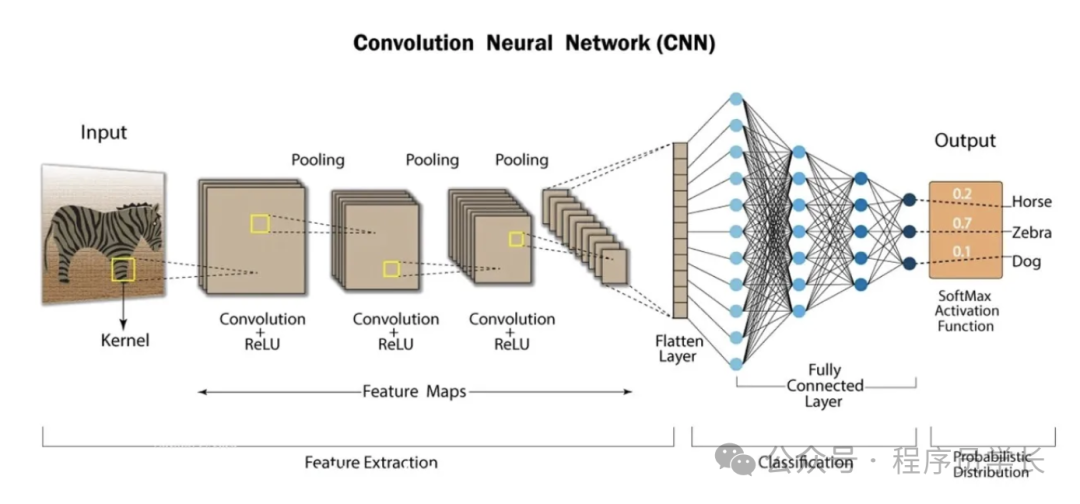

卷积神经网络(Convolutional Neural Network, CNN)是一类特别适合处理图像数据的深度学习模型。它们通过模拟生物视觉系统的处理方式,能够自动学习和提取图像中的特征。

CNN 由一系列层组成,每层都旨在从输入数据中提取越来越复杂的特征,使其非常适合图像分类、对象检测和图像生成等任务。

图片

图片

CNN 的核心组件

CNN 主要由卷积层(Convolutional Layer)、池化层(Pooling Layer)和全连接层(Fully Connected Layer)构成。

1.卷积层

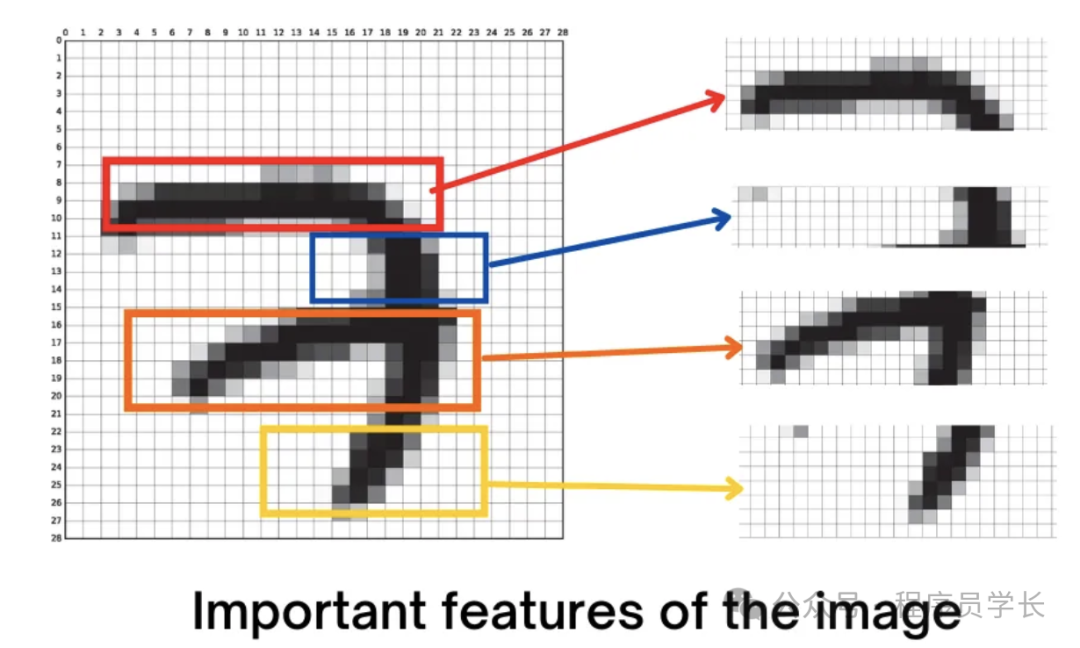

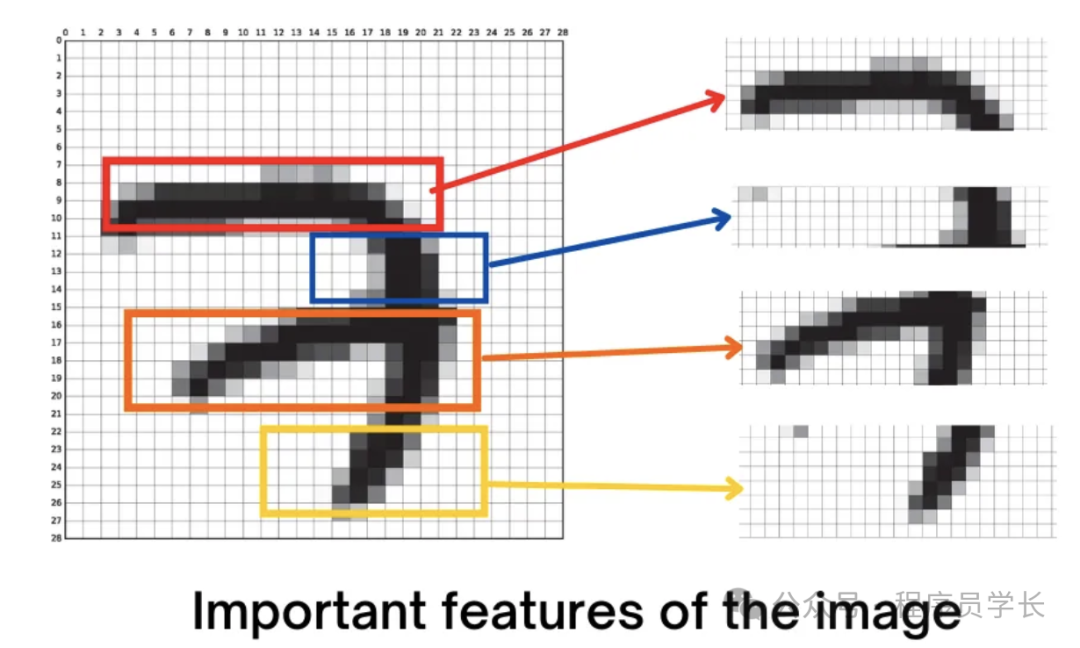

卷积层是 CNN 的核心组件,用于从输入数据中提取局部特征。

它通过卷积操作,将一个小的滤波器(或卷积核)应用到输入图像的不同区域,以捕捉局部的空间特征。

每个卷积核在输入数据上滑动,并计算其与输入数据的局部区域的点积,这个操作生成一个特征图(Feature Map)。

图片

图片

1.1 过滤器/卷积核

过滤器/卷积核是检测输入数据中特定特征(如边缘、纹理或图案)的小矩阵。

网络在训练期间学习这些过滤器,每个过滤器负责检测不同的特征。

图片

图片

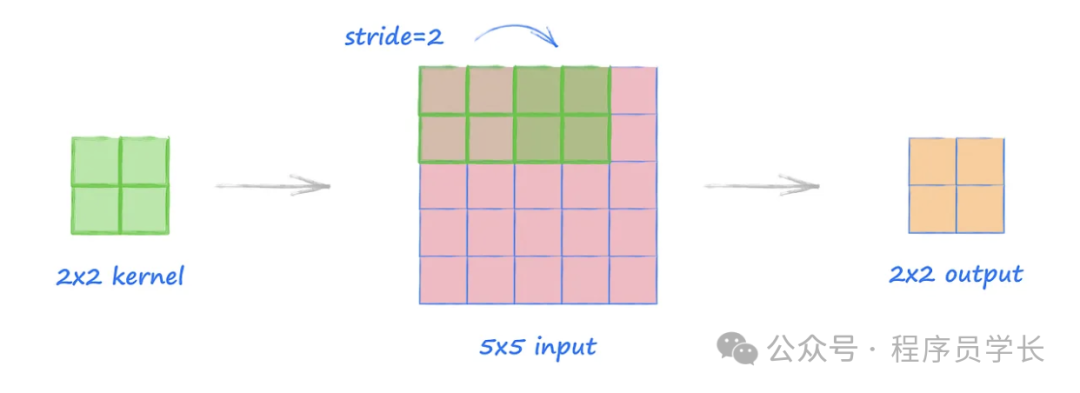

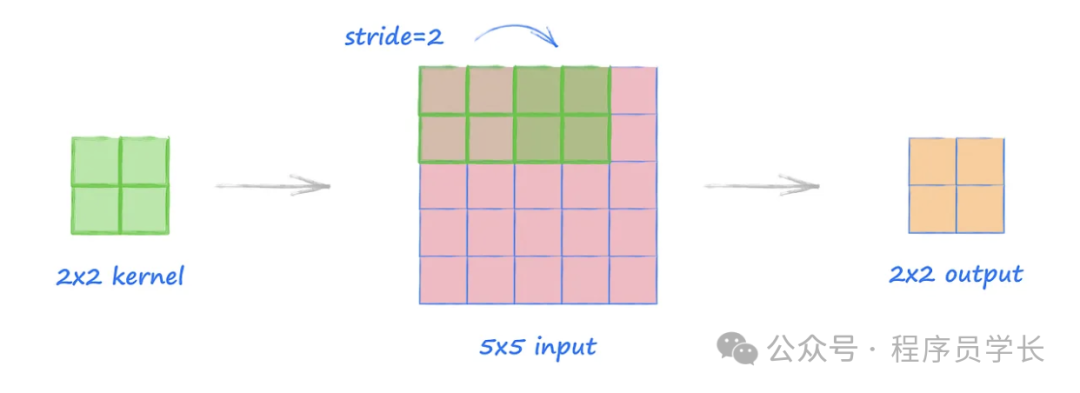

1.2 步幅

卷积核在输入图像上移动的步长。步幅为 1 表示卷积核每次移动一个像素。

2.池化层

池化层用于对特征图进行下采样,减少特征图的尺寸,从而降低计算量和减少过拟合。

池化操作通常选择局部区域的最大值(最大池化)或平均值(平均池化),从而减少信息冗余。

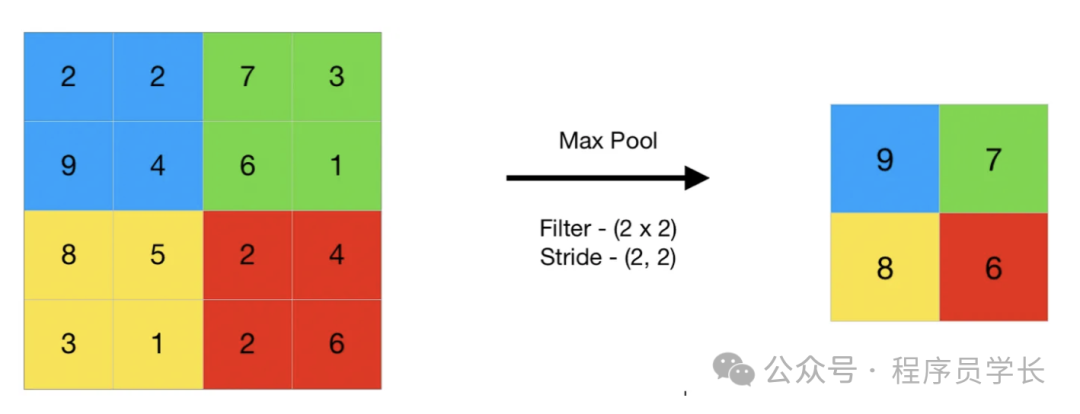

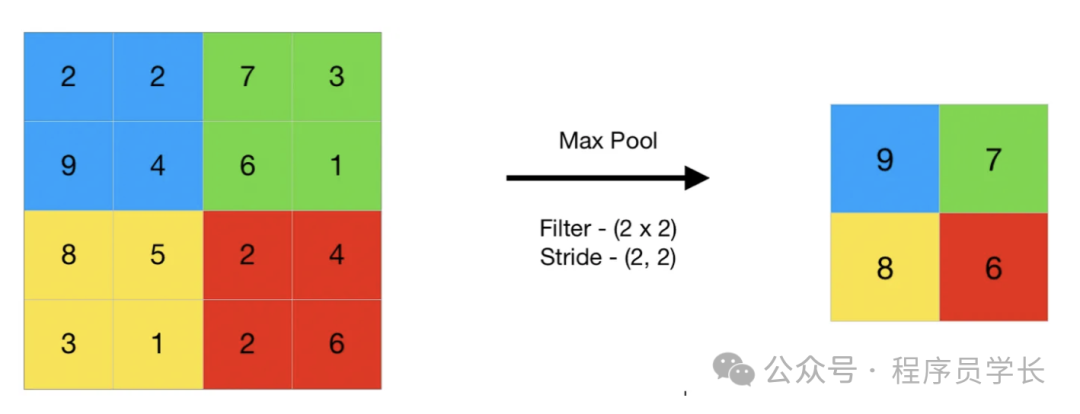

2.1 最大池化

最大池化是一种提取局部区域中最显著特征的操作。

在一个指定大小的池化窗口内,最大池化保留该区域中最大的数值,而忽略其他数值。

最大池化的效果是保留重要特征(如边缘、亮度等),同时减少数据的维度。

图片

图片

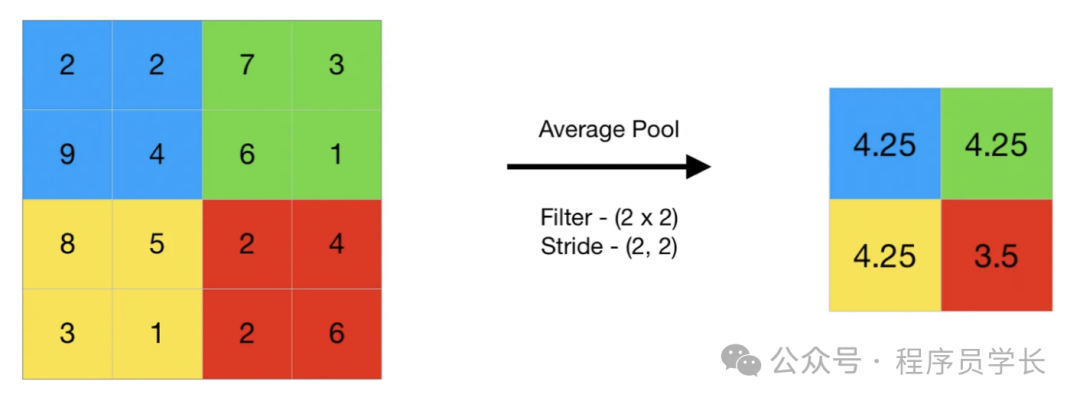

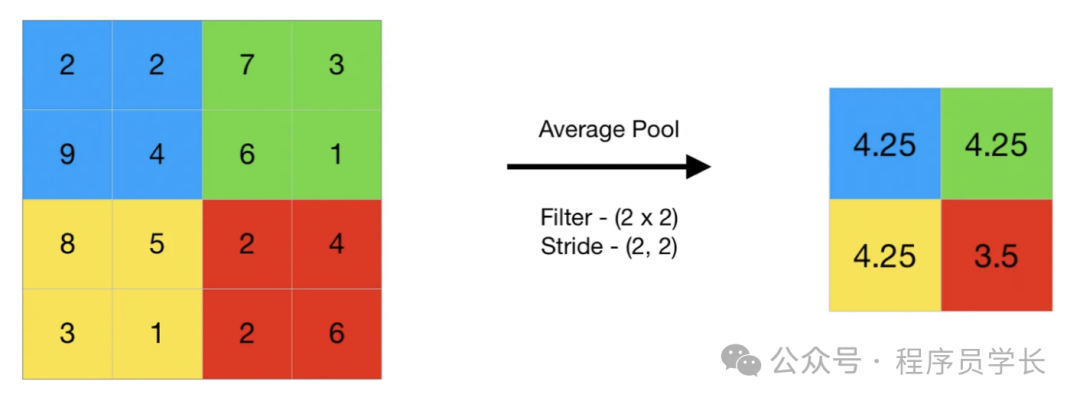

2.2 平均池化

另一方面,平均池化是对池化窗口内的所有值取平均值,从而得到一个代表性数值。

与最大池化不同,平均池化保留了池化窗口内所有数值的信息,这使得它在某些应用中可以捕捉到更多的上下文信息。

图片

图片

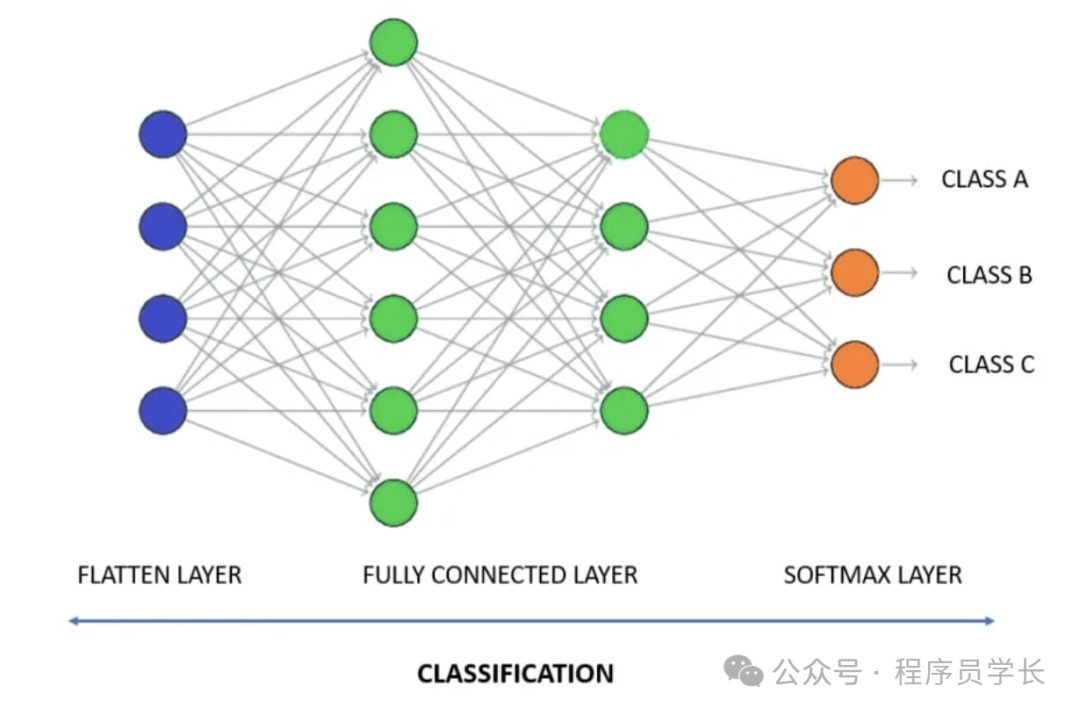

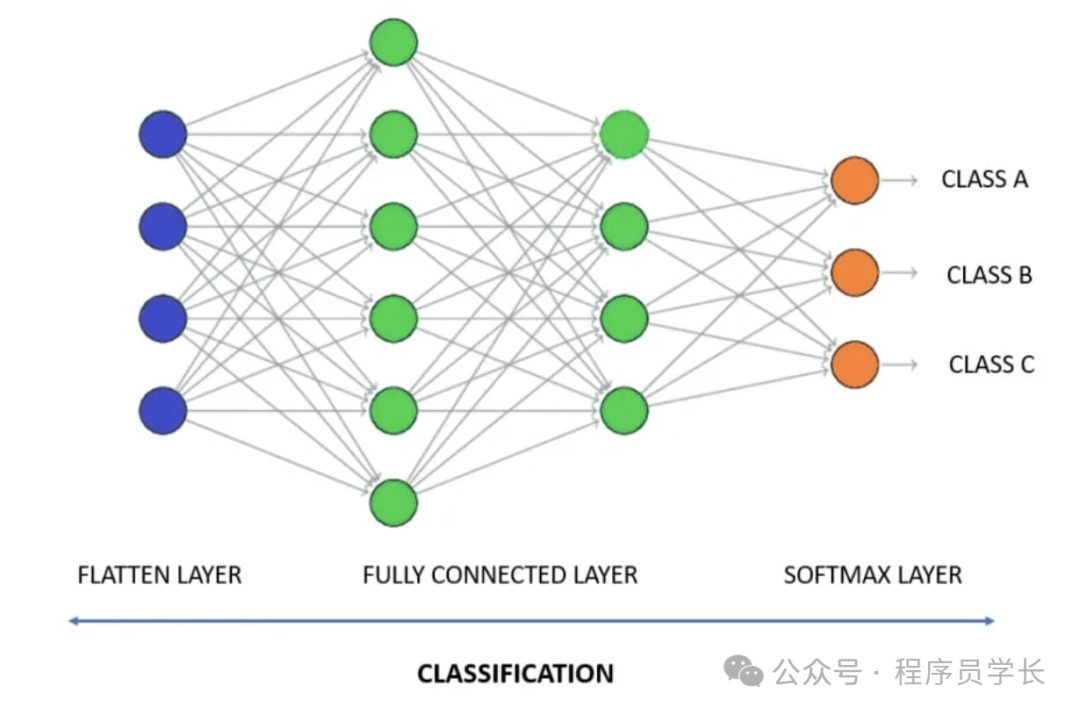

3.全连接层

全连接层是卷积神经网络的重要组成部分,它将前一层(通常是卷积层或池化层)的输出展平成一维向量,然后通过线性变换和激活函数进行处理。

全连接层的每个神经元与前一层的所有神经元相连接,因此称为“全连接”。

全连接层的主要作用是将前面提取到的特征进行进一步组合和处理,从而得出最终的输出(如分类结果)。

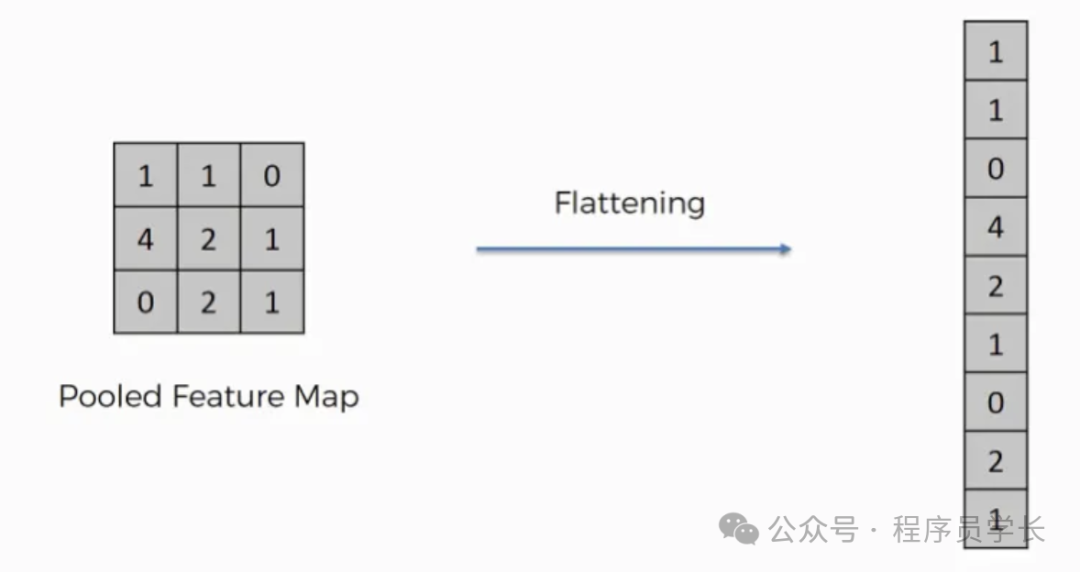

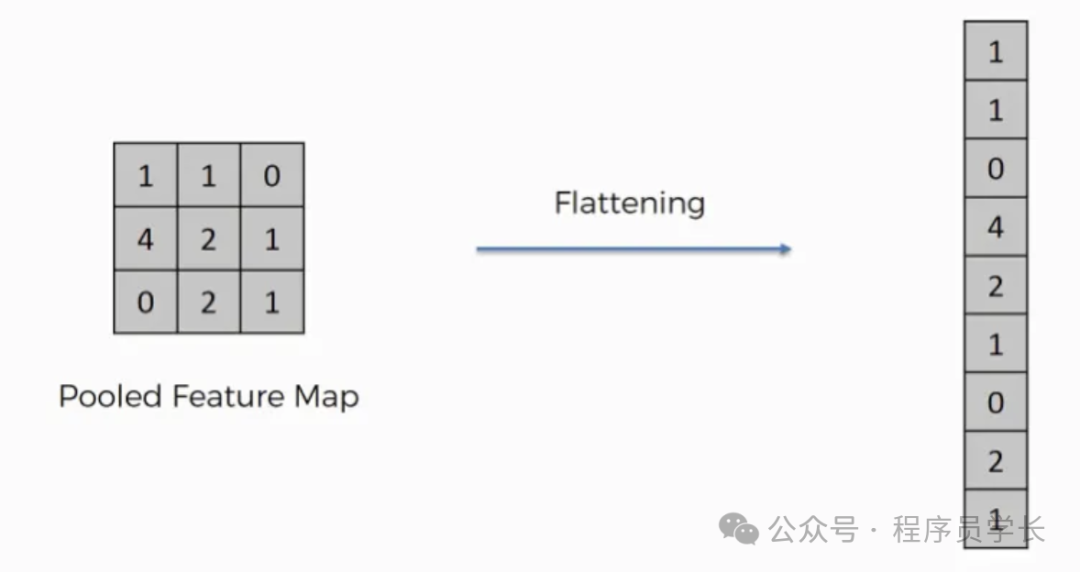

3.1 扁平化

扁平化将二维或三维特征图转换为一维向量,从而可以将卷积层和池化层连接到全连接层。

图片

图片

3.2 全连接层

全连接层通过处理卷积层和池化层提取的特征来执行最终的分类或回归任务。

图片

图片

案例分享

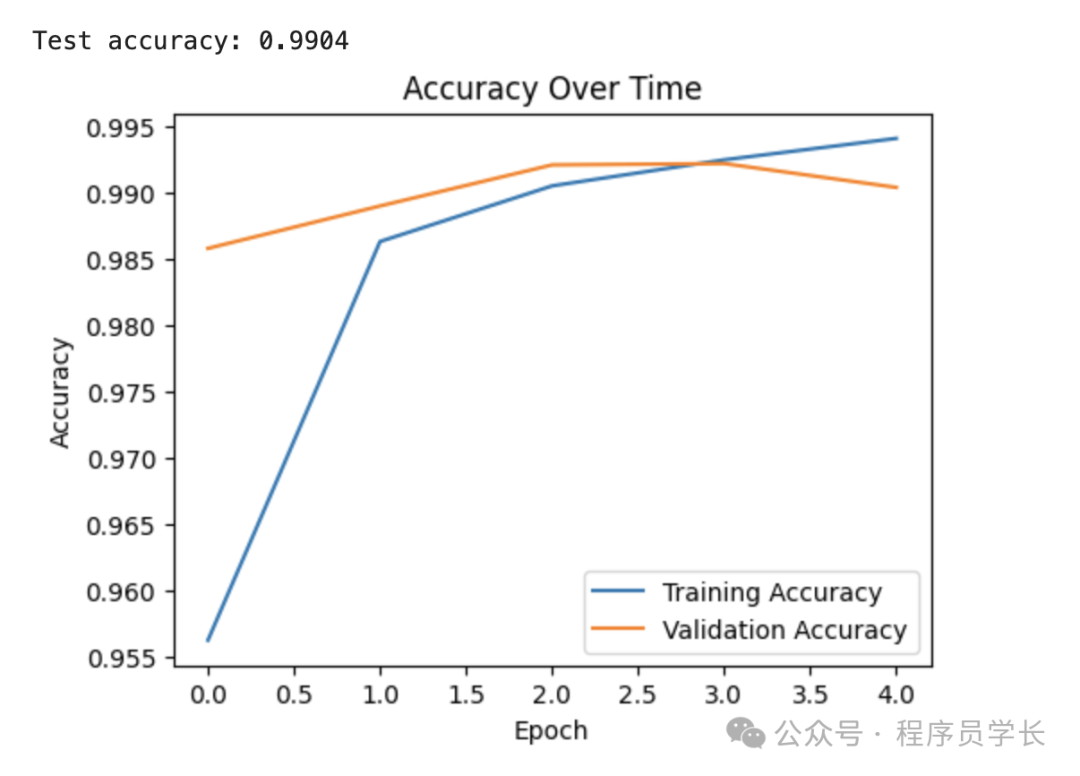

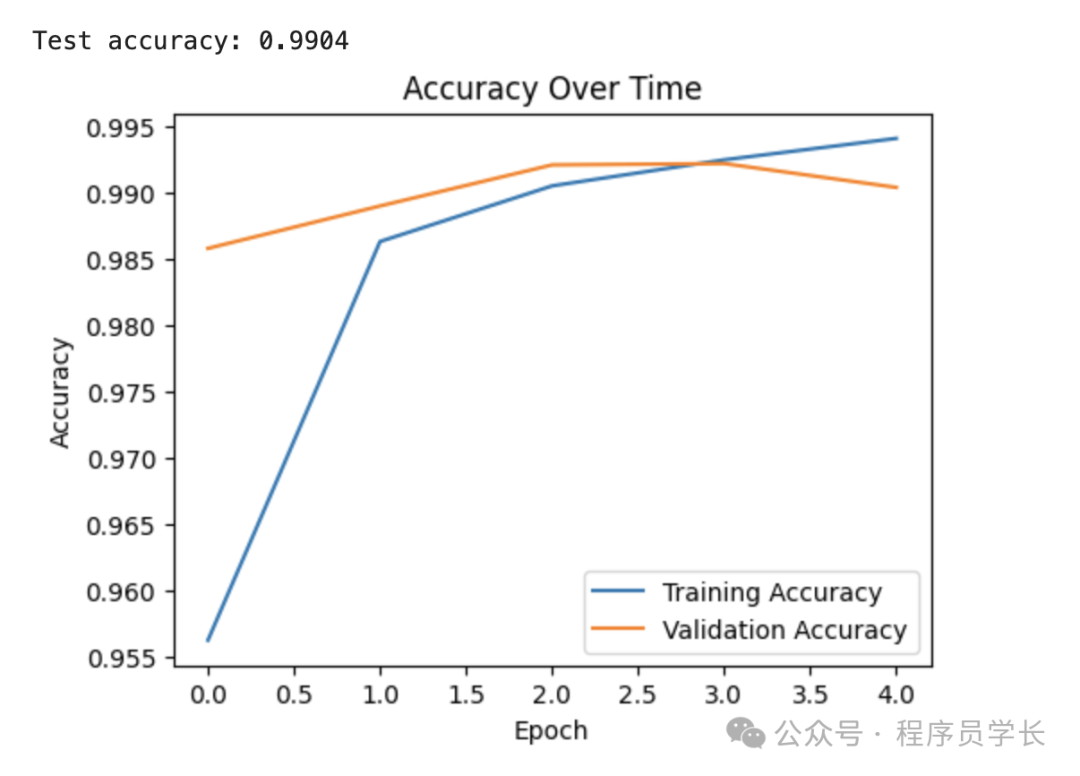

下面是一个使用卷积神经网络(CNN)进行手写数字识别的案例代码。

import tensorflow as tf

from tensorflow.keras import datasets, layers, models

import matplotlib.pyplot as plt

# 加载 MNIST 数据集

(train_images, train_labels), (test_images, test_labels) = datasets.mnist.load_data()

train_images, test_images = train_images / 255.0, test_images / 255.0

train_images = train_images.reshape((train_images.shape[0], 28, 28, 1))

test_images = test_images.reshape((test_images.shape[0], 28, 28, 1))

# 构建 CNN 模型

model = models.Sequential([

layers.Conv2D(32, (3, 3), activatinotallow='relu', input_shape=(28, 28, 1)),

layers.MaxPooling2D((2, 2)),

layers.Conv2D(64, (3, 3), activatinotallow='relu'),

layers.MaxPooling2D((2, 2)),

layers.Conv2D(64, (3, 3), activatinotallow='relu'),

layers.Flatten(),

layers.Dense(64, activatinotallow='relu'),

layers.Dense(10, activatinotallow='softmax')

])

# 编译模型

model.compile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

# 训练模型

history = model.fit(train_images, train_labels, epochs=5,

validation_data=(test_images, test_labels))

# 评估模型

test_loss, test_acc = model.evaluate(test_images, test_labels, verbose=2)

print(f'\nTest accuracy: {test_acc:.4f}')

# 绘制训练过程中的准确率

plt.figure(figsize=(12, 4))

plt.subplot(1, 2, 1)

plt.plot(history.history['accuracy'], label='Training Accuracy')

plt.plot(history.history['val_accuracy'], label='Validation Accuracy')

plt.xlabel('Epoch')

plt.ylabel('Accuracy')

plt.legend()

plt.title('Accuracy Over Time')

plt.show()

- 1.

- 2.

- 3.

- 4.

- 5.

- 6.

- 7.

- 8.

- 9.

- 10.

- 11.

- 12.

- 13.

- 14.

- 15.

- 16.

- 17.

- 18.

- 19.

- 20.

- 21.

- 22.

- 23.

- 24.

- 25.

- 26.

- 27.

- 28.

- 29.

- 30.

- 31.

- 32.

- 33.

- 34.

- 35.

- 36.

- 37.

- 38.

- 39.

- 40.

- 41.

- 42.

- 43.

- 44.

- 45.

- 46.

图片

图片

图片

图片 图片

图片 图片

图片

图片

图片 图片

图片 图片

图片 图片

图片 图片

图片