本文经自动驾驶之心公众号授权转载,转载请联系出处。

数据的收集、标注和整理过程既耗时又昂贵是自动驾驶技术发展不得不面对的问题。结合世界模型、扩散模型,来生成高质量的训练数据,为自动驾驶系统提供了更加真实和复杂的模拟环境。这种方法不仅降低了对真实世界数据集的依赖,还显著提高了数据生成的效率和多样性,为自动驾驶系统提供了更丰富的训练样本,使自动驾驶系统能够更好地适应各种复杂的交通场景,有助于提升其泛化能力和鲁棒性。

具体来说,近年来研究者多聚焦于如何让各种生成式技术各显神通,提升仿真各环节的“能力上限”。如:

1)基于世界模型生成高质量的驾驶视频和驾驶策略,在仿真环境中模拟各种复杂场景,提升系统的鲁棒性;

2)通过整合大语言模型,可以生成多视图的自动驾驶视频,充分考虑交通流、道路状况、行人行为等多种因素,实现定制化的交通模拟;

3)从原始传感器数据中提取特征,并生成自动驾驶的规划结果,实现生成式端到端自动驾驶……

4)加强自动驾驶系统的局部语义表示和图像推理能力,使得自动驾驶系统能够更好地理解交通场景中的语义信息,如交通标志、行人意图等,从而提升决策制定的准确性和安全性。

来看一些典型成果的分析。

DetDiffusion:协同生成模型和感知模型,以增强数据生成和感知

https://arxiv.org/abs/2403.13304

DetDiffusion是一个结合了生成模型和感知模型的框架,旨在提高数据生成和感知的性能。DetDiffusion的目标是通过感知信息增强图像生成质量,并促进下游感知任务的性能。模型通过在生成过程中提取和利用感知属性(Perception-Aware Attribute, P.A. Attr)来定制数据增强。感知属性为一种特殊的标记,通过预训练的检测器(如Faster R-CNN或YOLO系列)从图像中提取对象属性,属性包括类别、位置和检测难度,这些属性被设计为特殊的标记,以帮助扩散模型生成与感知模型训练目标更一致的图像。此外,模型通过分割引入了感知损失(Perception-Aware Loss, P.A. Loss),从而提高了质量和可控性。感知损失是一种新颖的损失函数,利用来自分割头的丰富视觉特征,以实现更精细的图像重建。它结合了掩码损失(mask loss)和dice损失,特别针对感知增强进行优化。

DetDiffusion的编码器使用预训练的Vector Quantized Variational AutoEncoder (VQ-VAE),将原始图像编码到潜在空间。文本编码器使用预训练的CLIP模型将文本条件编码。然后连接一个包含不同尺寸的resnet和transformer网络的UNet,用于生成过程,并通过交叉注意力机制整合条件变量。模型还基于UNet中间特征的分割模块引入分割头,用于生成对象掩码,与标签真实值结合以增强可控性。训练时,首先利用感知属性作为条件输入,通过感知损失进行监督,生成高质量的图像。然后通过优化模型的高维特征空间,使用感知信息进行更准确的图像合成。

结果显示,DetDiffusion在图像质量和与布局的一致性方面超越了现有的图像(L2I)模型,并且在目标检测任务中表现出色,显著提高了检测器的训练性能。生成的图像与真实图像在视觉上高度一致,展现了模型在图像生成方面的高保真度和准确性。

DriveDreamer:迈向真实世界的自动驾驶世界模型

https://arxiv.org/abs/2309.09777

DriveDreamer是一个为自动驾驶设计的现实世界驱动的世界模型,它能够生成高质量的驾驶视频和驾驶策略。DriveDreamer利用扩散模型(diffusion model)来构建对复杂环境的全面表示,它采用两阶段训练流程,首先让模型理解结构化交通约束,然后赋予模型预测未来状态的能力。第一阶段训练Auto-DM(Autonomous-driving Diffusion Model),用于模拟和理解真实世界驾驶视频。该阶段以结构化交通信息作为条件输入,包括高清地图(HDMap)和3D盒子(3D box),使用时间注意力层(temporal attention layers)增强生成视频帧的一致性。第二阶段训练ActionFormer,它是用于基于驾驶动作预测未来的交通结构条件。具体为利用门控循环单元(GRU)迭代预测未来的隐藏状态,这些状态随后被解码成未来的交通结构条件。

DriveDreamer模型包括一个条件编码器,用于嵌入不同的条件输入,如参考图像、HDMap、3D盒子和动作。然后通过扩散步骤估计噪声并生成与输入噪声的损失,以优化Auto-DM。最后通过交叉注意力促进文本输入与视觉信号之间的特征交互,使文本描述能够影响生成的驾驶场景属性。训练时通过文本提示动态调整生成视频的风格,例如天气和一天中的时间。还可以通过编码历史驾驶动作和Auto-DM提取的多尺度潜在特征,生成合理的未来驾驶动作。DriveDreamer还可以扩展到多视图图像/视频生成,使用视图注意力层来保持生成内容的一致性。

DriveDreamer模型的创新之处在于其对真实世界驾驶场景的深入理解,引入了Auto-DM和两阶段训练流程,以及能够生成与交通约束高度一致的驾驶视频和基于历史观察的合理驾驶策略。这为自动驾驶的实际应用提供了一个强大的工具,特别是在提高驾驶安全性和效率方面。

DriveDreamer-2:LLM增强的世界模型,用于多样化的驾驶视频生成

https://arxiv.org/abs/2403.06845

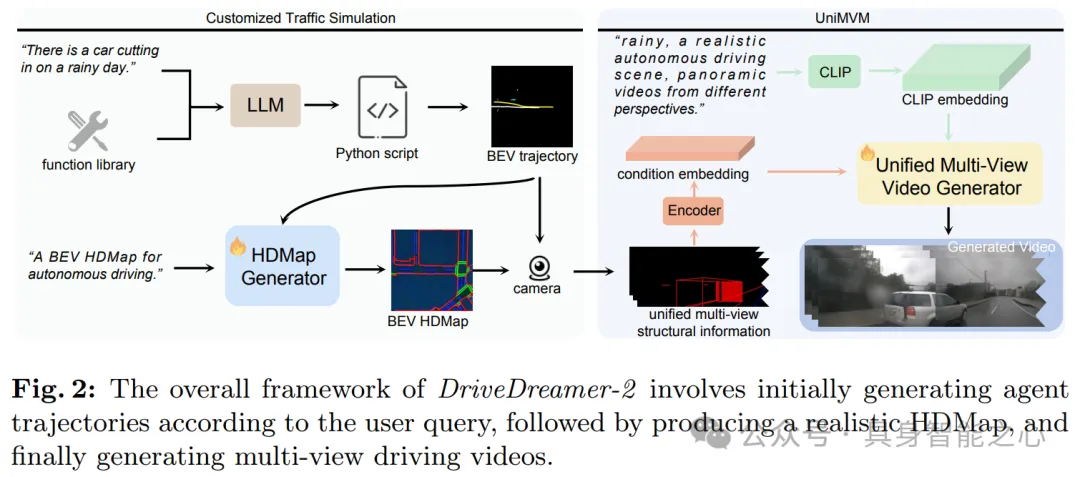

DriveDreamer-2是一个根据用户描述生成用户自定义的驾驶视频,增强了生成视频的多样性和定制化能力。它在DriveDreamer的基础上进行了增强,并整合了大型语言模型(LLM)。DriveDreamer-2首先集成了一个大型语言模型(LLM)接口,用于将用户的查询转换成代理轨迹(agent trajectories)。然后通过HDMap生成器基于轨迹生成遵守交通规则的高清地图(HDMap),作为视频生成的背景条件。文章引入一个统一多视图模型(UniMVM),用于在DriveDreamer框架内生成多视图驾驶视频,统一了视角内和视角间的一致性。通过调整掩码(mask),UniMVM能够实现基于初始帧、前视视频输入以及无需图像输入的视频生成。

模型能够实现定制化交通模拟,即利用构建的功能库对大型语言模型进行微调,使其能够基于用户文本输入生成代理轨迹。并且,HDMap生成器使用扩散模型来模拟道路结构,将之前生成的代理轨迹作为条件输入。DriveDreamer-2能够生成高质量的驾驶视频,其Fréchet Inception Distance (FID)和Fréchet Video Distance (FVD)分数分别为11.2和55.7,相比之前的方法有显著提升。总体来说,DriveDreamer-2的主要贡献在于:(1)它提出了一个使用文本提示生成多样化交通条件的交通模拟管道。(2)引入UniMVM框架提升了生成视频中的时间和空间连贯性。(3)通过大量实验验证了DriveDreamer-2生成多样化定制化视频的能力,并且提升了下游任务的性能。

GenAD:生成式端到端自动驾驶

https://arxiv.org/abs/2402.11502

文章介绍了一个名为GenAD(Generative End-to-End Autonomous Driving)的框架,旨在通过生成模型直接从原始传感器数据中生成自动驾驶的规划结果,实现生成式端到端自动驾驶(Generative End-to-End Autonomous Driving)。本文探索了端到端自动驾驶的新范式,其中关键是如何根据过去的场景演变预测自我汽车和周围环境,将自动驾驶转变为生成建模问题。文章提出了一个以实例为中心的场景表示(Instance-Centric Scene Representation),首先使用一个场景标记器(scene tokenizer)将周围场景转换为具有地图意识的实例令牌(map-aware instance tokens)。然后通过背景网络提取图像特征,并将它们转换到3D鸟瞰图(BEV)空间。最后使用交叉注意力(cross-attention)和自注意力(self-attention)机制来细化地图和代理(agent)令牌,同时整合实例和地图信息。然后,使用变分自编码器(VAE)学习将真实轨迹映射到高斯分布的潜在空间,以模拟轨迹的不确定性和结构化先验,以进行轨迹先验建模(Trajectory Prior Modeling)。最后,为实现潜在未来轨迹生成(Latent Future Trajectory Generation),采用门控循环单元(GRU)对潜在空间中的实例进行自回归建模,以生成更有效的未来轨迹。

GenAD框架将自动驾驶视为一个生成问题,通过在结构化潜在轨迹空间中采样,并使用学习到的时间模型来生成未来场景,同时执行运动预测和规划。在训练阶段,使用实例分布和真实轨迹分布之间的Kullback-Leibler散度损失来强制分布匹配。在推理阶段,丢弃未来轨迹编码器,根据实例令牌的条件在潜在空间中采样,并使用学习到的时间模型生成未来轨迹。在nuScenes基准测试中进行了广泛的实验,证明了GenAD在基于视觉的端到端自动驾驶中取得了最先进的性能,并且具有高效率。

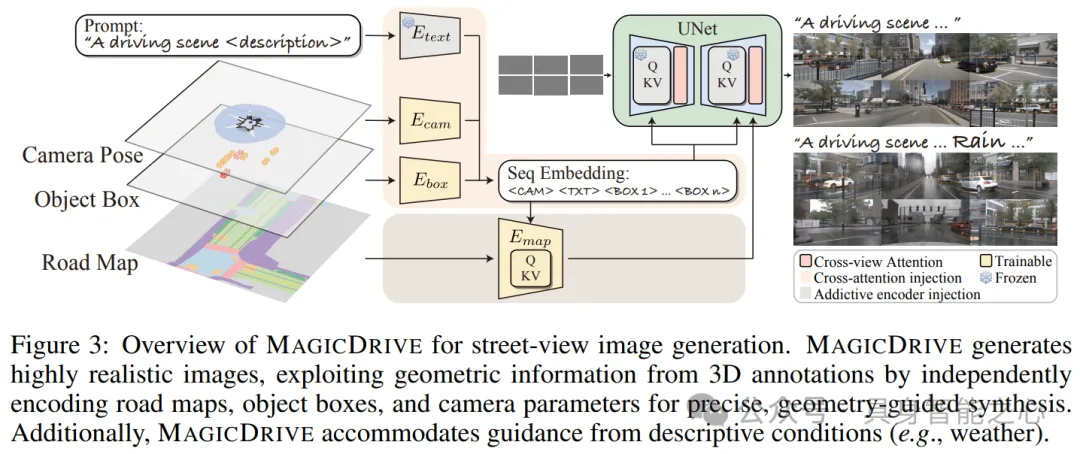

MagicDrive:具有多种 3D 几何控制的街景生成功能

https://arxiv.org/abs/2310.02601

文章介绍了一个名为MAGICDRIVE的框架,它是一个用于生成多视角街道视图图像和视频的模型,这些图像和视频可以捕捉精细的3D几何细节和各种场景描述。该框架通过定制的编码策略,实现了对相机姿势、道路地图、3D边界框和文本描述的精确控制。为了实现多样化的3D几何控制,模型需要理解不同相机姿势(Camera Pose)下的视图,包括内部参数(如焦距)和外部参数(如相机在世界坐标系中的位置和旋转)。模型以道路地图作为背景条件,提供了道路的二维网格格式信息,包括道路、人行道、交通标志等。3D边界框(3D Bounding Boxes)用于表示场景中对象的位置和尺寸,包括车辆、行人等,每个边界框由其8个角点的坐标定义。

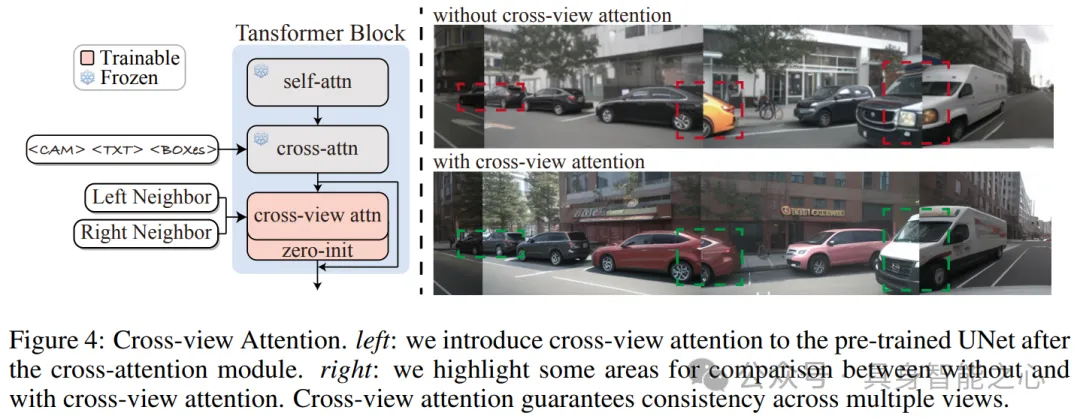

通过定制编码策略提供多样化的 3D 几何控制,包括:(1)场景级编码(Scene-level Encoding):使用模板构建文本提示,并利用预训练的CLIP文本编码器处理文本描述。(2)3D边界框编码(3D Bounding Box Encoding):使用交叉注意力机制对每个边界框进行编码,包括类别标签和边界框位置。(3)道路地图编码(Road Map Encoding):使用额外的编码器分支来处理道路地图信息,实现视图转换和与3D边界框的协同。此外,为了保持不同相机视角之间的一致性,MAGICDRIVE引入了一个交叉视角注意力模块(Cross-View Attention Module)。该模块允许目标视图从其相邻的左侧和右侧视图中获取信息,并通过注意力机制进行信息聚合。在训练时,使用分类器自由引导(Classifier-Free Guidance, CFG)来加强条件引导的影响,简化了在训练中丢弃条件的策略。

实验结果显示,MAGICDRIVE在生成现实感强、与3D注释高度一致的街道视图方面表现出色,可以显著提高BEV分割和3D目标检测任务的性能。MAGICDRIVE框架通过其定制的编码策略和交叉视角注意力模块,实现了对街道视图生成的精确控制,同时保持了多视角之间的一致性,为自动驾驶领域的3D感知任务提供了强大的数据支持。

CarDreamer:基于世界模型的自动驾驶开源学习平台

https://arxiv.org/abs/2405.09111

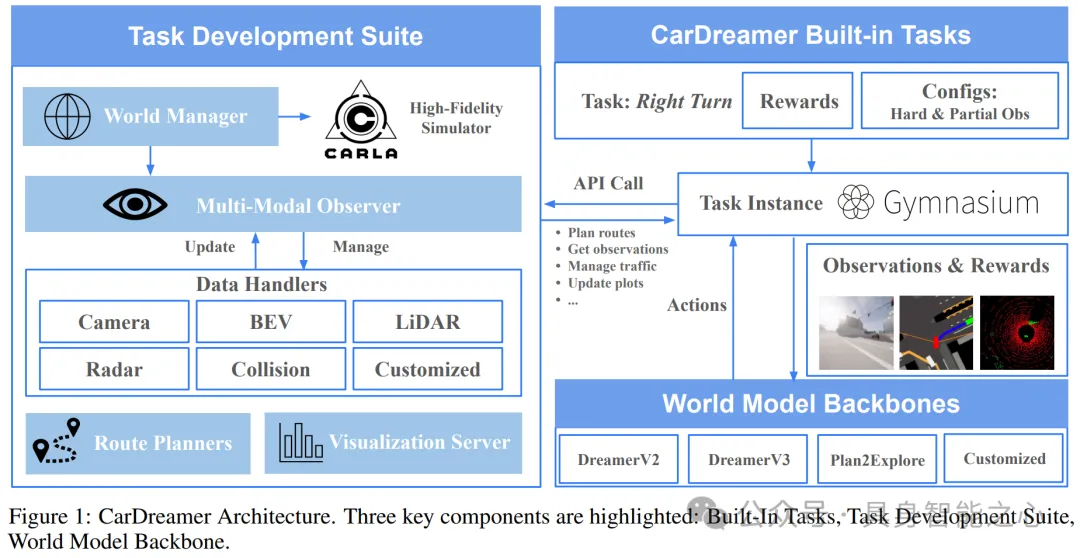

CarDreamer是一个为自动驾驶开发和评估基于世界模型(World Model, WM)的强化学习(Reinforcement Learning, RL)算法的开源学习平台。CarDreamer的架构包括三个主要部分:内置任务、任务开发套件和世界模型背骨:(1)世界模型Backbone(World Model Backbone):集成了最先进的世界模型,如DreamerV2、DreamerV3和Planning2Explore,使用户能够轻松地再现RL算法的性能。这些模型通过标准的Gym接口与其他组件解耦和通信。(2)内置任务(Built-in Tasks):提供了一系列高度可配置的驾驶任务,这些任务与Gym接口兼容,并配备了经验优化的奖励函数。任务包括变道、超车等,允许在难度、可观察性、观察模态和车辆意图交流方面进行广泛定制。(3)任务开发套件(Task Development Suite):通过API提供了一系列功能,包括API驱动的车辆生成和交通流控制,以及模块化的观察者(Observer)用于轻松收集多模态数据。此外,还有一个可视化服务器,允许用户通过浏览器实时追踪代理驾驶视频和性能指标。

使用DreamerV3作为模型Backbone,在CarDreamer中的不同任务上进行训练和评估。实验结果展示了在不同驾驶任务中WM的性能。文章评估了在不同观察模态(BEV、相机、激光雷达)下,世界模型预测未来状态的能力。实验结果表明,无论观察模态如何,世界模型都能准确预测未来。此外,CarDreamer允许车辆之间进行不同程度的通信,包括视野共享和意图共享。实验结果表明,通信可以显著提高交通的安全性和效率。