编辑 | 星璇

出品 | 51CTO技术栈(微信号:blog51cto)

Anthropic和OpenAI的竞争日趋白热化,前不久OpenAI发布了更便于开发者定制输出的json API,没过多久Anthropic也开始发布了一项利好开发者的消息:终于不必重复调用同样地提示了!

Anthropic在其 API 上引入了提示缓存,它可以记住 API 调用之间的上下文并允许开发人员避免重复提示。

简单来讲,新版API可以“记住”一整本书或整个代码库,不需要再重复输入了。这样一来,不仅处理长文本的延时更低,更是能节省最高90%的成本。

提示缓存功能已在 Claude 3.5 Sonnet 和 Claude 3 Haiku 的公开测试版中推出,但对最大的 Claude 模型 Opus 的支持即将推出。

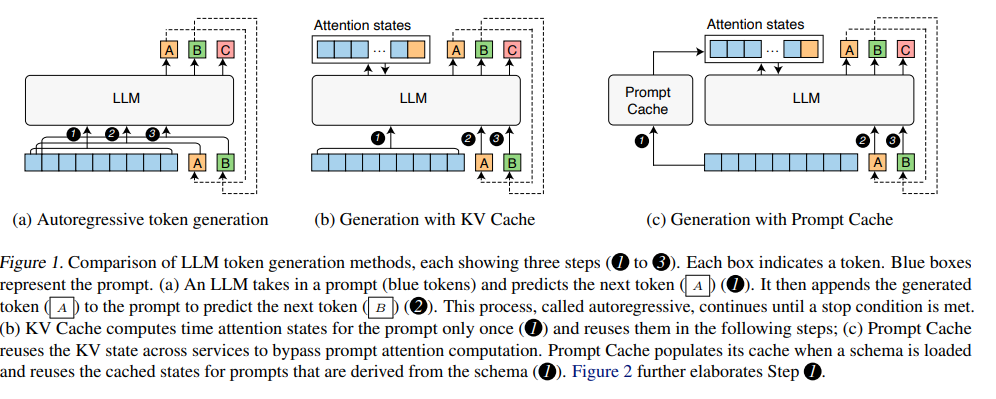

早在2023 年,论文《PROMPT CACHE: MODULAR ATTENTION REUSE FOR LOW-LATENCY INFERENCE》中就提出了“提示缓存”的方法,它允许用户在会话中保留常用的上下文。由于模型会记住这些提示,因此用户可以添加额外的背景信息而不会增加成本。这在有人想在提示中发送大量上下文,然后在与模型的不同对话中引用它的情况下很有用。它还允许开发人员和其他用户更好地微调模型响应。

图片

图片

Anthropic 表示,早期用户“已经看到了针对各种用例的提示缓存带来的显著速度和成本改进——从包括完整的知识库到 100 个示例,再到在提示中包含每次对话”。

该公司表示,潜在的用例包括:降低对话代理的长指令和上传文档的成本和延迟、更快地自动完成代码、为代理搜索工具提供多条指令以及在提示中嵌入整个文档。

1.缓存提示定价高吗?

缓存提示的一个优点是每个令牌的价格较低,Anthropic 表示使用缓存提示“比基本输入令牌价格便宜得多”。

对于 Claude 3.5 Sonnet,编写要缓存的提示将花费每 100 万个令牌 (MTok) 3.75 美元,但使用缓存的提示将花费每 MTok 0.30 美元。Claude 3.5 Sonnet 模型的输入基本价格为每 MTok 3 美元,因此,如果您预先多付一点钱,下次使用缓存的提示时,您可以预期节省 10 倍。

Claude 3 Haiku 用户将为缓存支付 0.30 美元/MTok,使用存储提示时支付 0.03 美元/MTok。

虽然 Claude 3 Opus 尚未提供即时缓存功能,但 Anthropic 已经公布了其价格。写入缓存的费用为 18.75 美元/MTok,但访问缓存的即时缓存费用为 1.50 美元/MTok。

然而,正如人工智能影响者 Simon Willison 在 X 上指出的那样,Anthropic 的缓存仅有 5 分钟的生命周期,并且每次使用时都会刷新。

当然,这并不是 Anthropic 第一次尝试通过定价与其他 AI 平台竞争。在 Claude 3 系列模型发布之前,Anthropic大幅下调了其Tokens价格。

在为基于其平台进行开发的第三方开发者提供低价选项方面,它目前正与谷歌和OpenAI等竞争对手进行某种“竞相压价”的态势。

2.呼声极高的功能

其他平台也提供提示缓存版本。LLM 推理系统 Lamina利用 KV 缓存来降低 GPU 成本。粗略浏览一下 OpenAI 的开发者论坛或 GitHub,就会发现有关如何缓存提示的问题。

缓存提示与大型语言模型内存中的提示不同。例如,OpenAI 的 GPT-4o 提供了一个内存,模型可以在其中记住偏好或详细信息。但是,它不会像提示缓存那样,记住并存储提示和对应的输出。