Falcon Mamba 7B 强大的新 AI 架构为 Transformer 模型提供了替代方案。

8月12日,阿布扎比技术创新研究所(TII)发布了一款名为 Falcon Mamba 7B 的新开源模型。同时,这款模型已经放在了Hugging Face平台。

Mamba 7B 采用了一种新颖的Mamba状态空间语言模型(SSLM)架构来处理各种文本生成任务,并在选定基准测试中优于其尺寸类别中的主流模型,包括Meta的Llama 3 8B、Llama 3.1 8B和Mistral 7B。

尽管,它是继Falcon 180B、Falcon 40B 和Falcon 2 之后 TII 的第四个开放模型,但令人兴奋的点在于,它是非Transformer架构的第一个类别,意义非比寻常。它正在迅速成为人工智能领域基于Transformer的大型语言模型 (LLM) 的新替代品。

据介绍,该模型采用了“Falcon License 2.0”,一种基于 Apache 2.0 的许可证。

01、Falcon Mamba 7B 有何优势?

尽管变换模型继续在生成式人工智能领域占据主导地位,但研究人员指出,该架构在处理较长的文本时可能会遇到困难。

本质上,Transformer 的注意力机制通过将每个单词(或标记)与文本中的每个单词进行比较来理解上下文,它需要更多的计算能力和内存来处理不断增长的上下文窗口。

如果不相应地扩展资源,推理速度就会变慢,并达到无法处理超过一定长度的文本的程度。

为了克服这些障碍,状态空间语言模型(SSLM) 架构应运而生,该架构通过在处理单词时不断更新“状态”来工作,已成为一种有前途的替代方案。一些组织已经部署了它——TII 是最新的采用者。

据 TII 介绍,其全新的 Falcon 型号采用了 Mamba SSM 架构,该架构最初由卡内基梅隆大学和普林斯顿大学的研究人员在 2023 年 12 月的一篇论文中提出。

该架构使用一种选择机制,允许模型根据输入动态调整其参数。这样,模型可以关注或忽略特定输入,类似于注意力机制在 Transformer 中的工作方式,同时提供处理长文本序列(例如整本书)的能力,而无需额外的内存或计算资源。

TII 指出,该方法使模型适用于企业级机器翻译、文本摘要、计算机视觉和音频处理任务以及估计和预测等任务。

02、挑战 Meta、Google 和 Mistral

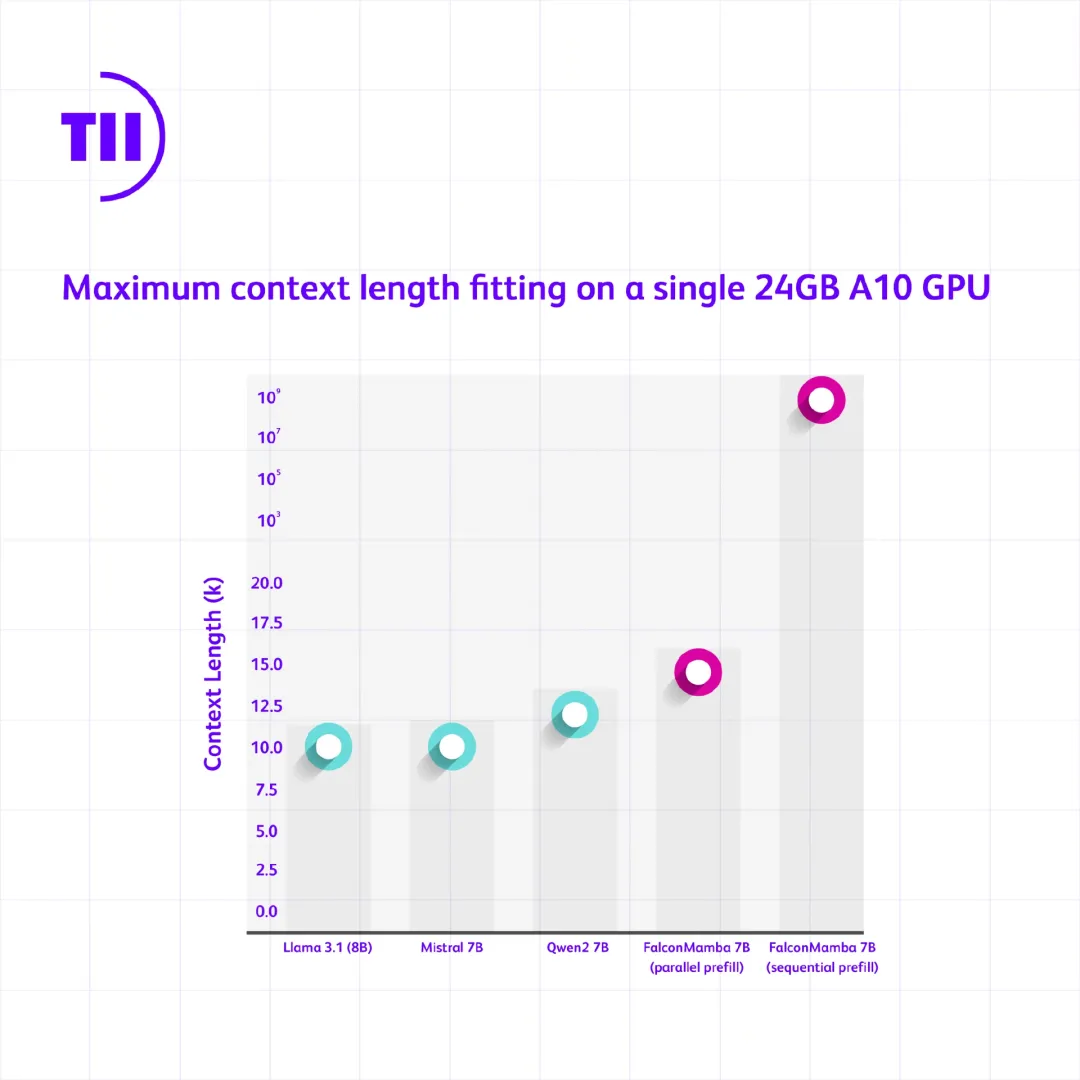

为了了解 Falcon Mamba 7B 与同尺寸级别领先的 transformer 模型的表现如何,该研究所进行了一项测试,以确定使用单个 24GB A10GPU 时模型可以处理的最大上下文长度。

结果显示,Falcon Mamba“可以适应比基于 SoTA Transformer 的模型更大的序列,同时理论上如果逐个处理整个上下文标记,或者按适合 GPU 的大小处理标记块(称为顺序并行),则能够适应无限的上下文长度。”

Falcon 7B

在单独的吞吐量测试中,它的表现优于 Mistral 7B 高效的滑动窗口注意力架构,能够以恒定的速度生成所有 token,并且不会增加 CUDA 峰值内存。

即使在标准行业基准中,新模型的性能也优于或几乎与流行的变压器模型以及纯和混合状态空间模型的性能相同。

例如,在 Arc、TruthfulQA 和 GSM8K 基准测试中,Falcon Mamba 7B 得分分别为 62.03%、53.42% 和 52.54%,明显优于 Llama 3 8B、Llama 3.1 8B、Gemma 7B和 Mistral 7B。

然而,在 MMLU 和 Hellaswag 基准测试中,它紧随所有这些模型之后。

但这仅仅是一个开始。下一步,TII 计划进一步优化模型设计,以提高其性能并覆盖更多的应用场景。

TII 人工智能跨中心部门代理首席研究员 Hakim Hacid 博士在一份声明中表示:“此次发布代表着向前迈出的重大一步,它激发了新的观点,并进一步推动了对智能系统的探索。在 TII,我们正在突破 SSLM 和 transformer 模型的界限,以激发生成式人工智能的进一步创新。”

总体而言,TII 的 Falcon 系列语言模型下载量已超过 4500 万次,成为阿联酋最成功的 LLM 版本之一。